ES常用的分词器有StandardAnalyzer、ChineseAnalyzer、CJKAnalyze、IKAnalyzer等,其中IK词库分词是第三方插件,对中文支持尚可,也是本文介绍的、实践过程中用到的分词器。

第三方插件需要安装,IK分词器插件安装版本要与ES版本一致,否则容易不兼容。

集成方式超级简单,从GIT上下载IK分词器插件,并拷贝至ES的plugin文件夹下,启动ES,即OK。

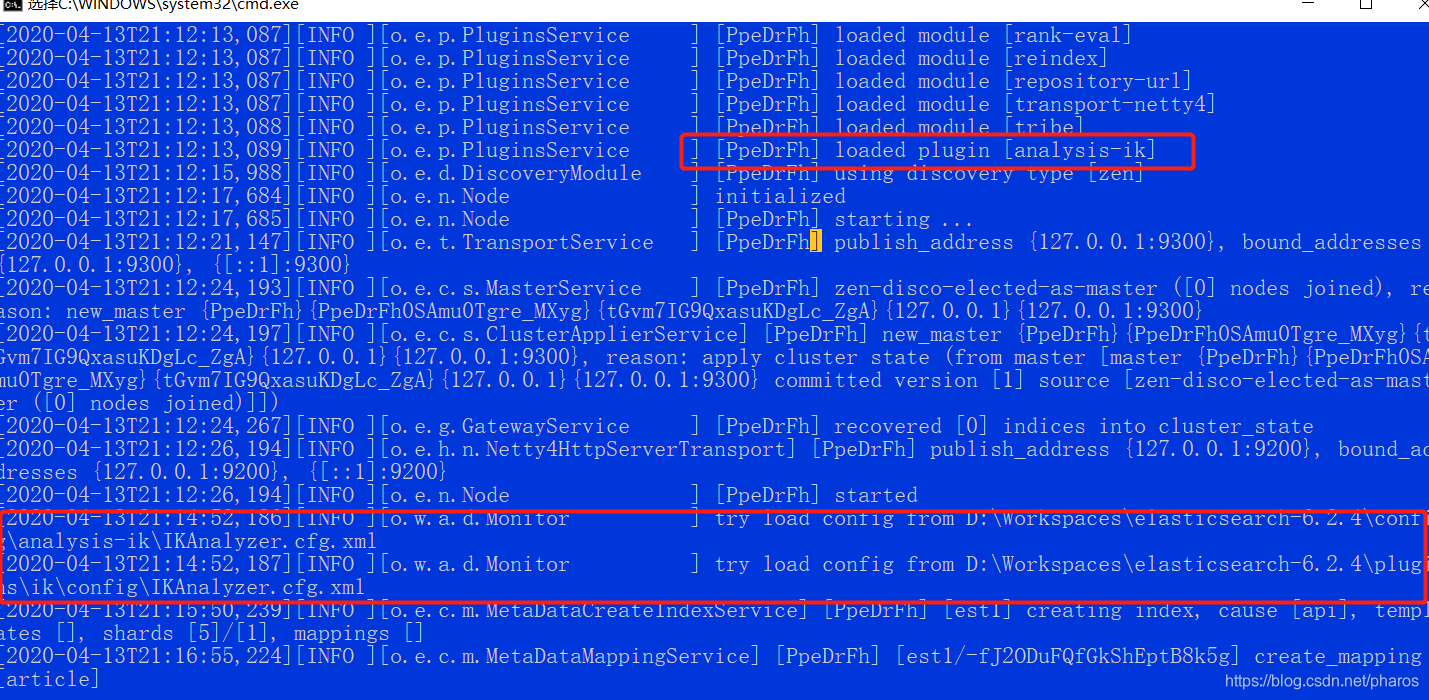

加载插件成功截图如下:

验证集成效果:

1、用标准分词器

GET http://127.0.0.1:9200/_analyze?analyzer=standard&pretty=true&text=学习Elasticsearch

响应为:

{

"tokens": [

{

"token": "学",

"start_offset": 0,

"end_offset": 1,

"type": "<IDEOGRAPHIC>",

"position": 0

},

{

"token": "习",

"start_offset": 1,

"end_offset": 2,

"type": "

本文介绍了在Elasticsearch中使用不同分词器的效果对比,重点讲解了如何集成并使用IK分词器进行中文文本的高效分词,通过具体实例展示了标准分词器与IK分词器在处理中文文本时的区别。

本文介绍了在Elasticsearch中使用不同分词器的效果对比,重点讲解了如何集成并使用IK分词器进行中文文本的高效分词,通过具体实例展示了标准分词器与IK分词器在处理中文文本时的区别。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

444

444

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?