|

Pola是什么? Pola是即拍即现,一次成像相机。1947年,美国人发明了一次成像胶片,并由宝丽来公司生产出一次成像的拍立得相机。这一发明,使得旅游者的摄影变得非常方便,而不用受当时还非常不普及的冲洗服务的影响。 这种照相机用特种胶片,拍摄后立即自动冲洗。在拍摄后从相机中拉出或自动弹出的已经是冲洗好的照片。拍摄者即拍即现可以看到刚拍摄的效果。 Pola同LOMO相比来的更加直白,也许长久以来Pola更多的是用在各旅游景点的留影处。但它却不乏人文气质,Pola诞生之初,全球追捧者众多,其中最著名的Fans是当代艺术家安迪 沃霍尔。 如今玩Pola的人说,玩Pola就是为了及时分享拍摄带来的快乐。Pola最吸引人之处也在于此。 每当和朋友们在一起时,欢笑、泪水、感动、兴奋时,无不想把这些精彩瞬间记录下来,并及时去分享和回味这份感受。Pola的即拍即现正好符合分享的要求。 SX-70――Pola的回归

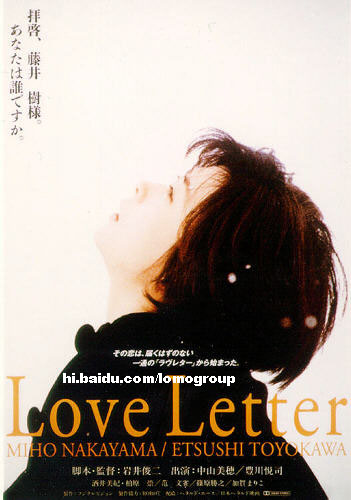

SX-70系列是拍立得发展史上最佳的专业单眼相机,在SX-70发明前,宝丽来相机是采用拉纸式的,就是按快门后,拍摄者要自行从相机中拉出宝丽来,然后撕开相底,这才能看到相片,但SX-70却是一按快门后,相片便会自动「吐出」,而且它可以做到『刮相』等特别效果。」是宝丽来最辉煌的一刻,可惜后来公司因无法清还巨额债务而不得不申请破产保护,加上数码相机迅速发展,宝丽来「即影即有」的历史任务渐渐地式微,然而却在几部电影如[情书] 以及MTV中再度唤起人们的记忆, 喜欢宝丽来的人,就是喜欢一种对颜色的感觉,以及一按快门,相片便实时显现的独特效果所带来快感乐趣。 「很多人玩宝丽来,就是很喜欢这种实时的效果,而且在聚会场合有着一台拍利得胜过在好的专业相机。」另外是有相片上所呈现的非一般颜色,也是「莱迷」钟情之处,「一般相机的菲林颜色可以做到很传真的效果,但宝丽莱显影的颜色却很不同,即使是拍摄同一种鲜红色,但显影的效果跟菲林色很不同。」 其实宝丽来即拍即有已经成为一种美学一种文化,也因为它所拍出来的相片颜色温婉有Mood,不是一般硬光硬闪灯拍出来的僵硬,加上它还可以调校焦点,无形中 "一般傻瓜机又多了一层距离的感觉, 拍摄时多了 另一份玩味。 目前因为sx-70早已停产,剩下的坏一台就少一台了,所以广为收藏家及艺术家或是设计人员收藏。 数位时代,任何产物都可经由一再复制获取你想要的任何东西,数位充斥我们的四周,方便我们的生活,但这真是好事?类比时代的东西依然迷人,我喜欢底片摄影,那种扎实光影结合的作品。

|

987

987

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?