官网中,有两种版本,一种是有hadoop支持的版本,一种是没有hadoop支持的版本

解压后重点有两个目录,一个是bin,一个是conf

1、解压到指定目录

tar -zxvf flink-1.7.2-bin-scala_2.11.tgz -C local/

2、

配置

Flink的配置很简单。 我们需要调整一些参数,我们都已设置好。 作业管理器节点和任务管理器节点的大多数配置都相同。 所有配置都在conf/flink-conf.yaml文件中完成。下面配置

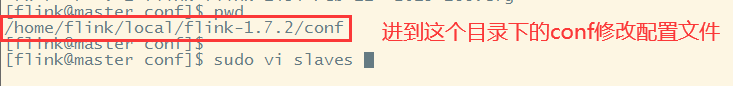

进入目录

cd /usr/flink-1.6.2/conf

vi flink-conf.yaml

需要修改的参数是:jobmanager.rpc.address: localhost

localhost改为主机hostname,我这里的hostname为job.

第二步:配置JAVA_HOME

还有我们需要添加JAVA_HOME

export JAVA_HOME=/usr/...

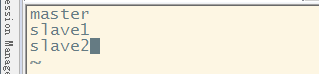

第三步:配置taskmanager

- vi slaves

复制代码

第四步:分发配置文件

- scp -r conf/ aboutyun@task1:~

- scp -r conf/ aboutyun@task1:~

第五步:启动集群

进入bin目录

- ./start-cluster.sh

复制代码

本文详细介绍Flink集群的部署步骤及关键配置项,包括解压安装包、配置Flink参数、设置JAVA_HOME、配置taskmanager及分发配置文件等。通过本教程,读者将学会如何从零开始搭建并启动Flink集群。

本文详细介绍Flink集群的部署步骤及关键配置项,包括解压安装包、配置Flink参数、设置JAVA_HOME、配置taskmanager及分发配置文件等。通过本教程,读者将学会如何从零开始搭建并启动Flink集群。

1426

1426

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?