内容概述

在线Latex公式

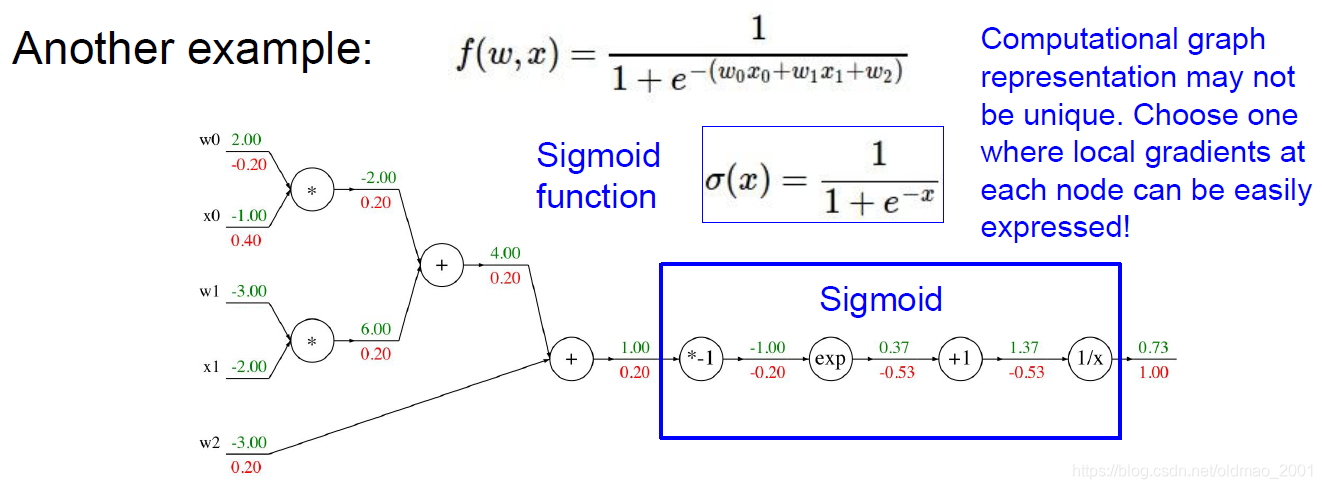

这节课对不住了,学过ng的深度学习和李宏毅的机器学习课程BP这块应该是理解比较深刻了,尤其是李宏毅的课程,在讲反向传播的时候提出了反向传播也是一个神经网络的观点,当然这节课的视频观看了以后也有一些收获,大概的简略的记录一下,这次课是由Serena Yeung(00后美女)来讲的,引入部分的思路和ng一样,用的是计算图(Computer Graph),可以看下ng深度学习课程第一门课2.7部分。

模块化

这里有所不一样的是,Serena在课程中提到了模块化的概念,也就更加直观的解释了为什么深度学习就好像是搭乐高!

门

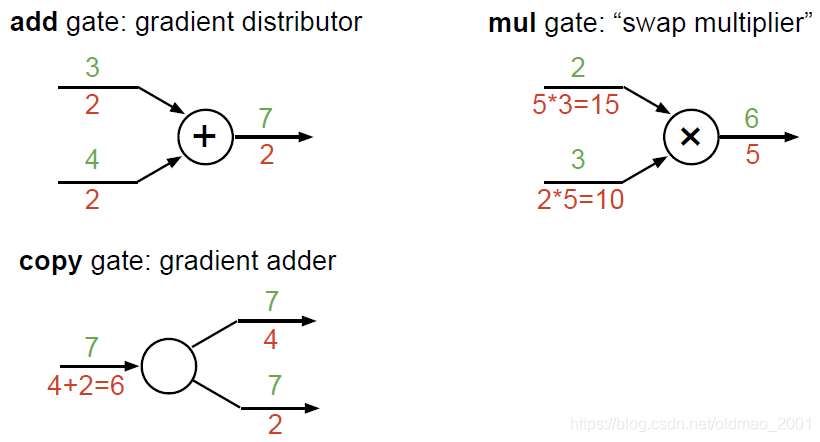

还有一个新概念就是门(gate):任何可微分的函数都可以看做门。可以将多个门组合成一个门,也可以根据需要将一个函数分拆成多个门。

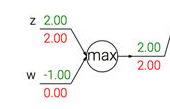

还有最大值门:

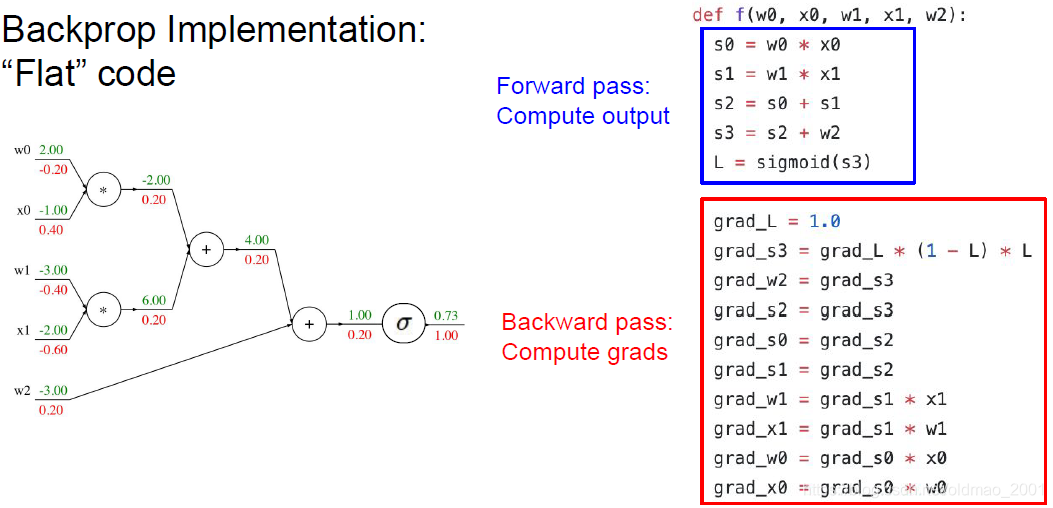

一维BP实现:

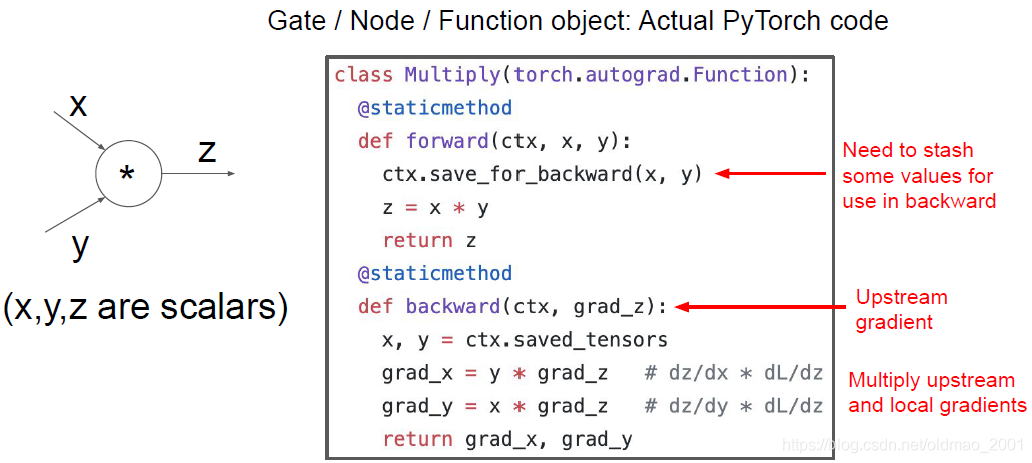

貌似这里就是现在的一些深度学习框架学习使用的原理,老师给出了PyTorch的代码可以感受一下:

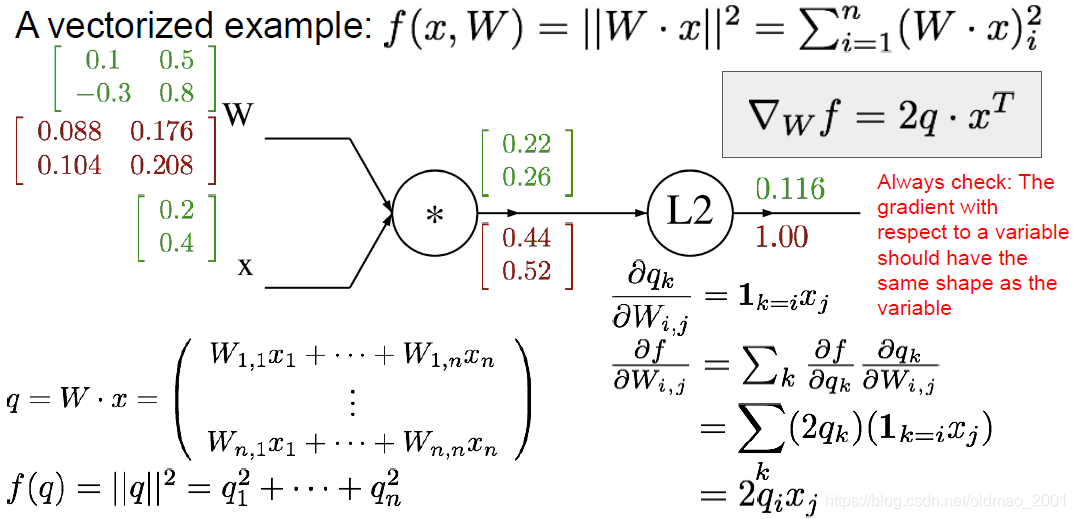

向量化BP实现

这里看得有点蒙,还是觉得ng的notation容易理解。。。

本文探讨了深度学习中反向传播(BP)的概念,通过模块化和门(gate)的概念深化理解,介绍了Serena Yeung的教学观点,并对比了与Ng课程的不同。文章还涉及了一维BP和向量化BP的实现,以及PyTorch框架的应用。

本文探讨了深度学习中反向传播(BP)的概念,通过模块化和门(gate)的概念深化理解,介绍了Serena Yeung的教学观点,并对比了与Ng课程的不同。文章还涉及了一维BP和向量化BP的实现,以及PyTorch框架的应用。

1374

1374

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?