LSTM与RNN

提起LSTM(长短期记忆神经网络),不得不先说一下RNN,RNN作为循环神经网络,具有记忆功能,在序列建模上具有重要的贡献。根据TensorFlow官方LSTM教程(colah’s Blog):Understanding LSTM Networks (英文)做一些总结,首先看下面几张图:

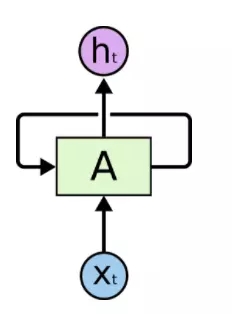

图1. 带循环的神经网络

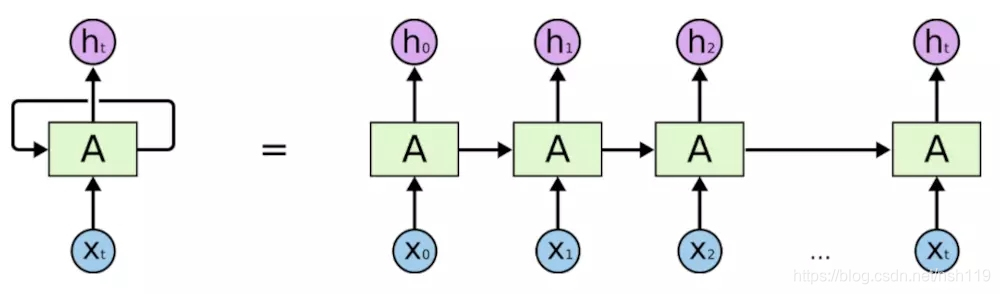

图2. 循环神经网络展开

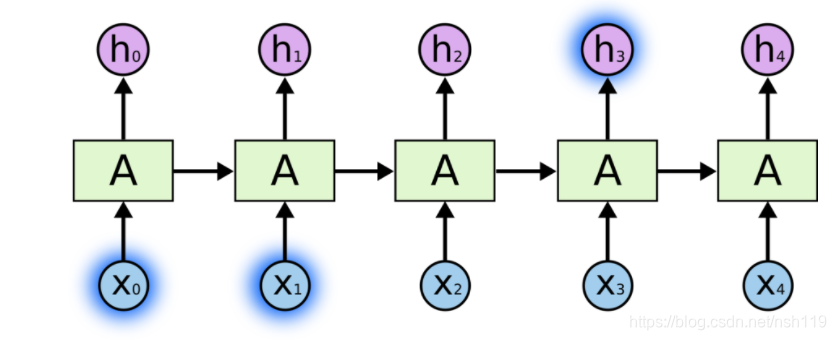

图3. 短依赖

图4. 长依赖

从图1和2中,我们可以看到RNN在时间序列上,具有记忆功能,可以将前面的信息沿着时间序列传递,事实也的确如此,但是通过验证发现,RNN在解决短依赖图3时,效果很好,但在长依赖图4方面,没有任何作用。

本文介绍了LSTM(长短期记忆神经网络)为解决RNN的长依赖问题而设计,详细阐述了LSTM的核心思想,包括遗忘门、输入门和输出门的工作原理。在语音识别领域,LSTM因其对序列数据的处理能力被广泛应用于声学模型和语言模型。文中引用了多个资源以帮助读者深入理解LSTM。

本文介绍了LSTM(长短期记忆神经网络)为解决RNN的长依赖问题而设计,详细阐述了LSTM的核心思想,包括遗忘门、输入门和输出门的工作原理。在语音识别领域,LSTM因其对序列数据的处理能力被广泛应用于声学模型和语言模型。文中引用了多个资源以帮助读者深入理解LSTM。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?