首先为了避免国外镜像不稳定,我们使用了清华大学的python库镜像:https://pypi.tuna.tsinghua.edu.cn/simple

1、安装scrapy

1.1、安装pywin32(解决python调用windows系统库的问题)

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple pywin32

1.2、安装Twisted网络数据处理的集成包,scrapy会调用

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple Twisted

1.3、安装scrapy模块

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple scrapy

1.4、查看scrapy的版本号

scrapy version

2、创建scrapy爬虫项目

2.1、执行如下命令创建一个爬虫项目

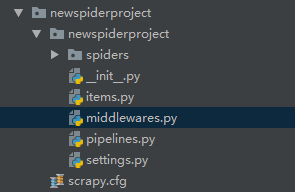

scrapy startproject newspiderproject

2.2、进入项目目录使用scrapy genspider命令创建爬虫主文件,指定爬取的url

cd newspiderproject

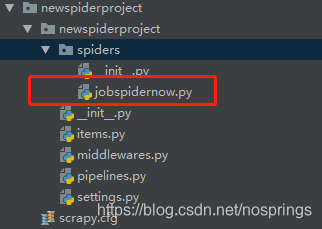

执行 scrapy genspider jobspidernow www.baidu.com

生成爬虫主文件

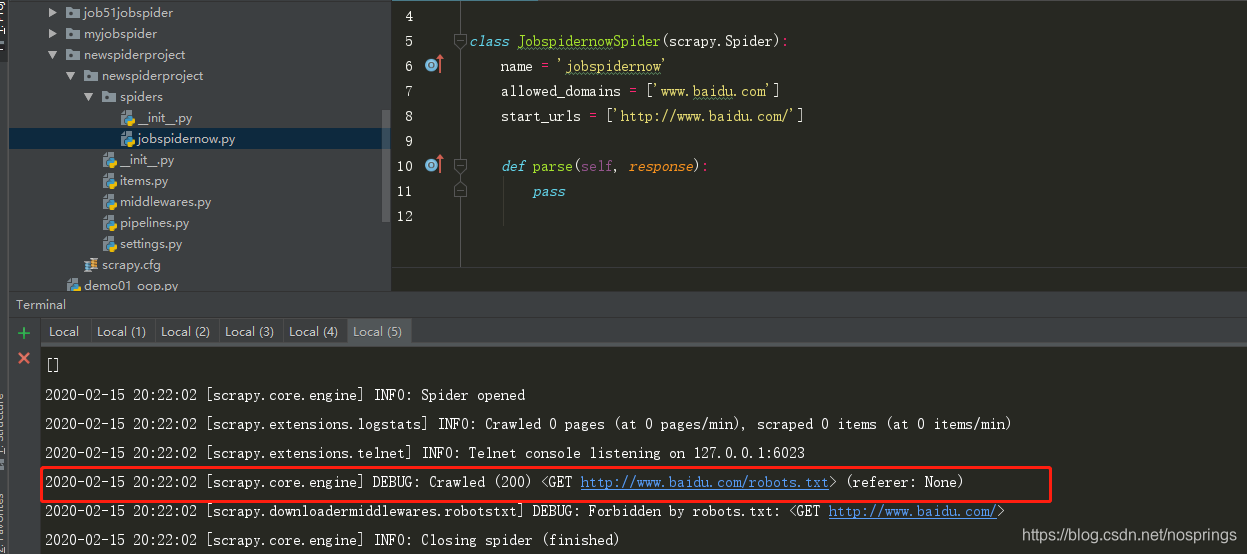

2.3、使用scrapy crawl 启动爬虫,查看是否能够访问url,如果200说明访问成功,爬虫框架搭建成功

scrapy crawl jobspidernow

本文详细介绍如何使用清华大学镜像源安装Scrapy爬虫所需组件,包括pywin32、Twisted及Scrapy本身,同时指导如何创建并运行Scrapy项目,实现网页数据抓取。

本文详细介绍如何使用清华大学镜像源安装Scrapy爬虫所需组件,包括pywin32、Twisted及Scrapy本身,同时指导如何创建并运行Scrapy项目,实现网页数据抓取。

65万+

65万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?