1、代码无错

2、全部代码

from pyspark import SparkConf, SparkContext

conf = SparkConf().setMaster("local[*]").setAppName("应用名")

sc = SparkContext(conf=conf)

RDD = sc.textFile("file:///home/hadoop/word.txt")

RDD.foreach(print)

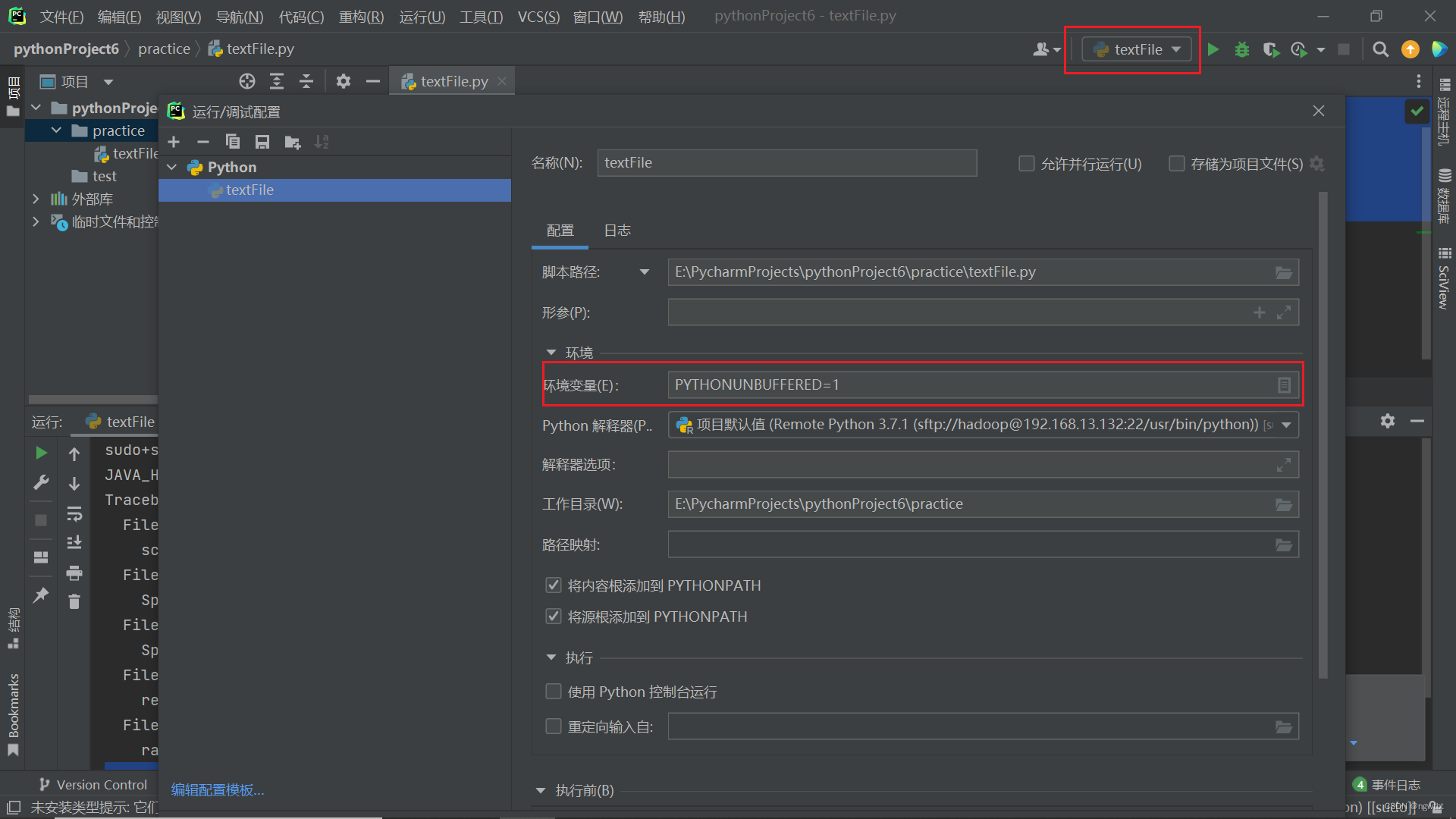

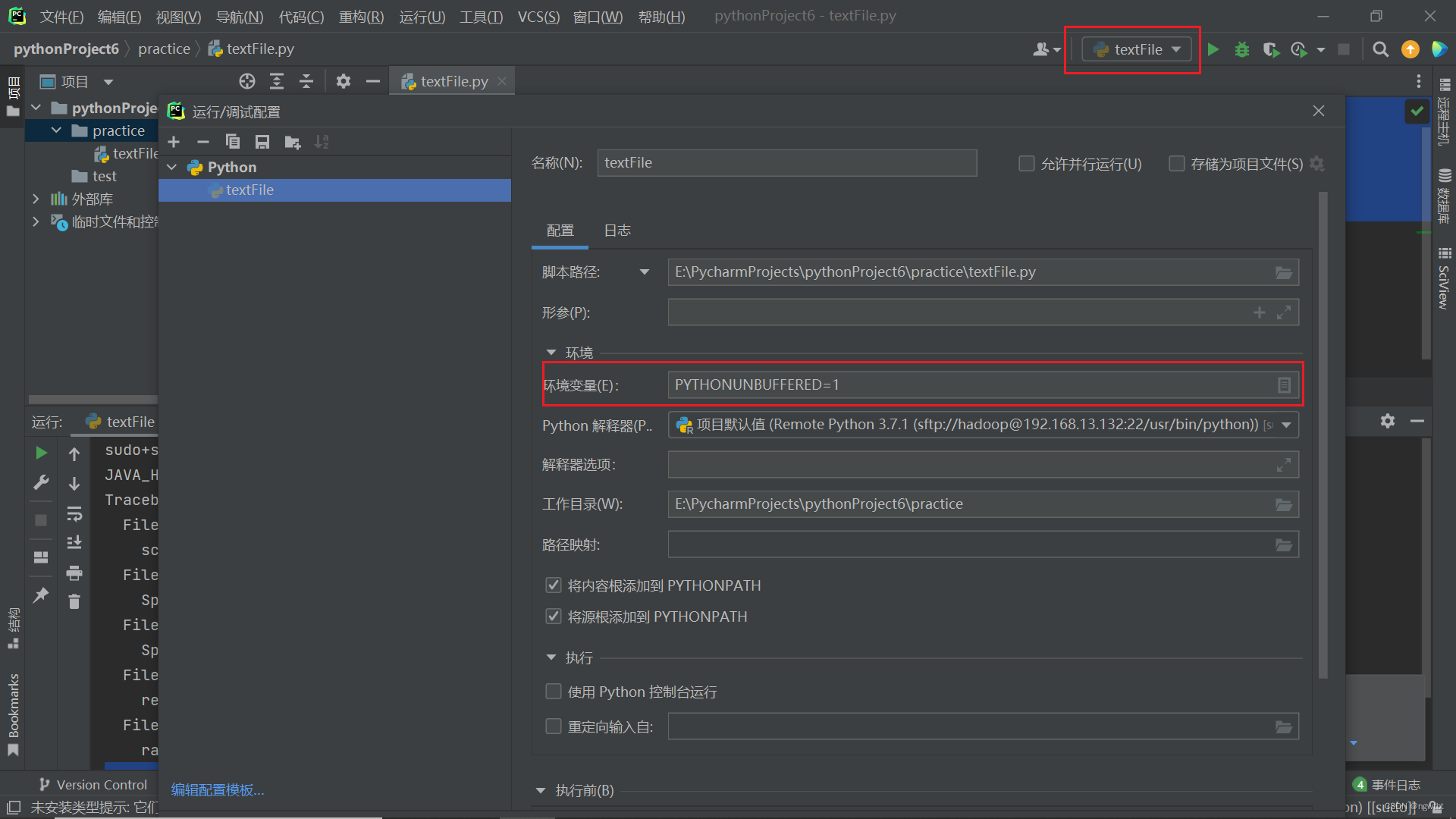

3、报错原因:未配置

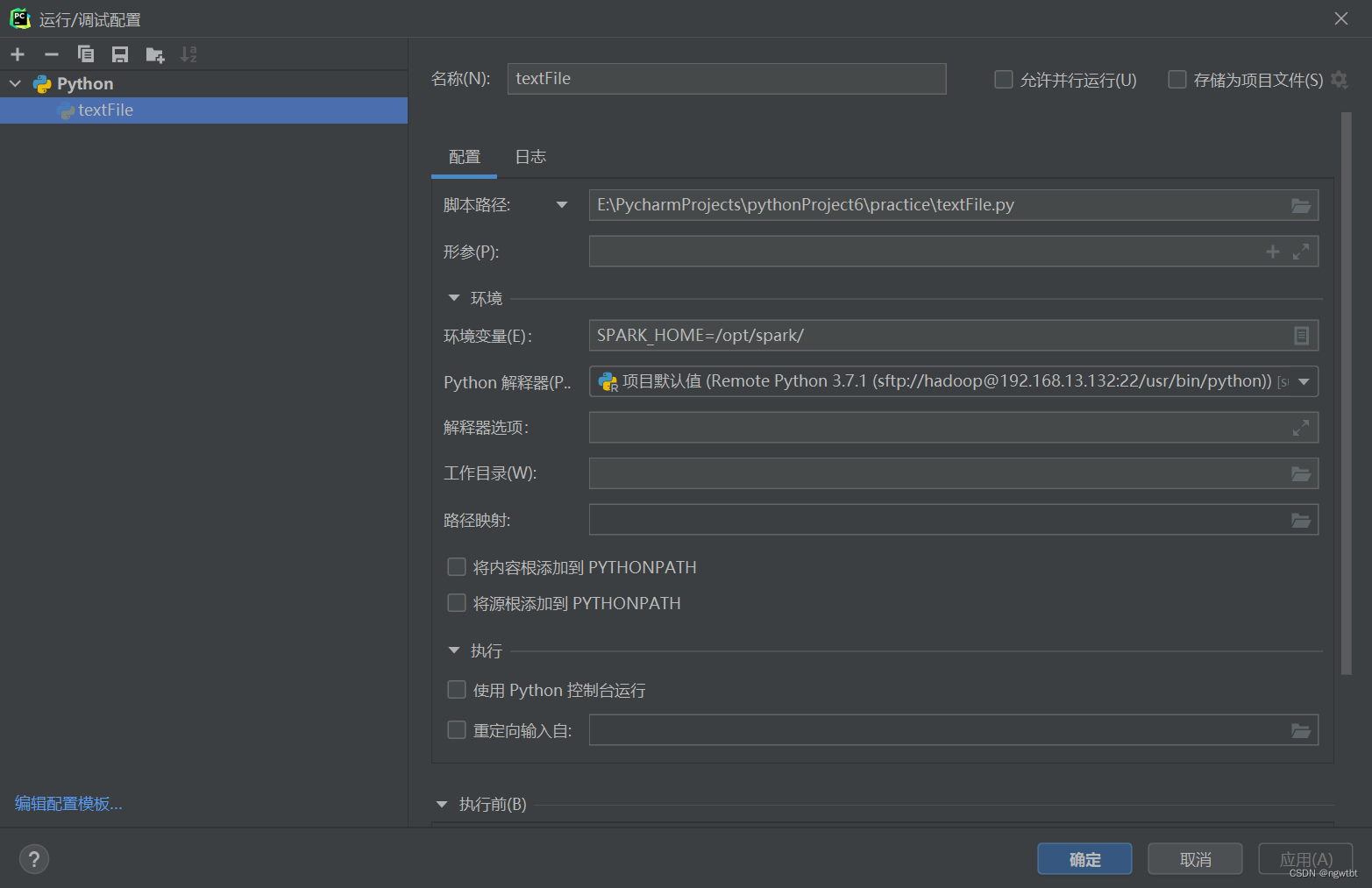

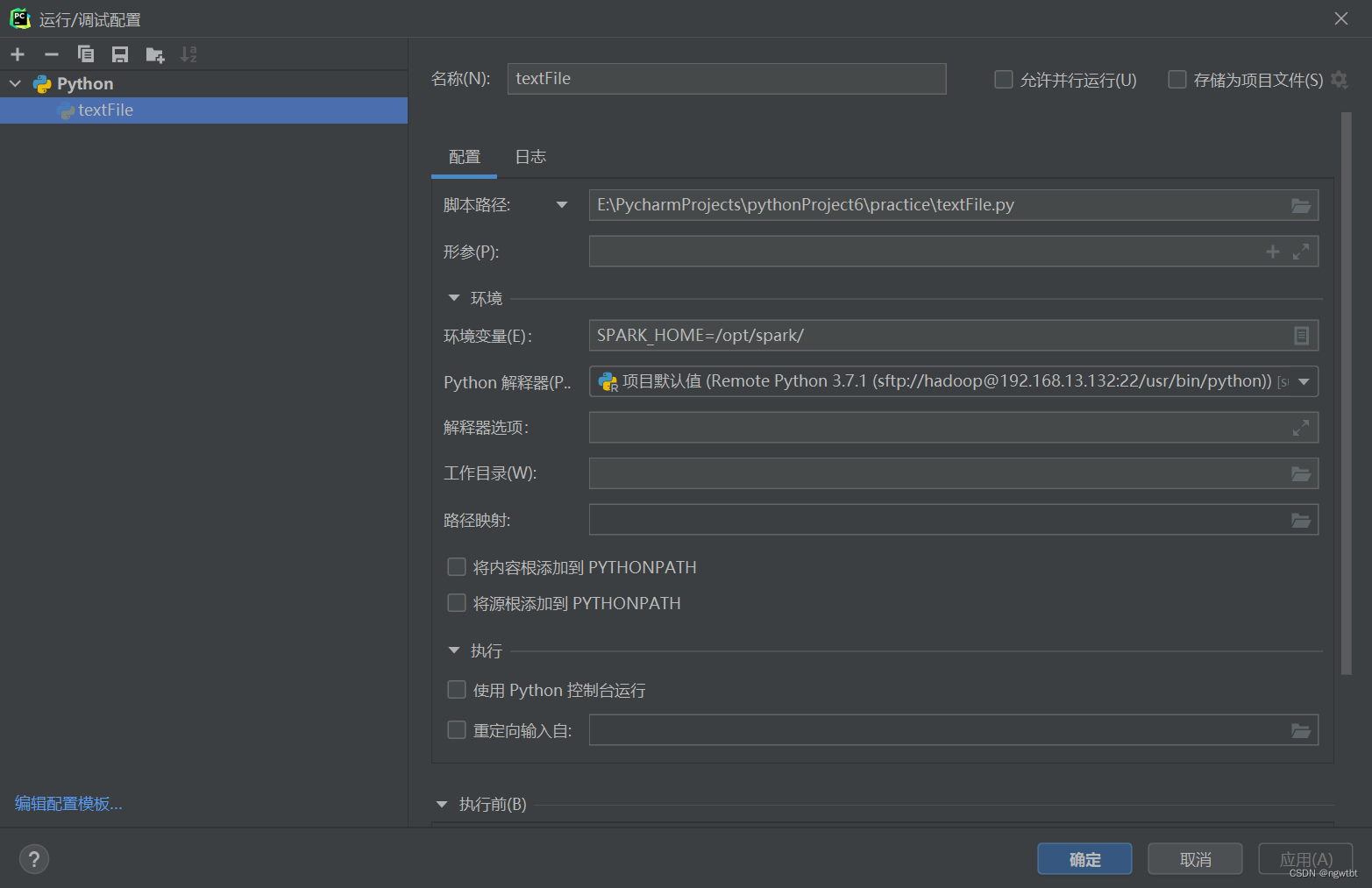

4、校正错误:设置环境变量

本文介绍了如何使用PySpark进行基本操作,包括创建SparkConf和SparkContext,以及处理文本文件。重点在于指出在运行时遇到的‘未配置’错误,并提示需要设置环境变量来解决问题。

本文介绍了如何使用PySpark进行基本操作,包括创建SparkConf和SparkContext,以及处理文本文件。重点在于指出在运行时遇到的‘未配置’错误,并提示需要设置环境变量来解决问题。

1、代码无错

2、全部代码

from pyspark import SparkConf, SparkContext

conf = SparkConf().setMaster("local[*]").setAppName("应用名")

sc = SparkContext(conf=conf)

RDD = sc.textFile("file:///home/hadoop/word.txt")

RDD.foreach(print)

3、报错原因:未配置

4、校正错误:设置环境变量

8910

8910

7336

7336

1086

1086

840

840

1万+

1万+

2251

2251