目录

3. DETR(DEtection TRansformer)

4. SAM(Segment Anything Model)

1. CLIP(Contrastive Language-Image Pretraining)

2. BLIP(Bootstrapped Language-Image Pretraining)

3. DINO(DIstillation with NO labels)

1. I3D(Inflated 3D Convolutional Networks)

4. RKNN(Rockchip RKNN Toolkit)

学习目标:探索计算机视觉的最前沿,扩展模型认知与落地能力,为科研/产品/创业/研究生发展打下坚实基础。

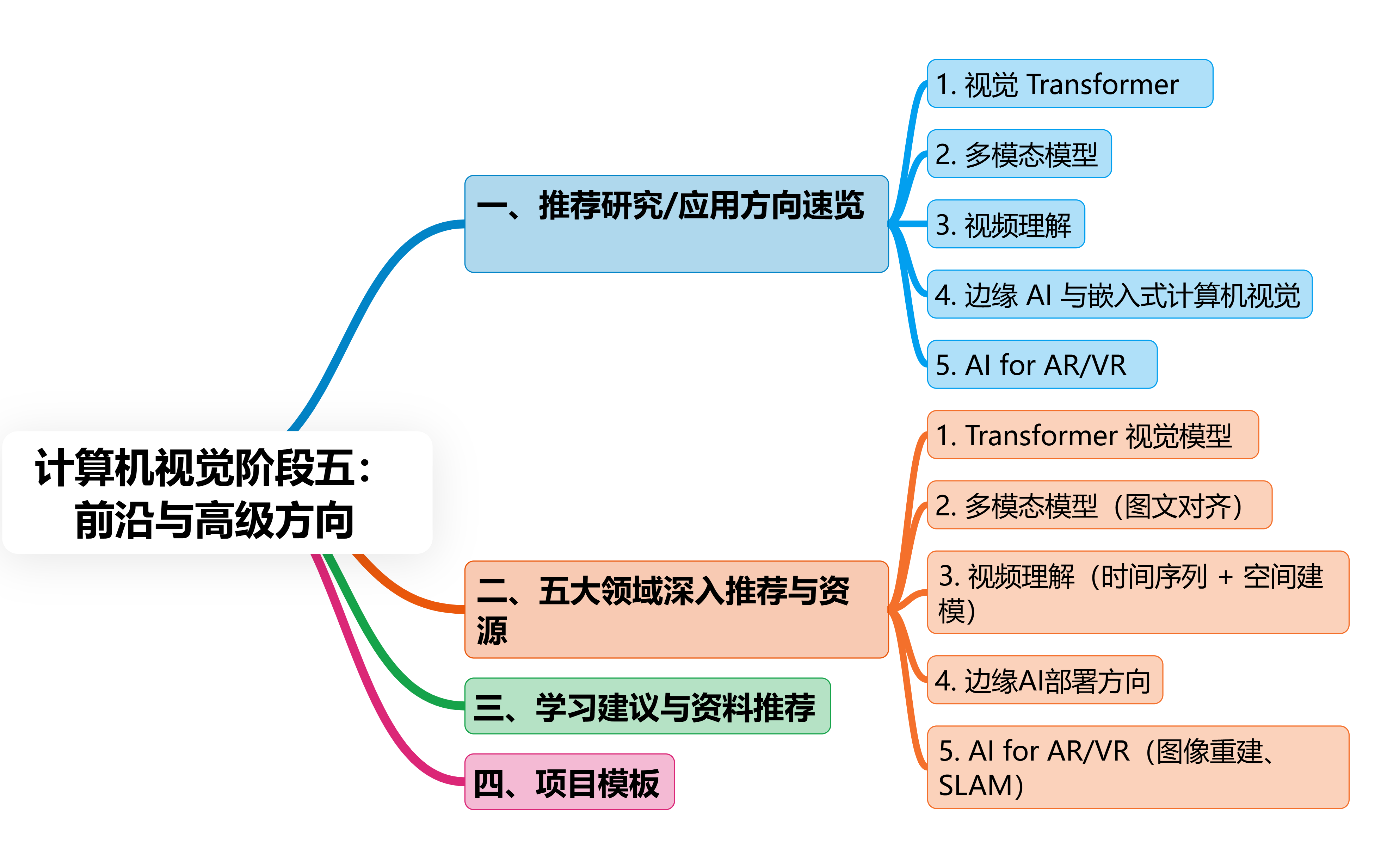

一、推荐研究/应用方向速览

| 方向领域 | 代表模型/方法 | 应用场景 / 突破点 |

| 视觉 Transformer | ViT、Swin、DETR、SAM | 颠覆 CNN 的图像建模方式,适配大模型范式 |

| 多模态模型 | CLIP、BLIP、DINO、MiniGPT-4 | 图文匹配、AIGC、以图搜文、图文生成 |

| 视频理解 | I3D、SlowFast、TimeSformer | 动作识别、行为预测、安防监控分析 |

| 边缘 AI & 嵌入式 CV | OpenVINO、TensorRT、NPU部署 | 实时低功耗推理,适用于无人机、车载、安防等 |

| AI for AR/VR | NeRF、SLAM、SfM、Depth Estimation | 空间建模、体积渲染、全景还原、实时定位 |

1.视觉 Transformer

技术背景

-

ViT(Vision Transformer) ViT 是第一个将 Transformer 架构直接应用于图像任务的模型,将图像划分为固定大小的 patch,通过线性嵌入和位置编码输入 Transformer,适用于图像分类、目标检测等任务。

-

Swin Transformer 在 ViT 的基础上改进,引入了分层架构(Hierarchical)和窗口化(Window-based)自注意力机制,解决了 ViT 对长序列处理效率低的问题,支持多尺度特征提取,适用于目标检测、语义分割等任务。

-

DETR(DEtection TRansformer) 首次将 Transformer 直接用于目标检测,通过集合预测(Set Prediction)和可变形注意力(Deformable Attention)实现端到端检测,无需锚框(Anchor-Free),适用于复杂场景的实例分割和目标检测。

-

SAM(Segment Anything Model) 由 Meta 发布的分割模型,通过提示(如点击、框选)实现任意物体的精准分割,支持多种模态(图像、文本、点提示),在医疗影像分析、AR/VR 实时分割等领域有广泛应用。

应用场景

-

医疗影像:SAM 可用于医学图像的病灶分割。

-

自动驾驶:DETR 用于实时目标检测和语义分割。

-

图像编辑:SAM 提供快速物体抠图能力。

当前发展

-

趋势:视觉 Transformer 在多模态任务(如视频理解)中与 CNN 结合,提升模型效率(如 Swin-V2)。

-

挑战:计算成本高,需轻量化设计(如 MobileViT)。

2.多模态模型

技术背景

-

CLIP(Contrastive Language-Image Pretraining) 通过对比学习联合训练文本和图像嵌入,实现跨模态对齐,可完成图像-文本检索、图像描述生成等任务。

-

BLIP(Bootstrapped Language-Image Pretraining) 在 CLIP 基础上引入掩码语言建模和图像-文本对齐优化,提升视觉问答(VQA)、图像描述生成的性能。

-

DINO(DIstillation with NO labels) 自监督学习模型,通过对比学习和蒸馏技术,无需标注数据即可预训练视觉表征,适用于无监督场景下的图像分类和下游任务。

-

MiniGPT-4 多模态大模型,结合视觉 Transformer 和语言模型(如 GPT),支持图文生成、复杂推理,是 LLM 驱动的多模态系统(如通义千问、Qwen-VL)的典型代表。

应用场景

-

图文检索:CLIP 用于电商商品搜索。

-

内容生成:MiniGPT-4 用于图文创作和虚拟助手。

-

教育与辅助:BLIP 实现图像内容自动标注。

当前发展

-

趋势:多模态模型与 LLM 结合,推动 AIGC(如图像生成、视频描述)。

-

挑战:多模态对齐的鲁棒性、长尾问题(Long-tail)。

4.视频理解

技术背景

-

I3D(Inflated 3D Convolutional Networks) 基于 3D 卷积网络,通过时间维度扩展 2D 卷积核,捕捉视频时序信息,适用于动作识别和视频分类。

-

SlowFast Network 双流网络设计,Slow 路径捕捉慢变化(如物体外观),Fast 路径捕捉快变化(如动作),提升动作识别精度。

-

TimeSformer 将 Transformer 扩展到视频领域,通过时间位置编码和空间-时间自注意力机制,处理视频帧的时空关系,用于动作检测和视频分类。

应用场景

-

视频监控:动作识别用于异常行为检测。

-

体育分析:动作分类用于运动员动作评估。

-

视频摘要:TimeSformer 提取关键帧生成摘要。

当前发展

-

趋势:时空 Transformer 结合 CNN,提升效率(如 X3D)。

-

挑战:长视频处理的计算开销,需轻量化设计。

5.边缘 AI & 嵌入式 CV

技术背景

-

OpenVINO Intel 的优化工具,支持模型量化、剪枝和部署到 CPU、VPU(如 Movidius),加速边缘设备(如无人机、摄像头)的推理速度。

-

TensorRT NVIDIA 的推理优化库,针对 GPU 和 Tensor Core 加速,支持模型引擎化(Engine)部署,用于自动驾驶和机器人。

-

NPU 部署 利用专用神经网络处理器(如华为昇腾、地平线征程系列),通过框架转换(如 ONNX 转 NPU 模型)实现低功耗、高性能部署。

应用场景

-

智能家居:人脸识别门锁的实时检测。

-

工业检测:嵌入式设备的缺陷检测。

-

自动驾驶:车载摄像头的实时目标跟踪。

当前发展

-

趋势:模型压缩(如知识蒸馏、量化)与硬件协同设计(如 NPU 架构优化)。

-

挑战:模型精度与计算资源的平衡。

6.AI for AR/VR

技术背景

-

NeRF(Neural Radiance Fields) 通过神经网络表示场景的密度和辐射场,实现高质量 3D 场景重建,适用于虚拟现实中的场景渲染和物体建模。

-

SLAM(Simultaneous Localization and Mapping) 实时定位与地图构建技术,结合视觉、IMU 等传感器,用于 AR 设备的定位和环境感知(如 AR 眼镜)。

-

SfM(Structure from Motion) 通过多视角图像重建 3D 结构,用于 AR 内容生成和 VR 场景建模。

-

Depth Estimation(深度估计) 通过单目或双目视觉预测深度图,实现物体遮挡处理和空间交互(如 VR 中的手部追踪)。

应用场景

-

AR 虚拟试衣:Depth Estimation 用于服装虚拟试穿。

-

VR 游戏:NeRF 生成高精度游戏场景。

-

导航辅助:SLAM 实现室内导航。

当前发展

-

趋势:轻量化 NeRF(如 Instant NGP)和实时 SLAM 技术。

-

挑战:动态环境下的鲁棒性,高精度与实时性的矛盾。

总结与趋势

-

跨领域融合:视觉 Transformer 与多模态模型结合(如视频文本生成)。

-

轻量化与效率:边缘部署和移动端优化是关键(如 MobileViT、TinyNeRF)。

-

场景驱动:AR/VR 和自动驾驶推动实时性需求,需软硬协同设计。

-

开源生态:Meta、Google 等持续发布开源模型(如 SAM、DINOV2)加速技术落地。

二、五大领域深入推荐与资源

①Transformer 视觉模型

| 模型 | 代表论文 / 项目 | 应用方向 |

| ViT | ViT (Google, ICLR 2021) | 图像分类 |

| Swin | 微软 Swin Transformer | 下游视觉任务基础 |

| DETR | Facebook 提出,Transformer + 目标检测 | 无 NMS 的目标检测 |

| SAM | Meta's Segment Anything | 通用图像分割模型 |

以下是针对 ViT、Swin、DETR、SAM 四个模型的详细技术分析,包括其核心思想、架构设计、应用场景及优缺点的对比总结:

1. Vision Transformer (ViT)

核心思想

-

目标:将 Transformer 架构从自然语言处理(NLP)迁移到计算机视觉任务。

-

关键创新:

-

将图像划分为固定大小的 **patch**(如 16×16),展平为一维向量。

-

通过线性嵌入(Linear Embedding)和位置编码(Positional Encoding)输入 Transformer 编码器。

-

使用 全局自注意力(Global Self-Attention) 捕捉图像全局特征。

-

架构设计

(1)Patch Embedding:将图像分割为不重叠的 patch,每个 patch 转为向量。

(2)Positional Encoding:添加可学习的位置编码,保留空间信息。

(3)Transformer Encoder:多层 Transformer 块(自注意力 + 前馈网络)。

(4)类头:通过 [CLS] 标记的输出进行分类。

应用场景

-

图像分类(如 ImageNet)

-

下游任务:通过迁移学习适应目标检测、语义分割等。

优缺点

| 优点 | 缺点 |

| 直接利用全局上下文,适合大规模数据 | 计算复杂度高(自注意力为 \(O(N^2)\),N 是 patch 数) |

| 端到端训练,无需手工设计特征 | 对小目标或局部细节敏感(缺乏局部感受野) |

| 适合长序列建模(如长视频) | 需要大量标注数据 |

2. Swin Transformer

核心思想

-

目标:改进 ViT 的效率和局部特征建模能力。

-

关键创新:

-

分层架构(Hierarchical):多尺度特征提取(如 Patches、Windows、Stages)。

-

窗口化自注意力(Window-based Self-Attention):分块计算自注意力,降低计算复杂度。

-

移位窗口(Shifted Window):通过滑动窗口避免边界效应,保持全局感知。

-

架构设计

(1)Patch Partition:图像分为多个窗口(如 7×7 patch 的 4×4 窗口)。

(2)Window-based Attention:在窗口内计算自注意力,减少计算量。

(3)移位窗口(Shifted Window):相邻窗口部分重叠,避免局部信息断裂。

(4)多级缩放:通过下采样生成多尺度特征(类似 CNN 的金字塔结构)。

应用场景

-

目标检测(如 Swin + DETR)

-

语义分割(如 Swin + Mask R-CNN)

-

视频理解(Swin-V2 支持视频帧建模)

优缺点

| 优点 | 缺点 |

| 效率显著提升(窗口机制降低计算量) | 分层设计可能增加模型复杂度 |

| 保留局部特征的同时保持全局感知 | 需要调整窗口大小和移位策略 |

| 适用于多任务(分类、检测、分割) | 对小物体检测仍需优化 |

3. DETR(DEtection TRansformer)

核心思想

-

目标:端到端目标检测,无需锚框(Anchor-Free)。

-

关键创新:

-

集合预测(Set Prediction):直接输出目标的集合(无顺序依赖)。

-

可变形注意力(Deformable Attention):仅关注与目标相关的区域,减少计算量。

-

匈牙利匹配(Hungarian Matching):通过损失函数将预测与真实框对齐。

-

架构设计

(1)Backbone:特征提取(如 ResNet 或 Swin Transformer)。

(2)Transformer Encoder:编码全局上下文。

(3)Transformer Decoder:通过查询(Queries)生成目标预测。

(4)可变形注意力:在解码器中动态选择关键采样点(参考点)。

应用场景

-

实例分割(DETR + mask head)

-

多目标检测(如 COCO 数据集)

-

视频目标检测(通过时间序列扩展)

优缺点

| 优点 | 缺点 |

| 端到端训练,无需 NMS 后处理 | 计算复杂度高(尤其可变形注意力) |

| 直接输出目标集合,无锚框设计 | 对小目标和密集目标效果较差 |

| 适用于复杂场景(如遮挡、多目标) | 收敛速度较慢 |

4. SAM(Segment Anything Model)

核心思想

-

目标:通用分割模型,支持多种提示(点击、框选、文本)。

-

关键创新:

-

**Prompt-Driven Segmentation

-

💡 推荐动手项目:

-

使用 HuggingFace Transformers 加载 ViT / SAM

-

用 Gradio 构建图像分割 App

②多模态模型(图文对齐)

| 模型 | 开源实现 | 功能 |

| CLIP | OpenAI 原创,HuggingFace 已收录 | 图 ↔ 文 嵌入空间对齐 |

| BLIP | Salesforce,图文生成 | 图→文描述 / 文→图生成 |

| DINO | 自监督图像特征提取 | 下游任务迁移基础 |

| MiniGPT | 支持图文对话 | 类似 GPT4-Vision 小型模型 |

以下是针对 CLIP、BLIP、DINO、MiniGPT-4 四个多模态模型的详细技术分析,涵盖其核心思想、架构设计、应用场景及优缺点对比:

1. CLIP(Contrastive Language-Image Pretraining)

核心思想

-

目标:通过对比学习(Contrastive Learning)将图像和文本嵌入到统一的语义空间中,实现跨模态对齐。

-

关键创新:

-

无监督预训练:利用大规模未标注的图文对(如互联网图文配对数据)。

-

对比损失(Contrastive Loss):最大化图像和对应文本的相似度,最小化与其他文本/图像的相似度。

-

对称性设计:同时学习图像到文本和文本到图像的映射。

-

架构设计

(1)图像编码器:基于 ViT 或 ResNet 的特征提取器。

(2)文本编码器:基于 Transformer 的语言模型(如 BERT 或 GPT)。

(3)嵌入空间:将图像和文本编码为固定长度的向量,并通过余弦相似度对齐。

(4)对齐训练:通过批量内的图文对(Batch-wise Pairs)计算对比损失。

应用场景

-

图文检索:电商商品搜索、社交媒体内容推荐。

-

零样本迁移(Zero-Shot Learning):通过文本提示实现新任务(如分类、检测)。

-

图像生成:作为扩散模型的引导(如 DALL·E 2 使用 CLIP 作为引导)。

优缺点

| 优点 | 缺点 |

| 跨模态对齐能力强,支持零样本学习 | 对长尾类别或复杂语义关系敏感 |

| 无需标注数据即可预训练 | 文本理解能力依赖于语言模型质量 |

| 支持多种下游任务(分类、检索) | 对动态场景(如视频)适应性不足 |

2. BLIP(Bootstrapped Language-Image Pretraining)

核心思想

-

目标:改进 CLIP 的多任务学习能力,支持更复杂的视觉-语言任务(如视觉问答、图像描述生成)。

-

关键创新:

-

多任务蒸馏(Multitask Distillation):结合图文对比、掩码语言建模(Masked Language Modeling)和图像掩码(Masked Image Modeling)。

-

自举训练(Bootstrapped Training):利用模型自身生成的伪标签进行迭代优化。

-

架构设计

(1)统一编码器:基于 ViT 的图像编码器和 Transformer 的文本编码器。

(2)多任务头:

-

图文对比头:与 CLIP 类似。

-

掩码语言建模头:预测文本中的掩码 token。

-

掩码图像建模头:预测图像中的掩码 patch。

(3)联合优化:通过多任务损失函数协同训练。

应用场景

-

视觉问答(VQA):理解图像内容并回答问题。

-

图像描述生成:为图像生成自然语言描述。

-

图文生成:根据文本生成图像(需结合扩散模型)。

优缺点

| 优点 | 缺点 |

| 多任务能力更强,支持生成和理解任务 | 计算资源需求高(多任务联合训练) |

| 支持细粒度任务(如局部区域描述) | 对复杂问题的推理能力有限 |

| 预训练数据效率较高 | 需要高质量的图文配对数据 |

3. DINO(DIstillation with NO labels)

核心思想

-

目标:通过自监督学习(Self-Supervised Learning)预训练视觉表征,无需标注数据。

-

关键创新:

-

去噪学生-教师框架(Denoising Student-Teacher Framework):

-

教师模型:固定参数,从噪声数据中学习稳定表征。

-

学生模型:通过蒸馏(Distillation)从教师模型中学习。

-

-

对比损失(Contrastive Loss):最大化不同增强视图的相似性。

-

架构设计

(1)图像编码器:基于 ViT 的特征提取器。

(2)教师模型:对输入图像进行随机增强(如裁剪、旋转)后,通过教师编码器生成嵌入。

(3)学生模型:通过对比损失学习教师的表征。

(4)蒸馏过程:学生模型逐步优化以匹配教师表征。

应用场景

-

无监督预训练:在无标注数据的场景(如医疗影像、卫星图像)中初始化模型。

-

下游任务迁移:分类、检测、分割等任务的微调。

-

跨模态对齐:与文本编码器结合(如 DINOv2+Text)。

优缺点

| 优点 | 缺点 |

| 无需标注数据,适合无监督场景 | 表征质量依赖于数据增强策略 |

| 支持大规模预训练(如 DINOv2) | 训练时间较长(需教师-学生框架) |

| 在下游任务中表现接近监督模型 | 对小样本任务优化空间有限 |

4. MiniGPT-4

核心思想

-

目标:结合视觉 Transformer 和大型语言模型(LLM),实现多模态理解和生成。

-

关键创新:

-

多模态融合:将视觉特征(ViT)和文本特征(LLM,如 Qwen、GPT)融合到统一空间。

-

分层架构:视觉编码器提取视觉特征,语言模型生成文本,通过交叉注意力交互。

-

端到端训练:在图文配对数据上联合优化。

-

架构设计

(1)视觉编码器:基于 ViT(如 Swin Transformer)提取图像特征。

(2)语言模型:基于 LLM(如 GPT-4)生成文本。

(3)多模态融合层:

-

视觉特征通过线性投影与文本 token 融合。

-

通过交叉注意力(Cross-Attention)实现视觉-语言交互。

(4)解码器:生成图文描述、回答问题或执行复杂推理。

应用场景

-

图文生成:根据文本描述生成图像(需扩散模型)。

-

视觉问答(VQA):结合图像和文本理解复杂问题。

-

多模态推理:如根据图像和文本生成故事或摘要。

优缺点

| 优点 | 缺点 |

| 强大的多模态理解和生成能力 | 计算资源需求极高(依赖大模型) |

| 支持复杂任务(如长文本生成) | 需要大量高质量图文数据 |

| 与 LLM 结合实现端到端推理 | 可能产生幻觉(Hallucination) |

5.对比总结

| 模型 | 核心优势 | 典型应用场景 | 技术特点 |

| CLIP | 跨模态对齐强,支持零样本学习 | 图文检索、生成引导 | 对比学习,无需标注数据 |

| BLIP | 多任务学习,生成能力突出 | 视觉问答、图像描述生成 | 掩码建模与多任务蒸馏 |

| DINO | 无监督预训练,数据高效 | 无标注场景下的表征学习 | 学生-教师框架,自监督蒸馏 |

| MiniGPT-4 | 大模型驱动,复杂推理能力 | 多模态生成与高级推理 | 视觉-语言融合,端到端训练 |

6.发展趋势与挑战

-

趋势:

-

多模态与 LLM 融合:如 MiniGPT-4 的设计,推动 AIGC(如文生图、视频生成)。

-

轻量化与效率:DINO 的自监督方法降低标注依赖,BLIP 的多任务设计提升模型利用率。

-

动态场景支持:扩展到视频-文本对齐(如时空 Transformer)。

-

-

挑战:

-

对齐鲁棒性:复杂语义(如隐喻、多义词)的跨模态对齐仍需改进。

-

计算成本:大模型(如 MiniGPT-4)的部署需硬件加速(如 GPU/TPU)。

-

伦理与安全:生成内容的真实性控制(如深度伪造检测)。

-

💡 推荐实验项目:

-

搭建 CLIP 检索引擎(上传图像→返回描述)

-

使用 BLIP2 做“看图说话”系统

③视频理解(时间序列 + 空间建模)

| 模型 | 应用 | 数据集 |

| I3D | 三维卷积建模时序信息 | Kinetics、UCF101 |

| SlowFast | 两路网络建模快动作+慢动作 | AVA、Charades |

| TimeSformer | Transformer 视频建模 | Something-Something |

以下是针对 I3D、SlowFast、TimeSformer 三个视频理解模型的详细技术分析,涵盖核心思想、架构设计、应用场景及优缺点对比:

1. I3D(Inflated 3D Convolutional Networks)

核心思想

-

目标:通过扩展 2D 卷积到 3D,直接捕捉视频的时空特征,解决传统 2D CNN 在时间维度上的不足。

-

关键创新:

-

膨胀卷积(Inflated Convolution):将 2D 卷积核扩展为 3D,时间维度初始设置为 \(1 \times 1 \times 1\),逐步扩展以学习时序信息。

-

全局池化(Global Pooling):对视频帧进行跨时间维度的池化,聚合全局时空特征。

-

架构设计

(1)3D 卷积层:将 2D 卷积核扩展为 3D(空间+时间),例如 \(3 \times 3 \times 3\) 的核。

(2)膨胀过程(Inflation):

-

初始层:时间维度为 \(1 \times 1 \times 1\),仅扩展空间维度。

-

后续层:逐步增加时间维度(如 \(3 \times 3 \times 3\)),以捕捉更长时间依赖。

(3)分类头:全局平均池化后接全连接层。

应用场景

-

动作识别(如 Kinetics 数据集)

-

视频分类(体育动作、日常活动识别)

-

视频摘要:提取关键帧或片段。

优缺点

| 优点 | 缺点 |

| 直接建模时空特征,无需额外时间模块 | 计算复杂度高(3D 卷积参数量大) |

| 适用于短时视频分类任务 | 对长视频处理效率低 |

| 端到端训练,无需手工设计特征 | 需要大量标注数据 |

2. SlowFast Network

核心思想

-

目标:通过双流网络设计,分别捕捉视频中的慢变化(外观)和快变化(运动)信息。

-

关键创新:

-

双流架构:

-

Slow Path:低帧率、高分辨率,捕捉外观和语义信息。

-

Fast Path:高帧率、低分辨率,捕捉运动和动态信息。

-

-

跨流交互:通过跨流注意力或特征融合增强表征。

-

架构设计

(1)Fast Path:

-

输入视频帧按高帧率(如每帧抽取 1 帧)。

-

使用小卷积核(如 \(3 \times 3 \times 3\))和小通道数,快速处理运动。

(2)Slow Path:

-

输入视频帧按低帧率(如每 8 帧抽取 1 帧)。

-

使用大卷积核和大通道数,捕捉细粒度外观。

(3)融合模块:通过跨流注意力或特征拼接融合两路径信息。

应用场景

-

复杂动作识别(如体育赛事中的高难度动作)

-

视频监控:异常行为检测(如跌倒、打架)

-

自动驾驶:动态场景中的物体运动预测。

优缺点

| 优点 | 缺点 |

| 分流设计提升运动和外观的平衡建模 | 计算资源需求较高(双流并行) |

| 对复杂动作(如快速运动)敏感 | 需要调整帧率和分辨率参数 |

| 在 Kinetics 等数据集上表现优异 | 对长尾类别泛化能力有限 |

3. TimeSformer

核心思想

-

目标:将 Transformer 架构扩展到视频领域,建模时空关系。

-

关键创新:

-

时空自注意力(Spatio-Temporal Self-Attention):

-

空间注意力:捕捉帧内像素关系。

-

时间注意力:捕捉帧间时序关系。

-

-

分层设计:通过层级 Transformer 处理多尺度时空特征。

-

架构设计

(1)视频分割:将视频划分为 \(T\) 帧,每帧分为 \(P \times P\) 的 patch。

(2)时空编码:

-

空间位置编码:为每个 patch 添加可学习空间坐标。

-

时间位置编码:为每帧添加可学习时间坐标。

(3)Transformer 块:

-

空间自注意力:在帧内 patch 间建模关系。

-

时间自注意力:跨帧 patch 建模时序依赖。

(4)分类头:通过 [CLS] 标记输出视频类别。

应用场景

-

视频分类与检测(如 YouTube-8M 数据集)

-

动作定位:检测视频中动作的起止时间。

-

视频生成:结合扩散模型生成连贯视频。

优缺点

| 优点 | 缺点 |

| 全局时空建模能力,捕捉长程依赖 | 计算复杂度高(\(O(N^2)\),N 是 patch 数) |

| 适用于需要全局时空关系的任务 | 内存占用大,难以处理长视频 |

| 可扩展性强(如结合 CNN 提升效率) | 需要大规模标注数据预训练 |

4.对比总结

| 模型 | 核心优势 | 典型应用场景 | 技术特点 |

| I3D | 直接建模时空特征,简单有效 | 短时动作识别、视频分类 | 3D 卷积,计算密集 |

| SlowFast | 分流设计平衡运动与外观建模 | 复杂动作检测、动态场景分析 | 双流 CNN,参数高效 |

| TimeSformer | 全局时空注意力,捕捉长程依赖 | 高级视频分类、动作定位 | Transformer 架构,适合多模态融合 |

5.发展趋势与挑战

-

趋势:

-

混合架构:结合 CNN 的局部特征与 Transformer 的全局建模(如 TimeSformer + CNN)。

-

轻量化设计:通过时空稀疏注意力或动态卷积降低计算量。

-

多模态扩展:与文本、语音结合(如视频-文本检索)。

-

-

挑战:

-

计算效率:3D 卷积和 Transformer 的高成本限制实时应用。

-

长视频处理:现有模型难以高效处理长时序列(如电影级视频)。

-

动态场景泛化:复杂光照、遮挡下的鲁棒性仍需提升。

-

💡 推荐开源项目:

-

MMAction2(OpenMMLab 出品)

④边缘AI部署方向

| 技术 | 支持平台 | 优势 |

| TensorRT | NVIDIA Jetson/GPU | 高速、低延迟 |

| OpenVINO | Intel CPU/VPU | 支持异构计算(NCS2等) |

| TFLite | Android / ARM 芯片 | 小模型部署 |

| RKNN | Rockchip 芯片 | NPU 推理引擎 |

以下是针对 TensorRT、OpenVINO、TFLite、RKNN 四个边缘 AI 和嵌入式视觉(CV)部署工具的详细技术分析,涵盖核心功能、架构设计、应用场景及优缺点对比:

1. TensorRT(NVIDIA TensorRT)

核心功能

-

目标:优化深度学习模型在 NVIDIA GPU 上的推理性能。

-

关键特性:

-

模型优化:通过图优化、层融合、精度量化(FP32/FP16/INT8)减少计算量。

-

硬件加速:利用 CUDA Core 和 Tensor Core 实现 GPU 加速。

-

部署支持:生成优化后的引擎(Engine)文件,直接调用 CUDA 接口。

-

架构设计

(1)流程:

-

解析器(Parser):读取模型文件(ONNX、TensorFlow、PyTorch 等)。

-

优化器(Optimizer):融合层、选择内核、调整精度。

-

构建器(Builder):生成优化后的推理引擎(Engine)。

-

执行器(Runtime):在 GPU 上运行推理。

(2)量化工具:

-

Calibrator:用于 INT8 量化时的动态范围收集。

-

校准算法:支持最小最大值(Min-Max)和熵校准。

应用场景

-

自动驾驶:车载 GPU 的实时目标检测。

-

机器人:Jetson 系列设备上的实时视觉感知。

-

工业检测:GPU 加速的高精度缺陷检测。

优缺点

| 优点 | 缺点 |

| GPU 加速显著提升推理速度 | 依赖 NVIDIA 硬件(CUDA 兼容设备) |

| 支持多种模型格式(ONNX、TF、PyTorch) | 需要 CUDA 环境和驱动支持 |

| 精度-速度平衡(INT8 量化) | 开源生态有限,社区资源依赖 NVIDIA |

2. OpenVINO(Intel OpenVINO)

核心功能

-

目标:优化模型在 Intel CPU、VPU(如 Movidius)、GPU 和 FPGAs 上的推理性能。

-

关键特性:

-

异构计算:支持多硬件协同(CPU+GPU+VPU)。

-

模型优化:剪枝、量化(INT8/FP16)、图优化。

-

跨平台支持:Windows、Linux、边缘设备(如 Raspberry Pi)。

-

架构设计

(1)流程:

-

模型转换:通过 Model Optimizer 将模型转换为 IR(Intermediate Representation)格式。

-

推理引擎(Inference Engine):

-

插件系统:根据硬件选择 CPU、GPU 或 VPU 插件。

-

执行网络:在目标硬件上部署优化后的模型。

-

(2)优化策略:

-

自动向量化:利用 Intel 指令集(AVX-512)加速 CPU 推理。

-

智能缓存:减少内存访问延迟。

应用场景

-

智能家居:CPU 上的实时人脸识别。

-

工业质检:边缘设备(如 Myriad VPU)的低功耗推理。

-

安防监控:多摄像头实时分析。

优缺点

| 优点 | 缺点 |

| 支持多硬件平台(CPU、VPU、GPU) | 对非 Intel 硬件优化有限 |

| 低功耗部署(如 Movidius VPU) | 模型转换流程较复杂 |

| 开源且社区活跃 | 需要 Intel 芯片才能发挥最佳性能 |

3. TFLite(TensorFlow Lite)

核心功能

-

目标:优化 TensorFlow 模型在移动端和嵌入式设备(如手机、Raspberry Pi)上的推理性能。

-

关键特性:

-

轻量化:移除训练相关组件,仅保留推理部分。

-

量化:支持动态范围量化(Dynamic Range Quantization)和整数量化(INT8)。

-

自定义操作:支持通过 C++ 或 Rust 添加自定义算子。

-

架构设计

(1)流程:

-

转换工具:使用 TensorFlow Lite Converter 将模型转换为

.tflite格式。 -

优化选项:

-

量化:减少模型体积和计算量。

-

选择性优化:根据硬件选择 CPU、GPU 或 NPU 加速。

-

-

推理引擎:通过 TFLite Interpreter 执行推理。

应用场景

-

移动应用:手机端实时图像识别(如 AR 应用)。

-

物联网设备:树莓派、Arduino 等嵌入式设备的推理。

-

语音助手:轻量级语音识别模型部署。

优缺点

| 优点 | 缺点 |

| 与 TensorFlow 生态深度集成 | 仅支持 TensorFlow 模型格式 |

| 低延迟和低功耗 | 复杂模型(如 Transformer)优化有限 |

| 移动端部署简单(支持 Android/iOS SDK) | 需要额外工具链处理非 TensorFlow 模型 |

4. RKNN(Rockchip RKNN Toolkit)

核心功能

-

目标:优化模型在 Rockchip(瑞芯微)芯片(如 RK3568、RK3588)上的部署性能。

-

关键特性:

-

芯片级优化:针对瑞芯微 NPU 的硬件特性设计。

-

多平台支持:支持 Linux、Android 系统。

-

量化工具:提供自定义量化配置和校准流程。

-

架构设计

(1)流程:

-

模型转换:将模型(ONNX、TensorFlow、PyTorch)转换为 RKNN 格式。

-

优化工具:通过

rknn-toolkit进行图优化、量化和 NPU 加速。 -

部署:生成

.rknn模型文件,通过 SDK 调用 NPU 运行。

(2)硬件协同:

-

NPU 加速:利用瑞芯微芯片的专用神经网络处理器。

-

混合推理:结合 CPU/GPU/NPU 多核协同。

应用场景

-

智能硬件:搭载瑞芯微芯片的摄像头、机器人、智能音箱。

-

工业控制:低延迟的视觉检测(如 PCB 缺陷检测)。

-

车载系统:车载信息娱乐系统的实时图像处理。

优缺点

| 优点 | 缺点 |

| 针对瑞芯微芯片深度优化,性能最佳 | 仅支持瑞芯微硬件平台 |

| 提供完整的工具链和文档 | 生态相对封闭,社区资源较少 |

| 支持 NPU 硬件加速 | 对非瑞芯微模型的兼容性需转换 |

5.对比总结

| 工具 | 核心优势 | 典型应用场景 | 硬件依赖 |

| TensorRT | NVIDIA GPU 加速,精度-速度平衡 | 自动驾驶、高性能边缘计算 | NVIDIA CUDA 兼容硬件 |

| OpenVINO | 多平台支持,CPU/VPU 低功耗部署 | 工业质检、安防监控 | Intel CPU/VPU/GPU |

| TFLite | 移动端轻量化,与 TensorFlow 集成 | 手机应用、物联网设备 | 通用 CPU/GPU(无硬件绑定) |

| RKNN | 瑞芯微芯片深度优化,NPU 加速 | 智能硬件、车载系统 | 瑞芯微芯片(如 RK35xx 系列) |

6.选择建议

-

需要 GPU 加速且硬件为 NVIDIA → TensorRT

-

多平台部署(尤其是 Intel 硬件) → OpenVINO

-

移动端或轻量化设备(如手机、树莓派) → TFLite

-

瑞芯微芯片的专用硬件 → RKNN

7.发展趋势与挑战

-

趋势:

-

轻量化与效率:模型压缩(如 TinyML)和硬件协同设计(如 NPU 专用指令集)。

-

跨平台兼容:OpenVINO 和 ONNX Runtime 等工具支持更多硬件。

-

边缘 AI 生态:厂商(如 NVIDIA、Intel、瑞芯微)提供端到端工具链。

-

-

挑战:

-

异构硬件适配:不同芯片架构的优化策略差异大。

-

实时性 vs 精度:边缘设备资源有限,需权衡模型复杂度。

-

开源与闭源生态:部分工具(如 RKNN)依赖厂商支持,社区贡献较少。

-

💡 推荐实践任务:

-

将YOLOv5导出为 ONNX→TensorRT,在 Jetson Nano 上部署测试

-

Raspberry Pi 上部署 TFLite 模型,用 OpenCV 摄像头实时识别

⑤AI for AR/VR(图像重建、SLAM)

| 技术/模型 | 功能说明 | 推荐资源 |

| NeRF(NerfStudio) | 通过多张图恢复3D场景 | 可视化 3D 网格 / 摄像头路径 |

| ORB-SLAM3 | 实时定位与建图 | VSLAM入门标杆开源系统 |

| SfM(结构光还原) | 多视图重建 | COLMAP |

以下是针对 NeRF(NerfStudio)、ORB-SLAM3、SfM(Structure from Motion) 的技术分析,涵盖核心原理、应用场景及优缺点对比:

1. NeRF(NerfStudio)

核心思想

-

目标:通过神经网络表示场景的**辐射场**(Radiance Field),实现高保真3D场景重建与渲染。

-

关键创新:

-

隐式表示:将场景的密度和颜色表示为连续函数,输入空间坐标 \( (x,y,z) \) 和视角方向 \( \theta \),输出体素密度和颜色。

-

多视角监督:通过多视角图像训练网络,学习场景的几何和光照信息。

-

动态扩展:NeRF 的变种(如 NeRF++、Instant-NGP)支持动态场景和实时渲染。

-

NerfStudio 的技术特点

-

工具链:提供端到端的 NeRF 训练、渲染和优化工具,支持动态场景(如 NeRF-VAE)。

-

高效渲染:结合哈希编码(Hash Encoding)和空间分层采样(如 Instant-NGP),加速推理。

-

多模态支持:可融合深度图、语义分割等信息提升重建精度。

技术架构

(1)数据输入:多视角图像(带相机内参和外参)。

(2)神经网络:

-

密度网络:预测体素密度(\( \sigma \))。

-

颜色网络:预测体素颜色(\( c \))。

(3)渲染过程:

-

沿光线投射路径积分密度和颜色,生成像素值。

-

通过体积渲染(Volume Rendering)公式合成图像。

应用场景

-

虚拟现实(VR):高精度3D场景重建(如虚拟旅游)。

-

电影特效:复杂场景的光线追踪渲染。

-

AR 增强:实时场景理解与虚拟物体融合。

优缺点

| 优点 | 缺点 |

| 生成高质量连续场景,支持任意视角渲染 | 计算和存储成本高(需 GPU 加速) |

| 支持动态场景(如视频 NeRF) | 训练需要多视角图像和精确相机参数 |

| 可融合光照和材质信息 | 实时渲染仍需优化(如 Instant-NGP) |

2. ORB-SLAM3

核心思想

-

目标:实时**同步定位与地图构建(SLAM)**,适用于动态环境和复杂场景。

-

关键创新:

-

多传感器融合:结合视觉(RGB、RGB-D)、IMU(惯性测量单元)和轮式里程计。

-

动态环境处理:通过特征过滤和鲁棒优化剔除动态物体。

-

闭环检测:基于 ORB 特征的回环检测,提升全局一致性。

-

技术架构

(1)前端(Localization):

-

特征提取:使用 ORB 特征(Oriented FAST and Rotated BRIEF)。

-

运动估计:通过 PnP 算法和 IMU 数据估计相机位姿。

(2)后端(Mapping):

-

回环检测:全局地图与当前帧的特征匹配。

-

优化:通过图优化(Graph Optimization)修正位姿和地图。

(3)动态处理:

-

特征过滤:基于光流或深度差异剔除动态区域。

-

重投影误差阈值:动态点不参与地图构建。

应用场景

-

机器人导航:移动机器人实时定位与避障。

-

AR/VR 头显:头部追踪和空间地图构建。

-

无人机导航:动态环境中自主飞行。

优缺点

| 优点 | 缺点 |

| 实时性高,适用于动态环境 | 对纹理不足或重复纹理场景鲁棒性差 |

| 支持多传感器融合,提升精度 | 需要高质量相机和 IMU 数据 |

| 开源且社区活跃(ROS 兼容) | 复杂场景下计算开销较大 |

3. SfM(Structure from Motion)

核心思想

-

目标:从图像序列中恢复相机运动和场景3D结构。

-

关键创新:

-

特征匹配:通过 SIFT、ORB 等特征匹配多视图图像。

-

运动恢复结构(SfM):通过 PnP 算法估计相机位姿,重建稀疏点云。

-

稠密重建:结合多视图几何生成稠密3D网格(如 COLMAP、MeshLab)。

-

技术流程

(1)特征提取与匹配:

-

提取图像局部特征(如 SIFT)并匹配跨视图对应点。

(2)稀疏重建:

-

运动估计:通过 RANSAC 估计相机位姿。

-

三角化:生成稀疏3D点云。

(3)稠密重建:

-

多视图立体匹配:生成深度图并融合为稠密点云。

-

网格化与纹理映射:生成网格模型并贴图。

应用场景

-

3D 建模:文物数字化、建筑扫描。

-

电影制作:场景重建与虚拟制作。

-

考古与文化遗产保护:高精度文物复原。

优缺点

| 优点 | 缺点 |

| 精度高,支持大规模场景重建 | 需要高质量多视角图像 |

| 可结合传统CV与深度学习 | 稀疏重建耗时,稠密重建计算量大 |

| 开源工具成熟(如 COLMAP) | 动态场景或快速运动下效果差 |

4.对比总结

| 技术 | 核心优势 | 典型应用场景 | 技术特点 |

| NeRF | 高保真连续场景渲染,支持动态场景 | VR/AR 内容生成、电影特效 | 神经隐式场,依赖多视角数据 |

| ORB-SLAM3 | 实时定位与动态环境鲁棒性 | 机器人导航、无人机避障 | 特征匹配+多传感器融合,开源且轻量 |

| SfM | 精确3D重建,传统CV基础方法 | 静态场景建模、文化遗产保护 | 多视图几何,依赖特征匹配与三角化 |

5.发展趋势与挑战

-

NeRF:

-

趋势:轻量化(如 TinyNeRF)、动态场景建模(如 VideoNeRF)、实时渲染(如 Neuralangelo)。

-

挑战:训练数据需求大,动态场景鲁棒性不足。

-

-

ORB-SLAM3:

-

趋势:多传感器融合(激光雷达+视觉)、边缘计算部署。

-

挑战:低纹理/动态环境下的定位精度。

-

-

SfM:

-

趋势:与深度学习结合(如神经渲染辅助重建)、轻量化工具开发。

-

挑战:稠密重建效率与动态场景适应性。

-

6.选择建议

-

需要高精度连续场景渲染 → NeRF

-

实时定位与导航 → ORB-SLAM3

-

静态场景的3D建模 → SfM

💡 推荐入门项目:

-

使用 NerfStudio 对静物多角度照片重建 3D 模型

-

在室内构建 ORB-SLAM 地图,实时获取摄像头姿态

三、学习建议与资料推荐

| 类别 | 推荐资源 |

| 课程 | Stanford CS231n(CNN基础)MIT 6.S191(深度学习新趋势)CMU 16-720(视觉) |

| GitHub 项目 | awesome-computer-visionawesome-multimodal |

| 实验平台 | KaggleHuggingFace[Google Colab] 免费 GPU 实验 |

| 论文平台 | Papers with CodeArxiv-sanity |

| 模型体验 | Segment Anything PlaygroundClip Interrogator Demo |

四、项目模板

项目源码,查看绑定的资源文件

| 文件名 | 描述说明 |

| 01_vit_classification.ipynb | Vision Transformer 图像分类示例 |

| 02_sam_segmentation.ipynb | Segment Anything 模型应用 |

| 03_clip_multimodal_search.ipynb | CLIP 多模态图文检索系统 |

| 04_nerf_reconstruction_readme.txt | NeRF 图像三维重建使用说明 |

| 05_slam_orbslam3_readme.txt | ORB-SLAM3 实时定位与建图说明 |

| README.txt | 项目导航与参考建议 |

扩展阅读:

| AI 技术&AI开发框架 | AI 技术&AI开发框架 |

| 深度解析 AI 应用开发流程 | 深度解析 AI 应用开发流程 |

| 深度解析 AI 开发的全栈生态 | 深度解析 AI 开发的全栈生态 |

| 从0到1:AI 全栈项目实战模板 | 从0到1:AI 全栈项目实战模板 |

| 计算机视觉(Computer Vision, CV) | 计算机视觉(Computer Vision, CV) |

| 计算机视觉阶段一:CV入门基础 | 计算机视觉阶段一:CV入门基础 |

| 计算机视觉阶段二:经典算法与理论基础(传统CV) | 计算机视觉阶段二:经典算法与理论基础(传统CV) |

| 计算机视觉阶段三&四:深度学习 + CV 模型训练及部署实战 | 计算机视觉阶段三&四:深度学习 + CV 模型训练及部署实战 |

13万+

13万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?