Apache atlas 的作用和概念不再陈述地址;

官方文档:atlas安装文档;

鄙人编译安装的是2.0的atlas;

一、CDH上集成atlas;

首先在CDH hive配置参数如图:

搜hive-site

hive环境变量配置hive-hook的相关jar包hive-hook相关jar:

看图更贴切:

搜hive-en

报错query: java.lang.NoClassDefFoundError: Could not initialize class org.apache.atlas.hive.hook.HiveHook (state=,code=0)

把配置加入到HOOK目录下的atlas-plugin-classloader-1.1.0.jar 这个包:

zip -u atlas-plugin-classloader-1.1.0.jar atlas-application.properties

hiveserver2执行不再报错,到此hiveserver2完成。

二、客户端配置atlas

首先要有hadoop环境和hive环境,环境配置不再累述。

- Set-up Atlas hook in hive-site.xml by adding the following:

<property>

<name>hive.exec.post.hooks</name>

<value>org.apache.atlas.hive.hook.HiveHook</value>

</property>- Add 'export HIVE_AUX_JARS_PATH=

<atlas package>/hook/hive' in hive-env.sh of your hive configuration - hive-en.sh 变量HIVE_AUX_JARS_PATH里边加入hive-hook的jar

- 执行atlas的import-hive.sh 等待一会就回把hive的表结构信息导进来了

- 对hive的一些操作也会被实时记录下来

到此客户端配置告一段落 。。。。

- Column level lineage works with Hive version 1.2.1 after the patch for HIVE-13112 is applied to Hive source

- 字段级别的血缘只能在hive1.2.1之后的版本使用(鄙人用的1.1的hive很是遗憾)

The following hive operations are captured by hive hook currently

- create database

- create table/view, create table as select

- load, import, export

- DMLs (insert)

- alter database

- alter table (skewed table information, stored as, protection is not supported)

- alter view

hive涉及增删改等等的操作记录就会被atlas 实时监控起来。

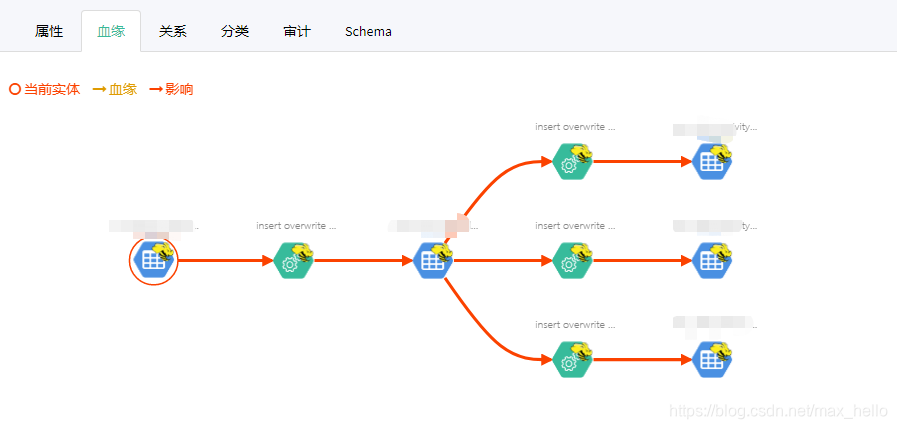

附血缘关系图一张

本文介绍了如何在CDH环境中集成Apache Atlas来管理Hive的元数据。首先,在Hive配置中添加Atlas相关参数并解决NoClassDefFoundError问题。然后,通过修改hive-site.xml和hive-env.sh文件配置客户端,导入Hive表结构,并实现对Hive操作的实时记录。但注意,字段级别血缘仅支持Hive 1.2.1及更高版本。

本文介绍了如何在CDH环境中集成Apache Atlas来管理Hive的元数据。首先,在Hive配置中添加Atlas相关参数并解决NoClassDefFoundError问题。然后,通过修改hive-site.xml和hive-env.sh文件配置客户端,导入Hive表结构,并实现对Hive操作的实时记录。但注意,字段级别血缘仅支持Hive 1.2.1及更高版本。

3066

3066