一、服务器规划

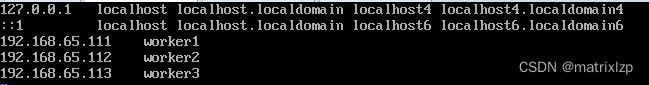

首先准备三台虚拟机 CentOS7

192.168.65.111 worker1

192.168.65.112 worker2

192.168.65.113 worker3

修改三台机器 hosts 文件

vim /etc/hosts

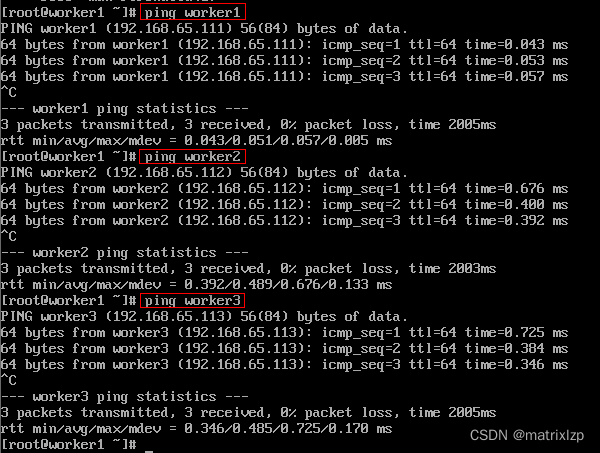

确保每台机器上都能 ping 通另外两台机器

就说明我们 hosts 配置没有问题

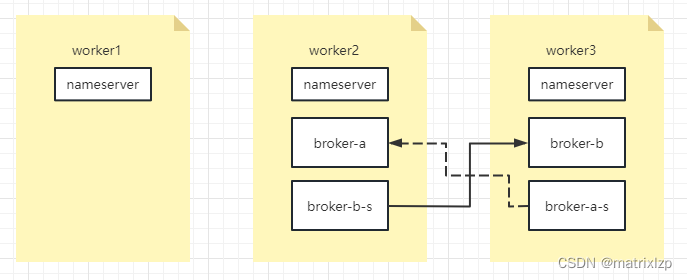

二、集群规划

| 机器名 | nemaeserver节点部署 | broker 节点部署 |

| worker1 | nemaeserver | |

| worker2 | nemaeserver | broker-a, broker-b-s |

| worker3 | nemaeserver | broker-b,broker-a-s |

1、配置第一组 broker-a

在 worker2 上先配置 broker-a 的 master节点。先配置 $ROCKETMQ_HOME/conf/2m-2s-async/broker-a.properties

[root@worker1 2m-2s-async]# vim broker-a.properties

#所属集群名字,名字一样的节点就在同一个集群内

brokerClusterName=rocketmq-cluster

#broker名字,名字一样的节点就是一组主从节点。

brokerName=broker-a

#brokerid,0就表示是Master,>0的都是表示 Slave

brokerId=0

#nameServer地址,分号分割

namesrvAddr=worker1:9876;worker2:9876;worker3:9876

#在发送消息时,自动创建服务器不存在的topic,默认创建的队列数

defaultTopicQueueNums=4

#是否允许 Broker 自动创建Topic,建议线下开启,线上关闭

autoCreateTopicEnable=true

#是否允许 Broker 自动创建订阅组,建议线下开启,线上关闭

autoCreateSubscriptionGroup=true

#Broker 对外服务的监听端口

listenPort=10911

#删除文件时间点,默认凌晨 4点

deleteWhen=04

#文件保留时间,默认 48 小时

fileReservedTime=120

#commitLog每个文件的大小默认1G

mapedFileSizeCommitLog=1073741824

#ConsumeQueue每个文件默认存30W条,根据业务情况调整

mapedFileSizeConsumeQueue=300000

#destroyMapedFileIntervalForcibly=120000

#redeleteHangedFileInterval=120000

#检测物理文件磁盘空间

diskMaxUsedSpaceRatio=88

#存储路径

storePathRootDir=/app/rocketmq/store

#commitLog 存储路径

storePathCommitLog=/app/rocketmq/store/commitlog

#消费队列存储路径存储路径

storePathConsumeQueue=/app/rocketmq/store/consumequeue

#消息索引存储路径

storePathIndex=/app/rocketmq/store/index

#checkpoint 文件存储路径

storeCheckpoint=/app/rocketmq/store/checkpoint

#abort 文件存储路径

abortFile=/app/rocketmq/store/abort

#限制的消息大小

maxMessageSize=65536

#flushCommitLogLeastPages=4

#flushConsumeQueueLeastPages=2

#flushCommitLogThoroughInterval=10000

#flushConsumeQueueThoroughInterval=60000

#Broker 的角色

#- ASYNC_MASTER 异步复制Master

#- SYNC_MASTER 同步双写Master

#- SLAVE

brokerRole=ASYNC_MASTER

#刷盘方式

#- ASYNC_FLUSH 异步刷盘

#- SYNC_FLUSH 同步刷盘

flushDiskType=ASYNC_FLUSH

#checkTransactionMessageEnable=false

#发消息线程池数量

#sendMessageThreadPoolNums=128

#拉消息线程池数量

#pullMessageThreadPoolNums=128

该节点对应的从节点在 worker3 上。修改 worker3 $ROCKETMQ_HOME/conf/2m-2s-async/broker-a-s.properties 只需要修改 brokerId 、brokerRole 还有那些存储路径的地址

[root@worker3 2m-2s-async]# vim broker-a-s.properties

#所属集群名字,名字一样的节点就在同一个集群内

brokerClusterName=rocketmq-cluster

#broker名字,名字一样的节点就是一组主从节点。

brokerName=broker-a

#brokerid,0就表示是Master,>0的都是表示 Slave

brokerId=1

#nameServer地址,分号分割

namesrvAddr=worker1:9876;worker2:9876;worker3:9876

#在发送消息时,自动创建服务器不存在的topic,默认创建的队列数

defaultTopicQueueNums=4

#是否允许 Broker 自动创建Topic,建议线下开启,线上关闭

autoCreateTopicEnable=true

#是否允许 Broker 自动创建订阅组,建议线下开启,线上关闭

autoCreateSubscriptionGroup=true

#Broker 对外服务的监听端口

listenPort=11011

#删除文件时间点,默认凌晨 4点

deleteWhen=04

#文件保留时间,默认 48 小时

fileReservedTime=120

#commitLog每个文件的大小默认1G

mapedFileSizeCommitLog=1073741824

#ConsumeQueue每个文件默认存30W条,根据业务情况调整

mapedFileSizeConsumeQueue=300000

#destroyMapedFileIntervalForcibly=120000

#redeleteHangedFileInterval=120000

#检测物理文件磁盘空间

diskMaxUsedSpaceRatio=88

#存储路径

storePathRootDir=/app/rocketmq/storeSlave

#commitLog 存储路径

storePathCommitLog=/app/rocketmq/storeSlave/commitlog

#消费队列存储路径存储路径

storePathConsumeQueue=/app/rocketmq/storeSlave/consumequeue

#消息索引存储路径

storePathIndex=/app/rocketmq/storeSlave/index

#checkpoint 文件存储路径

storeCheckpoint=/app/rocketmq/storeSlave/checkpoint

#abort 文件存储路径

abortFile=/app/rocketmq/storeSlave/abort

#限制的消息大小

maxMessageSize=65536

#flushCommitLogLeastPages=4

#flushConsumeQueueLeastPages=2

#flushCommitLogThoroughInterval=10000

#flushConsumeQueueThoroughInterval=60000

#Broker 的角色

#- ASYNC_MASTER 异步复制Master

#- SYNC_MASTER 同步双写Master

#- SLAVE

brokerRole=SLAVE

#刷盘方式

#- ASYNC_FLUSH 异步刷盘

#- SYNC_FLUSH 同步刷盘

flushDiskType=ASYNC_FLUSH

#checkTransactionMessageEnable=false

#发消息线程池数量

#sendMessageThreadPoolNums=128

#拉消息线程池数量

#pullMessageThreadPoolNums=128

2、配置第二组 broker-b

这一组broker的主节点在worker3上,所以需要配置worker3上的 $ROCKETMQ_HOME/conf/2m-2s-async/broker-b.properties

[root@worker3 2m-2s-async]# vim broker-b.properties

#所属集群名字,名字一样的节点就在同一个集群内

brokerClusterName=rocketmq-cluster

#broker名字,名字一样的节点就是一组主从节点。

brokerName=broker-b

#brokerid,0就表示是Master,>0的都是表示 Slave

brokerId=0

#nameServer地址,分号分割

namesrvAddr=worker1:9876;worker2:9876;worker3:9876

#在发送消息时,自动创建服务器不存在的topic,默认创建的队列数

defaultTopicQueueNums=4

#是否允许 Broker 自动创建Topic,建议线下开启,线上关闭

autoCreateTopicEnable=true

#是否允许 Broker 自动创建订阅组,建议线下开启,线上关闭

autoCreateSubscriptionGroup=true

#Broker 对外服务的监听端口

listenPort=10911

#删除文件时间点,默认凌晨 4点

deleteWhen=04

#文件保留时间,默认 48 小时

fileReservedTime=120

#commitLog每个文件的大小默认1G

mapedFileSizeCommitLog=1073741824

#ConsumeQueue每个文件默认存30W条,根据业务情况调整

mapedFileSizeConsumeQueue=300000

#destroyMapedFileIntervalForcibly=120000

#redeleteHangedFileInterval=120000

#检测物理文件磁盘空间

diskMaxUsedSpaceRatio=88

#存储路径

storePathRootDir=/app/rocketmq/store

#commitLog 存储路径

storePathCommitLog=/app/rocketmq/store/commitlog

#消费队列存储路径存储路径

storePathConsumeQueue=/app/rocketmq/store/consumequeue

#消息索引存储路径

storePathIndex=/app/rocketmq/store/index

#checkpoint 文件存储路径

storeCheckpoint=/app/rocketmq/store/checkpoint

#abort 文件存储路径

abortFile=/app/rocketmq/store/abort

#限制的消息大小

maxMessageSize=65536

#flushCommitLogLeastPages=4

#flushConsumeQueueLeastPages=2

#flushCommitLogThoroughInterval=10000

#flushConsumeQueueThoroughInterval=60000

#Broker 的角色

#- ASYNC_MASTER 异步复制Master

#- SYNC_MASTER 同步双写Master

#- SLAVE

brokerRole=ASYNC_MASTER

#刷盘方式

#- ASYNC_FLUSH 异步刷盘

#- SYNC_FLUSH 同步刷盘

flushDiskType=ASYNC_FLUSH

#checkTransactionMessageEnable=false

#发消息线程池数量

#sendMessageThreadPoolNums=128

#拉消息线程池数量

#pullMessageThreadPoolNums=128

然后他对应的 slave 在worker2上,修改work2上的 $ROCKETMQ_HOME/conf/2m-2s-async/broker-b-s.properties

#所属集群名字,名字一样的节点就在同一个集群内

brokerClusterName=rocketmq-cluster

#broker名字,名字一样的节点就是一组主从节点。

brokerName=broker-b

#brokerid,0就表示是Master,>0的都是表示 Slave

brokerId=1

#nameServer地址,分号分割

namesrvAddr=worker1:9876;worker2:9876;worker3:9876

#在发送消息时,自动创建服务器不存在的topic,默认创建的队列数

defaultTopicQueueNums=4

#是否允许 Broker 自动创建Topic,建议线下开启,线上关闭

autoCreateTopicEnable=true

#是否允许 Broker 自动创建订阅组,建议线下开启,线上关闭

autoCreateSubscriptionGroup=true

#Broker 对外服务的监听端口

listenPort=11011

#删除文件时间点,默认凌晨 4点

deleteWhen=04

#文件保留时间,默认 48 小时

fileReservedTime=120

#commitLog每个文件的大小默认1G

mapedFileSizeCommitLog=1073741824

#ConsumeQueue每个文件默认存30W条,根据业务情况调整

mapedFileSizeConsumeQueue=300000

#destroyMapedFileIntervalForcibly=120000

#redeleteHangedFileInterval=120000

#检测物理文件磁盘空间

diskMaxUsedSpaceRatio=88

#存储路径

storePathRootDir=/app/rocketmq/storeSlave

#commitLog 存储路径

storePathCommitLog=/app/rocketmq/storeSlave/commitlog

#消费队列存储路径存储路径

storePathConsumeQueue=/app/rocketmq/storeSlave/consumequeue

#消息索引存储路径

storePathIndex=/app/rocketmq/storeSlave/index

#checkpoint 文件存储路径

storeCheckpoint=/app/rocketmq/storeSlave/checkpoint

#abort 文件存储路径

abortFile=/app/rocketmq/storeSlave/abort

#限制的消息大小

maxMessageSize=65536

#flushCommitLogLeastPages=4

#flushConsumeQueueLeastPages=2

#flushCommitLogThoroughInterval=10000

#flushConsumeQueueThoroughInterval=60000

#Broker 的角色

#- ASYNC_MASTER 异步复制Master

#- SYNC_MASTER 同步双写Master

#- SLAVE

brokerRole=SLAVE

#刷盘方式

#- ASYNC_FLUSH 异步刷盘

#- SYNC_FLUSH 同步刷盘

flushDiskType=ASYNC_FLUSH

#checkTransactionMessageEnable=false

#发消息线程池数量

#sendMessageThreadPoolNums=128

#拉消息线程池数量

#pullMessageThreadPoolNums=128

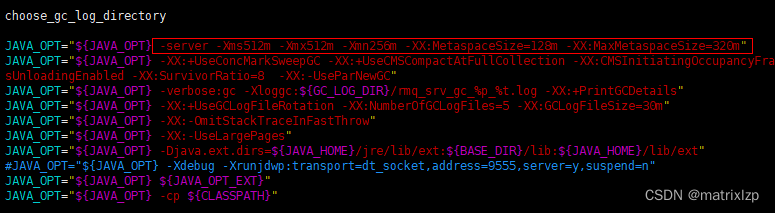

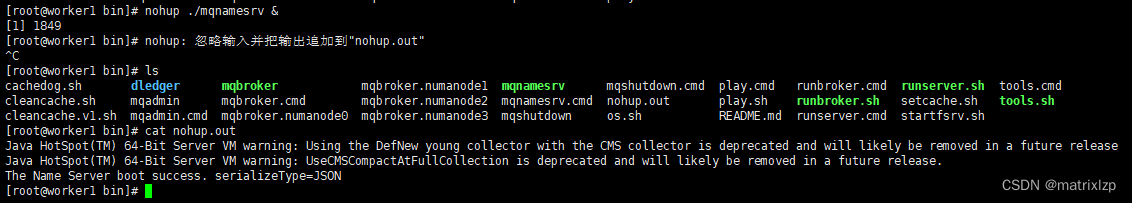

3、启动 nameserver

修改三个节点上的 $ROCKETMQ_HOME/bin/runserver.sh,调整里面的 jvm内存配置

在三个节点上运行

[root@worker1 bin]# nohup ./mqnamesrv &

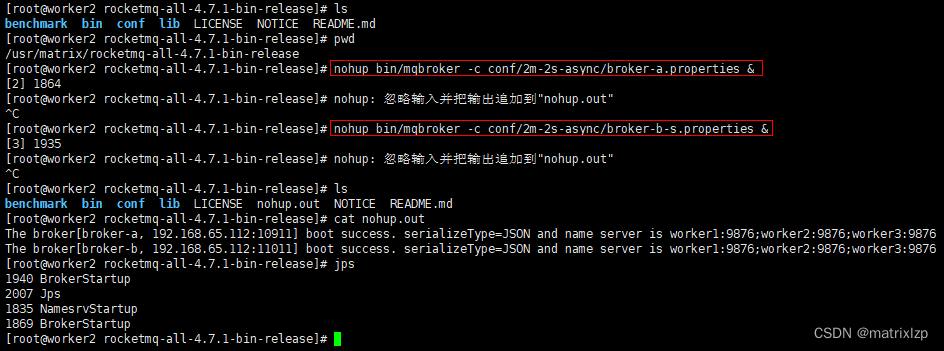

4、启动broker

启动 broker 是使用的 mqbroker 指令,只是注意启动 broker 时需要通过-c 指定对应的配置文件。 在 worker2上启动 broker-a 的 master 节点和 broker-b 的 slave 节点。

为了区分 nohup 的输出,我们在 $ROCKETMQ_HOME 执行

nohup bin/mqbroker -c conf/2m-2s-async/broker-a.properties &

nohup bin/mqbroker -c conf/2m-2s-async/broker-b-s.properties &

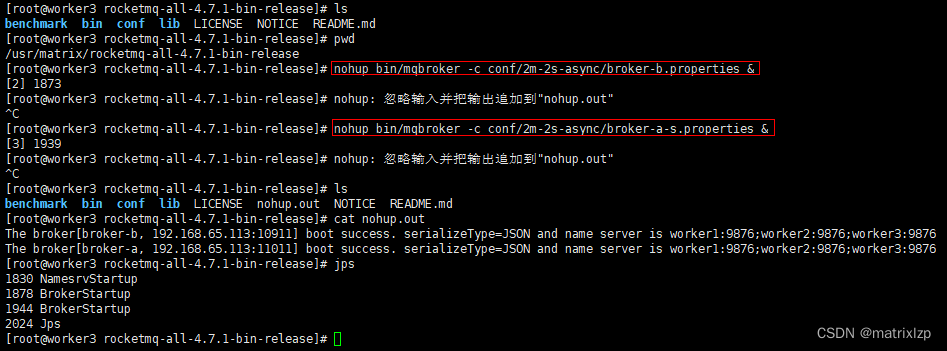

在 work3 上启动 broker-b 的 master 节点和 broker-a 的 slave 节点

# 查看nameServer日志

tail -500f ~/logs/rocketmqlogs/namesrv.log

# 查看broker日志

tail -500f ~/logs/rocketmqlogs/broker.log

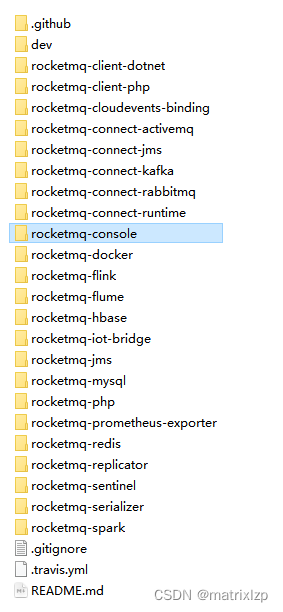

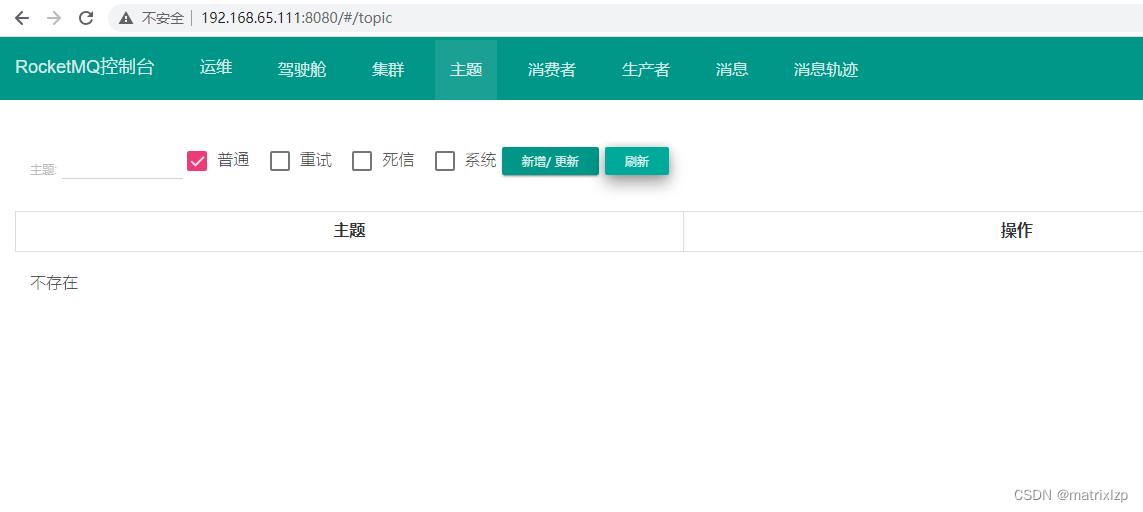

三、搭建管理控制台

rocketmq 扩展项目: https://github.com/apache/rocketmq-externals

下有一个

修改 rocketmq-console\src\main\resources 下的 application.properties文件

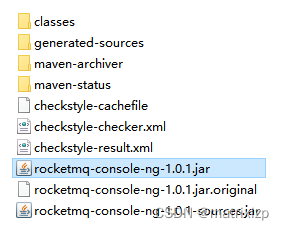

使用maven进行编译

mvn clean package -Dmaven.test.skip=true

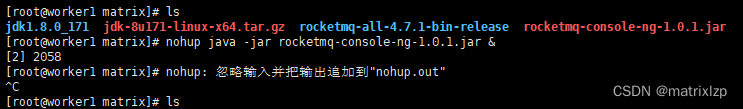

把 rocketmq-console-ng-1.0.1.jar 上传到集群任意一台服务器运行

nohup java -jar rocketmq-console-ng-1.0.1.jar &

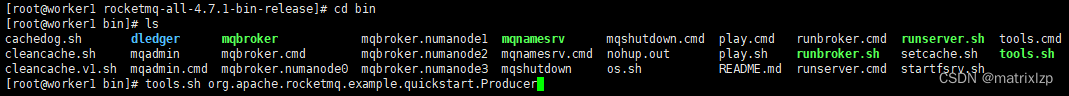

四、生产者发送消息

在RocketMQ的安装包中,提供了一个tools.sh工具可以用来在命令行快速验证RocketMQ服务。

tools.sh org.apache.rocketmq.example.quickstart.Producer

控制台多出来一个主题

五、消费者消费消息

tools.sh org.apache.rocketmq.example.quickstart.Consumer

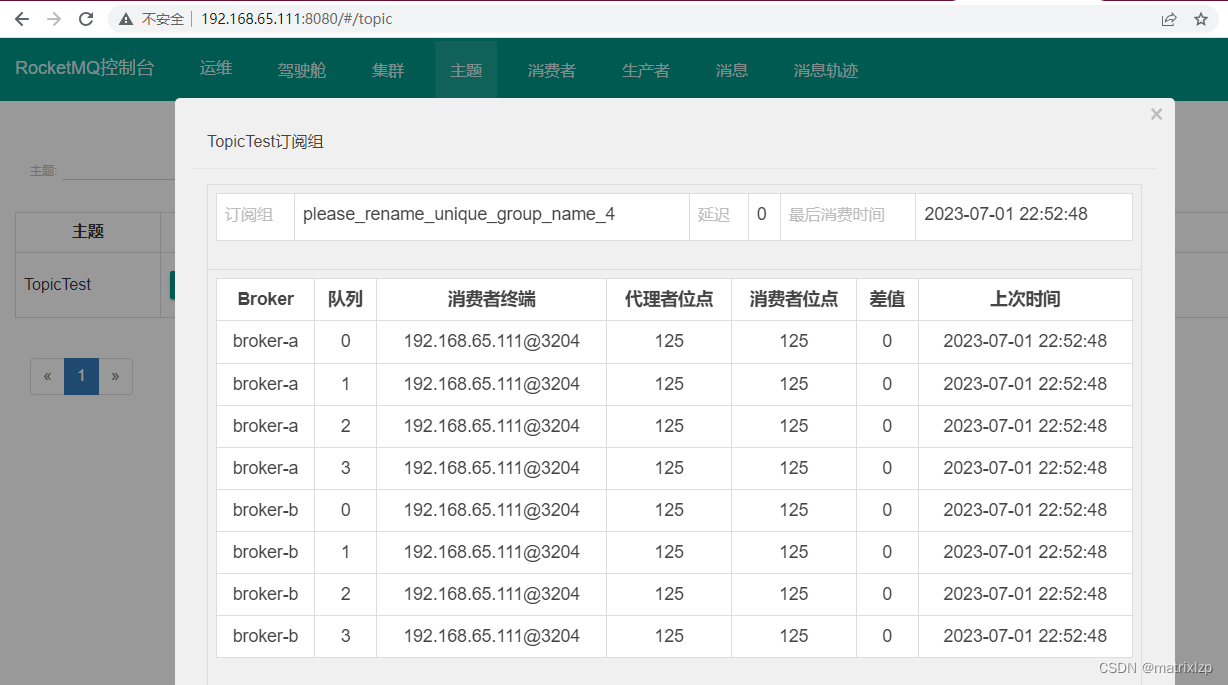

可以看到主题的消费情况

该文详细介绍了如何配置一个基于三台虚拟机的RocketMQ集群,包括服务器的网络配置、主从Broker的配置、NAMESRV的启动以及管理控制台的搭建。同时,文中还展示了如何使用生产者发送消息和消费者消费消息来验证集群的正常运行。

该文详细介绍了如何配置一个基于三台虚拟机的RocketMQ集群,包括服务器的网络配置、主从Broker的配置、NAMESRV的启动以及管理控制台的搭建。同时,文中还展示了如何使用生产者发送消息和消费者消费消息来验证集群的正常运行。

1015

1015

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?