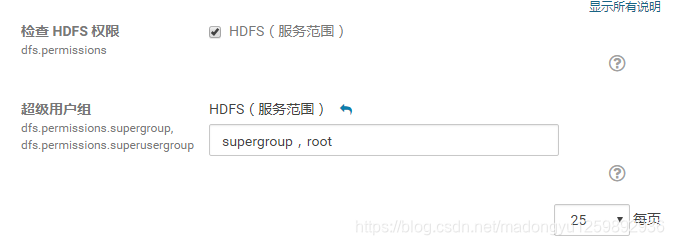

1.在CDH页面中添加超级用户

2.手动给用户授权

对CDH用户:对于文件夹/user,注意,这个文件夹的拥有者不是所谓的“root”。实际上,这个文件夹为“hdfs”所有(755权限,这里将hdfs理解为一个属于supergroup的用户)。

所以,只有hdfs可以对文件夹进行写操作。与Unix/Linux不同,hdfs是超级使用者(superuser),而不是root。

因此更改其权限为root。所以,你可以向这个文件夹随意的存、改文件了。

sudo -u hdfs hadoop fs -chown root /user

其中root是用户 /user 是将/user文件的权限给了root用户

3.对非CDH用户,到Namenode上修改hadoop的配置文件:conf/hdfs-core.xml, 找到 dfs.permissions 的配置项 , 将value值改为 false,修改完之后,要重启下hadoop的进程才能生效。

本文介绍如何在CDH页面中添加超级用户,并通过修改文件夹权限和Hadoop配置来实现用户授权。详细步骤包括更改/user文件夹权限给root用户及调整非CDH用户的Hadoop配置。

本文介绍如何在CDH页面中添加超级用户,并通过修改文件夹权限和Hadoop配置来实现用户授权。详细步骤包括更改/user文件夹权限给root用户及调整非CDH用户的Hadoop配置。

1398

1398

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?