机器学习

本篇文章为新手学习机器学习的全部过程以及对应章节的记录,如有问题尽请斧正。

第三章:线性模型

1.

1.1

什么是线性模型: 线性模型(linear model)试图学得一个通过属性的线性组合来进行预测的函数,既可以用于分类 也可以用于回归。从数学角度讲,回归就是用超平面做拟合,分类就是用超平面做分割。

谈及线性模型,其实我们很早就已经与它打过交道,还记得高中数学必修3课本中那个顽皮的“最小二乘法”吗?这就是线性模型的经典算法之一:根据给定的(x,y)点对,求出一条与这些点拟合效果最好的直线y=ax+b,之前我们利用下面的公式便可以计算出拟合直线的系数a,b(3.1中给出了具体的计算过程),从而对于一个新的x,可以预测它所对应的y值。

前面我们提到:在机器学习的术语中,当预测值为连续值时,称为“回归问题”,离散值时为“分类问题”。本篇先从线性回归任务开始,接着讨论分类和多分类问题。

线性回归

线性回归问题就是试图学到一个线性模型尽可能准确地预测新样本的输出值。

在线性模型,有时这些输入的属性值并不能直接被我们的学习模型所用,需要进行相应的处理。

对于连续值的属性,一般都可以被学习器所用,有时会根据具体的情形作相应的预处理,例如:归一化等;

对于离散值的属性,可作下面的处理:

若属性值之间存在“序关系”,则可以将其转化为连续值,例如:身高属性分为“高”“中等”“矮”,可转化为数值:{1, 0.5, 0}。

若属性值之间不存在“序关系”,则通常将其转化为向量的形式,例如:性别属性分为“男”“女”,可转化为二维向量:{(1,0),(0,1)}。

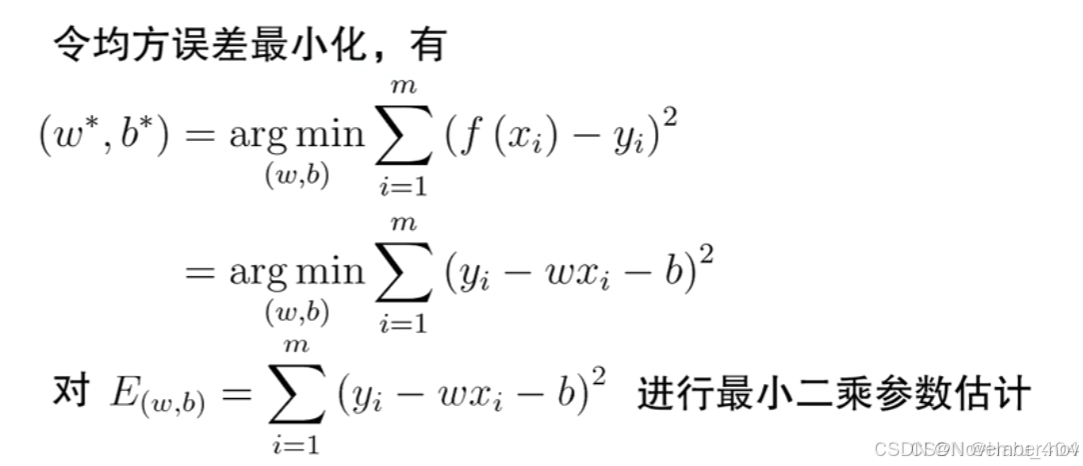

(1)当输入属性只有一个的时候,就是最简单的情形,也就是我们高中时最熟悉的“最小二乘法”(Euclidean distance),首先计算出每个样本预测值与真实值之间的误差并求和,通过最小化均方误差MSE,使用求偏导等于零的方法计算出拟合直线y=wx+b的两个参数w和b,计算过程如下图所示:

原文链接

1.2 基本术语

对于线性回归,它非常适合处理 数值属性。然而,离散值难以直接计算。因此要把离散值转化为连续问题。——序(order)概念。

如何确定ω和b呢?第二章介绍过的均方误差(square loss)是回归任务中最常用的性能度量,因此我们可以试图让均方误差最小化:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?