切记不可多行复制!!一行一行的复制!!!

-----------相关文件放在最后,虚拟机版本centos 7---------------

第一步

搭建静态IP(每次登陆后确保IP地址不发生改变)

VM打开编辑

进入虚拟网络编辑器

查看自己的虚拟网络地址后再进行主机IP的静态配置

!!如果不配置每次启动ip会发生变化!!

主机ip和网关配置请自行查阅计算机网络相关信息学习。

搭建后关闭有线连接再打开即可更改ip信息

su //登陆超级管理员

ifconfig ens33 //查看ens33身份下的ip信息

再次检查ip跟自己配置的ip是否相同

第二步:

在linux中切换用户

###su 用户名 //更改用户:此处暂时不需要使用

su //进入超级管理员

修改用户的权限设置(在su超管下配置):

后序过程尽量保持在超级管理员su下,即root下,不然权限不够

hostnamectl set-hostname slave[2]

chmod a+w /etc/sudoers //放开更改权限设置:必须在超级管理员下

vi /etc/sudoers //进行权限配置,具体配置见下文

进入插入模式 i

-- 用户名 ALL=(ALL) ALL //vi内配置插入用户所有权限语句

退出 :wq

chmod a-w /etc/sudoers //关闭更改权限的设置:超管下

利用sudo指令创建文件:

su 用户名 //进入用户下

//配置后便可在普通用户下采用sudo指令获得权限

sudo mkdir /date //用户下创建date目录

新建用户:

useradd zcw //新增用户名密:此处我新增zcw用户

passwd zcw //修改用户密码:此处也为用户名

tail /etc/passwd //查询用户信息:检查用户信息是否配置完成

把新用户配置为loaclhost:

hostname //检查当前主机名

hostnamectl set-hostname zcw //更改主机名:此处我的主机名改为了zcw,读者可根据需要改变

输入完成后即刻生效,只需要退出命令行重新打开即可看到(如下)

二号服务器

第三步:

关闭防火墙

su //进入超级用户

systemctl status firewalld //显示防火墙

systemctl stop firewalld //停止防火墙

getenforce //获取SE状态

>>>Enforcing //处于开启状态

setenforce 0 //关闭SE指令

getenforce //获取SE状态

>>>Permissve //处于关闭状态

这里我们要进行vi修改,直接修改文件配置

vi /etc/selinux/config //进入文件目录进行修改

--SELINUX=enforcig

改为

--SELINUX=disabled

--:wq //保存退出编辑

第四步:

配置ssh

ssh-keygen -t rsa //这里暂时不需要vi /etc/hosts,因为文件内有localhost自连接,后续需要搭建集群再更改

ssh-copy-id localhost //与本地搭建ssh连接,locathost也可以根据上面自己配置的locathost而更改

ssh localhost //ssh进入主机

exit //登出

进入windows控制台(Win+R)

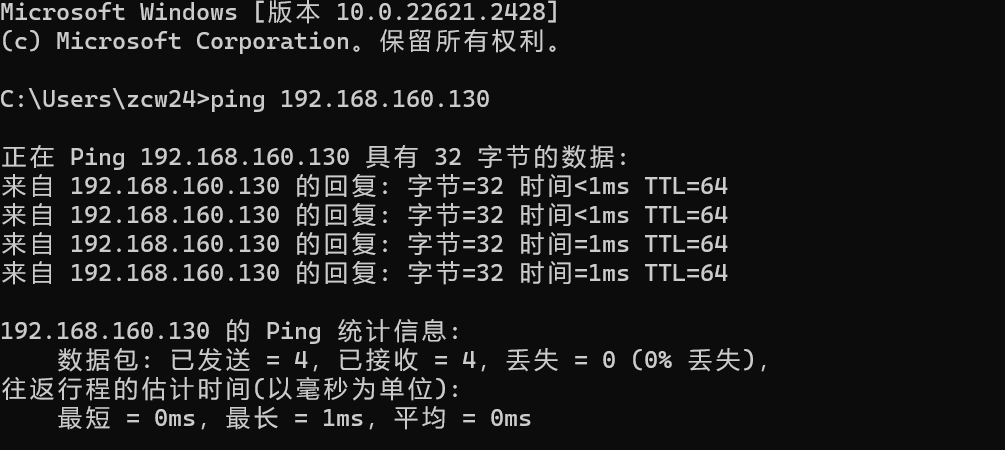

ping 192.168.160.130 //这里的ip应该为自己配置的ip信息,此处为本人配置的ip信息

ping的结果正常,表示已经正常连接

继续控制台操作

ipconfig //查看windows的ip配置信息,可以查看到我们本机的ip信息

以下为本人的ip信息

再次进入虚拟机,检验虚拟机与主机的连接:

虚拟机命令行输入:

ping -c 4 192.168.77.1(个人Windows主机ip) //此处ip应为主机ip信息

如下及验证成功连接:

双向的ssh已经验证可以正常连接

第五步:

文件的传输

下载老师发的文件在一个目录下(记得目录地址):

:::tips

!!!!建议把老师的零散文件打包到一个新建文件夹:Hadoopconf 下

:::

进入WinSCP,配置连接虚拟机:

用户名采用root最高级登陆

在虚拟机需要在对应文件目录下新建uploads目录:

(也可以在linux中对应目录下采用mkdir uploads 指令实现,此处不赘述)

补:!!后来发现这里漏添加了servers目录,在后续补上了,不影响环境的搭建!!

进入刚刚新建的uploads文件目录下,把文件复制到虚拟机中

:::tips

左边为Windows文件目录,右边为虚拟机文件目录

:::

文件传输完毕

可以断开ssh连接和WinSCP连接

:::tips

补:前面漏缺了servers的目录构建,此处进行弥补

:::

采用命令行构建目录

cd /usr/local //进入目录下

mkdir servers //创建server目录

!!如果权限不够需要进入su超级管理员,或者采用sudo mkdir servers构建,这里我就遇到了这样的问题

!!这里我新建的为server,老师的是servers,后续我修改回来了不必在意。

第六步

配置jdk环境:

cd /usr/local/uploads //进入刚刚导入的文件地址

ll //查看文件是否配置正常,如果不正常请检查之前步骤

su //进入超级管理员下,不然权限不够

tar -zxvf jdk-8u281-linux-x64.tar.gz -C ../servers //zxvf表示文件压缩并另保存到

//..表示上级目录,这里表示存到servers中

cd ../servers //进入servers下进行

mv jdk1.8.0_281/ jdk //更改文件名为jdk

---------------------------------------------------------------------------

cd ../uploads

cd Hadoopconf/ //进入Hadoopconf目录下

vi profile //进入相关文件

>>>:q //直接退出即可

cp -rf profile /etc/profile //把这个文件直接复制到对应的路径,然后覆盖即可

source /etc/profile //对文件进行刷新构建

java -version //检查java版本,如果没用问题jdk构建成功

配置hadoop

cd /usr/local/uploads //进入刚刚导入的文件地址

ll //查看文件是否配置正常

su //进入超级管理员下,不然权限不够

tar -zxvf hadoop-3.1.3.tar.gz -C ../servers //zxvf表示文件压缩并另保存到

//..表示上级目录,这里表示存到servers中

cd ../servers/

mv hadoop-3.1.3/ hadoop //重命名

##以下代码为视频精简版,减去了打开文件学习文件内部参数的过程,如有兴趣请自行学习##

cd /servers/hadoop/

cd etc

cd hadoop

cp /usr/local/uploads/Hadoopconf/hadoop-env.sh .

cp /usr/local/uploads/Hadoopconf/core-site.xml .

cp /usr/local/uploads/Hadoopconf/hdfs-site.xml .

cp /usr/local/uploads/Hadoopconf/yarn-site.xml .

cp /usr/local/uploads/Hadoopconf/mapred-site.xml .

新建命令栏

su

cd /usr/local/servers

mkdir hadoop/tmp

mkdir hadoop/tmp/nndata

mkdir hadoop/tmp/dndata

source /etc/profile

hadoop version

hdfs namenode -format

start-dfs.sh

jps

start-yarn.sh

jps

结果如下,即为正常:

:::info

本人已二次验证,以上命令结构按照顺序执行无任何问题

:::

网盘链接: https://pan.baidu.com/s/1Q6cZ5DCEm-tFUC2SglzQIA?pwd=qi7b 提取码: qi7b

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?