一 、安装Hadoop

- 从http://archive.apache.org/dist/hadoop/core/下载Hadoop-3.0.0,下载二进制压缩包文件:hadoop-3.0.0.tar.gz ,也可以在我的云盘里下载:链接:Hadoop-3.0.0 提取码:f5kq PS:在这里为了解压成功,所以最好将解压软件用管理员身份运行进行解压。

- 从https://github.com/steveloughran/winutils下载针对Windows环境的Hadoop修正程序winutils(Hadoop-3.0.0对应路径https://github.com/steveloughran /winutils /tree /master/hadoop-3.0.0 )。如果不会用Git工具下载,可以直接下载打包文件https://github.com/steveloughran/winutils/archive/master.zip,然后解压。也可以在我的云盘里提取:链接:winutils-master 提取码:lty8

- 确保自己的计算机上已经正确安装了JDK 1.8以上的Java开发和运行环境。(可以通过在命令行方式下运行java –version命令进行验证)

- 将hadoop-3.0.0.tar.gz解压至C:Hadoop子目录(可以根据自己喜好更改Hadoop安装目录) PS:解压后为了不出现问题,请大家把解压的文件名改为 hadoop,不要出现-3.0.0

- 新增环境变量HADOOP_HOME(作为系统变量),并将其值设为“C:Hadoop”。(设置方法:进入“控制面板系统和安全系统”,然后点击“高级系统设置”,然后点击“环境变量(N)…”按钮)

- 观察JAVA_HOME变量设置是否正确。(本人计算机上的JAVA_HOME被设置为C:Program FilesJavajdk1.8.0_192)

- 将“C:Hadoopin”和“C:Hadoopsbin”路径添加到Path环境变量。

- 将如下内容粘贴到C:Hadoopetchadoopcore-site.xml文件:

注意是将两个configuration之间的内容粘贴到原文件的两个configuration之间

fs.defaultFS

hdfs://localhost:9000

9.将如下内容粘贴到C:Hadoopetchadoopmapred-site.xml文件:

mapreduce.framework.name

yarn

10.在C:Hadoop路径下创建“data”子目录;

在C:Hadoopdata路径下创建“namenode”子目录;

在C:Hadoopdata路径下创建“datanode”子目录。

11.将如下内容粘贴到C:Hadoopetchadoophdfs-site.xml文件:

dfs.replication

1

dfs.namenode.name.dir

file:///C:/hadoop/data/namenode

dfs.datanode.data.dir

file:///C:/hadoop/data/datanode

12.将如下内容粘贴到C:Hadoopetchadoopyarn-site.xml文件:

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.nodemanager.auxservices.mapreduce.shuffle.class

org.apache.hadoop.mapred.ShuffleHandler

13.编辑文件C:Hadoopetchadoophadoop-env.cmd,将语句:

“set JAVA_HOME=%JAVA_HOME%”

修改为“set JAVA_HOME=C:PROGRA~1Javajdk1.8.0_192”。

(PS:此处有坑。如果将hadoop-env.cmd中的JAVA_HOME设置为“C:Program FilesJavajdk1.8.0_192”,将会出错,因为路径中不能含有空格。所以你最好把你的文件路径都设置成英文的,还不能有空格。同时建议你的以后环境变量配置都遵循这一原则)

14.C:Hadoopin目录下的内容删除。

15.将第2步下载的“winutils-master.zip”解压,然后将解压文件中“…winutils-masterhadoop-3.0.0in”目录下的内容拷贝到“C:Hadoopin”目录。

二/检验Hadoop是否按照成功

经过前面15步,Hadoop安装结束。

运行如下命令测试Hadoop是否可以正常运行:

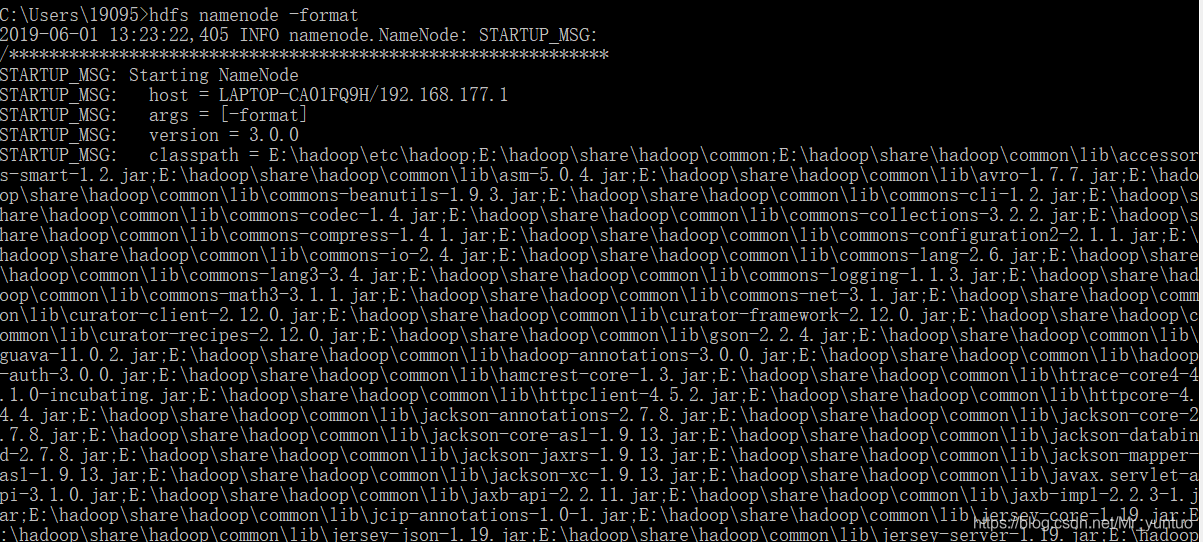

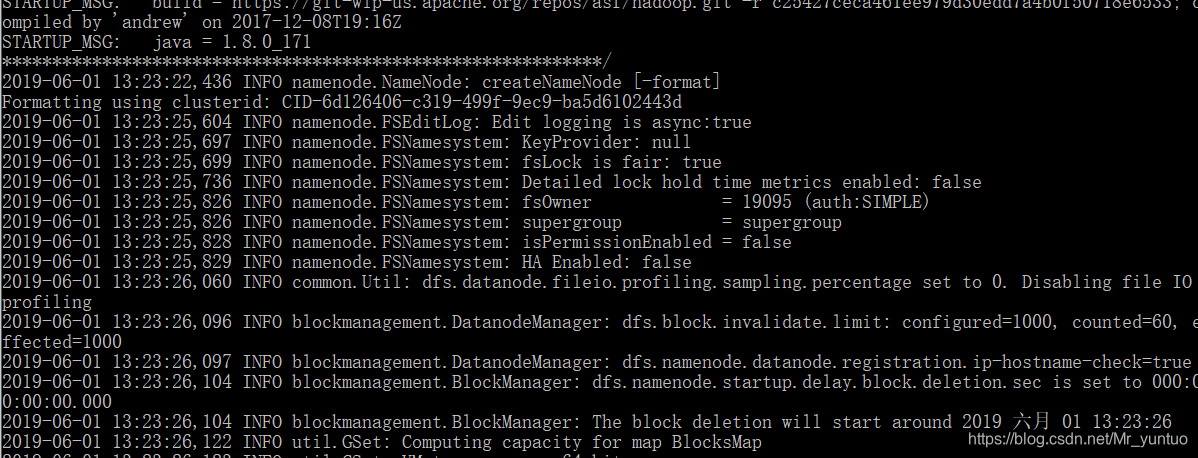

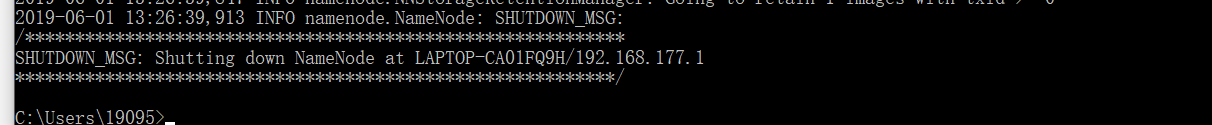

- 运行命令“hdfs namenode –format”,先对HDFS分布式文件系统进行格式化。 如果成功就会产生这样的内容:

在这一行 *号下面要检查是不是出现了问题,如果出现了问题一定要复制粘贴问题进行查询。

在这一行 *号下面要检查是不是出现了问题,如果出现了问题一定要复制粘贴问题进行查询。  2.进入“C:Hadoopsbin”目录运行命令“start-dfs”。如果一切正常,将会启动一个“hdfs namenode”进程和一个“hdfs datanode”进程,构成了只有1个主节点和1个从节点的“HDFS分布式文件系统集群”。可以通过“http://localhost:9870”监控HDFS系统。(用jps命令可以查看所有jvm相关的进程)HDFS分布式文件系正常启动之后,可以用“hadoop fs”或“hdfs dfs”命令在分布式文件系统中实现“浏览目录”、“创建子目录”、“删除子目录”、“创建文件”、“拷贝文件”、“移动子目录或文件”、“查看文件内容”、“删除文件”、“上传本地文件”等操作。

2.进入“C:Hadoopsbin”目录运行命令“start-dfs”。如果一切正常,将会启动一个“hdfs namenode”进程和一个“hdfs datanode”进程,构成了只有1个主节点和1个从节点的“HDFS分布式文件系统集群”。可以通过“http://localhost:9870”监控HDFS系统。(用jps命令可以查看所有jvm相关的进程)HDFS分布式文件系正常启动之后,可以用“hadoop fs”或“hdfs dfs”命令在分布式文件系统中实现“浏览目录”、“创建子目录”、“删除子目录”、“创建文件”、“拷贝文件”、“移动子目录或文件”、“查看文件内容”、“删除文件”、“上传本地文件”等操作。

hadoop fs **–**ls /

显示根目录下的所有文件和目录

hadoop fs –mkdir /test

创建子目录**/test****,创建多级目录** 加上 **–**p

hadoop fs -rm /test1.txt

删除文件

hadoop fs -rm -r /test

删除子目录(要加**-r****参数)**

hadoop fs -put C: mp est.txt est

将本地文件上传到HDFS分布式文件系统

hadoop fs -cat est est.txt

查看文件内容

hadoop fs -cp URI [URI …]

cp 复制系统内文件

hadoop fs -get[-ignorecrc] [-crc]

下载文件到本地

hadoop fs -mv URI [URI …]

将文件从源路径移动到目标路径

hadoop fs -du URI [URI …]

显示文件大小

3.http://localhost:9870工具中在“utilities”菜单下有一个“Browse the File System”工具,可以浏览、操作HDFS分布式文件系统。

4.进入“C:Hadoopsbin”目录运行命令“stop-dfs”,关闭HDFS分布式文件系统。

如果觉得不错,点个赞再走吧!!!

本文详细介绍了在Windows系统上安装和配置Hadoop3.0.0的步骤,包括下载Hadoop和winutils,设置环境变量,配置核心、MapReduce、HDFS和YARN站点XML文件,以及启动、测试和关闭HDFS的过程。通过本文,读者可以学习到如何在本地搭建Hadoop单节点集群。

本文详细介绍了在Windows系统上安装和配置Hadoop3.0.0的步骤,包括下载Hadoop和winutils,设置环境变量,配置核心、MapReduce、HDFS和YARN站点XML文件,以及启动、测试和关闭HDFS的过程。通过本文,读者可以学习到如何在本地搭建Hadoop单节点集群。

571

571

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?