今天要读的是一篇综述:

《Multilingual video dubbing—a technology review and current challenges》

翻译过来是《多语言视频配音 — 技术回顾和当前挑战》

讨论的主题是:多语言自动配音技术的发展与挑战

发表时间:2023

期刊:Frontiers in Signal Processing

影响因子:无

原文:https://doi.org/10.3389/frsip.2023.1230755

摘要

当今流媒体服务中多语言内容的激增催生了对自动化多语言配音工具的需求。在本文中,参考了自动配音和密切相关的 Talking Head Generation 领域的最新工作,讨论了当前最先进的方法。提出了这两个领域的论文分类法,并讨论和概述了语音驱动的自动配音和说话头生成的主要挑战,以及对解决这些问题的未来研究的建议。

1 引言和背景

视频配音问题并不是最近的挑战。回顾Cao et al. (2005)作者讨论了模拟面部肌肉运动的复杂性,并指出数据驱动的方法在当时,也就是近二十年前,已经产生了一些最有希望的结果。最近马里奥里亚德和布索 (2012)基于 MPEG-4 面部动画标准,使用视听 IEMOCAP 数据库 (Busso et al., 2008)。虽然 MPEG 中定义的面部动画参数 (FAP) 很有用,但这种基于模型的方法不再被视为照片级真实语音配音或面部动画的最新技术 (SOTA)。尽管如此,这些早期的工作证明了文献中对语音驱动的面部重演的长期研究。

今天,面部渲染以及声学和语音模型取得了许多新的进展。视频配音的要求主要是由视频流媒体行业的发展 (Hayes 和 Bolanos-Garcia-Escribano,2022 年),并将成为本综述的重点。流媒体服务的快速增长和由此产生的竞争导致了新内容的激增,非英语内容显著增长,受众在全球范围内扩展到现有和新的非英语受众和市场。领先的内容流媒体服务的成功在很大程度上在于向这些需要更复杂和半自动化字幕和配音服务的新市场提供更高的内容质量。

字幕服务非常成熟,为非英语观众提供了通往不断增长的视频内容库的有用桥梁。领先的服务也开始发布具有多种语言配音的新内容,并对遗留内容进行注释和配音 (罗克斯伯勒, 2019; NILESH 和 DECK,2023 年)。自动翻译算法可以在这方面提供帮助,但通常还需要人工输入来提高结果翻译的质量。

当内容经过专业配音时,配音演员会仔细工作,使翻译后的文本与原始演员的面部动作和表情保持一致。这是一项具有挑战性且技术娴熟的任务,很难找到多语种配音演员,因此通常只有电影中的主演才会进行专业配音。这会为大多数配音内容产生“恐怖谷”效果,从而减损观看体验,并且通常最好以带字幕的原始语言观看内容。因此,数字内容的配音仍然是视频流行业面临的重大挑战 (Spiteri Miggiani,2021 年)。

为了在观看多语言内容时获得最佳体验质量,不仅需要为角色的语音轨道配音,还需要调整其面部表情,尤其是嘴唇和下巴运动,以匹配语音配音。这需要对每个可用语言轨道的原始视频内容进行细微调整,确保在嘴唇和下巴运动响应新语言轨道时,原始语言演员的整体表现不会以任何方式降低。但是,实现这种无缝的音频驱动自动配音并非易事,在过去五年中提出了许多方法来解决这个问题。事实证明,深度学习技术在该领域尤其受欢迎 (Yang et al., 2020; Vougioukas 等人,2020 年; Thies 等人,2020 年; Song et al., 2018; 温 et al., 2020),展示了自动配音任务的令人信服的结果,以及限制较少、更知名的“会说话的头生成”任务。

在本文中,参考了自动配音领域的最新和相关工作以及密切相关的 Talking Head Generation 领域,讨论了当前最先进的方法。提出了这两个领域内论文的分类法,并讨论和概述了当前用于音频驱动自动配音和说话头生成的 SOTA。最近的方法可以大致分为两大思想流派:端到端或基于结构的生成(Liang 等人,2022 年).从这篇评论中可以清楚地看出,现在许多基础技术都可用于处理照片般逼真的多语言配音,但仍然存在挑战,我们试图在结论性讨论中定义和澄清这些挑战。

2 高级配音管线

传统上,配音是一项昂贵的后期制作工作,包括三个主要步骤:

- 翻译:这是获取原始视频的脚本并将其翻译成所需语言的过程。传统上,这是通过聘请精通原始语言和目标语言的多种语言专家来完成的。然而,随着近年来大型语言模型的出现,准确的自动语言到语言翻译正在成为现实 (Duquenne 等人,2023 年),并且早在 2020 年就已被 Netflix (阿拉孔, 2023).话虽如此,这些模型并不完美,容易出现误译,因此为了确保质量,仍然需要专家来检查翻译后的台词。

- 配音:翻译台词后,下一步就是为每种所需语言确定并聘请合适的配音演员。为了获得高质量的配音,必须注意确保配音演员能够准确地描绘原始录音的情感范围,并且他们的声音与屏幕上的角色适当匹配。这是一项成本高昂且耗时的工作,并且将从自动化中受益匪浅。尽管近年来文本转语音和语音克隆技术取得了令人难以置信的进步,但要真正复制专业配音演员的技能,仍有许多工作要做。韦茨曼,2023 年),但是对于质量不那么重要的项目,文本到语音转换是一个有吸引力的选择,因为它的成本较低。

- 音视频混合:一旦获得新的语言语音记录,最后一步就是将它们与原始视频记录尽可能无缝地组合在一起。传统上,这涉及大量的手动编辑工作,以便将新音频与原始视频性能正确对齐和同步。然而,即使是最熟练的编辑也无法真正同步这两个流。高质量的配音工作令人愉快,但通常内容被配音仍然很明显。质量差的配音工作会降低用户体验,通常会在观众中引起“恐怖谷”效果。

由于深度学习的最新进展,每个传统配音步骤都有自动化的空间。手动语言翻译可以通过大型语言模型自动执行,例如Duquenne 等人 (2023)。传统的配音可以被强大的文本转语音模型取代,例如瓦恩库奇 Łańcucki (2021); Liu et al. (2023); Wang et al. (2017)。然后可以通过说话头生成/视频编辑模型进行视听混合,例如周 et al. (2020)。给定原始视频和语言流,以下是将英语视频配音为德语的此类自动配音管线的示例:

- 转录和翻译源音频:使用现成的自动语音识别模型,可以从语音音频中生成准确的转录文本。然后,可以使用大型语言模型(如 BERT 或 GPT3)将英语翻译成德语,该模型针对语言到语言的翻译任务进行了微调。

- 合成音频:可以通过利用文本到语音模型来生成合成语音,将翻译后的转录文本作为输入,并输出逼真的语音。理想情况下,模型将根据原始演员的声音进行微调,并生成高质量的语音,听起来就像原始演员,但使用不同的语言。

- 3D 角色人脸解析:从视频流中检测并隔离目标角色。使用单目 3D 重建将目标角色的面部映射到 3D 可变形模型上,并隔离头部姿势/整体头部运动,获得静态 3D 面部。删除原始的嘴唇/下巴运动,但保留角色模型上的整体面部表情和眨眼。

- 面部动画生成:通过递归神经网络响应驱动合成德语音频语音信号,在 3D 面部模型上生成与嘴唇和下巴运动相对应的表情参数。将全局头部运动信息引入 3D 模型,以获得面部表情和头部姿势与原始表演对应的 3D 头部,但嘴唇和下巴会根据新音频进行修改。

- 渲染:遮罩原始视频中角色的面部区域,将新生成的 3D 面部模型插入顶部,并利用图像到图像转换网络生成最终的照片级真实输出帧。

上面描述的假设管道称为基于结构的方法,并且图 1.下一节将更详细地介绍流行的基于结构的方法,以及用于说话头像生成、音频驱动的自动配音/音频驱动的视频编辑的端到端方法。

图 1.描述本节中描述的自动配音过程。3D 模型图像取自作品Cudeiro 等人 (2019),而显示的受试者是Cooke 等人 (2006)数据。

本文的范围仅限于围绕处理面部动画生成的最新作品的讨论,即我们探讨了会说话头生成和音频驱动的自动配音/视频编辑的最新趋势。其余论文的组织方式如下:第 3 部分详细讨论了寻求解决 Talking Head Generation 和 Automatic Dubbing 的方法,将它们分类为端到端或基于结构的方法,并讨论了它们的优点和缺点。第 4 部分提供了用于训练这些任务的模型的常用数据集的详细信息,以及用于量化此类模型性能的常见评估指标列表。第 5 部分讨论了该领域的开放挑战,以及研究人员如何应对这些挑战,然后在第 6 部分.

3 会说话头生成和自动配音的分类法

说话头生成可以定义为从单个源图像或少量帧以及驱动语音音频输入创建新视频。与此相关的挑战有很多 (Chen et al., 2020a)。不仅生成的嘴唇和下巴运动必须与语音输入正确同步,而且整体头部运动也必须逼真,出现与说话者一致的眨眼,并且面部表情应与语音的语气和内容相匹配。虽然近年来提出了许多 talking head 方法,每种方法都在不同程度上解决了上述部分或全部问题,但正如本文将展示的那样,研究人员还有很大的空间来推动该领域的发展。

如前所述,音频驱动的自动配音任务是说话头生成问题的受限版本。目标是更改现有视频,重新同步目标演员的嘴唇和下巴运动,以响应新的输入音频信号,而不是从头开始创建整个视频。与会说话的头部生成不同,原始视频中已经存在头部运动、眨眼和面部表情等因素。挑战在于无缝改变视频的嘴唇和下巴内容,同时保持演员的表演尽可能接近原来,以免减损原作。

3.1 端到端与基于结构的生成

在高层次上,用于这两项任务的现有深度学习方法可以分为两种主要方法:端到端或基于结构的生成。每种方法都有自己的优点和缺点,我们现在将介绍一下。

3.1.1 管线复杂性和模型延迟

端到端方法具有更简单的管线的优势,可实现更快的处理速度并减少生成最终输出的延迟。通过减少组件数量和简化的计算,实时合成成为可能。但是,实际性能取决于所选架构、模型大小和输出帧大小等关键因素。例如,基于 GAN 的端到端方法可以获得实时结果,但它们通常仅限于较低的输出分辨率,例如 128 × 128 或 256 × 256。基于扩散的方法甚至更慢,即使使用更高效的采样方法,每帧也通常需要几秒钟甚至几分钟,尽管以牺牲图像质量为代价。在速度和输出分辨率之间取得适当的平衡对于优化端到端的说话头合成至关重要。需要强调的是,基于结构的方法也存在这些相同的限制,尤其是在其渲染过程中。然而,基于结构的方法往往比端到端方法更慢,因为其管道中涉及额外的计算步骤。基于结构的方法通常需要多个阶段,例如人脸检测、面部地标/3D 模型提取、表情合成、逼真渲染等。这些阶段中的每一个都会引入计算开销,使整个过程更加耗时。

3.1.2 级联错误

在基于结构的方法中,在管线的早期阶段犯的错误可以在整个过程中传播和放大。例如,人脸或路标检测的不准确会显著影响最终生成的视频的质量。另一方面,端到端方法绕过了对此类中间表示的需求,从而降低了级联错误的风险。但是,与此同时,当端到端方法中确实发生错误时,可能更难确定错误的来源,因为此类方法不会明确生成中间面部表示。生成过程中缺乏透明度,当输出与预期不符时,研究人员很难诊断和排除问题。开发错误分析和调试技术以提高端到端系统的可靠性和稳健性变得至关重要。

3.1.3 对不同数据的鲁棒性

基于结构的方法依赖于管道每个阶段精心策划和注释的数据集,创建这些数据集可能非常耗时且耗力。端到端方法通常适应性更强,并且更适合各种说话风格、口音和情感表达,因为它们可以利用大型和多样化的数据集进行训练。这种灵活性对于捕捉自然人类语音和面部表情中存在的细微差别和变化至关重要。

3.1.4 输出质量

输出质量是 Talking Head 合成中的一个关键方面,因为它直接影响生成视频的真实感和合理性。基于结构的方法在这方面表现出色,因为它们能够在合成过程中对面部的中间表示进行更精细的控制。使用此类方法,通常使用一组关键点(或 3D 模型参数)表示面部,从而捕获基本的面部特征和表情。这些标志作为生成面部运动的结构化指南,确保生成的视频符合人脸的解剖学限制。通过显式控制这些关键点,该模型可以产生与人类面部解剖结构一致的更准确、更逼真的面部表情。

端到端方法牺牲了一定程度的精细控制,以支持简单性和直接的音频到视频映射。虽然它们具有更快的处理速度和更低的延迟,但它们可能难以捕捉面部表情中存在的复杂细节和细微差别,尤其是在更具挑战性或不常见的场景中。

3.1.5 训练数据要求

端到端方法通常需要大量的训练数据才能在各种情况下很好地泛化。虽然基于结构的方法可以从针对特定任务的有针对性的、仔细注释的数据集中受益,但端到端方法可能需要更多样化和更广泛的数据集才能实现可比的性能。反过来,这意味着更长的训练时间,因为模型需要处理大量数据并从中学习,这可能是计算密集型和耗时的。这对研究人员和从业者来说可能是一个重大缺点,因为它阻碍了新模型的快速实验和开发。它可能还需要访问强大的硬件,例如高性能 GPU 或 TPU,以加速训练过程。

3.1.6 显式输出指导

基于结构的方法允许研究人员将明确的规则和约束合并到管道的不同阶段。这种明确的指导可以带来更准确和可控的结果,而这种指导更难实现的端到端方法可能缺乏。

3.2 基于结构的生成

基于结构的深度学习方法近年来非常流行,在说话头像生成和音频驱动的自动配音方面,它被认为是占主导地位的方法。如上所述,这是因为可以相对容易地控制最终输出视频、高质量的图像帧保真度以及为 3D 角色模型驱动动画的相对速度。

该问题通常分为两个主要步骤,而不是训练单个神经网络在给定音频信号的情况下生成所需的视频:1) 训练神经网络从面部底层结构表示的音频中驱动面部运动。结构表示通常是 3D 可变形模型或面部的 2D/3D 关键点表示。2) 使用第二个神经渲染模型从面部结构模型渲染逼真的视频帧。请参阅表 1有关文献中相关基于结构的方法的摘要。

表 1.表格总结了文献中一些最相关的基于结构的方法。

3.2.1 基于 2D/3D 特征点的方法

在本节中,我们将讨论依赖 2D 或 3D 面部特征点作为从音频生成面部动画的中间结构表示的方法。一些讨论的方法使用生成的特征点来制作 3D 面部模型的动画,这些方法也应被视为“基于特征”。图 2描述了典型的基于地标的方法的高级概述。

图 2.基于高级特征的管线,其中现有视频中的头部姿势和面部结构与目标音频剪辑中预测的嘴唇/下巴位移相结合,以生成修改后的视频。

Suwajanakorn 等人(2017 年),Taylor 等人 (2017)是最早探索使用深度学习技术生成语音动画的作品之一。前者训练了一个循环网络,在将它们合成到现有视频之前,从音频中生成稀疏的嘴部关键点,后者提出了一种广义语音动画的方法,通过训练神经网络模型来预测给定音素标签作为输入的参考人脸模型的动画参数。从那时起,该领域已经走过了漫长的道路,包括Eskimez 等人 (2018)介绍了一种通过基于 LSTM 的模型从音频生成静态(无头姿势)说话人脸标志的方法,以及Chen et al. (2019)通过在地标上调节 GAN 网络以生成逼真的帧来扩展工作。同样地Das 等人 (2020)还采用了基于 GAN 的架构,从音频中提取的 deepspeech 特征生成面部特征,然后使用以特征点为条件的第二个 GAN 来生成逼真的帧。

周 et al. (2020)的方法最早从音频中生成具有逼真头部姿势运动的会说话的面孔标志。他们通过训练两个 LSTM 网络来实现这一点,一个用于处理嘴唇/下巴运动,另一个用于生成头部姿势,然后将两个输出组合在一起,并将它们通过现成的图像到图像转换网络来生成逼真的帧。

Lu et al. (2021)的方法还使用一个单独的自动回归模型模拟了头部姿势和上半身运动,该模型在 DeepSpeech 音频特征上进行了训练,然后使用基于生成的地标的特征图的图像到图像转换模型生成逼真的帧。同时还提出了一种解决头部姿势问题的方法,Wang et al. (2021)解决了从单个图像生成说话头像视频时稳定非人脸(背景)区域的挑战。

与之前的所有方法解决说话头像生成任务的方法不同,以下论文属于音频驱动的自动配音类别,旨在修改现有视频。Ji et al. (2021)是最早解决生成情感感知视频肖像问题的公司之一,方法是将语音解开为两种表示形式,即内容感知的时间相关流和情感感知的时间无关流,并训练模型生成 2D 面部地标。这可能被认为是一种 “混合 ”结构方法,因为根据预测和GT地标(landmark),它们执行单目 3D 重建以获得两个 3D 人脸模型。然后,他们将来自GT的姿势参数与预测的表情和几何参数相结合,以创建最终的 3D 面部模型,然后提取边缘图并通过图像到图像转换生成输出帧。Bigioi 等人 (2022)从视频中提取真实 3D 地标,并训练网络直接在给定输入音频序列的情况下更改它们,而无需先将它们重新定位到静态固定面部模型,然后再对其进行动画处理,然后返回原始头部姿势。

3.2.2 基于 3D 模型的方法

在本节中,我们将讨论在生成面部动画时使用 3D 面部模型作为中间表示的方法。换句话说,我们讨论了训练模型以从作为输入的音频信号生成 blendshape 人脸参数的方法。图 3上面描述了一个此类模型的高级概述。

图 3.基于高级 3D 模型的管线,在源视频上执行单目面部重建,以提取表情、姿势和几何参数。然后训练一个单独的音频到表情参数预测网络。然后使用预测的表情参数替换原始参数,以生成新的 3D 面部网格,然后通过神经渲染模型将其渲染成逼真的视频。

Karras 等人 (2017)是最早使用深度学习从有限的音频数据中学习 3D 面部模型的面部动画的团队之一。Cudeiro 等人 (2019)引入了 4D 视听人脸数据集(会说话的 3D 模型),以及经过训练的网络,可以从 DeepSpeech 音频特征生成 3D 面部动画。Thies 等人 (2020)此外,还利用 DeepSpeech Audio 功能训练网络输出与说话人无关的面部表情参数,这些参数驱动中间 3D 面部模型,然后使用神经渲染模型生成逼真的帧。Chen et al. (2020b)的方法包括从一组参考帧中学习头部运动,然后将该信息与在 3D 感知帧生成网络中表示面部表情的 PCA 组件相结合。他们的方法很有趣,因为他们的管线解决了说话头像生成中的各种已知问题,例如保持头部的身份/外观一致、保持一致的背景以及生成逼真的说话人感知头部运动。Yi et al. (2020)提出了一种使用驱动音频信号生成说话头像视频的方法,方法是训练神经网络从音频中预测 3D 面部模型的姿势和表情参数,并将它们与从一组参考帧中提取的形状、纹理和照明参数相结合。然后,他们通过神经渲染器将 3D 面部模型渲染为照片真实感,然后使用内存增强的 GAN 微调渲染的帧。Wu et al. (2021)提出了一种在给定驱动语音信号的情况下生成目标肖像的说话头脸的方法,以及“Style Reference Video”。他们训练模型,使输出视频模仿参考视频的说话风格,但其身份与目标肖像相对应。Zhang et al. (2021b)提出了一种 One Shot Talking Head 动画的方法。给定参考帧和驱动音频源,他们使用编码器-解码器架构生成 3D 可变形模型的眉毛、头部姿势和嘴部运动参数。然后使用Flow导视频生成器创建最终输出帧。Zhang et al. (2021a)在给定驱动语音输入和参考视频剪辑的情况下合成会说话的头部视频。他们设计了一个基于 GAN 的模块,该模块可以输出给定 deepspeech 音频特征的 3D MM 的表情、眨眼和头部姿势参数。

虽然前面引用的方法都是纯说话头生成方法的示例,但以下内容属于自动配音类别。双Song 等人 (2022)和温 et al. (2020)提出了使用音频信号修改现有视频的方法,方法是训练神经网络从音频中提取 3D 人脸模型表情参数,并将它们与从原始视频中提取的姿势和几何参数相结合,然后应用神经渲染来生成修改后的照片级真实感视频。要生成面部动画,Song 等人 (2021)采用与上述方法类似的管线,但它们更进一步,通过编码器-解码器机制将原始视频说话人的声学特性转移到驱动语音上,本质上是对视频进行配音。Richard 等人 (2021)提供了一个通用框架,用于生成给定语音的准确 3D 面部动画,通过学习一个分类潜在空间,在推理时解开音频相关(嘴唇/下巴运动)和音频不相关(眨眼、上面部表情)信息。这样做,他们构建了一个框架,该框架可应用于自动配音和说话头像生成任务。Lahiri 等人 (2021)引入了一种编码器-解码器架构,经过训练可解码 3D 顶点位置 [类似于Karras 等人 (2017)],以及来自音频和先前生成的帧的嘴唇区域的 2D 纹理贴图。他们将这些网格组合在一起,形成一个带纹理的 3D 面部网格,然后渲染该网格并与原始视频混合,以生成配音视频剪辑。

我们还想提请注意Fried 等人 (2019)和Yao et al. (2021)。这些视频编辑方法除了利用音频之外,还利用文本来修改现有的说话头像视频。前一种方法的工作原理是将音素标签与输入音频对齐,并为每个输入帧构建一个 3D 面部模型。然后,在修改文本转录文本(例如,dog to god)时,他们会搜索输入视频中发音嘴型相似的片段,混合来自相应视频帧的 3D 模型参数以生成新帧,然后通过他们的神经渲染器进行渲染。后一种方法建立在这项工作的基础上,通过提高音素匹配算法的效率,并开发一种自我监督的神经重定向技术,用于将源参与者的嘴部动作传递给目标参与者。

3.3 端到端生成

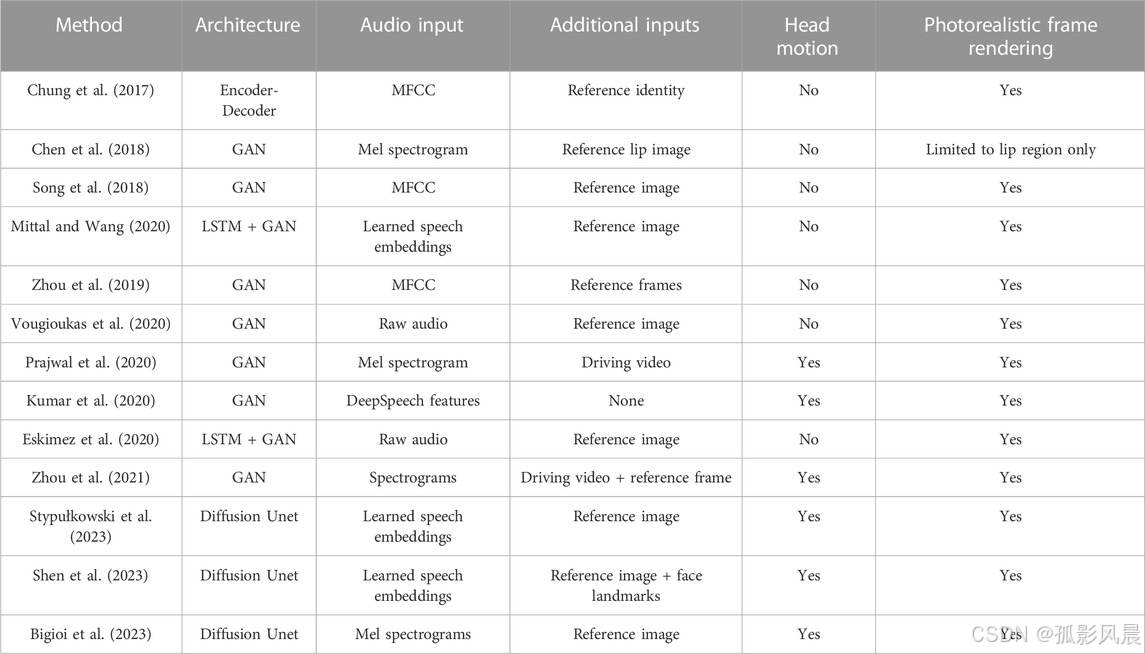

虽然最近不如基于结构的同类产品流行,但直接在输入音频信号下生成或修改视频的潜力是使端到端方法成为对谈话式首席研究人员有吸引力的关键因素之一。这些方法旨在使用一个统一的模型来学习音频、面部表情和嘴唇运动之间的复杂映射,该模型将说话头像生成的传统阶段结合到一个步骤中。这样,它们就不需要明确的中间表示,例如面部特征点或 3D 模型,这些表示可能计算成本高昂且容易出错。这种将音频输入直接连接到视频输出的能力简化了合成过程,并可以实现实时或近乎实时的生成。请参阅表 2了解文献中相关的基于端到端的方法的摘要。

表 2.表格总结了文献中一些最相关的端到端方法。

Chung 等人 (2017)提出了第一个端到端的 Talking Head Generation 技术之一。给定参考身份帧和驱动语音音频信号,他们成功地训练了基于编码器-解码器的架构来生成说话的头部视频,此外还展示了如何将他们的方法应用于配音问题。然而,他们的方法有限,因为它只生成面部周围的裁剪区域,丢弃了任何背景。

Chen et al. (2018)提出了一种基于 GAN 的方法,该方法从驱动语音源和参考唇框生成嘴唇运动。与上述方法类似,他们的方法仅限于生成嘴唇周围面部的裁剪区域。Song 等人 (2018)提出了一种更通用的基于 GAN 的说话头像生成方法,该方法还通过在他们的管线中引入递归单元来考虑帧之间的时间一致性,从而生成更流畅的视频。周 et al. (2019)提出了一个模型,该模型可以根据学习到的语音和视频的解纠缠表示生成视频。这种方法很有趣,因为它允许作者从参考身份框架生成说话的头部视频,并驱动语音信号或视频。Mittal 和 Wang (2020)将音频信号解开为各种因素,例如语音内容和情感语气,并根据这些表示而不是原始音频来调节 Talking Head 生成模型,展示了令人信服的结果。Vougioukas 等人 (2020)提出了一种使用基于 GAN 的方法从参考帧和音频生成时间一致的说话头视频的方法。他们的方法除了以端到端的方式同步嘴唇运动外,还可以生成逼真的眨眼。Prajwal 等人 (2020)引入了“口型同步判别器”,用于在说话的头部视频上生成更准确的嘴部运动,并提出了新的指标来评估生成视频的嘴部同步。Eskimez 等人 (2020)提出了一个基于 GAN 的稳健模型,可以从嘈杂的语音中生成说话的头部视频。Kumar 等人 (2020)提出了一种基于 GAN 的 one shot talking head 生成方法。周 et al. (2021)提出了一种有趣的方法来控制音频驱动的说话头的姿势。使用目标 “姿势” 视频和语音信号,他们使模型从单个参考身份图像生成说话的头部视频,该图像的姿势由目标视频决定。

虽然基于 GANGoodfellow 等人 (2014)诸如上述方法之类的方法近年来非常流行,该领域的从业者已经证明它们存在许多局限性。由于存在多重损失和判别器,它们的优化过程很复杂且非常不稳定。这可能会导致难以在生成器和判别器之间找到平衡,从而导致模式崩溃等问题,即生成器无法捕获目标分布的全部分集。梯度消失是另一个问题,当梯度在反向传播过程中变得太小时,就会发生这种情况,从而阻止模型有效学习,尤其是在更深的层中。这会显著减慢训练过程并限制模型的整体性能。考虑到这一点,我们想特别注意扩散模型 (Sohl-Dickstein 等人,2015 年,Ho et al., 2020,Dhariwal 和 Nichol,2021 年,Nichol 和 Dhariwal,2021 年),这是一类新的生成模型,由于在基于文本的图像生成、语音合成、着色、身体动画预测等无数任务中的出色表现,该模型在过去几年中获得了突出地位。

3.4 基于扩散的生成

由于基于扩散的方法最近得到广泛应用和普及,我们将用一小节来介绍它们。请注意,在本节中,我们描述了从端到端和基于结构的思想流派中找到的方法,因为此时只有少数基于扩散的 Talking Head 作品。

为了更深入地了解扩散架构,我们将读者引导至Sohl-Dickstein 等人 (2015); Ho 等人 (2020); Dhariwal 和 Nichol (2021); 尼科尔和达里瓦尔 (2021),因为这些是促成它们最近流行和广泛采用的开创性作品。然而,简而言之,扩散过程可以概括为由两个阶段组成:1) 正向扩散过程,以及 2) 反向扩散过程。

在正向扩散过程中,通过在每一步添加高斯噪声,所需的输出数据在一系列时间步长中逐渐“销毁”,直到数据成为标准高斯分布的另一个样本。相反,在反向扩散过程中,通过去除每个时间步的噪声来训练模型逐渐对数据进行去噪,损失通常计算为预测噪声与在该特定时间步长添加的实际噪声之间的距离函数。这两个阶段的结合使扩散模型能够对复杂的数据分布进行建模,而不会像 GAN 那样遭受模式崩溃,并且无需对抗性训练或复杂的损失函数即可生成高质量的样本。

在会说话的头像生成和视频编辑的背景下,有许多最近的工作已经探索了使用扩散模型。具体说来Stypułkowski 等人 (2023),Shen et al. (2023)和Bigioi 等人 (2023)率先探索它们用于端到端 Talking Head Generation 和音频驱动视频编辑的公司之一。这三种方法都遵循类似的基于自回归帧的方法,其中先前生成的帧与音频信号和参考标识帧一起反馈到模型中,以生成序列中的下一帧。特别是Shen et al. (2023)使用地标来调节他们的模型,并在潜在空间内执行训练以节省计算资源,这与Stypułkowski 等人 (2023)和Bigioi 等人 (2023).Stypułkowski 等人 (2023)方法可以被认为是一种真正的 Talking Head 生成方法,因为他们的方法不依赖于原始视频中的任何帧来指导他们的模型(初始种子/身份帧除外),并且他们得到的视频是完全合成的。Bigioi 等人 (2023)通过修改现有视频序列来执行视频编辑,方法是教他们的模型在视频的蒙面面部区域进行 Inpaint 以响应输入语音信号。Shen et al. (2023)的方法类似,他们通过使用旨在覆盖源视频面部区域的面罩来修改现有视频,从而执行视频编辑而不是说话头像生成。

虽然上述方法是目前唯一基于端到端扩散的方法,但最近几个月还提出了许多利用扩散模型的基于结构的方法。Zhang et al. (2022)提出了一种使用音频来预测特征点的方法,然后使用基于扩散的渲染器输出最终帧。Zhua 等人 (2023)还类似地利用了扩散模型,使用它来获取源图像和预测的运动特征作为输入,以生成高分辨率帧。Du 等人 (2023)引入了一种有趣的两阶段 Talking Head 生成方法。第一阶段包括在视频帧上训练扩散自动编码器,以提取帧的潜在表示。第二阶段涉及训练语音到潜在表示模型,其想法是语音预测的潜在内容可以由预训练的扩散自动编码器解码为图像帧。该方法取得了令人印象深刻的结果,优于该领域其他相关的基于结构的方法。Xu et al. (2023)使用以多模型输入为条件的基于扩散的渲染器来驱动生成的 Talking Head 视频的情感和姿势。值得注意的是,他们的方法也适用于换脸问题。

在会说话的头领域,扩散模型已经显示出非常有希望的结果,与更传统的基于 GAN 的方法相比,通常可以生成具有更高视觉质量的视频,以及相似的口型同步性能。然而,一个主要限制在于,由于它们的自回归性质,它们无法对长序列的帧进行建模,而不会使输出质量随着时间的推移而下降。看到该领域进一步研究的未来将是令人兴奋的。

3.5 其他方法

有些方法不一定适合上述子类别,但它们仍然相关且值得讨论。

基于 Viseme 的方法,例如周 et al. (2018)是驱动 3D 角色模型的早期方法。作者提出了一个基于 LSTM 的网络,该网络能够生成发音嘴型曲线,该曲线可以驱动基于 JALI 的角色模型,如下所示Edwards 等人 (2016)。Guo et al. (2021)是一种独特的说话头像生成方法,它不依赖于传统的中间结构表示(如地标或 3DMM),而是从音频中生成神经辐射场,使用音量渲染从中合成逼真的视频。

4 热门数据集和评估指标

在本节中,我们将介绍用于测量音频驱动的说话头像和自动配音模型生成的视频质量的最常用指标。

4.1 评估指标

定量评估 Talking Head 和 Dubbed 视频是一项非直接的任务。传统的感知指标(如 SSIM)或基于距离的指标(如 L2 Norm 或 PSNR)旨在量化两张图像之间的相似性,是不够的。此类指标未考虑视频的时间性质,视频质量不仅受帧的单个质量影响,还受视频中播放帧时帧的平滑度和同步性的影响。

尽管这些指标可能无法完美地评估视频质量,但它们对于基准标记目的仍然很重要,因为它们可以很好地指示模型的预期效果。因此,当可以访问 Ground Truth 样本以将模型的输出进行比较时,通常使用以下指标:

PSNR(峰值信噪比):计算地面实况和生成图像之间的峰值信噪比。PSNR 值越高,重建图像的质量越好。

面部动作装置 (中国)Ekman 和 Friesen (1978)识别:Song 等人 (2018)和Chen et al. (2020b)推广了一种使用五个面部动作单元根据真实样本评估重建图像的方法。

ACD (平均内容距离) (Tulyakov et al., 2018):使用Vougioukas 等人 (2020),可以计算生成的帧与真值图像之间的余弦 (ACD-C) 和欧几里得 (ACD-E) 距离。两个图像之间的距离越小,图像越相似。

SSIM (结构相似性指数) (Wang et al., 2004):这是一个指标,旨在通过查看图像中像素的亮度、对比度和结构来衡量两个图像之间的相似性。

地标距离度量 (LMD):提议者Chen et al. (2018),特征点距离 (LMD) 是用于评估合成视频的嘴部同步的常用指标。它的工作原理是使用现成的面部特征点提取器为生成的视频和真实视频的每一帧提取面部特征点嘴部坐标,计算它们之间的欧几里得距离,并根据视频长度和帧数进行标准化。

遗憾的是,在生成有声视频或配音视频时,通常无法使用上述指标,因为没有相应的真实数据来比较生成的样本。因此,已经提出了许多感知指标(试图模拟人类如何感知事物的指标)来解决这个问题。这些包括:

CPBD (累积概率模糊检测) (Narvekar 和 Karam,2011 年):这是一个基于感知的指标,用于检测图像模糊并测量图像清晰度。使用者Kumar 等人 (2020); Vougioukas 等人 (2020); Chung 等人 (2017)来评估他们的 Talking Head 视频。

WER(单词错误率):预训练的唇读模型用于预测生成的人脸所说的话。作品如Kumar 等人 (2020)和Vougioukas 等人 (2020)使用 LipNetAssael 等人(2016 年)模型,该模型在 GRID 数据集上进行了预训练,并实现了 95.2% 的唇读准确率。

基于 SyncNet 的指标:这些是基于 SyncNet 模型的感知指标,由Chung 和 Zisserman (2017b)评估不受约束的视频中的嘴唇同步。Prajwal 等人 (2020)引入了两个这样的指标:1) LSE-D,这是根据嘴唇和音频表示之间的距离计算的平均误差度量,以及 2) LSE-C,这是平均置信度分数。这些指标自推出以来就被证明很受欢迎,该领域最近的绝大多数论文都使用它们来评估他们的视频。

4.2 基准测试数据集

有许多基准数据集用于评估 Talking Head 和 Video Dubbing 模型。它们可以大致分为“在野”(自然的未被人为干预和处理)或“实验室条件”(人为处理过)风格的数据集。在本节中,我们列出了一些最受欢迎的,并简要描述了它们。

• VoxCeleb 1 和 2 (Nagrani 等人,2017 年; Chung et al., 2018):此数据集包含名人在野外讲话的音频和视频记录。它通常用于训练和评估说话头像生成、唇读和配音模型。前者包含来自 1251 位名人的超过 150000 条话语,后者包含来自 6112 位名人的超过 1000000 条话语。

• GRID (Cooke 等人,2006 年):GRID 数据集由 34 个说话人在实验室条件下阅读 1,000 个句子的音频和视频记录组成。它通常用于评估唇读算法,但也用于说话头像生成和视频配音模型。

• LRS3-TED (Afouras 等人,2018 年):该数据集包含超过 400 小时的 TED 演讲的音频和视频记录,这些演讲是各个领域专家的演讲。

• LRW (Chung 和 Zisserman,2017 年a):LRW(Lip Reading in the Wild)数据集由数百名不同的使用者在野外说出的 500 个不同单词的多达 1,000 个话语组成。

• CREMA-D (Cao et al., 2014):此数据集包含人们在各种情绪状态(快乐、悲伤、愤怒、恐惧、厌恶和中立)下说话的音频和视频记录。它总共包含 91 个不同演员的 7,442 个剪辑,在实验室条件下录制。

• TCD-TIMIT (Harte 和 Gillen,2015 年):都柏林圣三一学院会说话的人数据集 (TCD-TIMIT) 包含 62 名演员在受控环境中说话的视频记录。

• MEAD 数据集 (Wang et al., 2020):此数据集包含 60 名演员以三种不同强度级别(中性除外)以 8 种不同的情绪交谈的视频。这些视频以 7 个不同的角度同时录制,每个人录制了大约 40 小时的语音。

• RAVDESS 数据集 (Wang et al., 2020):瑞尔森情感言语和歌曲视听数据库是一个语料库,由 24 名演员组成,以平静、快乐、悲伤、愤怒、恐惧、惊讶和厌恶的表情说话,并以平静、快乐、悲伤、愤怒和恐惧的情绪唱歌。每个表情都是在两个层次的情绪强度上产生的,还有一个额外的中性表情。它总共包含 7,356 条录音。

• CelebV-HQ (Zhu et al., 2022):CelebV-HQ 是一个数据集,包含 35,666 个视频剪辑,涉及 15,653 个身份和 83 个手动标记的面部属性,涵盖外表、动作和情感等方面

5 挑战

尽管在说话头像生成和自动配音领域已经取得了重大进展,但这些研究领域在不断发展,仍然需要解决一些未解决的挑战,为未来的工作提供了大量机会。

5.1 恐怖谷效应

尽管已有研究,但生成真正逼真的会说话的头仍然是一个未解决的问题。在讨论现实主义的话题以及我们如何在视频配音中弥合“恐怖谷”效果时,有多种因素在起作用。这些包括:

- 视觉质量:逼真的会说话的头像视频应该具有高质量的视觉效果,能够准确捕捉场景的颜色、光照和纹理。这需要注意渲染过程中的细节。目前,大多数会说话的头像和视觉配音方法仅限于以低输出分辨率生成视频,而那些在更高分辨率下工作的方法在模型稳健性和泛化方面都非常有限(稍后会详细介绍)。这是由于以下几个原因:1) 在生成高分辨率视频时,深度学习模型的计算复杂性在训练时间和推理速度方面都显著上升;这反过来又会对实时性能产生不利影响;2) 生成逼真的说话头部视频需要模型捕捉面部表情、嘴唇运动和语音模式的复杂细节;随着视频输出分辨率的提高,对更精细细节的需求也会增加,这使得模型更难实现高度的真实感;3) 存储和带宽限制;高分辨率视频需要大量的这两点,从而限制了能够获得最新硬件系统的研究人员才能生成高分辨率。一些试图解决这个问题的方法包括Gao et al. (2023),Guo et al. (2021)和Shen et al. (2023),谁的方法能够输出高分辨率帧。

- 动作:逼真的说话头部/配音视频应具有逼真的动作,包括面部响应语音时流畅自然的动作,以及从头开始生成视频时逼真的头部运动。这是一个持续感兴趣的话题,许多作品都在探索它,例如Chen et al. (2020b),Wang et al. (2021)和最近的Zhang et al. (2023).

- 无实体声音:无实体声音现象的特点是说话者的声音与其外表之间存在不和谐的不匹配,这是电影配音中经常遇到的问题。尽管它很重要,但在 Talking Head 文献领域中,这个问题仍然相对未得到探索,因此为研究人员进一步研究提供了一条有希望的途径。开展的工作Oh et al. (2019 年)证明了说话者的声音和他们的外表之间存在着可以学习的内在联系,从而为配音工作应该优先考虑声音和外表的同步的观点提供了可信度。

- 情感:逼真的视频应该唤起逼真的情感,包括面部表情、肢体语言和对话。要实现逼真的情感,需要仔细注意表演和表演,以及注意动画和声音设计中的细节。最近试图将情感融入他们生成的对话头像的作品包括马等人 (2023),Liang 等人 (2022),Li et al. (2021).

5.2 数据问题:单说话人与多说话人方法

如前所述,视频配音有两种主要方法 - 结构化和端到端。为了训练模型以使用当前的端到端方法生成高度逼真的说话头像视频,需要数十小时的单说话人视听内容。内容应具有高质量,包括良好的照明、一致的面部取景和清晰的音频数据等因素。当在多说话人数据集上训练方法时,单个说话人的数据量可能会减少,但足够大的数据集才刚刚开始可用。此时,无法估计端到端方法对多个说话人的推广效果如何,也无法估计最终可能需要多少数据来微调电影中单个演员的配音模型,以实现对他们面部动作的真实模拟。目标应该是几十分钟的数据量级,或者更短,以便对大多数具有台词角色的角色进行配音。

5.3 泛化和稳健性

开发一个可以在任何条件下(如光线不足、部分遮挡或取景不正确)泛化所有人脸和音频的模型,仍然是一项尚未完全解决的挑战性任务。

虽然监督式学习已被证明是训练模型的强大方法,但它通常需要大量代表目标分布的标记数据。然而,收集涵盖面部外观和状况的所有可能场景和变化的多样化和平衡的数据集是一项具有挑战性且耗时的任务。此外,很难预测模型在推理过程中可能遇到的所有可能的变化,例如照明条件或面部表情的变化。

为了应对这些挑战,研究人员探索了替代方法,例如自监督学习,旨在通过从数据本身创建监督信号来从未标记的数据中学习。换句话说,对数据进行自我标记。诸如Baevski 等人 (2020); Hsu 等人 (2021)属于自我监督学习范式,由于其在提高模型的鲁棒性和泛化性方面取得的可喜成果,因此在语音相关领域广受欢迎。这些方法可能有助于克服传统监督学习方法的局限性,这些方法仅依赖标记数据进行训练。话虽如此,Radford 等人 (2022)表明,虽然这些方法可以学习它们正在训练的输入的高质量表示,但“它们缺乏将这些表示映射到可用输出的等效性能的解码器,因此需要一个微调阶段才能实际执行语音识别等任务”。作者证明,通过在 680,000 小时语音的 “弱监督 ”数据集上训练他们的模型,他们的模型在看不见的数据集上表现良好,而无需微调。这对于有声头生成/配音意味着,在大量 “弱监督” 或换句话说,不完美数据上训练的模型可能会获得更高级别的泛化。这对于诸如说话头像生成或配音之类的任务特别有价值,因为系统需要理解和复制标记数据中可能未明确存在的各种语音模式、口音和语言细微差别。

5.4 多语言方面

在说话头生成领域,观察仅在英语数据集上训练的模型的适应性是令人着迷的,当面对它们在训练过程中没有遇到的语言的语音时。这种现象可以归因于模型在学习通用声学和语言特征方面的熟练程度。虽然语言多样性涉及广泛的语音、韵律和句法复杂性,但存在跨越语言界限的共同特征的基础。这些基本方面是人类语言固有的,包括语音结构和韵律模式等元素,它们在语言中表现出共性。擅长捕捉这些通用属性的 Talking head 生成模型本身就具有生成与一系列语言表达一致的嘴唇运动的能力,而与语言无关。

虽然在英语数据集上训练的模型生成的嘴唇运动在应用于看不见的语言时可能会表现出相当程度的保真度,但捕捉与这些语言相关的文化行为是一项更复杂的工作。文化手势、表情和头部运动通常与语言及其微妙的复杂性有着密切的联系。不幸的是,尽管这些模型在语言上具有适应性,但可能缺乏准确捕捉这些文化特定行为所需的曝光。例如,在某些文化中,表明共识的独特头部运动等行为仍然是这些模型面临的挑战。这强调了语言和文化之间的联系,突出了模型不仅需要破译语言成分,还需要欣赏和模拟伴随它们的文化细微差别。因此,我们认为有必要进行进一步的研究,以确保在说话头像生成和自动配音领域中语言和文化维度的统一表示,这将留给该领域一个公开的挑战。

5.5 道德和法律挑战

最后,我们提到,对原始数字媒体内容的修改需要考虑广泛的道德和数据保护考虑。虽然对于大多数数字内容来说,付费演员的工作被视为 “雇佣工作”,但如果自动配音技术得到广泛采用,则还有更广泛的考虑。就在我们写这篇文章的时候,好莱坞正在发生大规模的演员罢工,为使用 AI 生成的表演序列争取权利。随着当今的 AI 技术成熟为数字内容创作的复杂最终产品,对产生的广泛的道德和知识产权影响进行全面讨论,需要另一篇文章。

归根结底,数字媒体创作行业显然需要高级 IP 权利管理。过去的工作主要集中在媒体纵上,例如指纹识别或加密 (Kundur 和 Karthik,2004 年),但最终没有成功。最近,研究人员提出了区块链等技术可能用于字幕 (Orero 和 Torner,2023 年),而法律研究人员在元宇宙发展的背景下为数字版权的挑战提供了更广泛的背景 (Jain 和 Srivastava,2022 年).显然,多语言视频配音只是这一更广泛的道德和监管挑战的一个特定子背景。

考虑到多语言视频配音这一重点主题的道德考虑,一种实用的方法是采用一种可以跟踪管线使用情况的方法。文献中采用的一种技术是将可追溯性构建到管线本身中,如Pataranutaporn 等人 (2021).这些作者已将人工和机器可追溯性方法纳入他们的流程中,以确保安全和合乎道德地使用。他们的人类可追溯性技术受到来自其他媒体范式(例如文本、视频)的制造检测技术的启发,并将可感知的痕迹(如作者签名、可区分的外观或小的编辑伪影)整合到生成的媒体中。另一方面,机器可追溯性涉及合并人类无法察觉的痕迹,例如不可见的噪声信号。

6 结束语

在本文中,我们试图捕捉自动化、多语言视频配音的当前最新技术。这是一个新兴的研究领域,由视频流行业的需求驱动,并且可能与一系列神经技术产生有趣的协同作用,包括自动翻译服务、文本到语音合成和说话头生成器。除了对最近的文献进行回顾和讨论外,我们还概述了将当今的神经技术融入未来数字媒体服务的实际实施中仍然存在的一些关键挑战。

这项工作既可以作为刚接触自动配音和说话头像生成领域的研究人员的介绍和参考指南,但也试图引起人们对最新技术和新方法和方法的关注,以便那些已经对该领域有一定了解的人。我们希望它能鼓励和激发关于这一新兴研究主题的新研究和创新。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?