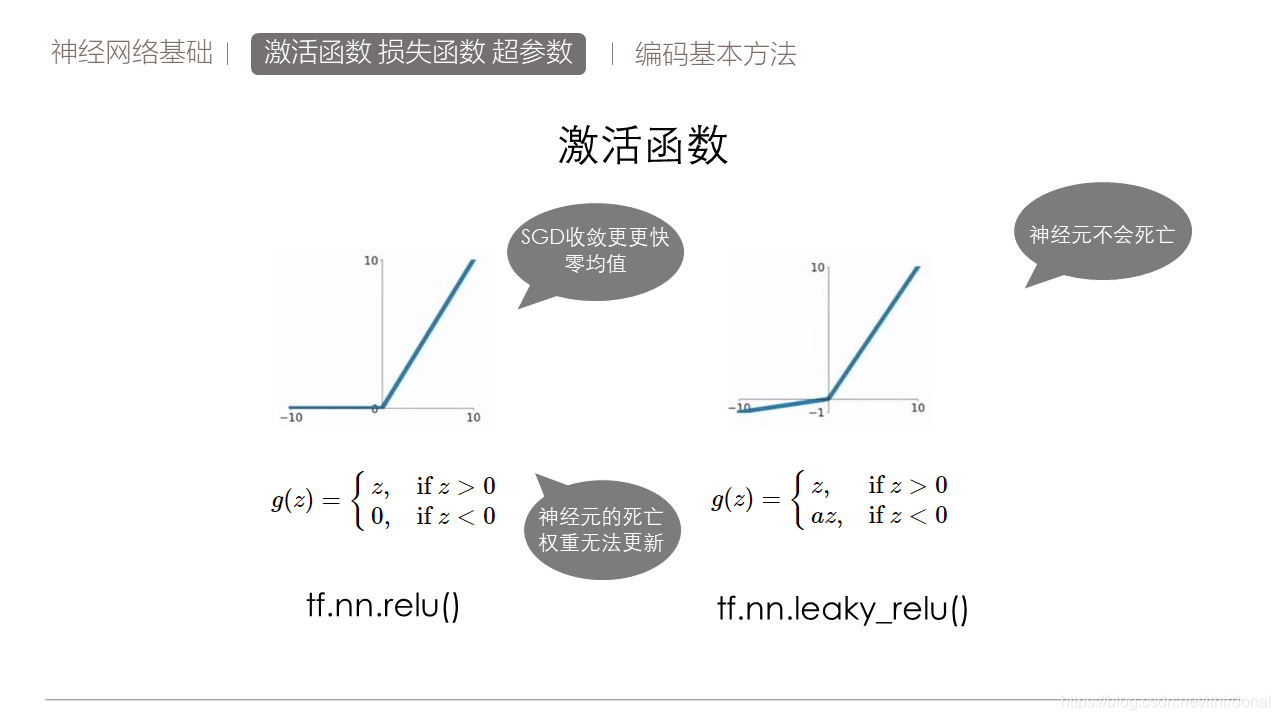

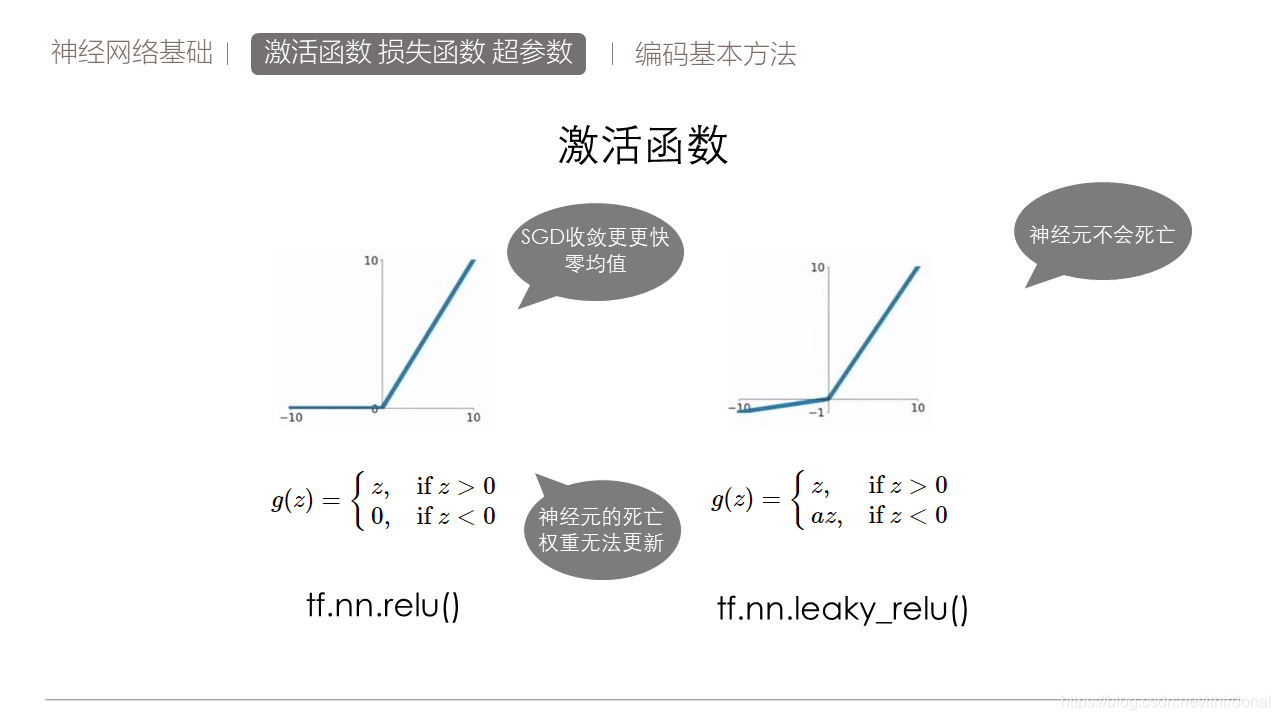

一般隐层选择LeakRelu,可以取得较为理想的效果。

如果使用ReLU学习率不要设置太高,防止神经元死亡。

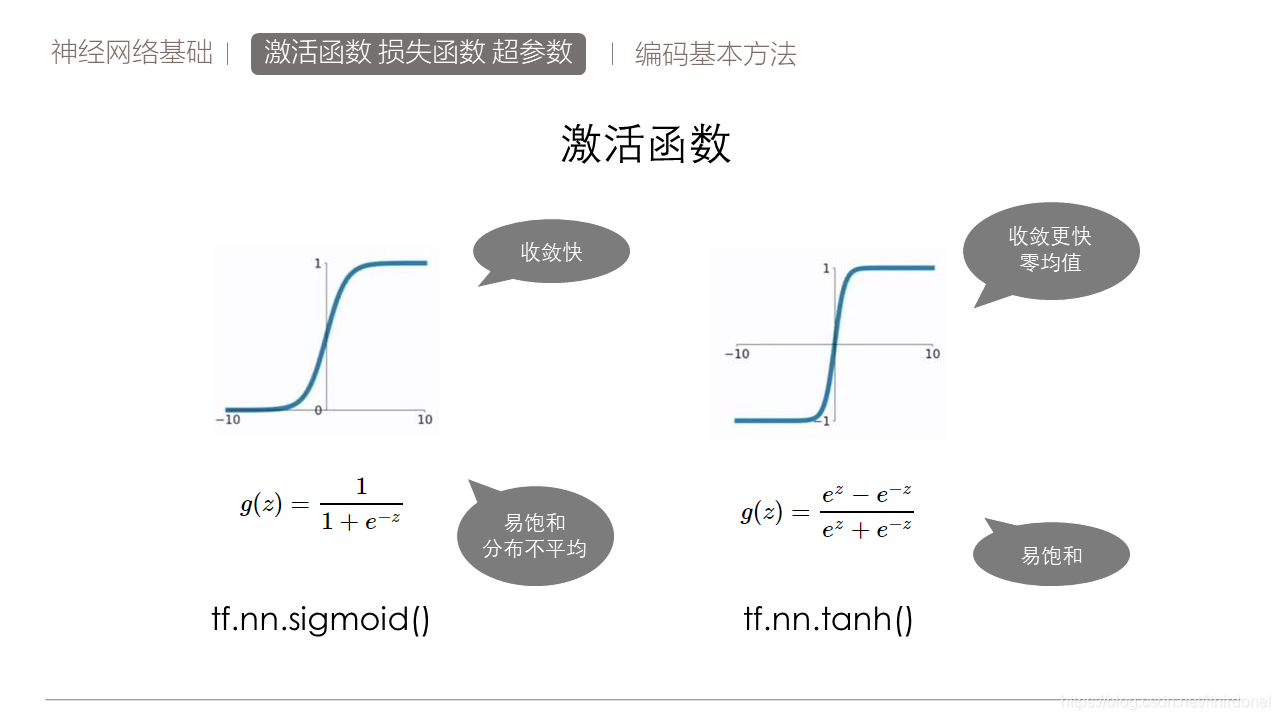

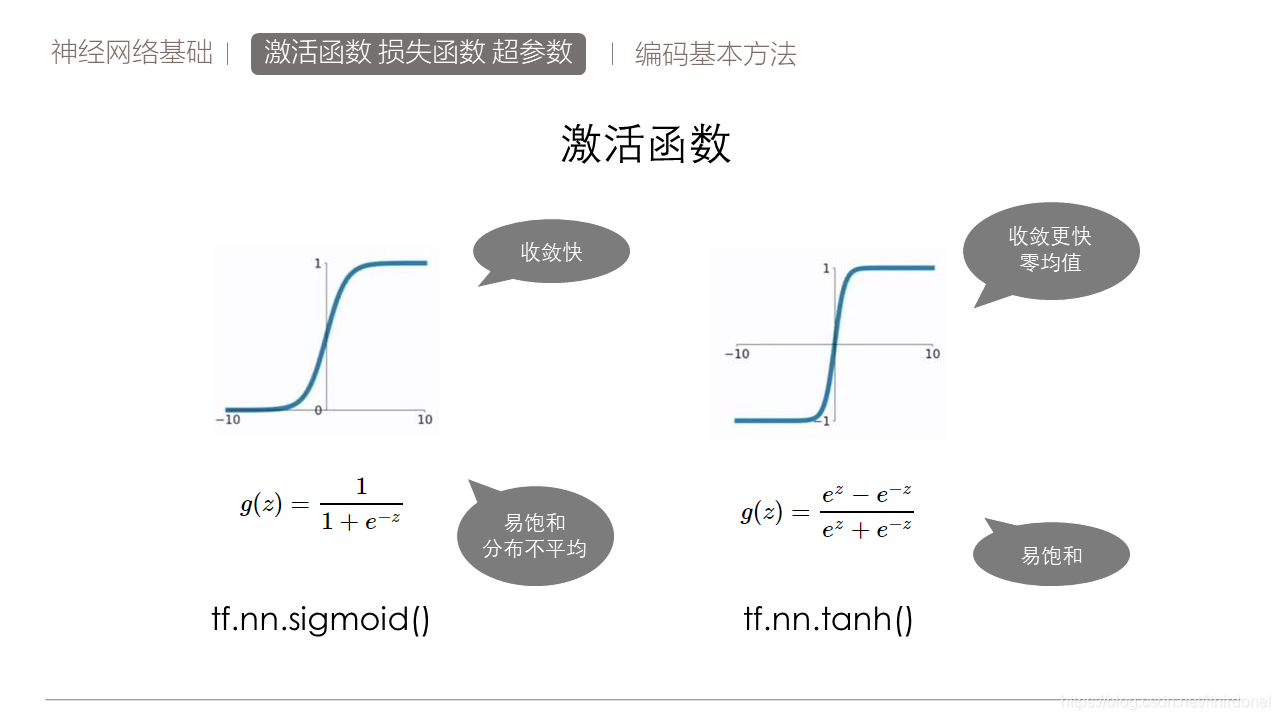

使用sigmiod函数时不要用在太多的隐层上,也可以替换成tanh看看效果。

一般隐层选择LeakRelu,可以取得较为理想的效果。

如果使用ReLU学习率不要设置太高,防止神经元死亡。

使用sigmiod函数时不要用在太多的隐层上,也可以替换成tanh看看效果。

2万+

2万+

3563

3563

1562

1562

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?