前言

前文概述了Agent开发定义和一些基本概念,本文目的是概述目前Agent开发的一些关键论文和思想。

| 年份 | 标题 |

|---|---|

| 2022 | ReAct: Synergizing Reasoning and Acting in Language Models |

| 2023 | ReWOO: Decoupling Reasoning from Observations for Efficient Augmented Language Models |

| 2023 | Reflexion: Language Agents with Verbal Reinforcement Learning |

| 2023 | REST MEETS REACT: SELF-IMPROVEMENT FOR MULTI-STEP REASONING LLM AGENT |

| 2024 | Self-Reflection in LLM Agents: Effects on Problem-Solving Performance |

| 2024 | An LLM Compiler for Parallel Function Calling |

研究进展

ReAct:推理 + 动作结合

论文标题:ReAct: Synergizing Reasoning and Acting in Language Models

作者:Shinn et al., 2022

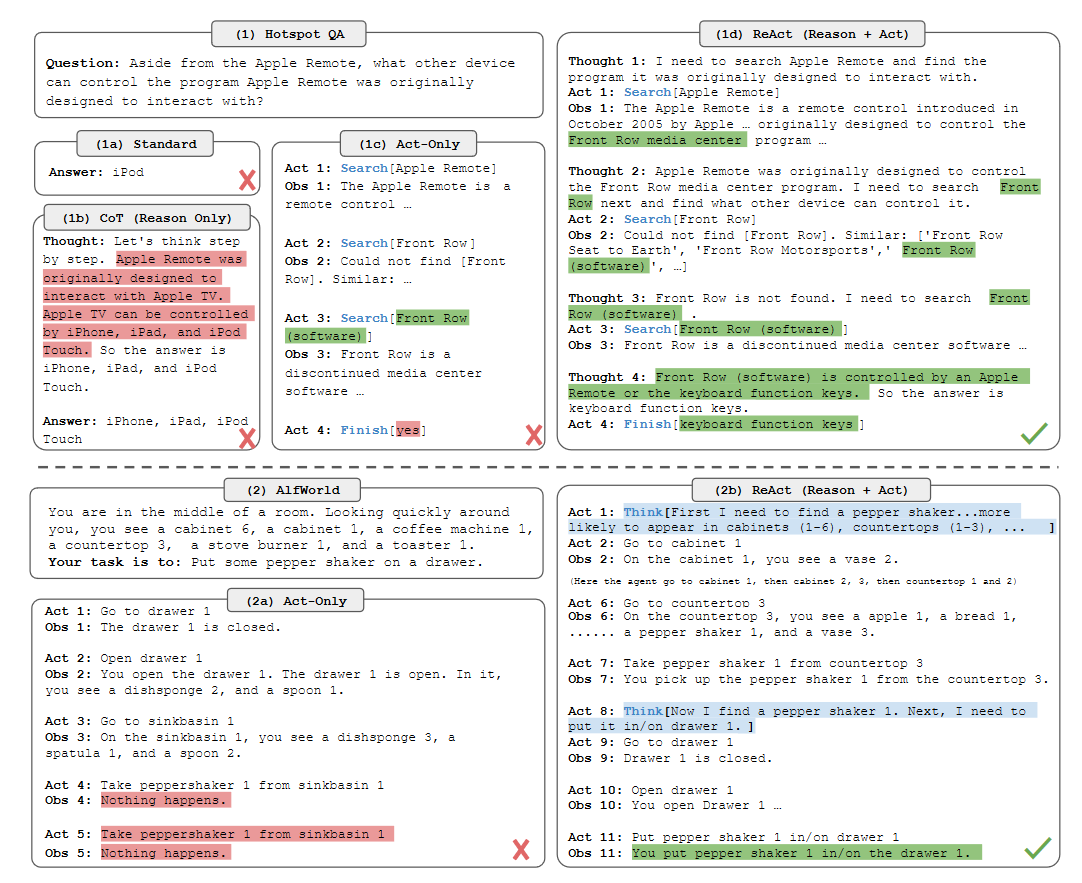

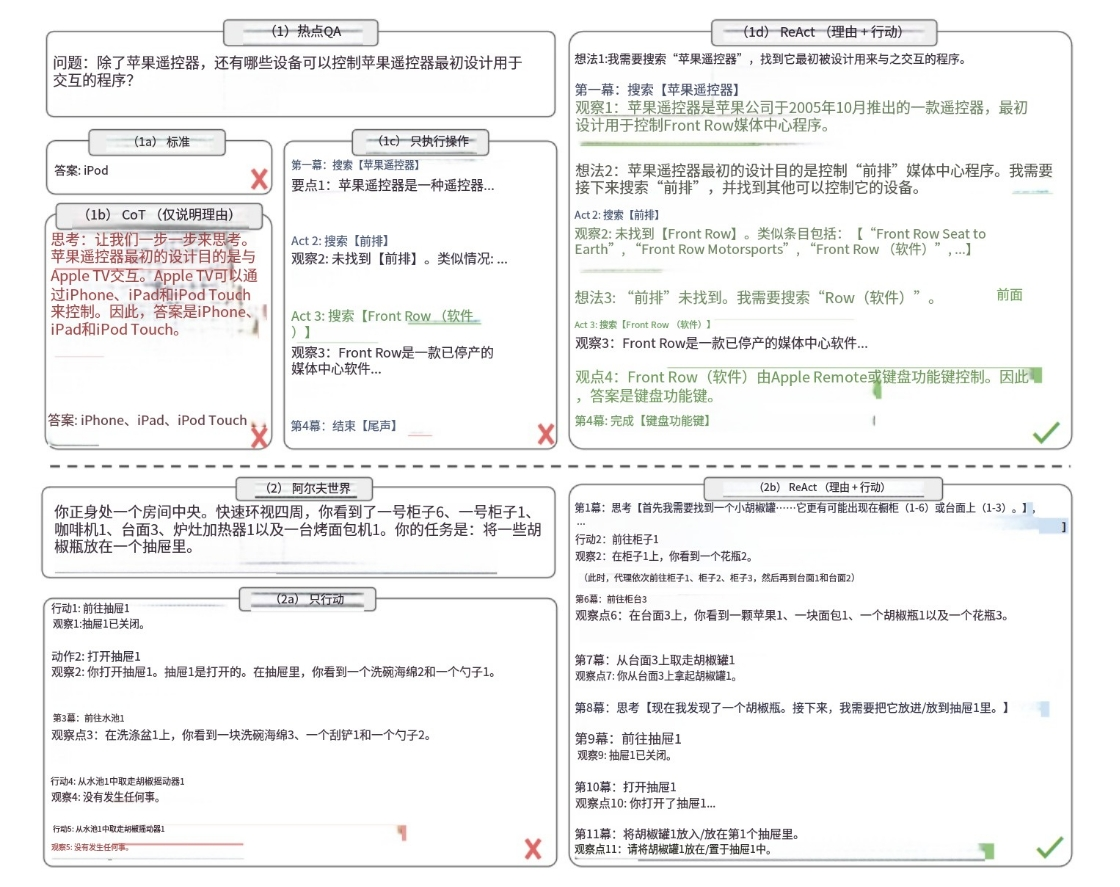

- 核心贡献:将“Chain-of-Thought”推理与动作(工具调用)结合。

- 场景:开放问答、Web搜索、Wikipedia浏览等。

- 适用:知识密集型问答、需要多步交互和决策、工具链式依赖

- 架构:Thought-Action-Observation 循环,支持工具使用。

- Thought:LLM 在输出时“自言自语”,写下自己当前的推理过程。

- Action: LLM 根据思考决定调用某个工具或执行动作。

- Observation:工具执行后返回结果,作为下一步推理的输入。

- 优点:

- 支持多步推理与交互,动态适应性极强,能够根据实时的环境观察灵活调整其行动计划,有效应对不确定性和突发情况。

- 其显式的推理轨迹使得整个决策过程高度可解释,这不仅便于开发者进行调试,也增强了用户对Agent的信任度。

- 缺点:

- 每次工具调用都需要进行一次LLM推理,导致执行速度相对较慢,并会产生高昂的Token消耗。

- 由于其每次只规划下一步,可能导致Agent陷入局部最优解,而无法找到全局最优的行动路径。

- 长链调用中可能会陷入反复调用和幻觉中。

下图展示了两个领域(问答、游戏)的回复方式(直接回复、仅推理、仅调用工具、推理+调用工具)的对比

ReWOO:推理过程与工具调用解耦

论文标题:ReWOO: Decoupling Reasoning from Observations for Efficient Augmented Language Models

作者:Xu B, Peng Z, Lei B, et al. 2023

- 核心贡献: ReAct 每一步都需要 Observation 不同,ReWOO 先让 LLM 生成一个完整的推理/

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2492

2492

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?