我们在随机爬取某个网站的时候,比如对网站发出成千上万次的请求,如果

user-agent都是一样的,就很容易被服务器识别出你是一个爬虫。因此在发送请求多了之后我们就要随机更换我们的user-agent,使服务器不那么容易去识别。那么如何在scrapy框架中如何随机更换请求头呢?

事先声明:在阅读本文之前,要对python爬虫和scrapy框架有一定的了解!!!

-

用以下三条命令在cmd中执行,建立名为

downloadmiddleware的scrapy框架,里面包含一个名为httpbin的Spider:

scrapy startproject downloadmiddleware

cd downloadmiddleware

scrapy genspider httpbin httpbin.org -

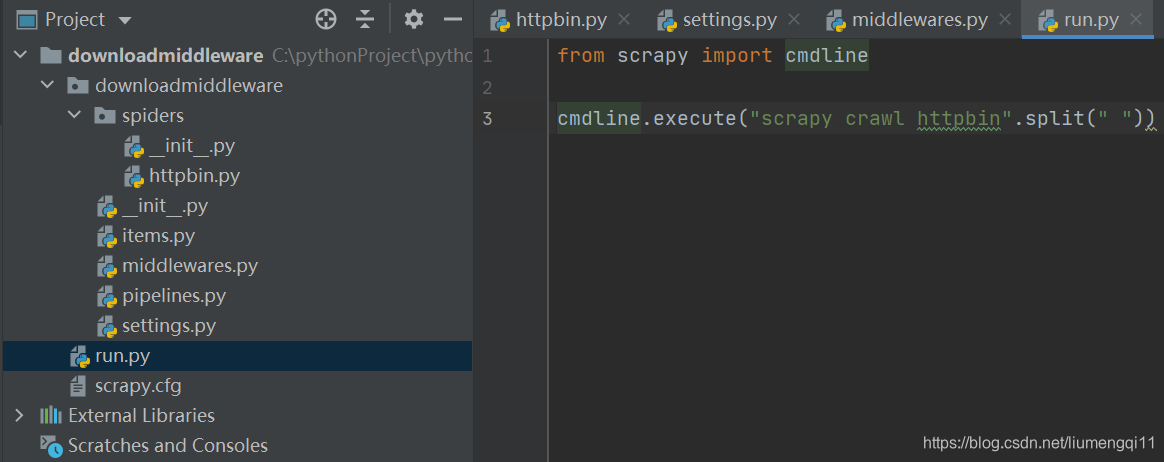

用pycharm打开此文件,可看到文件的框架如图片左侧(这里我又建立一个run.py文件,代码如图片右侧,方便整个框架的运行):

-

httbbin.py中的代码如下:

import scrapy class HttpbinSpider(scrapy

本文介绍了在使用Scrapy爬虫时,为避免被服务器识别为爬虫,如何随机更换请求头的方法。通过修改中间件、设置headers字典,实现在每个请求时生成不同的请求头,从而提高爬虫的匿名性。此外,还提到结合使用ip代理池可以进一步增强反爬效果。

本文介绍了在使用Scrapy爬虫时,为避免被服务器识别为爬虫,如何随机更换请求头的方法。通过修改中间件、设置headers字典,实现在每个请求时生成不同的请求头,从而提高爬虫的匿名性。此外,还提到结合使用ip代理池可以进一步增强反爬效果。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2140

2140

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?