(转)有关Auto encoder 和Denoising auto encoder分别和PCA之间的关系(学习笔记)

鉴于这几天心情大好,于是我决定在挖一个大坑,讲一讲Auto encoder和PCA的关系以及 Denoising auto encoder 和PCA的关系(流形学习角度),今天这一篇作为这个大坑的第一步,我打算讲讲有关Auto encoder的基础概念,基本上讲有关DL的博客都有说的什么深度结构的优势什么的,我这就不多说了,接下来直接进入正题,按照惯例,先上个图:

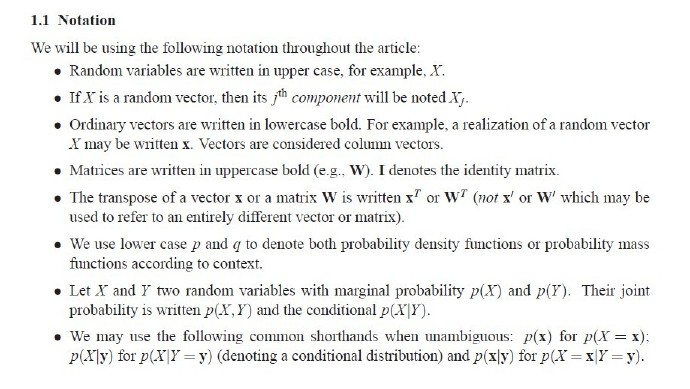

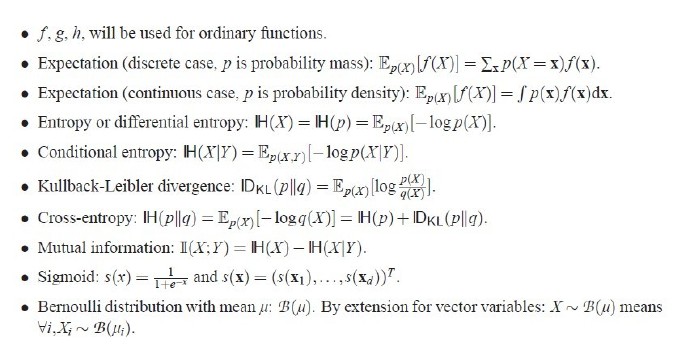

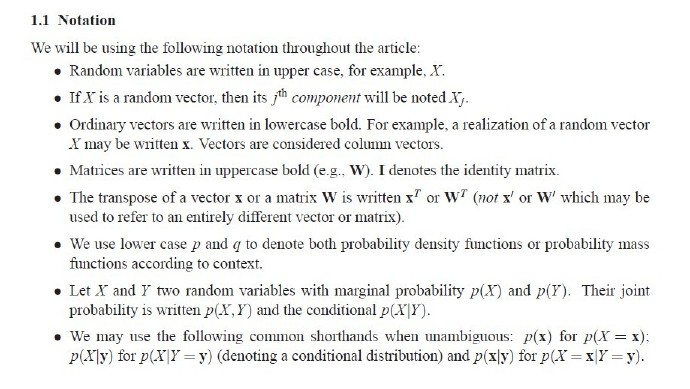

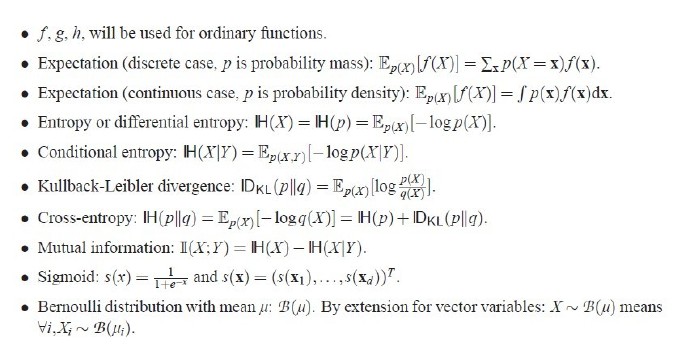

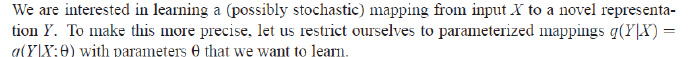

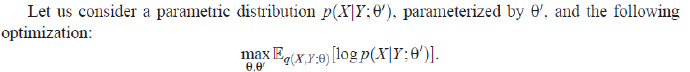

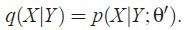

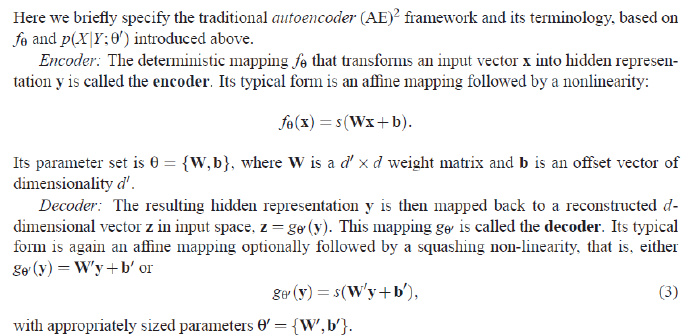

这些都是我们接下来会用到的符号,请各位看官看仔细了,既然讲到Auto encoder,那就不得不提到表示(representation)这个词了,我们的auto encoder所要达到的目标就是找到输入的一个新的高级表示,假设输入层的维数比隐藏层低则称我们获得的表示是over-complete representation,反之则是under-complete representation, 当然,获得的表示是有质量差别的,我们不能照单全收,所以我们需要一个标准来确定什么是一个好的表示,一个好的表示最低限度的要求是最大限度的保有输入所带有的“信息”(这里联系到信息论了),然后在这之上的就是是否可以使得分类的效果提升等的要求,当然了,如果把这些要求全讲出来会使得这个文章变得相当的混乱,当然,我们时常提到的稀疏性也是好的表示的标准之一。

(这次结构有点乱,下次会好的,各位看官见谅)。

这些都是我们接下来会用到的符号,请各位看官看仔细了,既然讲到Auto encoder,那就不得不提到表示(representation)这个词了,我们的auto encoder所要达到的目标就是找到输入的一个新的高级表示,假设输入层的维数比隐藏层低则称我们获得的表示是over-complete representation,反之则是under-complete representation, 当然,获得的表示是有质量差别的,我们不能照单全收,所以我们需要一个标准来确定什么是一个好的表示,一个好的表示最低限度的要求是最大限度的保有输入所带有的“信息”(这里联系到信息论了),然后在这之上的就是是否可以使得分类的效果提升等的要求,当然了,如果把这些要求全讲出来会使得这个文章变得相当的混乱,当然,我们时常提到的稀疏性也是好的表示的标准之一。

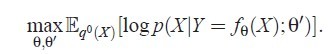

好了,接下来开始推导了,各位看官可看仔细了。

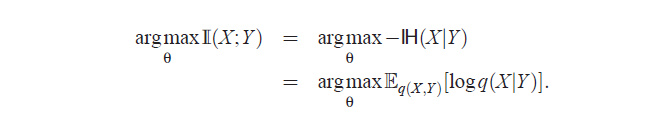

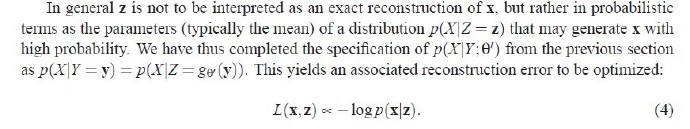

刚刚我说了一个好的表示最低限度的要求是最大限度的保有输入所带有的信息,那好,感性的认识各位看官应该都有了,但是如果要变成实际的式子要如何表示呢?,我估计有人应该看出来了,对,就是互信息!,那为什么是使用互信息表示呢?因为其实互信息表示的其实就是两个随机事件的相关性的度量,互信息的式子如下

的值会比随机变量X的熵要低,因为闷热和下雨是有相关性的,从而在给定Y(闷热)的条件下,X(下雨)的不确定减少了,而互信息就是由随机变量X的熵减去随机变量X给定Y的条件熵,我想接下来我应该不用解释了,各位看官应该明白了。

好,终于绕回来了,作为一位语文老师死得早的娃来说,我又让我语文老师黄泉之下泪奔三千里了,好了,既然互信息是相关性的度量,那我们的任务就应该是最大化互信息,使得输入层和隐层的相关性最大,从而获得好的表示,如下式所示:

(这次结构有点乱,下次会好的,各位看官见谅)。

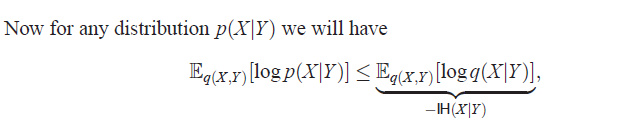

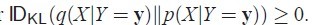

好了,关键的一部来了,见下图:

http://blog.sina.com.cn/s/blog_b0086f8c0101f976.html

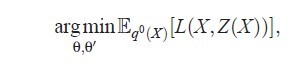

本文深入探讨了自动编码器(Autoencoder, AE)与主成分分析(PCA)之间的内在联系,详细介绍了AE如何通过减少重构误差来提升输入与隐藏层间的互信息下界,进而学习到高质量的数据表示。

本文深入探讨了自动编码器(Autoencoder, AE)与主成分分析(PCA)之间的内在联系,详细介绍了AE如何通过减少重构误差来提升输入与隐藏层间的互信息下界,进而学习到高质量的数据表示。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?