正文共1216个字 2张图,预计阅读时间5分钟。

今年年初的时候,Szegedy写了GoogLeNet的第三篇续作,如下:

[v4] Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning,top5 error 3.08%

Szegedy读了此论文后,蹦出了结合GoogLeNet与Residual Connections的奇思妙想,于是就有了上面那篇论文,主要贡献如下:

1、在Inception v3的基础上发明了Inception v4,v4比v3更加复杂,复杂到不可思议

2、结合ResNet与GoogLeNet,发明了Inception-ResNet-v1、Inception-ResNet-v2,其中Inception-ResNet-v2效果非常好,但相比ResNet,Inception-ResNet-v2的复杂度非常惊人,跟Inception v4差不多

3、加入了Residual Connections以后,网络的训练速度加快了

4、在网络复杂度相近的情况下,Inception-ResNet-v2略优于Inception-v4

5、Residual Connections貌似只能加速网络收敛,真正提高网络精度的是“更大的网络规模”

以上就是Inception v4论文的主要贡献了,没有什么创新,只是在前人的基础上修修补补、移花接木,但这篇文章工作量不小,需要花费大量时间训练作者提出的3种网络。

附上作者提出网络结构图,具体细节就不介绍了,因为没有任何原创性创新。以下是Inception v4的结构图:

Inception v4

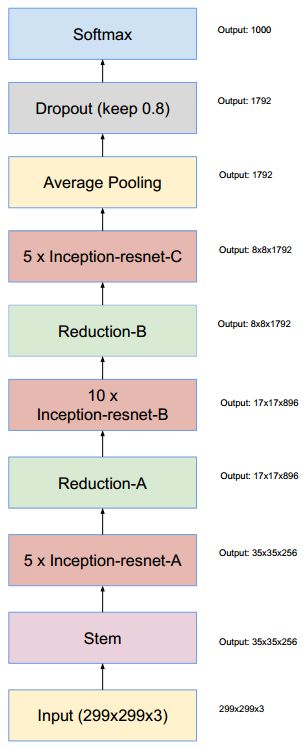

以下是Inception-ResNet的结构图:

Inception-ResNet

至此,GoogLeNet四篇相关论文就介绍完了,纵观GoogLeNet的发展历程,Szegedy为我们提供了许多可以借鉴的网络设计方法,比如Inception结构、非对称卷积、Batch Normalization、取消全连层……等等。就连Szegedy本人,也汲取了ResNet的精髓,合体两种网络设计出了Inception-ResNet。所以多读论文,多学习别人的idea,是非常重要的。

值得注意的是,Szegedy在Inception-v4论文中提出了这样一句话:

Although the residual version converges faster, the final accuracy seems to mainly depend on the model size.

或许是Szegedy玩儿了这么久GoogLeNet,终于参透了深度学习的精髓,即要想网络更牛逼,就得设计更复杂的网络,而网络能否做到更复杂的关键在于人类计算能力强弱。计算能力的提升是一个漫长的过程,任重道远。

想想生物进化几十亿年的历史,人工智能还差得远呢!

原文链接:https://www.jianshu.com/p/e0464e8d6db4

查阅更为简洁方便的分类文章以及最新的课程、产品信息,请移步至全新呈现的“LeadAI学院官网”:

www.leadai.org

请关注人工智能LeadAI公众号,查看更多专业文章

大家都在看

3081

3081

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?