1、CUDA线程模型

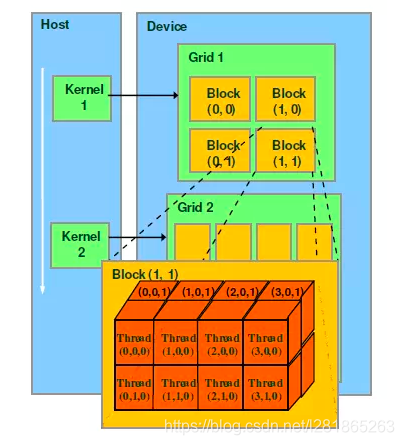

Grid/Block/Thread之间的关系,如下图所示。

Kernel:在GPU上执行的核心程序,这个kernel函数是运行在某个Grid上的。

2、核函数原型

核函数只能在主机端调用,调用时必须申明执行参数。调用形式如下:

Kernel<<<Dg,Db, Ns, S>>>(param list);

<<<>>>运算符内是核函数的执行参数,告诉编译器运行时如何启动核函数,用于说明内核函数中的线程数量,以及线程是如何组织的。

<<<>>>运算符对kernel函数完整的执行配置参数形式是<<<Dg, Db, Ns, S>>>

- 参数Dg用于定义整个grid的维度和尺寸,即一个grid有多少个block。对应核函数内部实参gridDim,为dim3类型。Dim3 Dg(Dg.x, Dg.y, 1)表示grid中每行有Dg.x个block,每列有Dg.y个block,第三维恒为1(因为如上图Block组织形式最多支持2维,而Thread最多3维)。整个grid中共有Dg.x*Dg.y个block,其中Dg.x和Dg.y最大值为65535。

- 参数Db用于定义一个block的维度和尺寸,即一个block有多少个thread。对应核函数内部实参blockDim,为dim3类型。Dim3 Db(Db.x, Db.y, Db.z)表示整个block中每行有Db.x个thread,每列有D

本文介绍了CUDA线程模型,包括Kernel、Grid、Block和Thread的关系。重点解析了CUDA核函数的执行参数,如GridDim、BlockDim以及它们在定义线程数量和组织方式上的作用。同时提到了内核函数中的可选参数Ns(动态分配的shared Memory大小)和S(CUDA流)。

本文介绍了CUDA线程模型,包括Kernel、Grid、Block和Thread的关系。重点解析了CUDA核函数的执行参数,如GridDim、BlockDim以及它们在定义线程数量和组织方式上的作用。同时提到了内核函数中的可选参数Ns(动态分配的shared Memory大小)和S(CUDA流)。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?