20210621

https://zhuanlan.zhihu.com/p/71553871

Deep Biaffine Attention for Dependency Parsing

https://blog.youkuaiyun.com/sinat_34072381/article/details/106864586

【论文解读】Deep Biaffine Attention for Neural Dependency Parsing(基于深层双仿射注意力的神经网络依存解析)

https://blog.youkuaiyun.com/ld326/article/details/114325742

[论文阅读笔记27]biaffine4NER:双仿射分类器在NER的应用

https://zhuanlan.zhihu.com/p/369851456

实体识别之Biaffine双仿射注意力机制

https://blog.youkuaiyun.com/QFire/article/details/105973697

Deep Biaffine Attention for Neural Dependency Parsing

https://blog.youkuaiyun.com/qq_27590277/article/details/106263268 原始论文

【一分钟论文】Deep Biaffine Attention for Neural Dependency Parsing

https://blog.youkuaiyun.com/li_jiaoyang/article/details/113975711 重点

【论文阅读】Entity Structure Within and Throughout: Modeling Mention Dependencies for Document-Level Relation

https://zhuanlan.zhihu.com/p/353183322

[KG笔记]八、文档级(Document Level)关系抽取任务

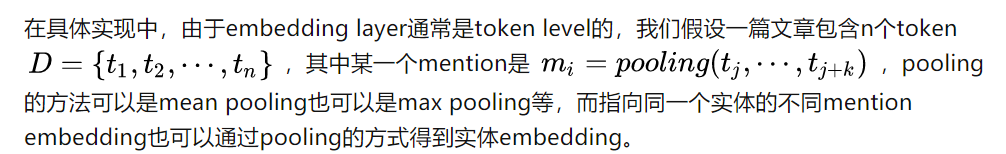

共指id嵌入一样

但是实体嵌入的时候 可能是不同的表述 所以取上述的方式

双仿射注意力

https://blog.youkuaiyun.com/qq_27590277/article/details/106263268

【一分钟论文】Deep Biaffine Attention for Neural Dependency Parsing

看不懂 需要补依存句法分析

https://blog.youkuaiyun.com/ld326/article/details/114325742

[论文阅读笔记27]biaffine4NER:双仿射分类器在NER的应用

https://zhuanlan.zhihu.com/p/369851456

本文主要是复现论文《Named Entity Recognition as Dependency Parsing》

重点

https://blog.youkuaiyun.com/sinat_33741547/article/details/79258045

依存分析

重点名词详细

https://www.zhihu.com/question/20666664

如何通俗地讲解「仿射变换」这个概念? 重点

http://lanqi.org/skills/10593/

仿射变换(一)—什么是仿射变换

https://blog.youkuaiyun.com/lyyiangang/article/details/115589333

仿射变换 重点

20210610

https://blog.youkuaiyun.com/sdu_hao/article/details/105314218

20210422

bert处理长文本

cogLTX

https://baijiahao.baidu.com/s?id=1685494944201487215&wfr=spider&for=pc

实战中,BERT如何处理篇章级长文本?

https://zhuanlan.zhihu.com/p/88944564

一种解决bert长文本匹配的方法

https://blog.youkuaiyun.com/u014400239/article/details/102925139

Bert 如何解决长文本问题?

https://www.zhihu.com/question/327450789

transformer-xl

https://github.com/kimiyoung/transformer-xl

Transformer-XL介绍

https://zhuanlan.zhihu.com/p/84159401

Transformer-XL

https://www.pianshen.com/article/23591233760/

20210124

learning to rank

lambdarank

lightgbm用于排序 重点

https://github.com/jiangnanboy/learning_to_rank

https://www.cnblogs.com/little-horse/p/11237099.html

lightGBM用于排序(Learning to Rank )

https://blog.youkuaiyun.com/demm868/article/details/103485658

https://blog.youkuaiyun.com/kyle1314608/article/details/113372359

NDCG Normalized discounted cumulative gain 理解分析

https://blog.youkuaiyun.com/xiangyong58/article/details/51166127

信息检索中的度量指标全解析 重点

https://blog.youkuaiyun.com/u011984148/article/details/108030794

20201107

https://blog.youkuaiyun.com/jiaowoshouzi/article/details/89073944

NLP发展史以及BERT 详解

20200819

https://mp.weixin.qq.com/s/ao1IXkwjphSvBm7VqsLVlg

20200803

人工智能大势 39期

深度学习习惯走捷径

山西标注

https://baijiahao.baidu.com/s?id=1675138249177788882&wfr=spider&for=pc

3、人工智能可以阻止基于物联网的DDoS攻击

http://www.techweb.com.cn/ucweb/news/id/2800439

https://mp.weixin.qq.com/s?__biz=MzA5ODEzMjIyMA==&mid=2247516873&idx=2&sn=5934c2023a809f5b244d47bcbf6e088f&chksm=90948b5aa7e3024cc0323688f481f4df50bd0ecb4a7eb0f321ac377958b2aac7fb8b85c54f7f&mpshare=1&scene=1&srcid=0803ddkAUs7wJqocLcUAgBYi&sharer_sharetime=1596415851933&sharer_shareid=ad938198e7c1453de3019f515c855c6a&key=88a35ed49a1211f58e67439c0403a7439dd2bcde5adb48528821e81136a7d96e817865c051b5941d5caace7b788c11fbe4bc2dd7770e27c45931ae880fb3b35a5cde3107b76acb1baf86f5545843f376&ascene=1&uin=MTk0ODYwODI2Mg%3D%3D&devicetype=Windows+10+x64&version=62090529&lang=zh_CN&exportkey=Ad%2BWW3t52pbsfCDuMF0imHA%3D&pass_ticket=33w%2BVRRxbs5mI4ZxvBcFc2IBIwytzREoeKqCirX1lVMeyfS4bL%2B9abrvvnSzn%2BNM

自监督学习主流方法

20200602

BERT模型学习与分析

https://www.jianshu.com/p/160c4800b9b5

20200527

https://blog.youkuaiyun.com/ccbrid/article/details/82835450

NCRF序列标注开源工具使用 开源可以直接使用

https://zhuanlan.zhihu.com/p/78006020

NCRF++

http://www.dataguru.cn/article-15211-1.html

BiLSTM-LAN

https://github.com/18106574249/BiLSTM-LAN

这个看看效果咋样 另外看看速度咋样 和BILSTM-CFR 应该差不多

只适用于格式简单的文本

Ernie slim 可以直接在 ERNIE 上操作吗 而不是在ernie tiny 上面

21:26:39

269884921 2020/5/27 21:26:39

它就是在大模型上操作

269884921 2020/5/27 21:26:49

tiny是它的产物之一

21:29:44

嗨嗨-杭州 2020/5/27 21:29:44

意思就是 如果仅仅用一个单机cpu跑的话 还是无法达到本质上的速度提升 工业上还是无法应用

嗨嗨-杭州 2020/5/27 21:30:12

看来还的本质上 bert 结构的优化

嗨嗨-杭州 2020/5/27 21:30:19

最近出现的一个fastbert

嗨嗨-杭州 2020/5/27 21:30:35

不过现在暂时不适用于 NER

人間の本質 2020/5/27 21:32:20

大型网络本来也很难在cpu上跑

GT|飞桨Ernie 2020/5/27 21:32:48

[图片]

GT|飞桨Ernie 2020/5/27 21:33:04

工业还是GPU用的多一点吧

嗨嗨-杭州 2020/5/27 21:33:35

成本所限 看来这是个无解的问题

21:33:33

人間の本質 2020/5/27 21:33:33

结构上做优化的也有啊

人間の本質 2020/5/27 21:33:41

不是同量级的就是加参数

嗨嗨-杭州 2020/5/27 21:34:00

有些结构上做优化 就是以损失精度为代价

嗨嗨-杭州 2020/5/27 21:34:10

而且速度没有本质的提升

人間の本質 2020/5/27 21:34:59

哪怕albert,计算量也是同量级的

嗨嗨-杭州 2020/5/27 21:35:19

albert 用在NER上效果很差

GT|飞桨Ernie 2020/5/27 21:35:28

CPU成本也不低

2207589533 2020/5/27 21:36:09

现在NER最好的与模型是啥

人間の本質 2020/5/27 21:36:10

可以压缩啊

我不乖加入本群。

人間の本質 2020/5/27 21:37:09

虽然ner本身是个偏开放域,但定期跟个时效性也可以了

嗨嗨-杭州 2020/5/27 21:37:15

给客户 gpu可以省 cpu不能省

人間の本質 2020/5/27 21:37:23

那你得看哪份数据集了

嗨嗨-杭州 2020/5/27 21:37:31

压缩能提高精度?

人間の本質 2020/5/27 21:37:40

cluener说roberta最好

人間の本質 2020/5/27 21:37:53

压缩不损精度就可以了

2207589533 2020/5/27 21:38:18

长度380的句子。拆分成单句做效果会不会提取?

人間の本質 2020/5/27 21:38:38

虽然cluener槽点满满,但总比msra ner难一些

人間の本質 2020/5/27 21:39:07

msra那个就太简单了,虽然它标的个人觉得也挺没劲儿

人間の本質 2020/5/27 21:39:37

京剧能标loc o

人間の本質 2020/5/27 21:40:33

一般情况下如果标的好,长句或许有指向信息

21:42:39

人間の本質 2020/5/27 21:42:39

不过要想模型准确好,样本好才是王道,大模型要其泛化能力,学习表示丰富性,压缩是让小模型能模仿一部分泛化能力,又能提高运算效率

20200526

https://blog.youkuaiyun.com/QbitAI/article/details/99618945

英伟达“暴力碾压”谷歌:53分钟训练完BERT,2.2毫秒完成推理,创下NLP三项新纪录…

https://github.com/NVIDIA/DeepLearningExamples/tree/master/FasterTransformer.

https://blog.youkuaiyun.com/junjie20082008/article/details/104280864/

bert推理速度太慢的解决方案[用于生成表征向量]

https://www.cnblogs.com/nxf-rabbit75/archive/2019/04/18/10727769.html#auto-id-26

命名实体识别总结

2019

20200521

https://zhuanlan.zhihu.com/p/127869267

FastBERT:又快又稳的推理提速方法

20200509

ELECTRA - 比BERT更快更好的预训练模型

https://blog.youkuaiyun.com/black_soil/article/details/102944521

华为的tinybert 还没出来

GEMM( 通用矩阵乘法 )

https://blog.youkuaiyun.com/mangobar/article/details/82925415

把BERT的推断速度提升17倍

https://blog.youkuaiyun.com/u011984148/article/details/104075161

2031

2031

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?