机器之心报道

机器之心编辑部

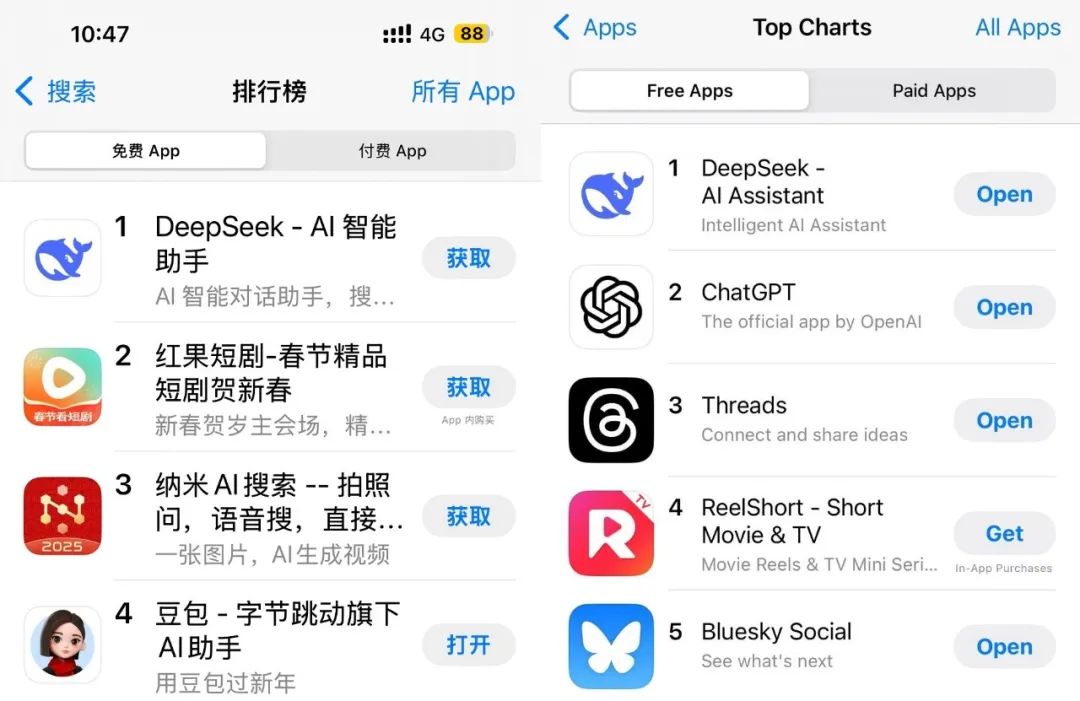

DeepSeek 20 日发布以来获得的热度至今依然没有任何消退的迹象。一觉醒来,DeepSeek 发布的 iOS 应用甚至超越了 ChatGPT 的官方应用,直接登顶 AppStore。

不少网友都认为这是他们当之无愧。

毕竟,正如 a16z 合伙人、Mistral 董事会成员 Anjney Midha 说的那样:从斯坦福到麻省理工,DeepSeek-R1 几乎一夜之间就成了美国顶尖大学研究人员的首选模型。

甚至有网友认为 DeepSeek 是 OpenAI 与英伟达都未曾预见的黑天鹅。

与此同时,围绕 DeepSeek-R1 的各路消息也正层出不穷 ——Hugging Face 等组织正在尝试复现 R1、DeepSeek 之前接受的采访被翻译成了英文版并正在 AI 社区引发热议、开发了 Llama 系列模型的 Meta 似乎陷入了焦虑之中…… 下面我们就来简单盘点一下最近两天围绕 DeepSeek 的几个热点议题。

DeepSeek 创始人梁文锋之前接受的采访被翻译成了英文版,正在 AI 社区引发热议

AI 社区开启 R1 复现热潮

DeepSeek-R1 是开源的,但也没有完全开源 —— 相关的训练数据、训练脚本等并未被公布出来。不过,因为有技术报告,也就有了复现 R1 的指导方针,也因此,最近有不少人都在强调复现 R1 的重要性与可行性。

𝕏 博主 @Charbax 总结了 DeepSeek 文档中没有介绍的地方以及复现 R1 的一些难点。

训练流程的细节。虽然其技术报告中介绍了强化学习阶段和蒸馏,但省略了关键的实现细节,包括超参数(例如,学习率、批量大小、奖励缩放因子)、用于生成合成训练数据的数据管道(例如,如何编排 800K 蒸馏样本)、需要人类偏好对齐的任务的奖励模型架构(多语言输出的「语言一致性奖励」)。

冷启动数据生成。报告中虽然提到了创建「高质量冷启动数据」(例如,人工标准、少样本提示)的过程,但缺乏具体的示例或数据集。

硬件和基础设施。没有关于计算资源(例如,GPU 集群、训练时间)或软件堆栈优化(例如,DeepSeek-V3 的 AMD ROCM 集成)的详细信息。

复现难题。缺少多阶段强化学习的脚本等组件。

当然,也确实有些团队已经开始行动了。

Open R1:复现一个真・开源版 R1

在复现 R1 的各式项目中,最受人关注的当属 Hugging Face 的 Open R1 项目。

项目地址:https://github.com/huggingface/open-r1

Open R1 宣称是 DeepSeek-R1 的「完全开放复现(A fully open reproduction)」,可以补齐 DeepSeek 没有公开的技术细节。该项目目前还在进行中,已经完成的部分包括:

GRPO 实现

训练与评估代码

用于合成数据的生成器

Hugging Face CEO Clem Delangue 的推文

据其项目介绍,Open R1 项目计划分三步实施:

第一步:复现 R1-Distill 模型,具体做法是蒸馏一个来自 DeepSeek-R1 的高质量语料库。

第二步:复现 DeepSeek 用于创建 R1-Zero 的纯强化学习管线。这一步涉及到编排一个新的大规模数据集,其中包含数学、推理和代码数据。

第三步:通过多阶段训练从基础模型得到强化学习微调版模型。

7B 模型 8K 样本复现 R1-Zero 和 R1

另一个复现 R1 的团队是来自香港科技大学的何俊贤(Junxian He)团队,并且他们采用的基础模型和样本量都非常小:基于 7B 模型,仅使用 8K 样本示例,但得到的结果却「惊人地强劲」。

项目地址:https://github.com/hkust-nlp/simpleRL-reason

需要注意,该团队的这个实现的实验大都是在 R1 发布之前完成的。他们发现,仅使用 8K MATH 示例,7B 模型就能涌现出长思维链 (CoT)和自我反思能力,而且在复杂的数学推理上的表现也非常不错。

具体来说,他们从基础模型 Qwen2.5-Math-7B 开始,仅使用来自 MATH 数据集的 8K 样本直接对其进行强化学习。最终得到了 Qwen2.5-SimpleRL-Zero 与 Qwen2.5-SimpleRL。

或者按其博客的说法:「没有奖励模型,没有 SFT,只有 8K 用于验证的 Math 样本,得到的模型在 AIME 上成绩为(pass@1 准确率)33.3%、在 AMC 上实现了 62.5%、在 MATH 上实现 77.2%,优于 Qwen2.5-math-7B-instruct,可与使用多 50 倍数据和更复杂组件的 PRIME 和 rStar-MATH 相媲美。」

Qwen2.5-SimpleRL-Zero 的训练动态

所得模型与基线模型的 pass@1 准确度

基于 3B 模型用 30 美元复现 R1

TinyZero 则是一个尝试复现 DeepSeek-R1-Zero 的项目,据其作者、伯克利 AI 研究所在读博士潘家怡(Jiayi Pan)介绍,该项目是基于 CountDown 游戏实现的,完整配方有一句话就能说完:「遵照 DeepSeek R1-Zero 的算法 —— 一个基础语言模型、提示词和 ground-truth 奖励,然后运行强化学习。」

实验过程中,模型一开始的输出很蠢笨,但逐渐发展出修改和搜索等策略。下面展示了一个示例,可以看到模型提出解决方案,自我验证,并反复修改,直到成功。

实验中,该团队也得到了一些有意思的发现:

基础模型的质量很重要。0.5B 的小模型在猜测一个解答之后就会停止,而从 1.5B 规模开始,模型会开始学习搜索、自我验证、修正解答,从而可以得到远远更高的分数。

基础模型和指令模型都可行。实验发现,指令模型的学习速度更快,但性能会收敛到与基础模型同等的程度;同时指令模型的输出更加结构化、更可读。

具体采用什么强化学习算法并不重要。该团队尝试了 PPO、GRPO 和 PRIME,但它们的差异并不大。

模型的推理行为严重取决于具体任务。对于 CountDown 游戏,模型会学习执行搜索和自我验证;对于数值乘法,模型会学习使用分配律分解问题并逐步解决。

模型学会乘法分配律

而最惊人的是,整个项目的计算成本不到 30 美元。

Meta 的焦虑:下一代 Llama 可能赶不上 R1

数天前,机器之心报道文章《Meta 陷入恐慌?内部爆料:在疯狂分析复制 DeepSeek,高预算难以解释》引起广泛关注与讨论。

文章中, Meta 员工在美国匿名职场社区 teamblind 上面发布了一个帖子提到,国内 AI 创业公司 DeepSeek 最近的一系列动作让 Meta 的生成式 AI 团队陷入了恐慌。

今日,The Information 最新的文章爆料出更多内容。

在文章中,The Information 爆料称包括 Meta 人工智能基础设施总监 Mathew Oldham 在内的领导表示,他们担心 Meta Llama 的下一个版本性能不会像 DeepSeek 的那样好。

Meta 也暗示 Llama 的下一个版本将于本季度发布。

此外,文章也爆料,Meta 生成式 AI 小组和基础设施团队组织了四个作战室来学习 DeepSeek 的工作原理。

其中两个作战室,正在试图了解幻方是如何降低训练和运行 DeepSeek 模型的成本。其中一名员工表示:Meta 希望将这些技术应用于 Llama。

其中一些开发人员透露,尽管 Meta 的模型是免费的,但它们的运行成本通常比 OpenAI 的模型更高,部分原因是 OpenAI 可以通过批量处理其模型客户的数百万条查询来降低价格。但是,使用 Llama 的小型开发人员却没有足够的查询来降低成本。

据一位直接了解情况的员工透露,第三个作战室正在试图弄清楚幻方可能使用哪些数据来训练其模型。

第四作战室正在考虑基于 DeepSeek 模型的新技术,重构 Meta 模型。Meta 考虑推出一个与 DeepSeek 相似的 Llama 版本,它将包含多个 AI 模型,每个模型处理不同的任务。这样,当客户要求 Llama 处理某项任务时,只需要模型的某些部分进行处理。这样做可以使整个模型运行得更快,并且以更少的算力来运行。

不知道,在这样的压力下,2025 年 Meta 会拿出什么样的开源模型?说不定,Meta 也会加入到复现 R1 的浪潮中。

不过可以预料的是,在 DeepSeek 这条鲶鱼的搅动下,新一年的大模型格局正在发生转变。

对新一年的 AI 技术发展与应用,你有什么样的期待?欢迎留言讨论。

参考链接:

https://www.theinformation.com/articles/meta-scrambles-after-chinese-ai-equals-its-own-upending-silicon-valley

3549

3549

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?