1.环境准备

1.1 cmake

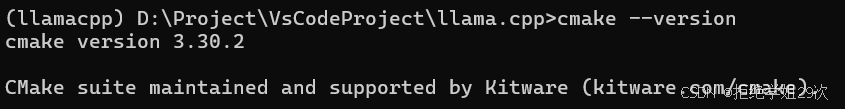

在cmd上查看这些安装情况,输入cmake --version, 查看cmake是否安装,如果没有安装,参考这个cmake 安装教程,再次输入cmake --version

cmake --version

1.2 git

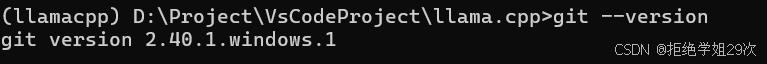

在cmd中查看git是否安装,没有安装的话参考这个git安装教程,安装完成后cmd中输入git --version

git --version

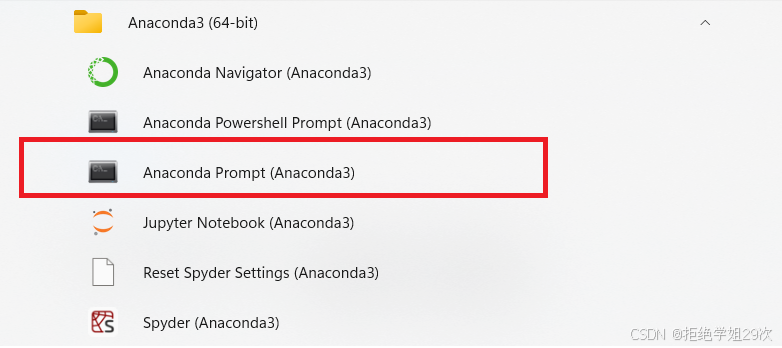

1.3 anaconda/minconda

这个主要是用来调用llama.cpp中的python模型转换脚本的,只要有相应的python包就可以,笔者这里为了环境不冲突,使用conda 创建的虚拟环境进行python包安装。如果没有anaconda,参照anaconda安装教程, 安装好conda后,在开始->所有应用->anaconda中有个anaconda版的prompt, 如图,点击,这样就能创建虚拟环境了。

输入命令 conda create -n llamacpp python==3.10, -n表示名称(name),python==3.10表示指定python版本3.10, 正常来说,其他版本都可以,笔者这里用的3.10

conda create -n llamacpp python==3.101.4 virtual studio

如果没有安装vs2019或者vs2022,参考这个vs安装教程 ,安装之后,配置一下环境变量可以参考vs环境变量教程。

至此,所有环境已经ok

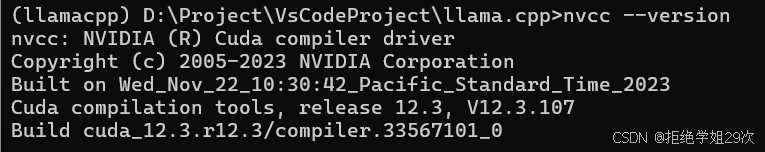

1.5 cuda

笔者的显卡是4060laptop, 安装的cuda版本是12.3, 如果没有安装cuda, 需要根据显卡的类型选择相应的cuda版本,再进行安装,安装之后输入 nvcc --version,查看是否安装成功。

nvcc --version 2. 编译执行llama.cpp

2. 编译执行llama.cpp

2.1 编译源码

首先clone下来

git clone https://github.com/ggerganov/llama.cpp然后进行cd 到项目文件夹下,输入mkdir build 创建文件夹 build, 再cd build文件夹下

cd llama.cpp

mkdir build

cd build执行cmake .. -DGGML_CUDA=ON,指定后端为cuda

cmake .. -DGGML_CUDA=ON然后开始构建,输入cmake --build . --config Release -j16, -j16表示开16个线程构建,Release表示构建Release版本, 小圆点"." 表示在当前文件夹构建

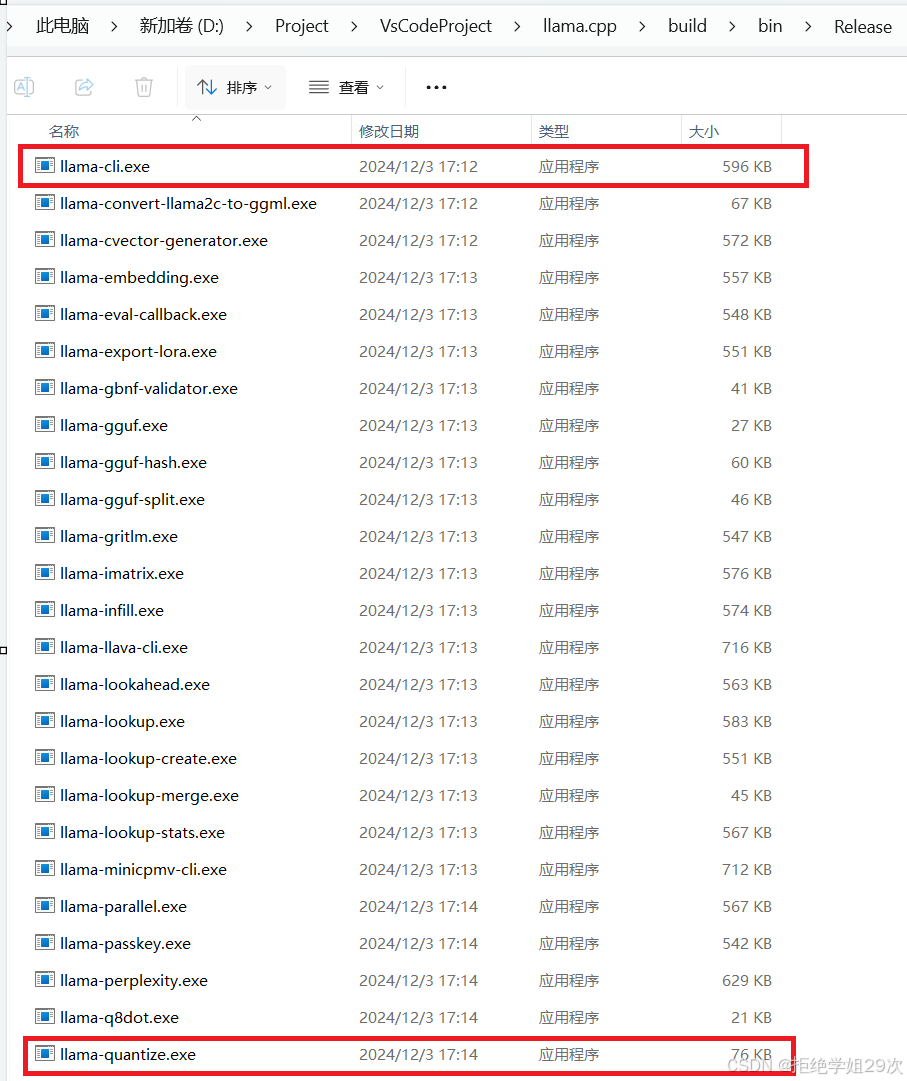

cmake --build . --config Release -j16然后等待25分钟即可,完成之后生成的exe在build/bin/Release/文件夹下,主要需要用到lama-cli.exe和llama-quantize.exe

2.2 运行面壁智能 CPM-2B-dpo-F16模型

2.2.1 下载模型

笔者这里采用git从魔搭社区下载,命令如下,模型大小为5G左右,参考魔搭社区,在llama.cpp的项目文件夹下有个models的文件夹,cd models,切换到这个文件夹下

cd models

git lfs install

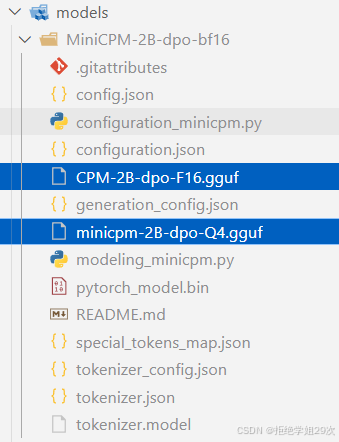

git clone https://www.modelscope.cn/OpenBMB/MiniCPM-2B-dpo-bf16.git下载好的文件结构如图所示, 蓝色部分是笔者后来转化的fp16 gguf模型文件和量化后的模型文件,去掉蓝色部分之后就是下载的文件。

2.2.2 转化模型

激活1.3 中创建的llamacpp, 切换到llama.cpp文件夹目录下,输入pip install -r requirements.txt,安装相关依赖

conda activate llamacpp

cd llama.cpp

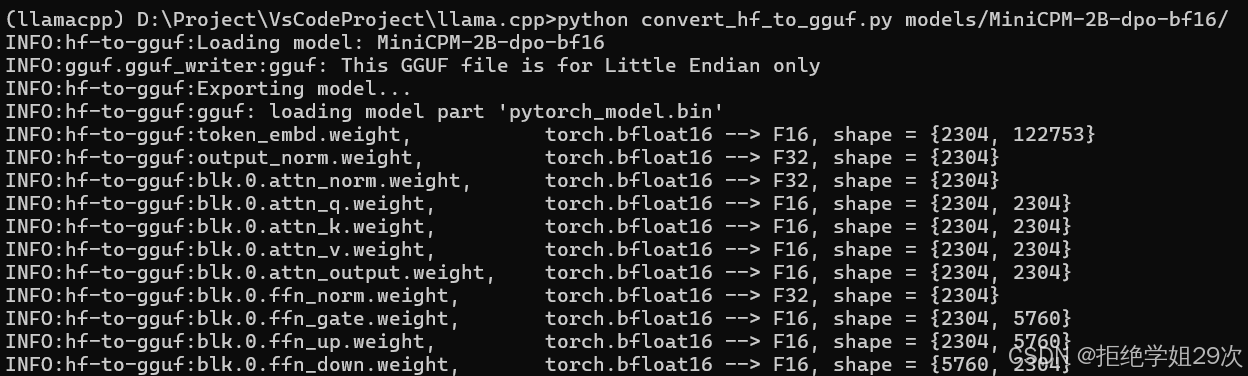

pip install -r requirements.txt依赖安装之后,输入下面指令,将官网上的.bin模型转化为.gguf格式

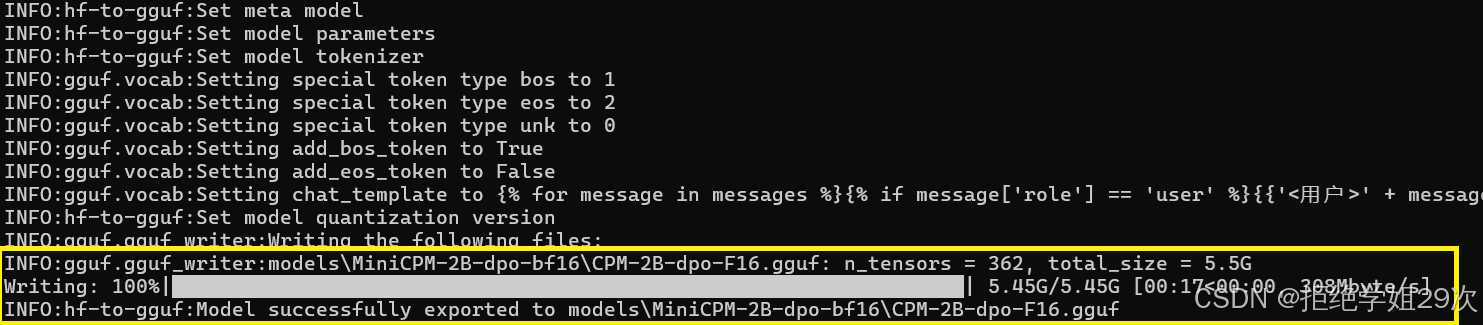

python convert_hf_to_gguf.py models/MiniCPM-2B-dpo-bf16/可以看到,黄色框已经输出了生成的gguf模型

2.2.3 量化模型

输入下面的指令,将模型转为int4

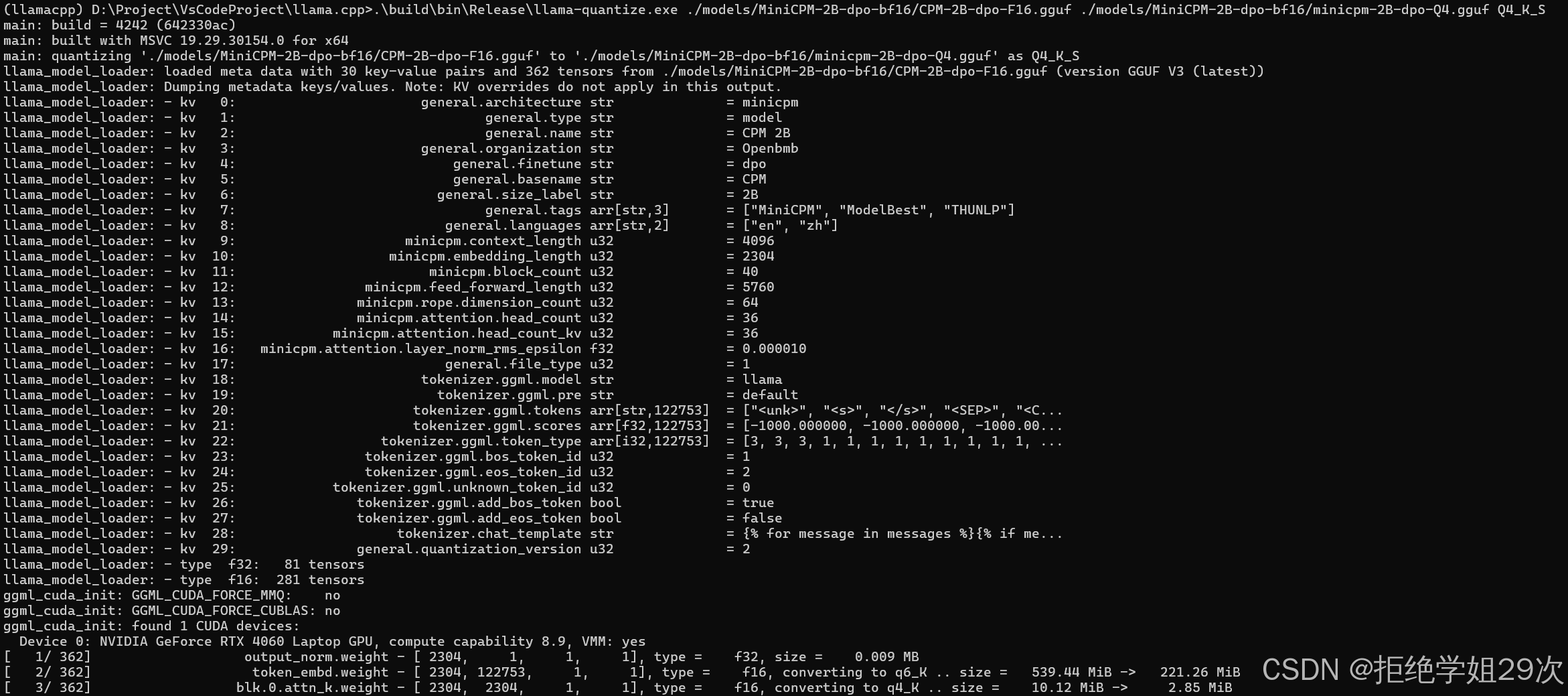

.\build\bin\Release\llama-quantize.exe ./models/MiniCPM-2B-dpo-bf16/CPM-2B-dpo-F16.gguf ./models/MiniCPM-2B-dpo-bf16/minicpm-2B-dpo-Q4.gguf Q4_K_S

至此模型量化已经完成

2.2.4 执行

输入下面的命令进行执行,-p表示prompt, <用户> ...<AI>这个是固定格式,否则推理会出错,-n 2048 表示输出最大2048个token

.\build\bin\Release\llama-cli.exe -m models/MiniCPM-2B-dpo-bf16/minicpm-2B-dpo-Q4.gguf -p "<用户>conda 如何激活虚拟环境?<AI>" -n 2048enjoy

参考

1587

1587

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?