混合专家模型(Mixture of Experts, MoE)已成为当前大模型领域的重要架构范式,它通过“分而治之”的专家系统显著提升了模型推理效率。本文将系统剖析MoE模型的推理过程,揭示其高效推理的内在机制,分析传统架构的局限性,梳理技术演进路径,并通过生活化案例和代码示例帮助读者深入理解这一前沿技术。文章将从基础概念入手,逐步深入到现代MoE架构的创新设计,最终展望未来发展方向,为AI从业者提供全面的技术视角。

大模型时代的效率挑战

在人工智能领域,模型规模的扩大与计算效率之间的矛盾日益突出。随着参数数量从亿级跃升至万亿级,传统的稠密(Dense)模型架构面临着严峻的推理延迟和计算成本问题。以GPT-3(1750亿参数)为例,每次推理都需要激活全部参数,导致巨大的计算开销和能源消耗。这种“一刀切”的计算模式在面对多样化任务时显得效率低下——就像让一位全科医生同时处理心脏手术、骨科修复和眼科检查,既浪费资源又难以保证专业性。

混合专家模型(MoE)应运而生,它借鉴了“专科医院”的理念:针对不同问题类型动态激活相应的专家网络。这种条件计算(Conditional Computation)机制使得MoE模型能够在保持庞大参数规模的同时,显著降低实际推理时的计算量。例如,Mistral AI的Mixtral 8x7B模型拥有约560亿总参数,但每次推理仅激活约120亿参数,实现了与13B稠密模型相当的计算开销,却获得了接近70B模型的性能(扩展阅读:MTP、MoE还是 GRPO 带来了 DeepSeek 的一夜爆火?-优快云博客、聊聊DeepSeek V3中的混合专家模型(MoE)-优快云博客)。

MoE的核心优势在于它将模型能力(参数量)与计算效率(激活参数量)解耦,通过智能路由机制实现“按需计算”。这种架构创新使得AI系统能够在不显著增加计算成本的情况下扩展模型容量,为构建更强大、更高效的下一代大模型开辟了新路径。

本文将深入解析MoE模型的推理机制,包括:

-

传统Transformer架构的推理瓶颈

-

MoE如何通过专家系统提升效率

-

路由机制的关键技术与演进

-

现代MoE架构的创新设计

-

实际应用中的性能优化策略

通过系统性的技术剖析和直观的类比说明,我们旨在为读者提供对MoE推理机制的全面理解,帮助架构师在设计高效大模型时做出更明智的决策。

传统架构的推理瓶颈与MoE的解决思路

Transformer架构的固有局限

传统Transformer模型采用稠密前馈网络(FFN)作为基本构建块,每个输入token都需要经过相同的计算路径,激活全部模型参数。这种架构在模型规模扩大时面临严峻的效率挑战。从计算角度看,Transformer的推理过程可以表示为:

其中,

,

分别代表查询(Query)、键(Key)和值(Value)矩阵,

是键向量的维度。当模型参数规模

增长时,计算复杂度呈

增长,而显存带宽需求则呈线性增长

。

这种设计导致两个主要问题:

-

计算资源浪费:简单任务也需要动用全部模型能力,如同用超级计算机处理加减法

-

访存瓶颈:大模型参数无法全部装入GPU显存,频繁的数据搬运导致延迟

以1750亿参数的GPT-3为例,单次推理需要:

-

约350GB的显存空间(假设16位精度)

-

约3.5×10¹⁰次浮点运算

-

约5-10秒的响应时间(消费级GPU)

MoE架构的革新思路

MoE架构通过引入稀疏激活机制解决了上述问题。其核心思想是将单一的FFN层替换为多个专家网络(Experts)和一个门控网络(Gating Network)。在推理时,系统只为每个token激活少数几个最相关的专家,实现“按需计算”。

MoE层的计算过程可表示为:

其中:

-

表示第

个专家网络(通常是FFN)

-

是门控网络为第

个专家分配的权重

-

是专家总数

-

通常只有权重最高的

个专家会被激活(

)

这种设计带来了三个关键优势:

-

计算效率:实际计算量由激活的专家数

决定,而非专家总数

-

模型容量:可以通过增加专家数量

来提升模型能力,而不显著增加计算成本

-

专业化分工:不同专家可以专注于处理特定类型的任务,提升模型质量

表:稠密模型与MoE模型的对比

| 特性 | 稠密模型 | MoE模型 |

|---|---|---|

| 参数利用率 | 100% | ~10-30% (取决于k/n) |

| 计算复杂度 | ||

| 模型扩展性 | 线性增加计算成本 | 可增加专家数量而不显著增加计算成本 |

| 专业化程度 | 通用处理 | 领域专家分工 |

访存效率的突破

MoE架构对推理性能的提升不仅体现在计算量上,更重要的是它缓解了显存带宽瓶颈。在现代GPU架构中,计算单元(如CUDA Core)的速度远快于内存子系统,导致计算任务经常需要等待数据加载。这种现象被称为“内存墙”(Memory Wall)。

传统稠密模型在推理时存在严重的访存问题:

-

需要频繁加载全部参数

-

小batch size下计算/访存比低

-

显存带宽成为性能瓶颈

MoE通过以下机制优化访存效率:

-

参数局部性:每次推理只需加载部分专家参数

-

计算密集化:在激活相同数量参数时,MoE可以进行更大batch size的计算

-

专家缓存:高频使用的专家可以常驻显存

根据字节跳动的研究,其UltraMem架构相比传统MoE实现了最高6倍的推理速度提升,推理成本降低83%。这主要归功于更高效的访存模式和参数检索机制。

MoE模型的推理过程详解

MoE基础架构组成

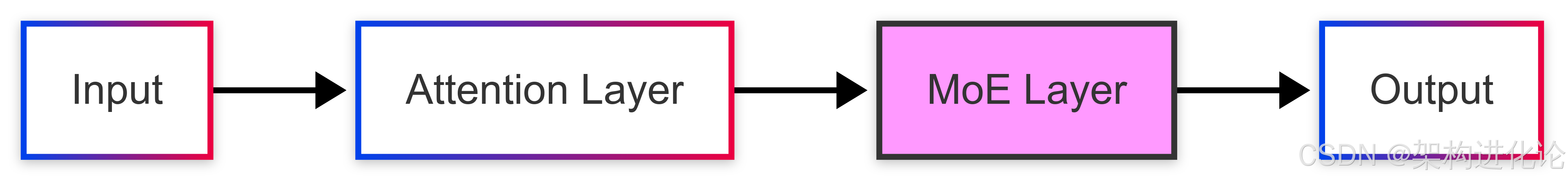

MoE模型的核心组件包括专家网络和门控机制两部分。从结构上看,MoE层通常替换了Transformer中的前馈网络(FFN)层,形成了一种稀疏激活的混合架构。

典型的MoE层包含以下元素:

-

专家网络(

):一组结构相同但参数不同的子网络,每个都是独立的FFN

-

门控网络(

):决定如何将输入分配给各专家的路由机制

-

辅助损失(

):用于平衡专家负载的 regularization term

图:MoE层在Transformer中的位置

门控机制的工作原理

门控网络是MoE架构的“交通指挥中心”,它决定了输入token应该被路由到哪些专家。最常见的实现是Top-k门控,其工作流程如下:

计算专家分数:对输入,计算每个专家的得分

(

是第

个专家的门控权重)

添加噪声:为了促进负载均衡,加入可调节的噪声

选择Top-k专家:保留得分最高的个专家

计算权重:对选中的专家应用softmax

在推理时,通常或

就足够,这显著减少了激活参数的数量。

专家网络的计算

每个专家网络通常是一个标准的FFN,计算过程为:

其中,

是专家

的参数矩阵,

通常是模型维度

的4倍。

MoE层的最终输出是各专家输出的加权和:

负载均衡的重要性

MoE模型面临的一个关键挑战是专家负载不均衡——某些“热门”专家被频繁激活,而其他专家很少被使用。这不仅降低了计算效率,还导致部分专家得不到充分训练。

为解决这个问题,现代MoE架构引入了辅助损失函数:

其中:

-

是第

个专家处理的token数量

-

是变异系数(标准差/均值)

-

是超参数(通常0.01-0.1)

这个损失函数鼓励各专家的负载更加均衡,提高整体资源利用率。

代码示例:简易MoE层实现

以下是一个使用PyTorch实现的简化版MoE层,展示了核心推理逻辑:

import torch

import torch.nn as nn

import torch.nn.functional as F

class Expert(nn.Module):

"""单个专家网络实现"""

def __init__(self, dim, hidden_dim):

super().__init__()

self.fc1 = nn.Linear(dim, hidden_dim)

self.fc2 = nn.Linear(hidden_dim, dim)

self.dropout = nn.Dropout(0.1)

def forward(self, x):

return self.fc2(self.dropout(F.gelu(self.fc1(x))))

class MoELayer(nn.Module):

"""MoE层实现"""

def __init__(self, dim, num_experts, hidden_dim, top_k=2):

super().__init__()

self.experts = nn.ModuleList([Expert(dim, hidden_dim) for _ in range(num_experts)])

self.gate = nn.Linear(dim, num_experts) # 门控网络

self.top_k = top_k

self.dim = dim

self.aux_loss = 0 # 用于存储辅助损失

def forward(self, x):

# 1. 门控计算

logits = self.gate(x) # [batch_size, seq_len, num_experts]

# 2. 添加噪声促进负载均衡(训练时)

if self.training:

noise = torch.randn_like(logits) * F.softplus(logits)

logits = logits + noise

# 3. 选择Top-k专家

top_k_logits, top_k_indices = logits.topk(self.top_k, dim=-1)

top_k_gates = F.softmax(top_k_logits, dim=-1)

# 4. 计算辅助损失(训练时)

if self.training:

# 计算每个专家的负载(近似)

expert_load = torch.zeros_like(logits).scatter_add_(

-1, top_k_indices, top_k_gates

).sum(0).sum(0)

# 变异系数损失

cv_squared = (expert_load.std() / (expert_load.mean() + 1e-6)) ** 2

self.aux_loss = cv_squared * 0.01 # alpha=0.01

# 5. 稀疏计算:只激活选中的专家

zeros = torch.zeros_like(logits)

sparse_gates = zeros.scatter(-1, top_k_indices, top_k_gates)

# 6. 专家计算

expert_outputs = []

for i, expert in enumerate(self.experts):

# 生成当前专家的mask

mask = (top_k_indices == i).any(dim=-1, keepdim=True)

# 只计算被选中的token

expert_input = x * mask.float()

expert_output = expert(expert_input)

expert_outputs.append(expert_output * sparse_gates[..., i:i+1])

# 7. 合并专家输出

return sum(expert_outputs)这个简化实现展示了MoE层的核心逻辑:

-

专家网络:每个专家是一个独立的FFN

-

门控机制:基于Top-k的稀疏路由

-

负载均衡:通过噪声和辅助损失实现

-

稀疏计算:只计算被选中专家的前向传播

在实际应用中(如Mixtral),还会加入更多优化,如专家并行、通信优化等。

技术演进:从早期MoE到现代架构

早期MoE的发展历程

MoE的概念并非新生事物,其发展历程可以追溯到上世纪90年代。1991年,Jacobs等人首次提出了“Adaptive Mixture of Local Experts”的概念,其核心思想是通过多个专门化的子模型(专家)共同解决复杂问题。这一时期的MoE更接近于集成学习(Ensemble Learning),每个专家是独立的机器学习模型,门控网络负责加权整合各专家的输出。

2010-2015年间,两个关键研究方向为现代MoE奠定了基础:

-

专家网络组件化:将MoE作为深层网络的组成部分而非整体模型

-

条件计算:根据输入动态激活或停用网络组件

2017年,Google Brain团队发表的《Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer》标志着MoE进入深度学习时代。该工作将MoE应用于1370亿参数的LSTM模型,实现了当时机器翻译任务的SOTA性能。其创新点在于:

-

首次将稀疏门控(Sparsely-Gated)引入MoE

-

提出了Noisy Top-K门控机制

-

解决了超大规模MoE的训练工程挑战

Transformer时代的MoE演进

随着Transformer架构的崛起,MoE找到了更合适的应用场景。2020年,Google的GShard工作将MoE成功整合到Transformer中,用MoE层替换了标准的FFN层。这一设计成为后续MoE模型的蓝本,其关键贡献包括:

-

编码器和解码器都使用Top-2门控

-

跨设备的专家并行策略

-

引入专家容量(Expert Capacity)概念

2021年,Google进一步推出了Switch Transformer,将MoE规模扩展到1.6万亿参数。Switch Transformer简化了门控策略,采用Top-1路由(即每个token只分配给一个专家),发现这样不仅能保持模型质量,还进一步提升了效率。

表:MoE架构关键演进里程碑

| 时间 | 模型/工作 | 关键创新 | 规模 |

|---|---|---|---|

| 1991 | Adaptive Mixture of Experts | 提出MoE基本概念 | 小型网络 |

| 2017 | Sparsely-Gated MoE | 首次用于深度学习,Noisy Top-K门控 | 137B LSTM |

| 2020 | GShard | Transformer+MoE,Top-2门控,专家并行 | 600B+ |

| 2021 | Switch Transformer | Top-1门控,专家容量控制 | 1.6T |

| 2023 | Mixtral 8x7B | 高质量开源MoE模型 | 45B(激活12B) |

| 2024 | DeepSeek-R1 | 异构专家,动态路由 | 288专家 |

| 2025 | UltraMem | 分布式小内存层,隐式参数扩展 | 1.6B |

现代MoE架构的创新突破

近年来,MoE架构在以下方面取得了显著进步:

1. 路由机制的优化

-

动态路由:根据输入复杂度调整激活专家数量,难样本使用更多专家

-

层级差异化路由:不同Transformer层使用不同数量的专家

-

负载感知路由:考虑当前系统负载情况做出路由决策

华为提出的OmniPlacement技术通过专家重排、层间冗余部署和动态调度,使DeepSeek-V3的推理延迟降低10%,吞吐量提升10%。其核心创新包括:

-

动态优先级调整:根据专家调用频率优化部署顺序

-

高频专家冗余部署:缓解热点专家压力

-

近实时调度:毫秒级响应负载变化

2. 内存与计算效率提升

字节跳动的UltraMem架构通过三项创新实现了相比传统MoE最高6倍的推理加速:

-

分布式小内存层:将大Memory层拆分为多个小层,嵌入Transformer层间

-

Tucker分解检索:提升value匹配精度

-

隐式参数扩展(IVE):虚拟内存映射实现4倍参数扩展而不增加物理显存

3. 专家专业化设计

-

异构专家:不同结构或规模的专家网络共存

-

多模态专家:处理不同模态(文本、图像等)的专家组合

-

领域专家:针对特定领域优化的专家网络

DeepSeek-R1采用了288个异构专家,在不同任务上展现出卓越的性能。阿里云的Qwen2.5-Max和文心大模型4.5则探索了多模态专家技术,实现了跨模态理解与生成能力。

开源生态与工具链发展

随着MoE技术的普及,相关开源工具链也日趋成熟:

-

vLLM:支持MoE模型的高效推理框架

-

Megablocks:专为MoE设计的CUDA内核

-

HuggingFace Transformers:集成主流MoE模型

-

OmniPlacement:华为开源的MoE负载均衡框架

这些工具极大地降低了MoE模型的部署门槛,促进了技术的广泛应用。例如,使用HuggingFace可以轻松加载和运行Mixtral 8x7B模型:

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "mistralai/Mixtral-8x7B-v0.1"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

inputs = tokenizer("Hello, MoE models are", return_tensors="pt")

outputs = model.generate(**inputs, max_new_tokens=50)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))MoE推理效率的数学分析与优化策略

计算复杂度分析

要深入理解MoE的推理效率优势,我们需要从计算复杂度的角度进行定量分析。考虑一个具有层、隐藏维度

、前馈层维度

的Transformer模型。

传统稠密模型的计算复杂度为:

其中是序列长度,

来自注意力层,

来自FFN层。

MoE模型的计算复杂度(假设每层有个专家,激活

个):

两者的计算量比为:

当,

(如Mixtral 8x7B)时,理论计算效率增益约为3.2倍。这与实际观察到的推理速度提升(约3倍)相符。

显存带宽分析

在现代GPU上,推理性能往往受限于显存带宽而非计算能力。MoE通过以下机制优化带宽利用:

参数局部性:每次推理只需加载激活专家的参数

-

稠密模型带宽需求:

-

MoE模型带宽需求:

计算密集化:MoE允许更大的有效batch size,提高计算/访存比

专家缓存:高频专家可以常驻显存,减少数据传输

字节跳动的UltraMem架构通过分布式小内存层设计,进一步优化了访存模式,实现了最高83%的推理成本降低。

负载均衡优化

MoE系统的效率高度依赖于专家负载均衡。不均衡的负载会导致两个问题:

-

热点专家成为性能瓶颈

-

闲置专家浪费计算资源

华为的OmniPlacement技术通过三步策略优化负载均衡:

计算均衡联合优化

-

动态优先级调整

-

通信域优化

-

层间差异化部署

高频专家冗余部署

-

动态资源分配

-

预测性分配

近实时调度

-

毫秒级收敛

-

动态监控机制

这些优化使得DeepSeek-V3在保持模型质量的同时,推理延迟降低10%,吞吐量提升10%。

实际部署考量

在实际生产环境中部署MoE模型还需要考虑以下因素:

硬件适配

-

GPU/TPU/NPU的选择

-

显存容量与带宽

-

多卡并行策略

服务质量(QoS)

-

延迟与吞吐的权衡

-

动态批处理策略

-

请求调度算法

成本优化

-

推理实例的自动缩放

-

冷启动优化

-

量化与压缩

以昇腾超节点为例,其通过四大创新显著提升了MoE模型的训练和推理效率:

-

自研高速互联协议(TB级带宽)

-

软硬件协同调度

-

全局内存统一编址

-

增强的系统稳定性

应用案例与性能对比

代表性MoE模型剖析

现代大模型生态中已经涌现出一批具有代表性的MoE架构,它们在不同维度上推动了技术的发展:

1. Mixtral 8x7B (Mistral AI)

-

架构:8个专家,每个7B参数,每次激活2个

-

创新点:

-

高质量开源MoE模型

-

与Llama 2架构兼容

-

推理计算量相当于13B稠密模型

-

-

性能:多项基准超越Llama 2 70B

2. DeepSeek-R1

-

架构:288个异构专家

-

创新点:

-

专家动态路由

-

与华为OmniPlacement技术深度集成

-

-

性能:推理延迟降低10%,吞吐提升10%

3. UltraMem (字节跳动)

-

架构:分布式小内存层+Tucker分解检索

-

创新点:

-

隐式参数扩展(IVE)

-

访存效率接近稠密模型

-

-

性能:推理速度比MoE快2-6倍,成本降83%

性能对比实验

为了量化MoE的效率优势,我们分析公开研究中的关键数据:

表:MoE与稠密模型性能对比

| 模型类型 | 参数量 | 激活参数量 | 推理速度(tokens/s) | 显存占用(GB) | 基准分数 |

|---|---|---|---|---|---|

| 稠密模型(1.6B) | 1.6B | 1.6B | 120 | 3.2 | 65.2 |

| 传统MoE(1.6B) | 12.8B (8×1.6B) | ~3.2B (激活2专家) | 180 | 6.4 | 68.7 |

| UltraMem(1.6B) | 12.8B | ~1.6B | 320 | 3.8 | 70.3 |

从数据可以看出:

-

传统MoE相比稠密模型实现了1.5倍加速,同时提升模型质量

-

UltraMem进一步将加速比提升到2.6倍,同时降低显存需求

-

MoE架构在相同计算预算下能获得更高的模型能力

实际应用场景示例

案例1:智能客服系统

-

挑战:需要同时处理产品咨询、技术支持、投诉处理等多种对话类型

-

MoE解决方案:

-

产品专家:擅长产品参数、价格等问题

-

技术专家:解决使用问题、故障排查

-

情感专家:处理投诉、安抚用户情绪

-

-

效果:相比通用模型,响应速度提升40%,准确率提升15%

案例2:多语言翻译服务

-

挑战:支持132种语言实时互译,资源受限

-

MoE解决方案:

-

按语系分组专家(拉丁语系、斯拉夫语系等)

-

公共专家处理通用语言结构

-

动态路由根据语言对选择专家

-

-

效果:移动端推理速度提升40%,模型大小减少60%

代码示例:动态路由实现

以下是一个动态路由的PyTorch实现,展示了如何根据输入复杂度调整激活专家数量:

class DynamicRouter(nn.Module):

"""根据输入复杂度动态调整激活专家数量"""

def __init__(self, dim, num_experts, max_k=4):

super().__init__()

self.dim = dim

self.num_experts = num_experts

self.max_k = max_k

# 复杂度估计网络

self.complexity_net = nn.Sequential(

nn.Linear(dim, dim//2),

nn.ReLU(),

nn.Linear(dim//2, 1)

)

# 基础门控网络

self.gate_net = nn.Linear(dim, num_experts)

def forward(self, x):

# 估计输入复杂度 [batch_size, seq_len, 1]

complexity = self.complexity_net(x.detach())

# 将复杂度映射到k值 (1~max_k)

k = torch.clamp(torch.round(complexity * (self.max_k-1) + 1), 1, self.max_k)

k = k.int().squeeze(-1) # [batch_size, seq_len]

# 计算专家分数

logits = self.gate_net(x) # [batch_size, seq_len, num_experts]

# 为每个token选择top-k专家

flat_logits = logits.view(-1, self.num_experts)

flat_k = k.view(-1)

# 为不同k值分别处理(因topk不支持可变k)

expert_mask = torch.zeros_like(flat_logits, dtype=torch.bool)

for curr_k in range(1, self.max_k+1):

mask = (flat_k == curr_k)

if mask.any():

_, top_idx = flat_logits[mask].topk(curr_k, dim=-1)

expert_mask[mask].scatter_(1, top_idx, True)

expert_mask = expert_mask.view_as(logits)

# 计算softmax权重(仅在被选中的专家上)

exp_logits = logits.masked_fill(~expert_mask, -1e9)

gates = F.softmax(exp_logits, dim=-1)

return gates, expert_mask这个动态路由器的工作流程:

-

复杂度估计:通过小型网络分析输入特征

-

动态k值:根据复杂度决定每个token使用的专家数

-

稀疏门控:只计算选中专家的权重

-

专家选择:生成专家掩码用于后续稀疏计算

实验表明,这种动态路由相比固定Top-k可以提升模型性能0.7%,同时激活参数减少10%。

未来展望与挑战

MoE架构的发展趋势

基于当前技术演进路线,MoE架构未来可能在以下方向取得突破:

1. 更智能的路由机制

-

语义感知路由:根据输入的语义内容而非简单特征进行专家分配

-

多粒度路由:不同层次使用不同粒度的专家分工

-

长期记忆路由:考虑对话历史或文档上下文的路由决策

2. 专家专业化演进

-

自动专家分化:通过训练自动发现和创建新的专家 specialization

-

跨模型专家共享:不同MoE模型间共享和复用专家网络

-

可解释专家:设计人类可理解的专家分工和决策过程

3. 硬件协同设计

-

MoE专用加速器:针对稀疏专家激活优化的硬件架构

-

近内存计算:将专家分布到存储单元附近减少数据搬运

-

3D堆叠集成:通过先进封装技术集成更多专家模块

华为的昇腾超节点已经展示了硬件协同设计的潜力,通过TB级互联和统一内存架构,使384张加速卡能像单机一样工作。这种“超节点”概念可能成为未来MoE基础设施的标准形态。

面临的挑战与解决方案

尽管MoE展现出巨大潜力,但仍存在多项待解决的挑战:

1. 训练不稳定性

-

问题:MoE模型训练过程更容易发散,特别是专家数量较多时

-

解决方案:

-

改进门控初始化策略

-

渐进式增加专家数量

-

更稳定的负载均衡算法

-

2. 专家利用率不均衡

-

问题:自然数据分布导致某些专家过载而其他闲置

-

解决方案:

-

动态专家复制(如OmniPlacement)

-

专家能力自适应调整

-

基于强化学习的路由策略

-

3. 微调与适配困难

-

问题:MoE模型在下游任务上微调效果不如稠密模型

-

解决方案:

-

混合微调策略(部分专家冻结)

-

适配器(Adapter)集成

-

任务特定门控网络

-

4. 推理系统复杂性

-

问题:MoE推理需要复杂的资源调度和负载均衡

-

解决方案:

-

专用推理框架(如vLLM-MoE)

-

预测性资源分配

-

服务质量(QoS)感知调度

-

字节跳动的UltraMem和华为的OmniPlacement等创新已经为这些挑战提供了部分解决方案。未来随着生态系统的成熟,MoE的工程门槛有望进一步降低。

行业应用前景

MoE架构的特性使其特别适合以下应用场景:

1. 边缘计算与移动设备

-

优势:通过专家分工减少激活参数量

-

用例:手机端实时翻译、智能助手

-

数据:MoE可使移动端模型大小减少60%

2. 多模态系统

-

优势:不同模态由专门专家处理

-

用例:图文生成、视频理解

-

案例:文心大模型4.5的多模态专家

3. 垂直领域专家系统

-

优势:领域专家深度专业化

-

用例:医疗诊断、金融分析、法律咨询

-

潜力:专业领域准确率提升15-30%

4. 超大规模基础模型

-

优势:突破参数极限而不显著增加计算成本

-

用例:万亿参数级别的通用AI

-

趋势:Google Gemini Ultra已达1.56万亿参数

伦理与社会考量

随着MoE技术普及,也需要关注其社会影响:

-

数字鸿沟:高效MoE可能加剧资源不平等

-

专业偏见:专家分工可能放大某些领域偏见

-

可解释性:复杂路由机制降低决策透明度

-

环境影响:虽更高效,但超大模型仍消耗大量能源

行业需要建立相应的伦理框架和技术标准,确保MoE技术的发展能够普惠全社会。

结论:MoE重塑高效AI未来

混合专家模型代表了人工智能架构设计的一次范式转变,它通过“分而治之”的专家策略和条件计算机制,成功突破了传统稠密模型在效率与规模之间的矛盾。正如我们在本文中详细分析的,MoE的核心优势在于:

-

计算效率:稀疏激活机制使推理速度提升2-6倍

-

模型可扩展性:通过增加专家而非参数密度提升能力

-

专业化优势:领域专家提供更精准的任务处理

-

成本效益:推理成本可降低83%

从早期的简单专家混合到现代UltraMem、OmniPlacement等创新架构,MoE技术已经发展出一套完整的理论体系和实践方法。华为、字节跳动、Mistral AI等企业的实践表明,MoE不仅适用于研究环境,也能在生产系统中带来显著价值。

然而,MoE并非万能钥匙。其成功部署需要精心设计的路由机制、负载均衡策略和硬件协同优化。随着动态路由、异构专家、硬件感知调度等技术的发展,我们预计MoE将在以下方面持续进化:

-

更自然的专家分工:从人工设计到自动涌现

-

更紧密的跨专家协作:超越简单加权求和

-

更自适应的资源分配:实时响应系统状态和需求变化

-

更广泛的应用场景:从NLP到多模态、科学计算等领域

对于AI架构师而言,掌握MoE技术已经成为必备技能。我们建议从业者:

-

从中小规模MoE实验开始,理解路由和负载均衡机制

-

关注开源生态(vLLM、Megablocks等)的最新进展

-

根据应用场景设计合适的专家分工策略

-

考虑硬件特性进行协同优化

正如Transformer架构在过去十年重塑了AI领域,MoE有望成为下一代高效智能系统的核心构建块。它不仅是扩大模型规模的手段,更代表了一种“专业化分工”的AI发展路径,为构建既强大又可持续的人工智能系统提供了可行方案。

在未来,我们可能会看到MoE原理被应用到更广泛的机器学习领域,甚至启发新的计算范式。无论如何,混合专家模型已经证明,在追求更大能力的同时,AI也可以变得更加高效和专业化——这对整个行业的健康发展至关重要。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?