你有没有过下面的经历?

凌晨12点,你还在为明天的需求评审会修改第7版原型,而竞争对手的新功能已悄然上线;

上午10点,你淹没在20个未读需求池条目和3份冲突的部门反馈中,却找不到决策依据;

下午3点,你发现刚上线的功能使用率不足2%,但没人能说清问题出在哪个环节;

……

据了解,产品经理日均工作时长9.2小时,但仅有31%的时间用于核心决策工作,高达69%的精力消耗在需求交接、文档修改、跨部门对齐等琐碎工作中。

但现在,DeepSeek让一切不同!

本文将通过10个实际工作的场景案例,带你见证如何用DeepSeek为工作流提速,实现2025年效率翻倍!

一、协助产品设计,让创意落地更高效

产品设计是从0到1的关键环节,涉及需求描述、需求分析、原型设计等多个方面。借助DeepSeek,产品经理可以快速梳理逻辑、优化流程,甚至生成初步设计方案,即使有时它的回复不能直接使用,也会给我们很多启发。

1、精准传递需求,减少沟通成本

当你想快速精准描述产品需求时,可以把需求甩给DeepSeek,让它帮你写清需求,并直接提供开发团队可执行的需求细节,让设计师、开发再也不会抱怨需求模糊,减少大量来回沟通的时间。

DeepSeek提示词:

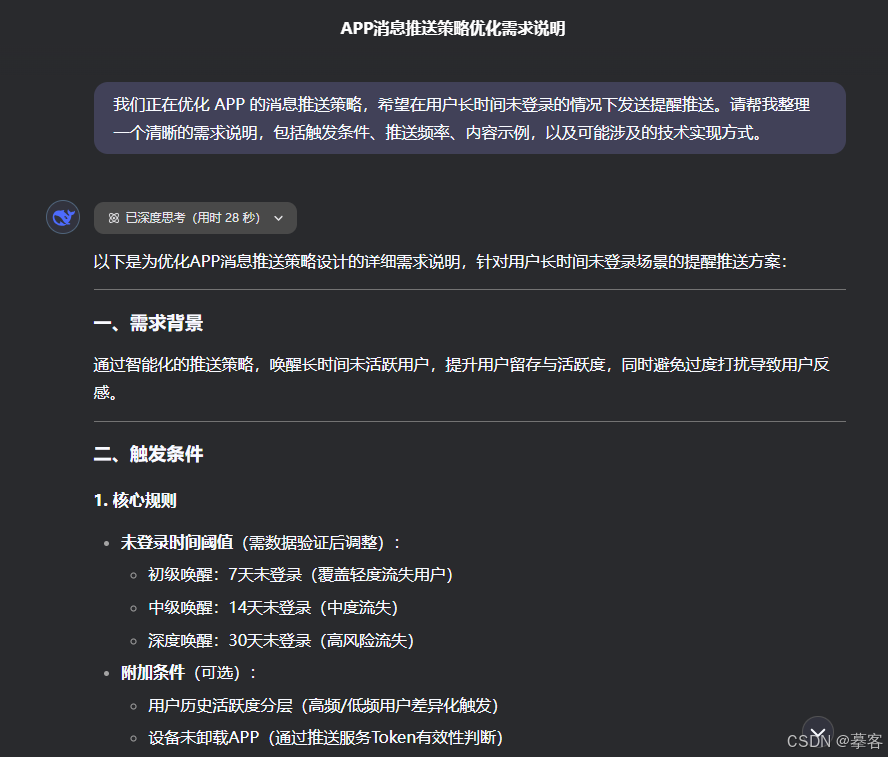

我们正在优化XX产品的XXX策略,请帮我整理一个清晰的需求说明,包括XXX条件。

*仅截图部分回复(下同)

2、设计产品原型,打开你的思路

你需要为产品的新页面、新功能模块设计原型,但不知道如何下手,或者思路局限在已有的设计模式里,缺乏创新。这时,你就可以求助DeepSeek,让它帮你描述清楚原型框架,或者输出多个设计方案供

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?