问题一

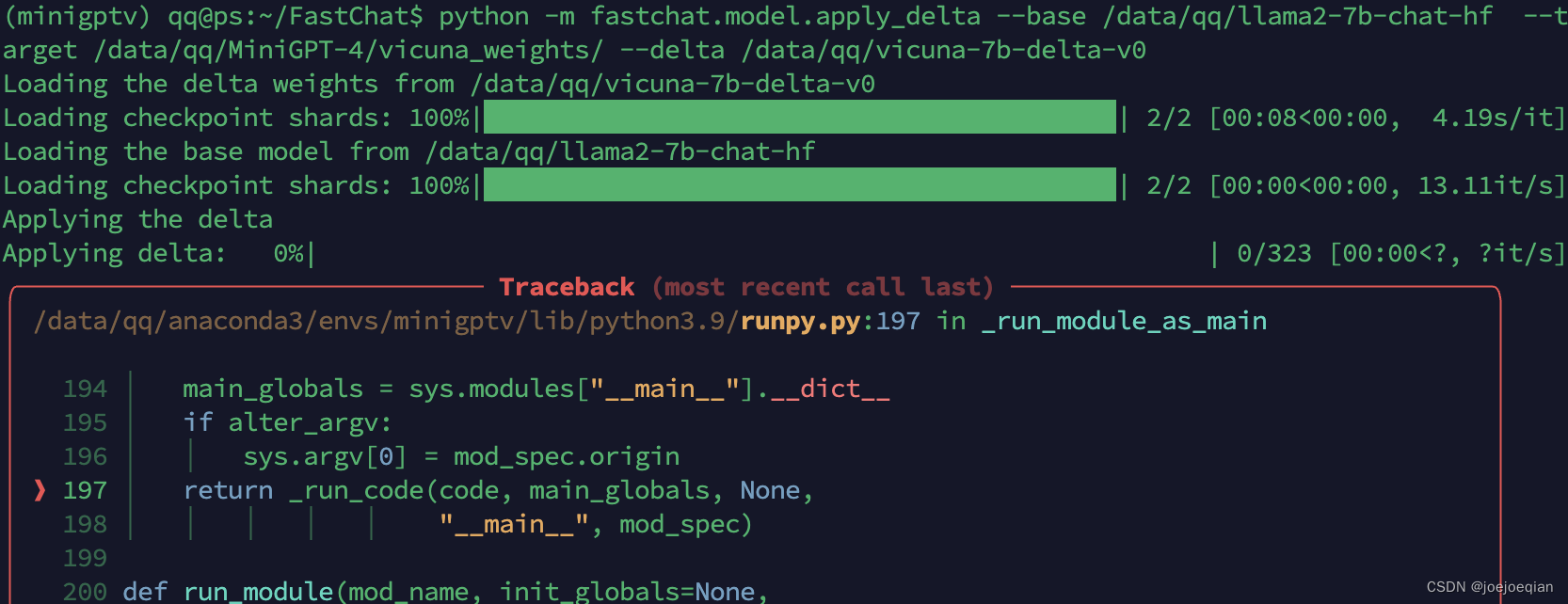

合并权重:

python -m fastchat.model.apply_delta --base /data/qq/llama2-7b-chat-hf --target /data/qq/MiniGPT-4/vicuna_weights/ --delta /data/qq/vicuna-7b-delta-v0

fastchat版本与模型版本 不兼容

解决方法:

第一种:用低版本fastchat

第二种:vicuna别用v0

问题二

HFValidationError: Repo id must use alphanumeric chars or '-', '_', '.', '--' and '..' are forbidden,

'-' and '.' cannot start or end the name, max length is 96: ''.

把模型权重路径中用’-'的全改了。

问题三

在web端测试时出现胡言乱语的情况

原因是:minigpt4/configs/models/minigpt4.yaml文件时,误将llama_model指向了vicuna的delta文件。

文章讨论了fastchat与特定模型(如MiniGPT-4的vicuna版本)之间的兼容性问题,包括如何处理不同版本fastchat与模型权重的合并,以及在web端测试中遇到的因配置错误导致的胡言乱语问题,着重于修改模型权重路径中的字符限制。

文章讨论了fastchat与特定模型(如MiniGPT-4的vicuna版本)之间的兼容性问题,包括如何处理不同版本fastchat与模型权重的合并,以及在web端测试中遇到的因配置错误导致的胡言乱语问题,着重于修改模型权重路径中的字符限制。

10万+

10万+