今天路上在浏览 Anthropic 的工程博客时,看到了一篇关于代码执行与 MCP 协议[1]结合的技术文章,读完之后感触颇深。

文章中提出的优化思路非常巧妙——通过让 AI Agent 编写代码与工具交互,而非传统的直接调用方式,竟然能将 Token 使用量降低 98.7%。这种「回归软件工程基本原理」的设计哲学,让我意识到在 AI Agent 快速发展的今天,我们或许过于关注模型能力的提升,而忽视了架构层面的优化空间。

因此,我将这篇文章的核心思想进行了深入解读和扩展,整理成这篇技术分析文章,作为目前在这方向探索的燃料。

一、AI Agent 正在遭遇「效率瓶颈」

当你让 AI Agent 连接数千个工具时,会发生什么?

答案可能出乎意料:在真正处理你的需求之前,Agent 可能已经消耗了数十万个 Token,仅仅用于加载工具定义。这就像一个工人在开工前,需要先阅读数千页工具说明书——效率低下且成本高昂。

根据 2025 年最新数据,全球 AI Agent 市场规模已突破 320 亿美元,IDC 预测该市场将保持高速增长。然而,随着 Agent 能力的提升,一个严峻的技术挑战正在浮现:上下文窗口的 Token 开销正在成为制约 AI Agent 大规模应用的核心瓶颈。

Anthropic 工程团队在最新发布的技术博客中,揭示了这个问题的严重性,并提出了一套革命性的解决方案。

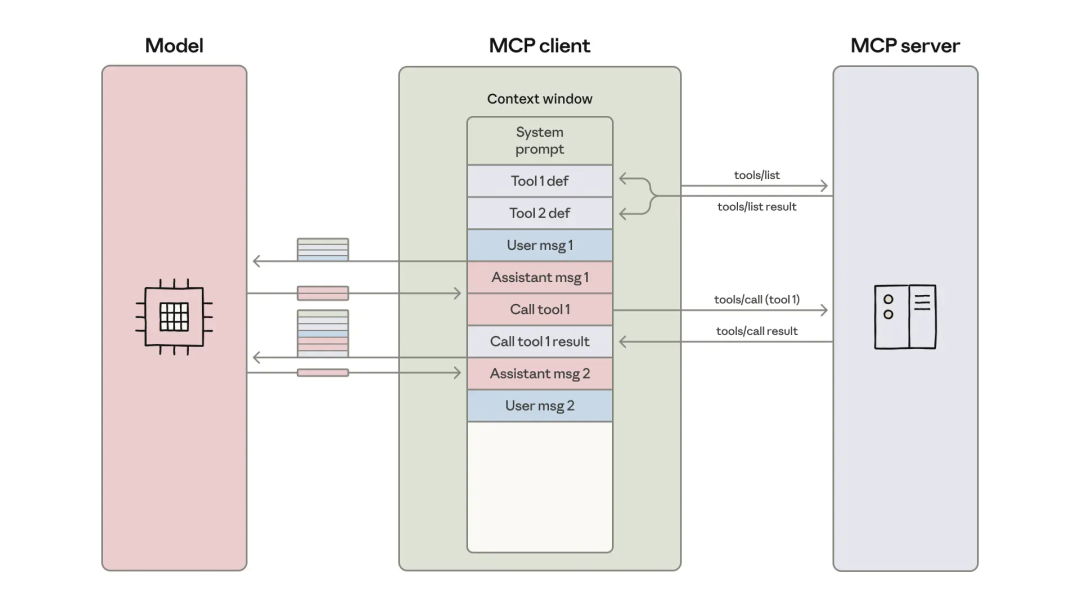

二、传统 MCP 架构的「两大效率陷阱」

陷阱 1:工具定义的 Token 黑洞

Model Context Protocol(MCP)作为 2024 年 11 月由 Anthropic 推出的开放标准,正在成为连接 AI Agent 与外部工具的核心基础设施。OpenAI、Google DeepMind、阿里云、腾讯云等国内外大厂在 2025 年已全面采纳 MCP 协议。

但传统 MCP 实现存在一个致命问题:所有工具定义必须预先加载到模型的上下文窗口中。

这意味着什么?当 Agent 连接到数千个工具时,可能需要处理数十万个 Token 的工具描述,然后才能开始阅读用户的实际请求。就像在餐厅点餐前,服务员非要你先读完整本菜单的详细说明——包括那些你根本不需要的菜品。

陷阱 2:中间结果的重复传输

更严重的问题在于,每次工具调用的结果都必须完整地流经模型的上下文窗口。

举个实际案例:假设你让 Agent 从 Google Drive 获取一份 2 小时会议的文字记录,然后将其附加到 Salesforce 的客户记录中。传统方式下,这份可能超过 50,000 个 Token 的会议记录,需要在上下文中流转两次——一次是读取,一次是写入。

Anthropic 团队指出,这种「中间结果膨胀」问题在复杂任务中尤为突出。研究显示,单次任务平均可能触发 50 次工具调用,如果所有结果都存入上下文,窗口会被迅速填满。

三、代码执行:重新定义 Agent 与工具的交互方式

Anthropic 提出的解决方案核心在于一个简单但强大的理念:让 Agent 通过编写代码与 MCP 服务器交互,而不是直接调用工具。

文件系统:渐进式发现工具的关键

开发者可以使用工具构建文件系统层次结构:

servers/

├── google-drive/

│ ├── getDocument.ts

│ └── index.ts

├── salesforce/

│ ├── updateRecord.ts

│ └── index.ts

Agent 可以像探索代码库一样浏览文件系统,只加载真正需要的工具定义。

这种方法带来的效果令人震撼:Token 使用量从 150,000 降至 2,000——节省 98.7%!

五大核心优势深度解析

1. 渐进式披露:按需加载工具

传统方式就像强制参会者记住所有人的名字,而新方式允许你在需要时再查找通讯录。模型能够高效导航文件系统,按需加载工具定义,大幅降低初始 Token 开销。

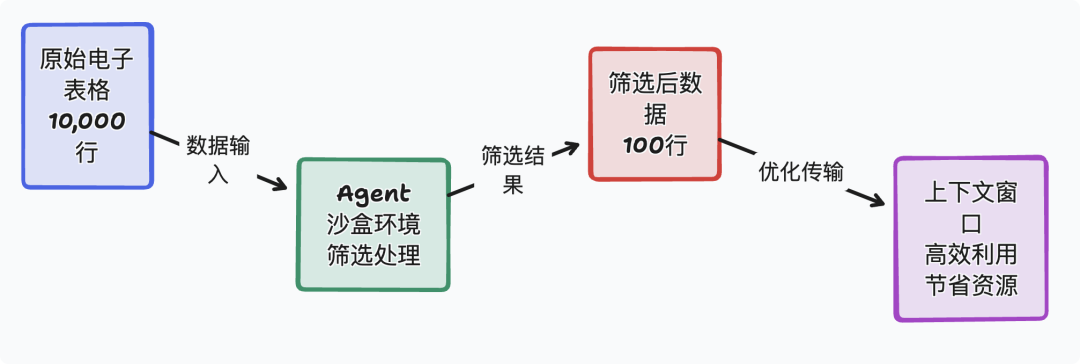

2. 上下文高效过滤:数据在执行环境中处理

这是最具革命性的特性之一。Agent 可以在执行环境中对数据进行过滤、转换和处理,只将最终结果返回给模型。

实际案例:处理一个 10,000 行的电子表格时,Agent 可以在沙盒环境中筛选出「待处理订单」,然后只返回筛选后的 100 行数据,而不是让整个表格占用上下文窗口。

根据研究数据,采用优化后的方法,可以将 Token 使用量降低 75% 以上——从 10,590 降至 2,336 个 Token。

3. 控制流:循环和条件的本地执行

在传统架构中,一个包含循环的任务需要多次往返模型:

-

• 第一次调用:执行第一次迭代

-

• 第二次调用:执行第二次迭代

-

• ……依此类推

而在代码执行环中,整个循环作为代码运行,无需每次迭代都与模型交互。这不仅降低了 Token 成本,还显著改善了延迟表现。

4. 隐私保护:敏感数据不进入模型上下文

这是企业级应用的关键需求。中间结果默认保留在执行环境中,敏感数据(如 PII 个人身份信息)可以自动进行 Token 化处理,在系统间流转而无需进入模型的上下文窗口。

安全研究显示,AI Agent 沙盒环境需要强隔离机制来避免越权与数据外泄。Anthropic 的方案通过将数据处理转移到沙盒环境,有效降低了数据泄露风险。

5. 状态持久化:任务断点续传与技能积累

Agent 可以将中间结果写入文件,实现工作的恢复和进度跟踪。更重要的是,Agent 还可以将可复用的代码保存为「技能」(skills),供未来任务使用。

这种机制类似于人类的学习过程——一次编写,多次复用,让 Agent 真正具备了「经验积累」的能力。

四、技术实现的关键考量

尽管代码执行方案带来了显著的效率提升,但 Anthropic 团队也坦承,这种方法并非没有成本。

安全沙箱:核心基础设施要求

代码执行需要安全的沙箱环境。主流方案包括:

-

• E2B:开源基础设施,提供快速启动(~150 毫秒)的 microVM,底层基于 AWS Firecracker 技术

-

• AIO Sandbox:国内首个兼容 E2B 接口的 Agent 沙箱,提供一体化、可定制的隔离环境

-

• 基于 Docker 的容器化架构:确保代码在安全隔离环境中运行

沙箱环境需要实现:

-

• 资源限制:CPU、内存、网络带宽的配额管理

-

• 动态熔断:对高危操作(进程注入、内存篡改)实施实时拦截

-

• 监控体系:跟踪上下文窗口 Token 占比、工具调用频次等关键指标

运维复杂度的权衡

相比直接工具调用,代码执行方案增加了运维复杂度:

-

• 沙箱环境的部署和维护

-

• 资源配额的动态调整

-

• 安全审计和日志分析

企业需要在效率收益与实施成本之间做出权衡。Anthropic 建议,对于需要处理大量工具或涉及敏感数据的应用场景,代码执行方案的长期收益将远超初期投入。

五、从「协议兼容」到「标准化时代」

Anthropic 的这项技术突破,标志着 AI Agent 发展正在进入新阶段。

MCP 生态的爆发式增长

2025 年第一季度,全球 MCP 相关投融资额同比增长 470%。阿里云百炼平台已集成 50 多款 MCP 服务,腾讯云大模型知识引擎也完成了 MCP 接入。

E2B 沙箱的月创建量在一年内从 4 万增长到 1500 万,增长 375 倍,充分印证了市场对高效 Agent 基础设施的迫切需求。

从助手到执行者的跨越

2025 年正在成为「AI Agent 执行元年」。模型不再局限于问答和内容生成,而是可以跨多个工具进行实时推理、行动和协助,真正承担起「执行者」的角色。

代码执行 + MCP 的组合,为这一跨越提供了技术支撑:

-

• 98.7% 的 Token 节省意味着 Agent 可以处理更复杂的任务

-

• 75% 以上的成本降低让大规模商业化应用成为可能

-

• 隐私保护机制满足了企业级部署的合规要求

软件工程经典模式的回归

Anthropic 团队特别强调,他们并非创造了全新的技术范式,而是将成熟的软件工程模式——代码执行、文件系统组织、数据过滤——应用到 AI Agent 领域。

这种「回归经典」的思路,恰恰体现了技术演进的智慧:真正的创新,往往来自于对基本原理的深刻理解和灵活应用。

六、对开发者的启示

Anthropic 的方案为 AI Agent 开发者提供了清晰的技术路线图:

-

1. 重新审视工具架构:不要简单地将所有工具暴露给模型,考虑通过文件系统进行组织

-

2. 拥抱代码执行:对于复杂数据处理任务,让 Agent 编写代码比链式调用工具更高效

-

3. 建立沙箱基础设施:尽早投资安全隔离环境,这是生产级 Agent 的必备条件

-

4. 监控 Token 使用:将上下文窗口视为稀缺资源,建立完善的监控和优化机制

-

5. 渐进式优化策略:从最耗费 Token 的场景入手,逐步应用代码执行方案

正如 Anthropic 所说:MCP 提供了连接 Agent 与工具的协议,但要实现大规模落地,必须解决 Token 效率问题。代码执行方案,正是这个问题的最优解之一。

引用链接

[1] 代码执行与 MCP 协议: https://www.anthropic.com/engineering/code-execution-with-mcp

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量

867

867

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?