在分布式系统与微服务架构盛行的当下,Spring Boot应用产生的日志数据量呈指数级增长。日志不仅是问题排查的"黑匣子",更是系统健康度监测、安全审计与性能优化的核心依据。然而,生产环境中因日志配置不当导致的存储爆炸、敏感信息泄露、调试信息缺失等问题频发。

环境:SpringBoot3.4.2

1. 简介

在分布式系统与微服务架构盛行的当下,Spring Boot应用产生的日志数据量呈指数级增长。日志不仅是问题排查的"黑匣子",更是系统健康度监测、安全审计与性能优化的核心依据。然而,生产环境中因日志配置不当导致的存储爆炸、敏感信息泄露、调试信息缺失等问题频发。为此,结合Spring Boot默认集成的Logback框架特性与行业最佳实践,梳理出涵盖框架选型、级别控制、结构化输出、性能优化等12条准则,助力开发者构建可观测、可维护、高性能的日志体系。

2.实战案例

2.1 可阅读的日志

许多开发人员的第一反应是:“日志是用来排查问题的。”但问题是:谁会来阅读这些日志呢?

大多数日志要么是被完全忽略,要么是在排除问题时才被翻阅。

当你编写每一行日志代码时,想象一下自己(或一位可怜的待命同事)在凌晨3点时,需要从茫茫日志之海中查找问题。

如下日志记录:

// 不佳的日志示例

log.info("处理开始");

//……大量业务逻辑……

log.info("处理结束");

// 改进后的日志

log.info("开始处理用户支付请求。用户ID={},订单ID={},金额={}", userId, orderId, amount);

//……业务逻辑……

log.info("用户支付请求处理完成。用户ID={},订单ID={},结果={}", userId, orderId, result);

2.2 含糊其词的技术建议:莫只说“多加些日志”

单纯增加日志并不总是解决问题的最佳方案,还需要考虑日志的内容、级别、输出位置等具体因素。

不加区分地随意记录日志,只会让有价值的信息湮没在茫茫日志之海中。我曾见过一个Java项目在短短5分钟内就生成了50MB的日志文件。打开一看,全是:

log.debug("Entering method A");

log.debug("Exiting method A");

log.debug("Entering method B");

log.debug("Exiting method B");

// ....

这并非日志记录,而是垃圾。记住,每一行日志记录都有代价:存储代价、I/O 代价,以及阅读它的代价。

2.3 用户视角与开发者视角

日志应该从谁的视角来编写呢?大多数日志都是从开发者的角度来编写的:

log.info("数据处理完成,准备添加到缓存.");

但真正有价值的日志应当融入业务视角:

log.info("User {}'s order {} status changed from {} to {}", userId, orderId, oldStatus, newStatus);

此类日志不仅技术人员能够理解,产品和运维同事也能普遍看懂,这对跨团队沟通至关重要。

2.4 错误的使用ERROR级别日志

大多数开发人员在catch块中机械地编写以下内容:

try {

// TODO

} catch (Exception e) {

log.error("处理失败, {}", e);

}

但这种情况可能是错误的!许多异常都是预期内的业务异常,而非系统错误。例如,用户输入错误密码属于业务逻辑事件,而非ERROR级别的系统故障。

try {

userService.login(username, password);

} catch (InvalidCredentialsException e) {

// 这是预期内的业务场景,应使用INFO级别来记录它

log.info("User {} 登录失败: 错误的密码", username) ;

return ... ;

} catch (Exception e) {

// 这是意外异常,应使用ERROR级别来记录它

log.error("用户 {} 在登录过程中发生了系统异常, {}", username, e);

return ... ;

}

如何正确定义日志级别的边界? 一个简单准则:

- ERROR:需要人工干预的问题

- WARN:若今天不处理,明天可能会演变成ERROR的问题

- INFO:标记重要的业务里程碑,以帮助了解系统的运行状态

- DEBUG/TRACE:用于临时故障排查;通常在生产环境中禁用

不同环境的日志级别策略

- 开发环境:DEBUG或更详细级别,以帮助开发人员调试

- 测试环境:INFO级别,重点关注业务流程是否正确。

- 生产环境:根据系统规模和性能要求,选择WARN或INFO级别。

logging:

level:

root: WARN

com.pack.business: INFO

com.pack.other: ERROR

2.5 避免在循环中记录日志

// 错误实践

for (Item item : items) {

logger.info("Processing item: {}", item); // 可能输出数千行日志

}

// 改进版本

logger.info("准备处理 {} 项数据", items.size());

// 处理逻辑

logger.info("完成处理 {} 项数据. 成功={}, 失败={}", items.size(), successCount, failCount);

2.6 使用占位符而非字符串拼接

// 错误的做法

log.debug("正在处理用户:" + user.getName() + ",ID:" + user.getId());

// 正确的做法

log.debug("正在处理用户:{},ID:{}", user.getName(), user.getId());

只有在日志级别启用时才会计算参数,避免无谓的字符串拼接开销。

2.7 请谨慎处理大型对象的日志记录:

// 危险操作(可能输出大量无用信息)

log.debug("User data: {}", user);

// 最佳操作

log.debug("User basic info: id={}, name={}, type={}", user.getId(), user.getName(), user.getType());

- 对敏感数据使用日志掩码工具

- 引入 SLF4J 的 MDC(映射诊断上下文)机制,以关联来自同一请求的日志

- 定期清理不再使用的日志

- 使用断言来检查是否需要打印复杂的日志

if (log.isDebugEnabled()) {

log.debug("复杂对象详细信息: {}", calcInfo(obj)) ;

}

2.8 敏感信息处理

这是最容易被忽视的问题,但也可能导致最严重的后果。请务必从日志中删除以下内容:

- 密码、密钥、TOKEN

- 身份证号、电话号码、银行卡号

- 用户地址及其他个人信息

// 危险日志

log.info("User login: username={}, password={}", username, password);

// 安全日志

log.info("User login: username={}, password=****", username);

// 使用工具特殊处理

log.info("User info: {}", LogSensitiveUtils.mask(userInfo));

2.9 JSON日志格式

首先,引入如下依赖:

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>8.0</version>

</dependency>

配置logback-spring.xml

<appender name="TRACEX" class="ch.qos.logback.core.ConsoleAppender">

<encoder class="net.logstash.logback.encoder.LogstashEncoder"/>

</appender>

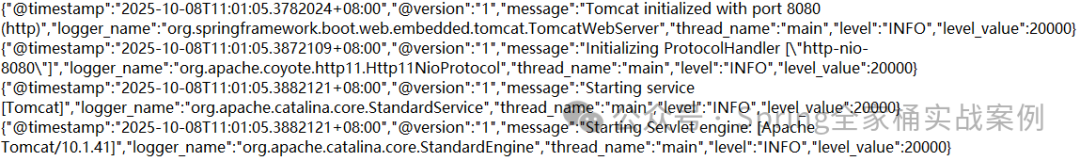

运行结果

2.10 异步日志记录

日志记录是一项典型的 I/O 密集型操作。主要的性能瓶颈包括:

- 磁盘 I/O(写入速度受限)

- 文件系统缓存

- 字符串处理(格式化、拼接)

- 线程同步(在多线程环境中)

测试表明,大量的日志记录会使应用程序的吞吐量降低 30% 至 50%!

<appender name="ASYNC" class="ch.qos.logback.classic.AsyncAppender">

<appender-ref ref="TRACEX" />

<queueSize>512</queueSize>

<discardingThreshold>0</discardingThreshold>

<includeCallerData>false</includeCallerData>

</appender>

2.11 高并发下的日志记录

抽样日志记录:仅记录部分请求的详细信息。如下示例:

// 简单的采样实现

if (Math.random() < 0.01) { // 1% 的采样率

logger.info("详细请求信息:request={}, headers={}", request, headers);

}

- 批量日志记录:将多个日志项合并为单个写入操作

- 异步非阻塞日志记录:使用像Disruptor这样的高性能队列

- 日志缓冲区调优:增大缓冲区大小以降低磁盘刷新的频率

2.12 日志轮换与归档策略

日志文件无法无限增长。必须制定轮换策略:

<appender name="FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>app.log</file>

<rollingPolicy

class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">

<fileNamePattern>app-%d{yyyy-MM-dd}.%i.log</fileNamePattern>

<maxFileSize>100MB</maxFileSize>

<maxHistory>30</maxHistory>

<totalSizeCap>3GB</totalSizeCap>

</rollingPolicy>

<encoder>

<pattern>%d %p %c{1} [%t] %m%n</pattern>

</encoder>

</appender>

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量

1176

1176

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?