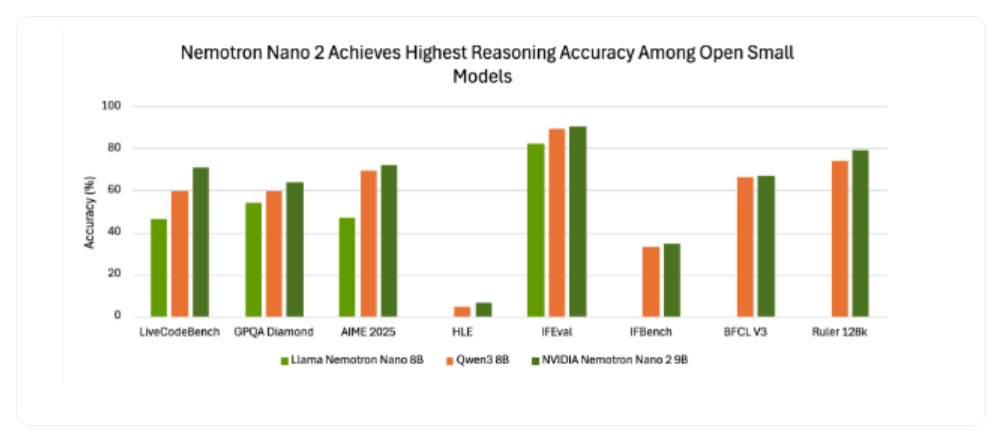

英伟达发布了其最新的小型语言模型(SLM)——Nemotron-Nano-9B-V2。该模型在多个基准测试中表现出色,并在特定测试中达到了同类产品的最高水平。

Nemotron-Nano-9B-V2 的参数量为 90 亿,虽然比一些数百万参数的微型模型要大,但它比之前的 120 亿参数版本显著减小,并专门针对单个英伟达 A10GPU 进行了优化。英伟达 AI 模型后训练总监 Oleksii Kuchiaev 解释说,这种调整是为了适配 A10 这款热门的部署 GPU。此外,Nemotron-Nano-9B-V2 是一款混合模型,能处理更大的批次,速度比同等规模的 Transformer 模型快 6 倍。

该模型支持多达九种语言,包括中、英、德、法、日、韩等,并擅长处理指令跟踪和代码生成任务。其预训练数据集和模型本身都已在 Hugging Face 和英伟达的模型目录中提供。

融合 Transformer 与 Mamba 架构

Nemotron-Nano-9B-V2 基于 Nemotron-H 系列,该系列融合了 Mamba 和 Transformer 架构。传统的 Transformer 模型虽然强大,但在处理长序列时会消耗大量内存和计算资源。而 Mamba 架构则引入了选择性状态空间模型(SSM),能够以线性复杂度处理长信息序列,从而在内存和计算开销上更具优势。Nemotron-H 系列通过用线性状态空间层替换大部分注意力层,在长上下文处理上实现了 2-3 倍的吞吐量提升,同时保持了高精度。

独特的推理控制功能

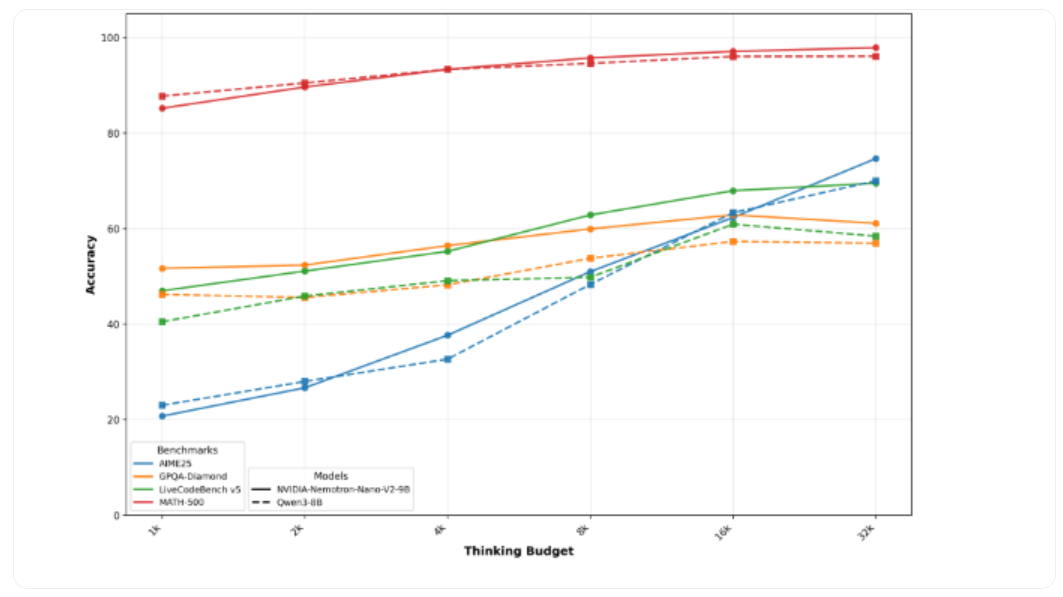

这款模型的一大创新是其内置的 “推理” 功能,允许用户在模型输出最终答案前进行自我检查。用户可以通过简单的控制符(如 /think 或 /no_think)来开启或关闭此功能。模型还支持运行时 “思考预算” 管理,开发者可以限制用于内部推理的令牌数量,从而在准确性和延迟之间取得平衡。这对于客户支持或自主代理等对响应速度有要求的应用场景尤为关键。

英伟达根据其开放模型许可协议发布了 Nemotron-Nano-9B-V2,该协议对企业友好且高度宽松。英伟达明确表示,企业可以自由地将该模型用于商业用途,并且无需为使用该模型支付费用或版税。

尽管如此,协议仍有一些核心要求,例如用户必须遵守内置的安全机制、在重新分发模型时进行归属标注,并遵守相关法律法规。英伟达表示,该协议旨在确保负责任和合乎道德的使用,而不是通过限制商业规模来盈利。这使得 Nemotron-Nano-9B-V2 成为了那些希望在降低成本和延迟的同时,保持高精度的企业开发者的理想选择。

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量

890

890

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?