LazyLLM Agent简介

LazyLLM Agent 是基于商汤科技研发的 LazyLLM 框架构建的智能体应用。LazyLLM 是一个开源、低代码的大模型应用开发框架,旨在为大模型应用提供快速、高效、低门槛的构建路径。以下是关于 LazyLLM Agent 的简介:

LazyLLM Agent 是基于商汤科技研发的 LazyLLM 框架构建的智能体应用。LazyLLM 是一个开源、低代码的大模型应用开发框架,旨在为大模型应用提供快速、高效、低门槛的构建路径。以下是关于 LazyLLM Agent 的简介:

LazyLLM 框架优势

低代码组装:LazyLLM 预置了 “数据流 + 功能模块”,无需了解大模型底层知识,就能像搭积木一样将 “生成大纲、逐段写作、结果拼接、对外服务” 等模块串起来构建应用,若需要多个 Agent,复制或串联模块即可,成本低且容错友好。

一键部署:在验证阶段,只需一套轻量网关就能把多 Agent 各子模块串起来,上线时,一键打镜像,借助 k8s 网关、负载均衡、容错机制,就能让服务稳定运行。

模型微调省心:LazyLLM 会按场景自动选择合适的微调框架和参数切分方式,减少工程细节负担,让算法同学能专注于 “数据打磨与策略优化”。

LazyLLM Agent 应用示例

打工人述职 Agent:可以通过输入 OKR 和一周的工作内容生成周报,输入 OKR 和若干周的周报生成季度 / 年度述职报告,将写周报和述职报告从纯体力活变成了标准流程。

代码文档生成 Agent:能够扫描本地 Python 文件,自动生成函数注释和 API 文档,还可以将注释直接写入源代码中,实现 “代码即文档” 的效果。

个性化学习助手智能体:结合 RAG 技术,通过文档加载、检索组件配置及大模型调用,能自动生成高质量习题和教学计划。

环境部署

打开终端(以anaconda为例)

输入下列代码

pip install lazyllm -i https://pypi.tuna.tsinghua.edu.cn/simple # python3.10为例

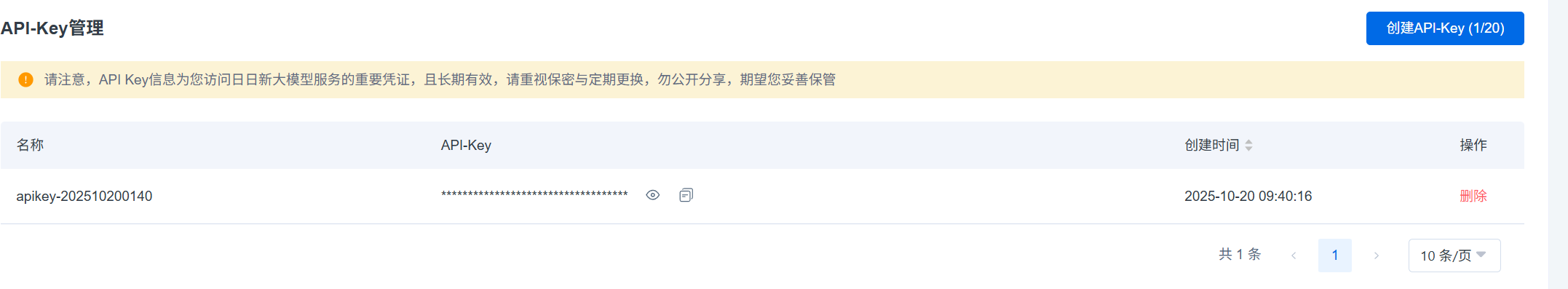

完成后进行模型API的选择与配置

在https://console.sensecore.cn/进行申请

注册后完成登录

windows 配置环境变量方法

- 右键点击"此电脑"或"我的电脑",选择"属性"

- 点击"高级系统设置"

- 在"系统属性"窗口中点击"环境变量"

- 在"系统变量"或"用户变量"区域点击"新建"

- 输入变量名(如`LAZYLLM_SENSENOVA_API_KEY`)和变量值(您的"API密钥")

- 点击"确定"保存

- 点击"确定"关闭所有窗口

- 重新启动命令提示符以使更改生效

采用以下代码来简单验证部署

import json

from lazyllm import ReactAgent, fc_register, LOG, OnlineChatModule, WebModule

# 天气数据字典

WEATHER_DATA = {

"北京": {

"province": "北京市",

"city": "北京",

"publish_time": "2024-01-15 08:00:00",

"weather": "晴天",

"wind": "西北风 3-4级",

"sunriseSunset": "日出: 07:30, 日落: 17:20",

"temperature": "5°C / -3°C"

},

"上海": {

"province": "上海市",

"city": "上海",

"publish_time": "2024-01-15 08:00:00",

"weather": "阴天",

"wind": "东南风 2-3级",

"sunriseSunset": "日出: 07:00, 日落: 17:30",

"temperature": "12°C / 8°C"

},

"广州": {

"province": "广东省",

"city": "广州",

"publish_time": "2024-01-15 08:00:00",

"weather": "雨天",

"wind": "南风 4-5级",

"sunriseSunset": "日出: 07:10, 日落: 18:00",

"temperature": "18°C / 15°C"

}

}

@fc_register("tool")

def get_weather(city: str):

"""

天气查询。

Args:

city: 城市名(中文),当前仅支持北京、上海、广州

Returns: 当地当天的天气信息

"""

try:

# 从字典中查找天气数据

if city in WEATHER_DATA:

res = WEATHER_DATA[city]

return json.dumps(str(res), ensure_ascii=False)

else:

return f"抱歉,暂时无法查询到 {city} 的天气信息。目前支持的城市有:北京、上海、广州"

except Exception as e:

message = f"[Tool - get_weather] error occur, city: {city}, error: {str(e)[:512]}"

LOG.error(message)

return message

prompt = """

【角色】

你是一个出行建议助手,能够根据用户给定的城市名称主动查询天气信息,并给出出行建议。

【要求】

1. 根据用户的输入,调用工具查询当地天气情况

2. 城市名称为中文

3. 出行建议可以推荐一些活动

4. 目前支持的城市:北京(晴天)、上海(阴天)、广州(雨天)

"""

agent = ReactAgent(

llm=OnlineChatModule(source='sensenova',stream=False,model='DeepSeek-V3-1'),

tools=['get_weather'],

prompt=prompt,

stream=False

)

# 前端页面

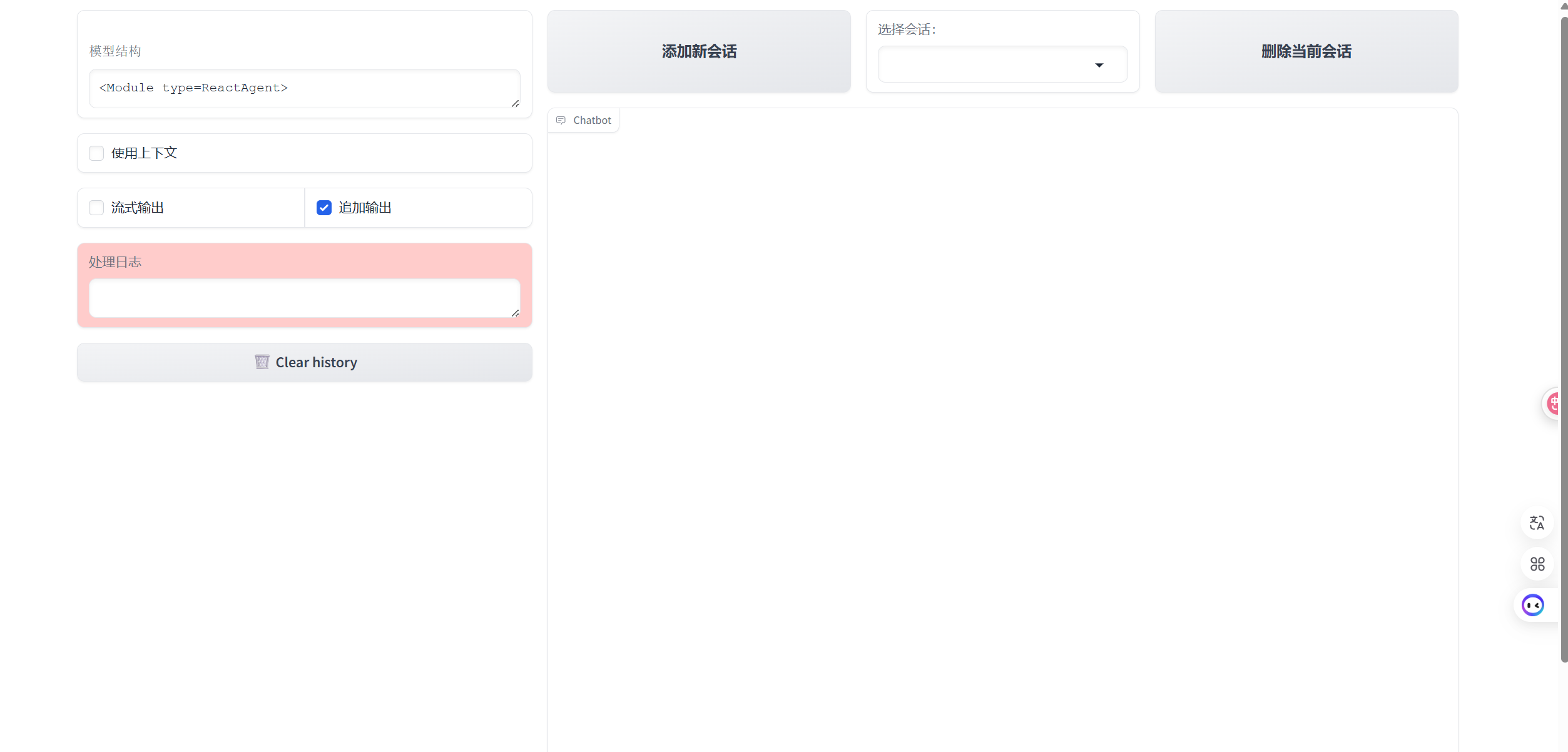

w = WebModule(agent, port=8846, title="ReactAgent")

w.start().wait()

至此简单的部署完成

LazyLLM Agent框架初体验

LazyLLM Agent框架初体验

2万+

2万+