一、为什么我们需要自定义分词器

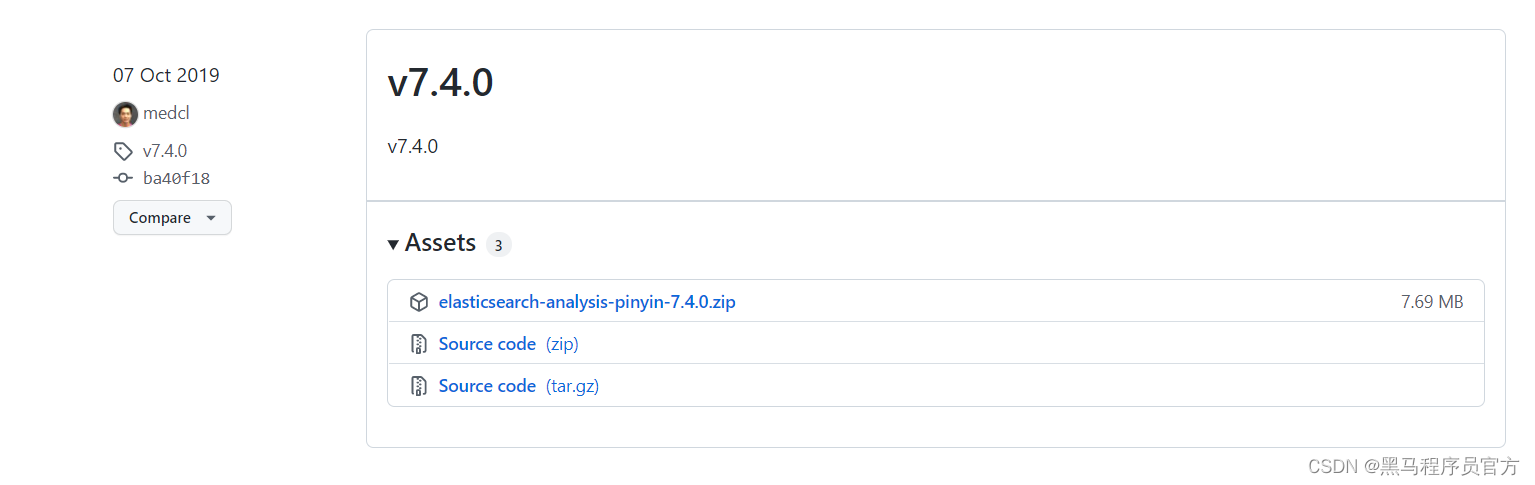

1.1 安装拼音分词器

要实现拼音分词检索,就必须对文档按照拼音分词。在

GitHub

上恰好有

elasticsearch

的拼音分词插件。

地址:

https://github.com/medcl/elasticsearch-analysis-pinyin

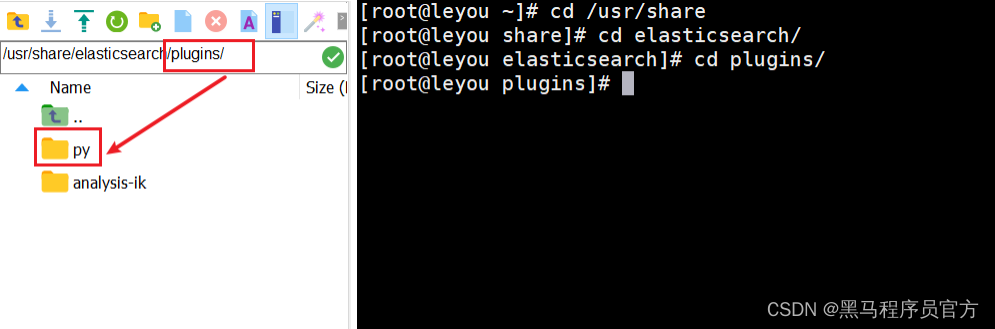

把yinpin分词器拷贝到es的/plugins目录里面

重启es的容器:

docker restart elasticsearch测试拼音分词器是否起作用:

POST _analyze

{

"text": "长隆大马戏",

"analyzer": "pinyin"

}结果:

<

本文介绍了为何需要自定义分词器,以满足特定的拼音检索需求。通过示例展示了如何在Elasticsearch中安装和测试拼音分词器,但发现其默认行为并不符合期望。接着,探讨了Elasticsearch中分词器的组成,包括字符过滤器、分词器和过滤器。为了达到基于ik分词器的拼音检索,文章提出了自定义分词器的解决方案,详细解释了自定义分词器的配置参数及其作用。通过自定义分词器,可以实现更精准的拼音检索功能。

本文介绍了为何需要自定义分词器,以满足特定的拼音检索需求。通过示例展示了如何在Elasticsearch中安装和测试拼音分词器,但发现其默认行为并不符合期望。接着,探讨了Elasticsearch中分词器的组成,包括字符过滤器、分词器和过滤器。为了达到基于ik分词器的拼音检索,文章提出了自定义分词器的解决方案,详细解释了自定义分词器的配置参数及其作用。通过自定义分词器,可以实现更精准的拼音检索功能。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

715

715

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?