线程模型基本介绍

不同的线程模式,对程序的性能有很大影响,在学习Netty线程模式之前,首先讲解下 各个线程模式, 最后看看 Netty 线程模型有什么优越性.目前存在的线程模型有:

(1)传统阻塞 I/O 服务模型

(2)Reactor 模型

根据 Reactor 的数量和处理资源池线程的数量不同,有 3 种典型的实现:

单 Reactor 单线程

单 Reactor 多线程

主从 Reactor 多线程

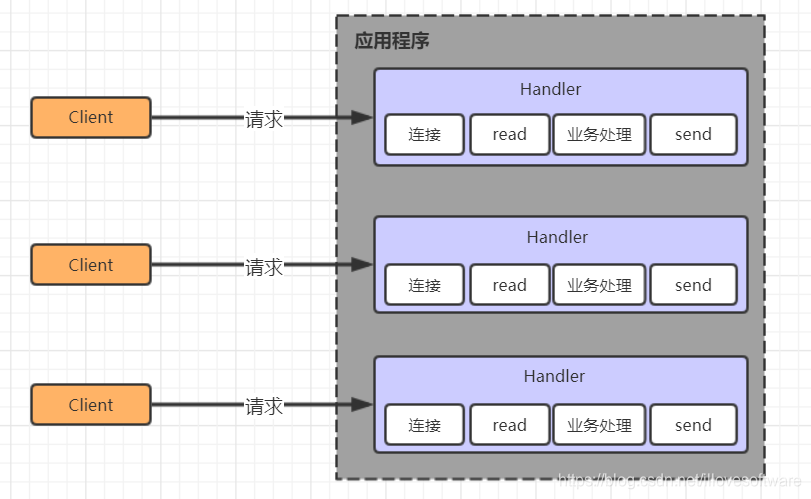

传统阻塞 I/O 服务模型

采用阻塞 IO 模式获取输入的数据, 每个连接都需要独立的线程完成数据的输入 , 业务处理和数据返回工作。

存在问题:

1. 当并发数很大,就会创建大量的线程,占用很大系统资源。

2. 连接创建后,如果当前线程暂时没有数据可读,该线程会阻塞在 read 操作,造成线程资源浪费。

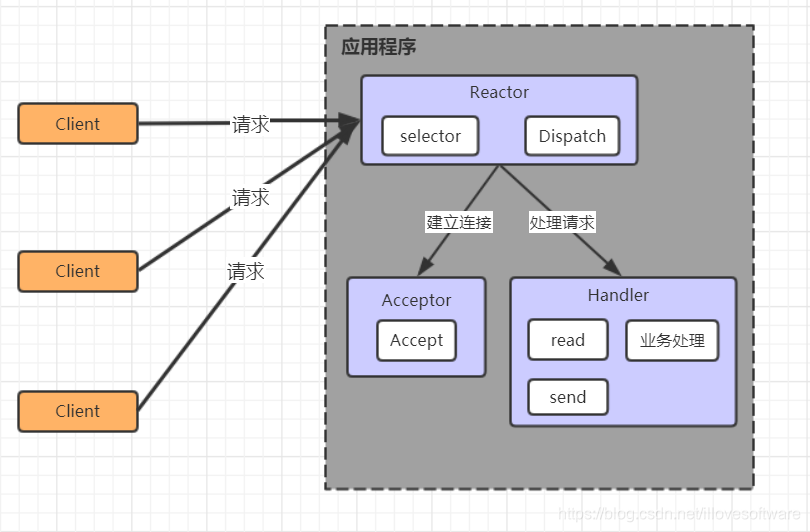

Reactor 模型

Reactor 模式,通过一个或多个输入同时传递给服务处理器的模式 , 服务器端程序处理传入的多个请求,并将它们同步分派到相应的处理线程, 因此 Reactor 模式也叫 Dispatcher模式. Reactor 模式使用IO 复用监听事件, 收到事件后,分发给某个线程(进程), 这点就是网络服务器高并发处理关键。

单 Reactor 单线程

1.Selector是可以实现应用程序通过一个阻塞对象监听多路连接请求。

2.Reactor 对象通过 Selector监控客户端请求事件,收到事件后通过 Dispatch 进行分发。

3.是建立连接请求事件,则由 Acceptor 通过 Accept 处理连接请求,然后创建一个 Handler 对象处理连接完成后的后续业务处理。

4.Handler 会完成 Read→业务处理→Send 的完整业务流程。

优点:模型简单,没有多线程、进程通信、竞争的问题,全部都在一个线程中完成。

缺点:

1. 性能问题: 只有一个线程,无法完全发挥多核 CPU 的性能。Handler 在处理某个连接上的业务时,整个进程无法处理其他连接事件,很容易导致性能瓶颈。

2. 可靠性问题: 线程意外终止或者进入死循环,会导致整个系统通信模块不可用,不能接收和处理外部消息,造成节点故障。

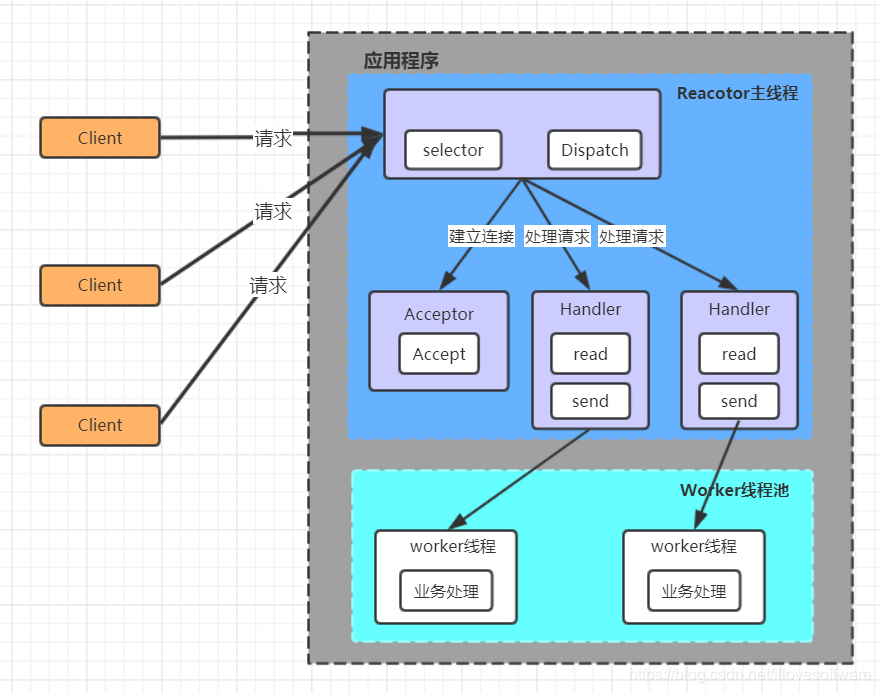

单 Reactor多线程

1.Reactor 对象通过 selector 监控客户端请求事件, 收到事件后,通过 dispatch 进行分发

2.如果建立连接请求, 则右 Acceptor 通过accept 处理连接请求。

3.如果不是连接请求,则由 reactor 分发调用连接对应的 handler 来处理。

4.handler 只负责响应事件,不做具体的业务处理, 通过 read 读取数据后,会分发给后面的

worker 线程池的某个线程处理业务。

5.worker 线程池会分配独立线程完成真正的业务,并将结果返回给 handler。

6.handler 收到响应后,通过 send 将结果返回给 client。

优点:

可以充分的利用多核 cpu 的处理能力。

缺点:

多线程数据共享和访问比较复杂, reactor 处理所有的事件的监听和响应,在单线程运行, 在高并发场景容易出现性能瓶颈。

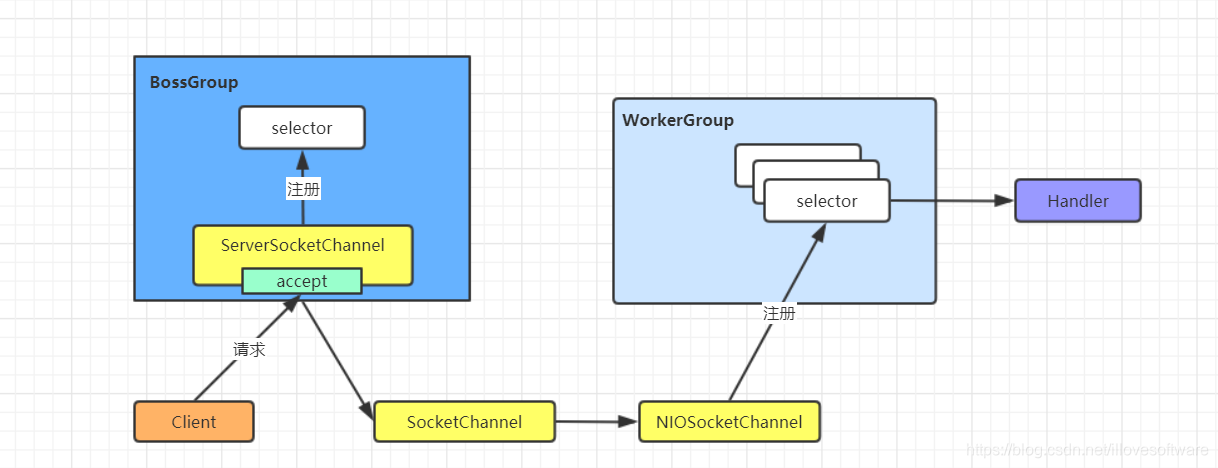

Netty线程模型

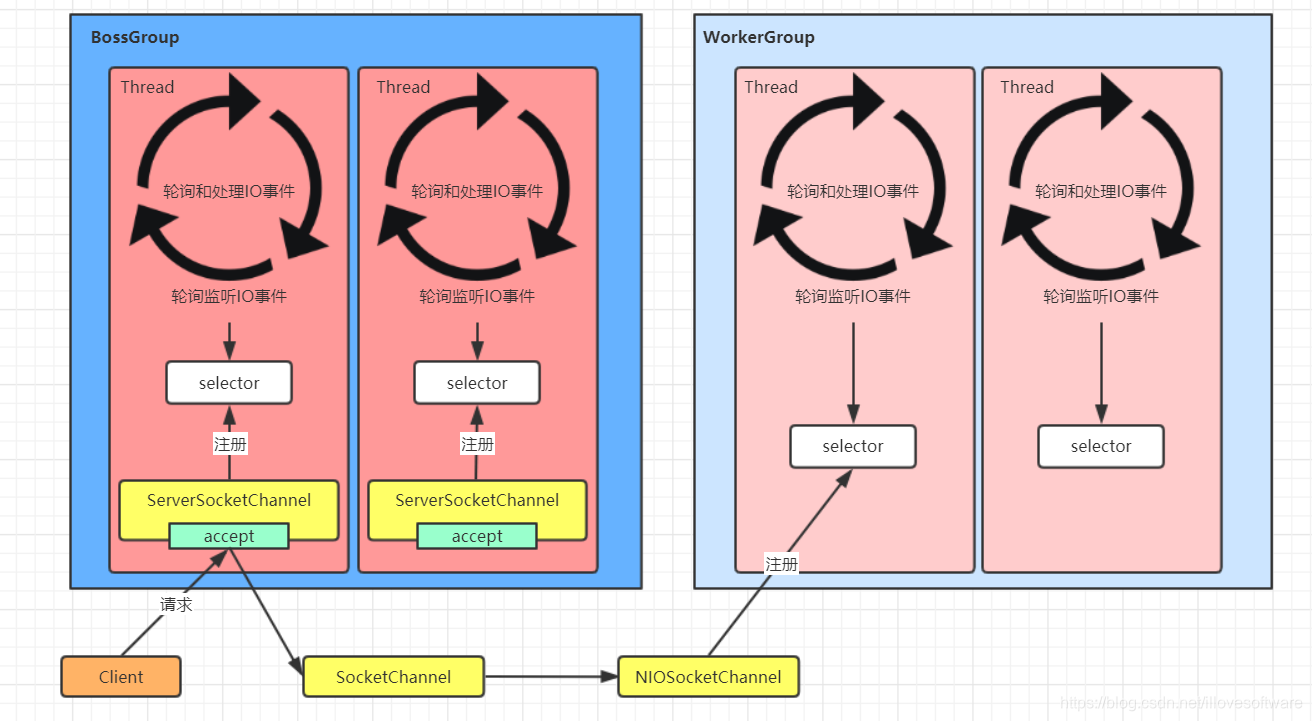

Netty 的设计主要基于主从 Reactor 多线程模式,并做了一定的改进。

1. 简单版Netty模型

1.BossGroup 线程维护 Selector,ServerSocketChannel 注册到这个 Selector 上,只关注连接

建立请求事件(主 Reactor)。

2.当接收到来自客户端的连接建立请求事件的时候,通过 ServerSocketChannel.accept 方法获得对应的 SocketChannel,并封装成 NioSocketChannel 注册到 WorkerGroup 线程中的

Selector,每个 Selector 运行在一个线程中(从 Reactor)。

3.当 WorkerGroup 线程中的 Selector 监听到自己感兴趣的 IO 事件后,就调用 Handler 进行处理。

2. 进阶版Netty模型

1.有两组线程池:BossGroup 和 WorkerGroup,BossGroup 中的线程专门负责和客户端建立

连接,WorkerGroup 中的线程专门负责处理连接上的读写。

2.BossGroup 和 WorkerGroup 含有多个不断循环的执行事件处理的线程,每个线程都包含一个 Selector,用于监听注册在其上的 Channel。

3.每个 BossGroup 中的线程循环执行以下三个步骤

一.轮训注册在其上的 ServerSocketChannel 的 accept 事件(OP_ACCEPT 事件)。

二.处理 accept 事件,与客户端建立连接,生成一个 NioSocketChannel,并将其注册到

WorkerGroup 中某个线程上的 Selector 上。

三.再去以此循环处理任务队列中的下一个事件。

4.每个 WorkerGroup 中的线程循环执行以下三个步骤

一.轮训注册在其上的 NioSocketChannel 的 read/write 事件(OP_READ/OP_WRITE 事

件)

二.在对应的 NioSocketChannel 上处理 read/write 事件

三.再去以此循环处理任务队列中的下一个事件

本文介绍了线程模型的基本概念,对比了传统阻塞I/O服务模型与Reactor模型的不同之处,重点阐述了Netty线程模型的设计原理,包括其主从Reactor多线程模式及其优劣。

本文介绍了线程模型的基本概念,对比了传统阻塞I/O服务模型与Reactor模型的不同之处,重点阐述了Netty线程模型的设计原理,包括其主从Reactor多线程模式及其优劣。

648

648

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?