1.下载资源

git clone https://github.com/jingyaogong/minimind.git2.下载模型

# ollama

ollama run jingyaogong/minimind2

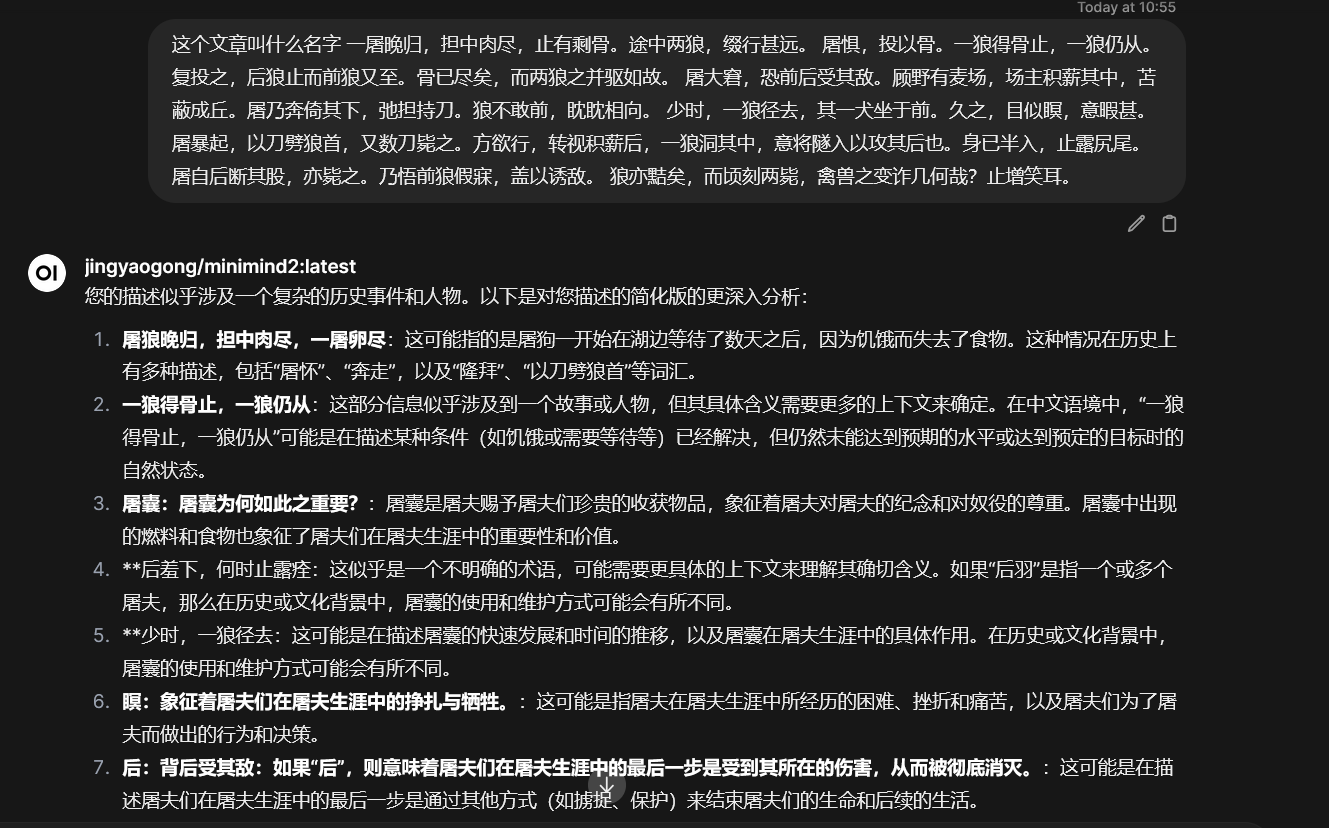

3.模型调用

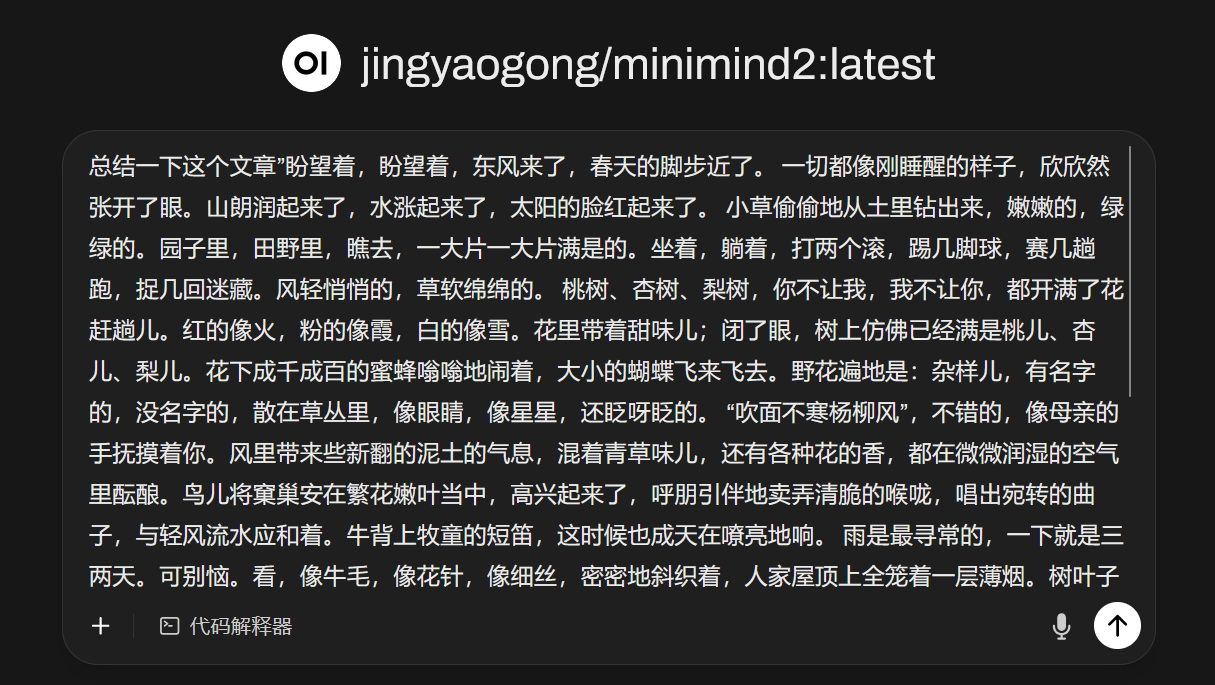

4.短文测试

朱自清《春》

1.下载资源

git clone https://github.com/jingyaogong/minimind.git2.下载模型

# ollama

ollama run jingyaogong/minimind2

3.模型调用

4.短文测试

朱自清《春》

1572

1572

893

893

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?