前面购买好阿里云机器后,接下来进行集群机器间的互信任操作

购买配置请参考

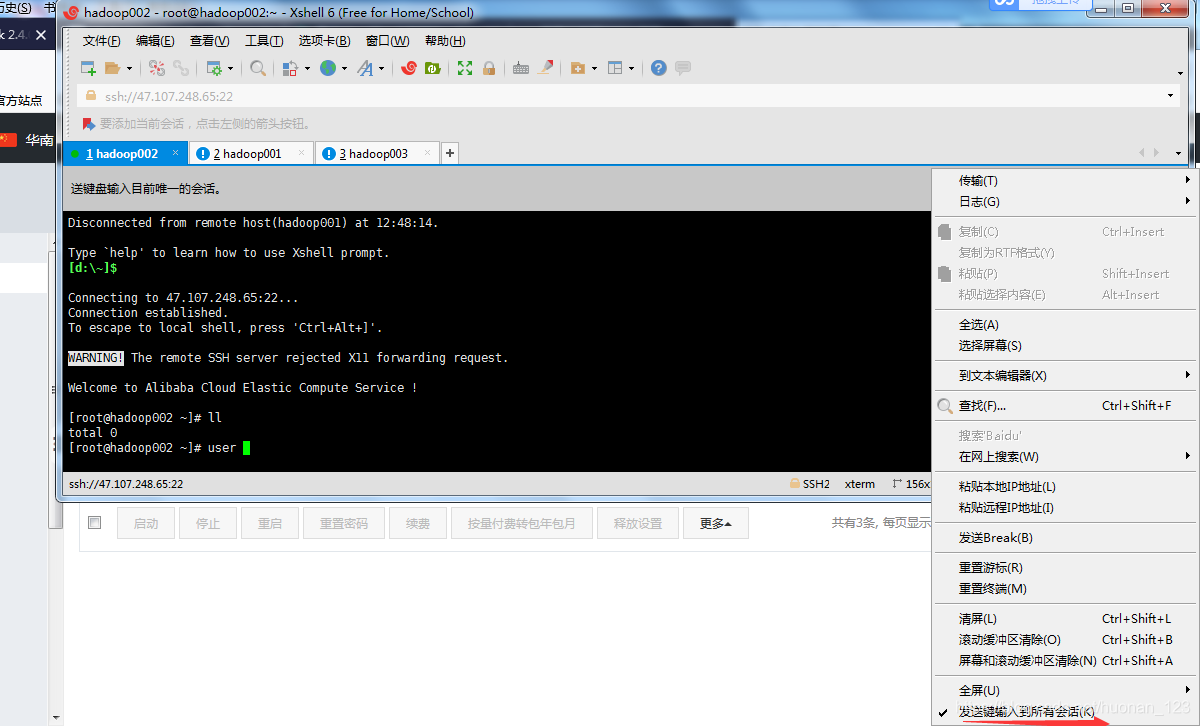

- 小技巧 在xshell中同时操作多个窗口(鼠标右键,选择如下如图箭头所示)

- 创建用户

[root@hadoop002 ~]# useradd hadoop

- 上传文件(root)

[root@hadoop001 software]$ ll

total 509828

-rw-r--r-- 1 root root 311585484 Nov 26 14:23 hadoop-2.6.0-cdh5.7.0.tar.gz

-rw-r--r-- 1 root root 173271626 Nov 26 14:23 jdk-8u45-linux-x64.gz

-rw-r--r-- 1 root root 37191810 Nov 26 14:23 zookeeper-3.4.13.tar.gz

- 复制到每台机器上

scp root@ip/home/hadoop/software

[hadoop@hadoop001 software]$ hostname -i

172.18.97.104

[hadoop@hadoop001 software]$ scp root@172.18.97.104/home/hadoop/software

- 修改上传软件权限

[root@hadoop001 ~]# chown -R hadoop:hadoop /home/hadoop/software/*

- 修改hosts文件

[root@hadoop001 ~]# vim /etc/hosts

172.18.97.104 hadoop001 hadoop001

172.18.97.106 hadoop002 hadoop002

172.18.97.105 hadoop003 hadoop003

阿里云集群互信任配置

阿里云集群互信任配置

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1590

1590

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?