一、前言

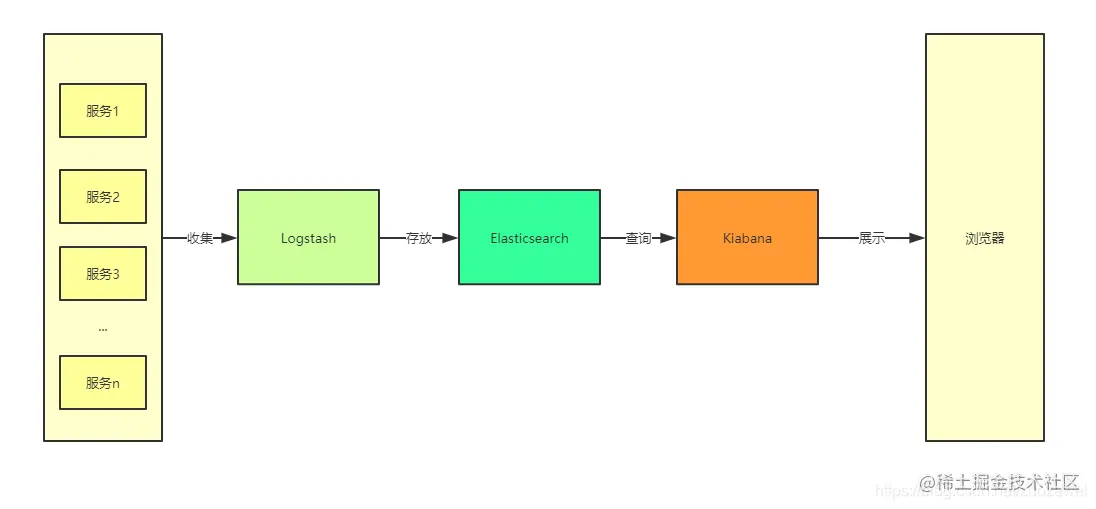

ELK 即 Elasticsearch、Logstash、Kibana,组合起来可以搭建线上日志系统,本文主要讲解使用 ELK 来收集测试框架产生的日志。

二、ELK 中各个服务的作用

- Elasticsearch:用于存储收集到的日志信息;

- Logstash:用于收集日志,测试框架应用整合了 Logstash 以后会把日志发送给 Logstash,Logstash再把日志转发给Elasticsearch;

- Kibana:通过Web端的可视化界面来查看日志。

三、使用 Docker Compose 搭建 ELK 环境

1、需要下载的 Docker 镜像

docker pull elasticsearch:7.6.2

docker pull logstash:7.6.2

docker pull kibana:7.6.2

复制代码2、搭建前准备

Docker Compose是一个用于定义和运行多个docker容器应用的工具。使用Compose你可以用YAML文件来配置你的应用服务,然后使用一个命令,你就可以部署你配置的所有服务了。

2.1、下载 Docker Compose

curl -L https://get.daocloud.io/docker/compose/releases/download/1.24.0/docker-compose-`uname -s`-`uname -m` > /usr/local/bin/docker-compose

复制代码2.2、修改该文件的权限为可执行

chmod +x /usr/local/bin/docker-compose

复制代码2.3、查看是否已经安装成功

docker-compose --version

复制代码3、开始搭建

3.1、创建一个存放 logstash 配置的目录并上传配置文件

logstash-springboot.conf 文件内容:

input {

tcp {

mode => "server"

host => "0.0.0.0"

port => 4560

codec => json_lines

}

}

output {

elasticsearch {

hosts => "es:9200"

index => "springboot-logstash-%{+YYYY.MM.dd}"

}

}

复制代码创建配置文件存放目录并上传配置文件到该目录:

mkdir /mydata/logstash

复制代码</

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

921

921

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?