一、准备阶段

1.1 查看NPU信息

香橙派查看npu信息的命令如下,可以看到npu的型号、显存和版本信息等。

npu-smi info

1.2 查看ollama信息

1.2.1 查看ollama是否安装及服务状态

检查 ollama 是否安装及 ollama 服务状态。

# 查看ollama是否安装

which ollama

# 已安装查看ollama服务状态

systemctl list-unit-files | grep ollama

# 查看 Ollama 服务实时状态(运行/停止/失败)

systemctl status ollama

# 如果服务正在启用,停止现在的ollama服务

pkill ollama

1.2.2 卸载ollama

# 停用ollama服务

sudo systemctl stop ollama

# 查看ollama路径

which ollama

# 卸载当前版本ollama,路径为上面查看的路径

sudo rm -rf /usr/local/bin/ollama*

1.3 安装昇腾版本ollama

1.3.1 下载安装昇腾版本的ollama

# 安装昇腾版本的ollama

curl -fsSL https://ollama.com/install.sh | OLLAMA_ASCEND=true sh

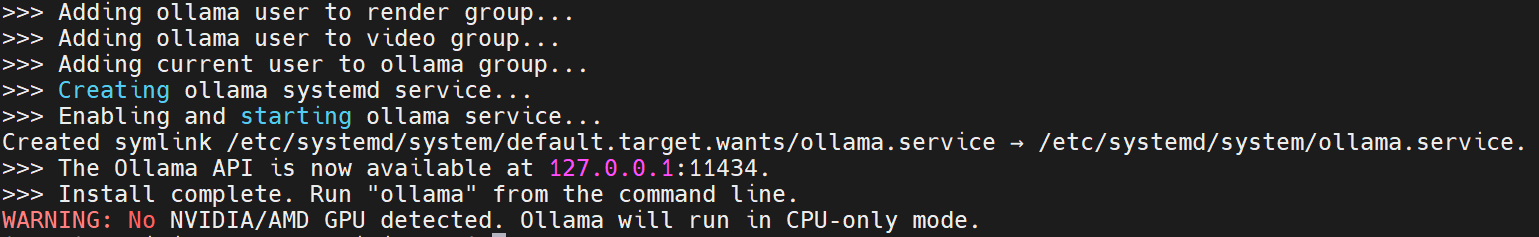

下载完成后,输入密码启动 ollama 服务,会输出以下信息:

1.3.2 配置环境变量

# 永久生效,写进 ~/.bashrc

echo 'export OLLAMA_ASCEND=true' >> ~/.bashrc

echo 'export ASCEND_TOOLKIT_HOME=/usr/local/Ascend/ascend-toolkit/latest' >> ~/.bashrc

echo 'export PATH=$PATH:/usr/local/Ascend/ascend-toolkit/latest/bin' >> ~/.bashrc

source ~/.bashrc

1.3.3 重启ollama服务

# 如果你用的是 systemd

sudo systemctl restart ollama

# 或者直接后台运行

ollama serve &

二、验证是否使用NPU

2.1 查看日志

ollama serve & # 后台启动

# 然后看日志,应该出现类似:

# time=... level=INFO source=runner.go msg="detected ascend device" device=0

# time=... level=INFO source=types.go msg="inference compute" id=0 library=ascend ...

2.2 运行模型尝试

ollama pull llama3.1:8b

ollama run llama3.1:8b

2.3 监控NPU显存占用

实时监控负载(每秒刷新一次):

watch -n 1 npu-smi info

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?