文章目录

核心观点

强化学习已经在游戏、机器人控制、自动驾驶等多个领域取得了成功,证明了它在复杂、未知环境中学习的强大能力。但强化学习仍然面临挑战:样本效率低、对数据差异敏感、商业应用有限,这些都是当前研究的热点问题。

强化学习的成功证明了它作为通用学习范式的价值。从AlphaGo战胜人类围棋冠军,到DQN学会玩49种Atari游戏,再到机器人学会复杂动作,强化学习展示了它在复杂任务中的强大能力。

但强化学习不是万能的。它需要大量试错,对训练数据和真实环境的差异敏感,在实际应用中仍然面临挑战。理解强化学习的成功和局限,可以帮助我们更好地应用它来解决实际问题。

一、在电子游戏中的应用

1.1 早期工作

强化学习在游戏中的应用可以追溯到1952年Arthur Samuel的跳棋工作。这是强化学习的早期探索,证明了通过试错和反馈,机器可以学会玩游戏。

但真正的突破来自Gerry Tesauro的西洋双陆棋工作(Tesauro, 1990)。他的NEUROGAMMON系统使用了一种模仿学习形式:将游戏转移(s, a, s’)转换为训练样本,每个样本的标签s’表示它比其他可能的下一个状态s’'(通过s的不同移动可达)更好。

网络有两个部分,一个用于s’,一个用于s’',通过比较它们的输出来选择更好的网络。每个部分学习一个评估函数。NEUROGAMMON在1989年赢得了计算机奥林匹克竞赛,成为第一个赢得计算机游戏锦标赛的学习程序。

1.2 TD-GAMMON

Tesauro的TD-GAMMON(1992)使用了TD学习方法,进一步改进了性能。它使用时序差分学习来更新价值函数,不需要完整的游戏结果,可以在每一步都进行学习。

TD-GAMMON的成功证明了时序差分学习在游戏中的有效性。它学会了评估棋盘状态,选择最优动作,最终达到了人类大师水平。这为后续的深度强化学习奠定了基础。

1.3 Deep Q-Network (DQN)

DQN是第一个现代深度强化学习系统,使用深度神经网络表示Q函数。它在49种不同的Atari电子游戏上训练,从原始图像数据学习玩模拟赛车、射击外星人、打乒乓球等游戏。

DQN的成功证明了深度强化学习在复杂任务中的强大能力。它不需要手工特征,可以直接从原始图像学习,这大大扩展了强化学习的应用范围。

但DQN也面临挑战。像"Montezuma’s Revenge"这样的游戏,由于需要长期策略和稀疏奖励,DQN表现不佳。这揭示了深度强化学习在稀疏奖励和长期规划方面的局限性。

1.4 AlphaGo

DeepMind的AlphaGo系统使用深度强化学习击败了顶级人类围棋选手。它使用价值函数和Q函数,用卷积神经网络指导搜索,通过自我对弈不断改进。

AlphaGo的成功证明了深度强化学习在复杂策略游戏中的强大能力。围棋的状态空间比西洋双陆棋大得多 ( 1 0 170 v s 1 0 20 ) (10^{170} vs 10^{20}) (10170vs1020),但AlphaGo通过深度学习和自我对弈,学会了超越人类的策略。

AlphaGo的后续版本(AlphaGo Zero、AlphaZero)进一步改进了方法,完全从零开始学习,不需要人类知识,只通过自我对弈就达到了超人类水平。这证明了强化学习的强大潜力。

二、在机器人控制中的应用

2.1 倒立摆平衡问题

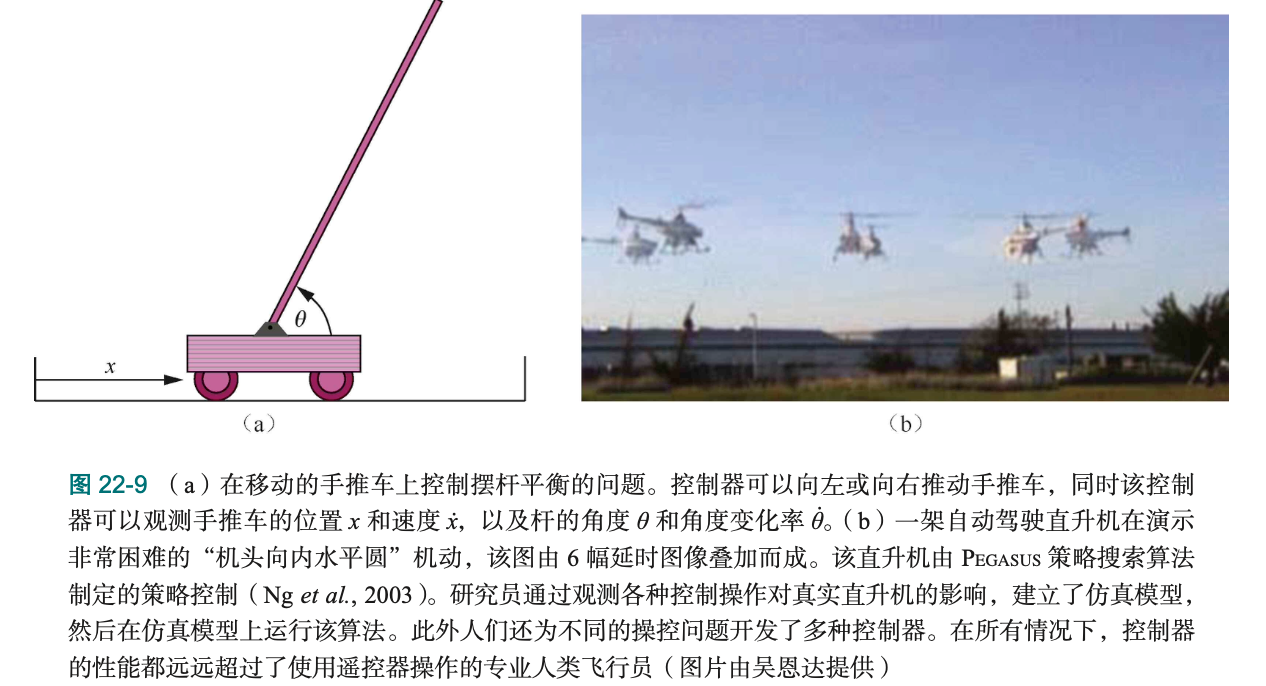

倒立摆平衡问题(cart-pole balancing)是强化学习在机器人控制中的经典例子。这个问题涉及在移动的手推车上控制摆杆平衡:控制器可以向左或向右推动手推车,同时观察手推车的位置x和速度,以及杆的角度θ和角度变化率。

这个问题很困难,因为状态变量是连续的(位置x、角度θ、速度ẋ、角速度θ̇),而动作是离散的(急左或急右)。早期工作(Michie and Chambers, 1968)使用"BOXES"算法,将4D状态空间离散化,经过约30次试验后实现了超过一小时的平衡。

通过自适应状态空间划分和非线性函数近似器(如神经网络),性能得到了改进。平衡"三段倒立摆"(三根杆子首尾相连)是一个常见的训练任务,远远超过人类能力,但强化学习可以实现。

2.2 自主直升机飞行

在无线电控制的直升机飞行中,强化学习取得了显著成功。使用大型马尔可夫决策过程(MDP)进行策略搜索,结合从人类专家飞行员那里学习的模仿学习和逆强化学习。

图22-9b展示了一架自主直升机演示非常困难的"机头向内水平圆"机动。该直升机由PEGASUS策略搜索算法控制(Ng et al., 2003)。研究员通过观察各种控制操作对真实直升机的影响,建立了仿真模型,然后在仿真模型上运行该算法。

此外,人们还为不同的操控问题开发了多种控制器。在所有情况下,控制器的性能都远远超过了使用遥控器操作的专业人类飞行员。这证明了强化学习在复杂机器人控制任务中的强大能力。

2.3 逆强化学习的应用

逆强化学习在机器人学中有广泛应用。从GPS数据预测出租车司机的目的地和路线,从视频分析复杂环境中详细的人体运动,都是逆强化学习的应用。

在机器人学中,单个专家演示可以使四足机器人(LittleDog)学习奖励函数,并在以前未见过的岩石地形中导航。这证明了逆强化学习在从少量演示中快速学习的能力。

2.4 机器人学习的挑战

机器人学习面临独特挑战。首先,状态空间通常是高维、连续的,动作空间也可能是连续的。这使得函数近似和策略搜索变得困难。

其次,试错成本很高。在真实世界中,错误的动作可能导致机器人损坏或危险。这使得安全探索和从专家演示中学习变得重要。

另外,真实世界的环境是部分可观察的、动态的、不确定的。机器人可能无法完全观察环境状态,环境可能随时间变化,传感器和执行器可能有噪声。这些因素使得机器人学习比游戏中的学习更困难。

三、强化学习的其他应用

3.1 自动驾驶

在自动驾驶中,强化学习帮助车辆学习安全驾驶策略。但这也面临安全挑战:错误的动作可能导致严重事故。因此,安全探索和安全约束在自动驾驶中至关重要。

强化学习在自动驾驶中的应用包括:路径规划、行为预测、决策制定等。通过从人类司机的演示中学习(逆强化学习),或者通过模拟中的试错学习,自动驾驶系统可以学会复杂的驾驶策略。

但自动驾驶中的强化学习仍然面临挑战:如何保证安全?如何处理罕见但危险的情况?如何适应不同的驾驶环境和风格?这些都是当前研究的热点问题。

3.2 推荐系统

在推荐系统中,强化学习可以帮助系统学习最优推荐策略。系统可以看作智能体,用户行为看作环境反馈,推荐动作的点击率、转化率等看作奖励。

通过强化学习,推荐系统可以学习长期策略,而不仅仅是短期优化。它可以平衡探索(推荐新内容)和利用(推荐已知好的内容),实现长期收益最大化。

3.3 资源管理

在资源管理中,强化学习可以帮助优化资源分配。比如,在云计算中,强化学习可以学习最优的资源调度策略;在能源管理中,强化学习可以学习最优的能源分配策略。

这些应用的特点是:环境复杂、动态变化、目标多目标(如性能、成本、能耗等)。强化学习可以通过试错和反馈,学会在这些复杂约束下的最优策略。

3.4 金融交易

在金融交易中,强化学习可以帮助学习最优交易策略。智能体可以学习何时买入、何时卖出,以最大化长期收益。

但金融交易中的强化学习面临挑战:市场环境复杂、数据噪声大、风险高。错误的策略可能导致巨大损失。因此,风险控制和稳健性在金融交易中至关重要。

四、强化学习的成功因素

4.1 合适的任务

强化学习适合的任务通常具有以下特征:有明确的奖励信号、状态和动作空间可以表示、试错成本可接受、有足够的时间进行学习。

游戏是强化学习的理想测试平台,因为:奖励信号明确(输赢)、状态和动作可以表示、试错成本低(可以重新开始)、可以快速进行大量试验。这使得游戏成为强化学习研究和应用的重要领域。

4.2 合适的算法

不同的任务需要不同的算法。对于状态空间小、可以学习模型的任务,基于模型的方法(如ADP)可能更有效;对于状态空间大、无法学习模型的任务,无模型方法(如Q学习)可能更合适。

对于需要长期规划的任务,分层强化学习可能更有效;对于有专家演示的任务,模仿学习或逆强化学习可能更快。选择合适的算法对于成功应用强化学习至关重要。

4.3 合适的表示

状态和动作的表示对强化学习的成功至关重要。好的表示应该:捕获任务的关键信息、支持泛化、计算效率高。

在游戏中,原始图像可能是好的表示;在机器人控制中,传感器读数和状态估计可能是好的表示。选择合适的表示需要领域知识和实验。

4.4 足够的计算资源

强化学习通常需要大量的计算资源。从AlphaGo需要数千个GPU进行训练,到DQN需要数百万帧游戏数据进行学习,强化学习对计算资源的需求很高。

但随着计算能力的提升和算法的改进,强化学习的计算成本正在降低。分布式训练、更高效的算法、更好的硬件都在推动强化学习的应用。

五、强化学习的挑战与局限

5.1 样本效率低

强化学习通常需要大量的试错才能学会好的策略。比如,AlphaGo需要数百万盘对局,DQN需要数百万帧游戏数据。这导致强化学习在现实世界中的应用受到限制,因为很多任务的试错成本很高。

提高样本效率的方法包括:从专家演示中学习、迁移学习、元学习、更好的探索策略等。这些方法正在不断改进,但样本效率仍然是强化学习面临的主要挑战。

5.2 对数据差异敏感

强化学习对训练数据和真实环境之间的差异很敏感。在模拟中训练的策略可能在真实世界中表现不佳,因为模拟和真实世界之间存在差异。

这就像你在游戏中学开车,但在真实世界中可能不会开。模拟和真实世界的差异(如物理模型、传感器噪声、执行器延迟等)可能导致策略失效。

解决这个问题的方法包括:域适应、稳健性训练、从真实数据中学习等。但这个问题仍然是强化学习在实际应用中的主要障碍。

5.3 商业应用有限

尽管强化学习在研究和演示中取得了成功,但商业应用仍然有限。这主要是因为:样本效率低、对数据差异敏感、难以保证性能、安全风险高等。

但随着技术的进步和应用的积累,强化学习正在逐步走向商业应用。从游戏AI到推荐系统,从机器人控制到自动驾驶,强化学习的商业应用正在扩展。

5.4 安全与伦理问题

强化学习在实际应用中还面临安全与伦理问题。在自动驾驶中,错误的策略可能导致事故;在医疗诊断中,错误的策略可能危害患者;在金融交易中,错误的策略可能导致巨大损失。

如何保证强化学习系统的安全性?如何确保系统不会学习到有害行为?如何平衡性能和安全?这些都是强化学习在实际应用中必须解决的问题。

七、总结

强化学习已经在游戏、机器人控制、自动驾驶等多个领域取得了成功,证明了它在复杂、未知环境中学习的强大能力。它的核心在于:通过试错和反馈,学会在复杂环境中做出最优决策。

但强化学习不是万能的。它需要大量试错,对训练数据和真实环境的差异敏感,在实际应用中仍然面临挑战。理解强化学习的成功和局限,可以帮助我们更好地应用它来解决实际问题。

记住:强化学习是一个强大的工具,但需要合适的任务、算法、表示和资源。通过理解强化学习的原理、方法和应用,我们可以更好地利用它来解决实际问题,构建更智能的系统。

未来,随着技术的进步和应用的积累,强化学习有望在更多领域发挥重要作用。从游戏到机器人,从虚拟到现实,强化学习正在改变我们构建AI系统的方式,为人工智能的未来开辟新的可能性。

22万+

22万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?