Demo01

Python3 print("")“”用双引号输出

Python2 Print(‘’)‘’单引号输出

10用e代替 1.23e9=1.23x10^9

“ ‘ 本身只是一种表示方式,不是字符串一部分

”“”注释内容“”“ ’‘’注释内容’‘’三对双引号或者三对单引号表多行注释 python允许表示多行内容

选中要注释的区域 Ctrl+/批量注释 # 单行注释

urlopen函数

From urllib import request #从urllib库中导入 request模块

Resp =request.urlopen('http://www.baidu.com') #urlopen 函数

Print(resp.getcode())#读取网页状态码

Print(resp.read())#read()#读取网页源码

Print(resp.readline())读取第一行网页源码

Demo02

#urlretrieve函数

Fromurllibimportrequest,parse

#request.urlretrieve('http://www.baidu.com','baidu.html')

#下载网页或图片,src地址就行

#网址解码和编码

#urlencode函数

params=parse.urlencode({'wd':'刘德华','age':20})

print(params)#输出编码

#wd=%E5%88%98%E5%BE%B7%E5%8D%8E&age=20

Parse_qs

qs=parse.parse_qs(params)

print(qs)#输出解码Demo03

#urlparse和urlsplit函数爬取url详细信息

fromurllibimportparse,request

url='http://www.baidu.com/s?wd=python&username=abc#1'

result=parse.urlparse(url)

#print(result)ParseResult(scheme='http',netloc='www.baidu.com',path='/s',params='',query='wd=python&username=abc',fragment='1')

print('scheme',result.scheme)

print('netloc',result.netloc)#域名

print('path:',result.path)

print('params:',result.params)

print('query:',result.query)

print('fragment',result.fragment)

'''

netloc www.baidu.com

path: /s

params:

query: wd=python&username=abc

fragment 1

'''urlparse和urlsplit基本上是一模一样的。唯一不一样的地方是,urlparse里面多了一个params属性,而urlsplit没有这个params属性。比如有一个url为:url = 'http://www.baidu.com/s;hello?wd=python&username=abc#1',那么urlparse可以获取到hello,而urlsplit不可以获取到。url中的params也用得比较少。

Demo04

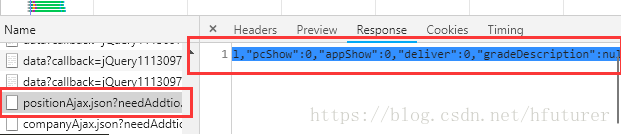

爬取拉勾网招聘信息

检查元素,选择找到headers REferer伪装成浏览器访问

Chrome response Ctrl+f搜索框

复制里面响应的position去 www.json.cn 网站上解析

这里就是要爬取的招聘信息

fromurllibimportrequest,parse

url="https://www.lagou.com/jobs/positionAjax.json?needAddtionalResult=false"

headers={

'User-Agent':'Mozilla/5.0(WindowsNT10.0;Win64;x64)AppleWebKit/537.36(KHTML,likeGecko)Chrome/67.0.3396.99Safari/537.36'

#浏览器默认

}

data={

'first':'true',

'pn':1,#pn代表第几页

'kd':'python'

}

req=request.Request(url,headers=headers,data=parse.urlencode(data).encode('utf-8'),#data也需要urlencodeparse模块导入

method='POST')

resp=request.urlopen(req)

print(resp.read().decode('utf-8'))#.decode解码成可读"utf-8"

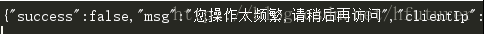

防爬误导

这篇博客介绍了Python的基础知识,包括打印输出、注释方式以及urllib库的使用。通过Demo展示了urlopen函数的用法,如获取网页状态码、读取网页源码。此外,还提到了urlparse和urlsplit的区别,并简单提及了爬虫中的头部伪装和信息解析。

这篇博客介绍了Python的基础知识,包括打印输出、注释方式以及urllib库的使用。通过Demo展示了urlopen函数的用法,如获取网页状态码、读取网页源码。此外,还提到了urlparse和urlsplit的区别,并简单提及了爬虫中的头部伪装和信息解析。

9234

9234

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?