下面这个视频是作者本人的oral presentation ,讲的是论文思路,很不错。

https://www.bilibili.com/video/av884481653/

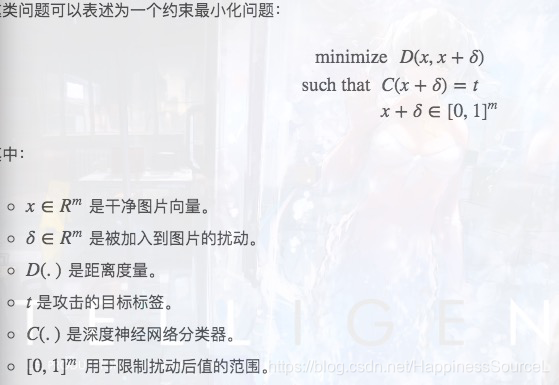

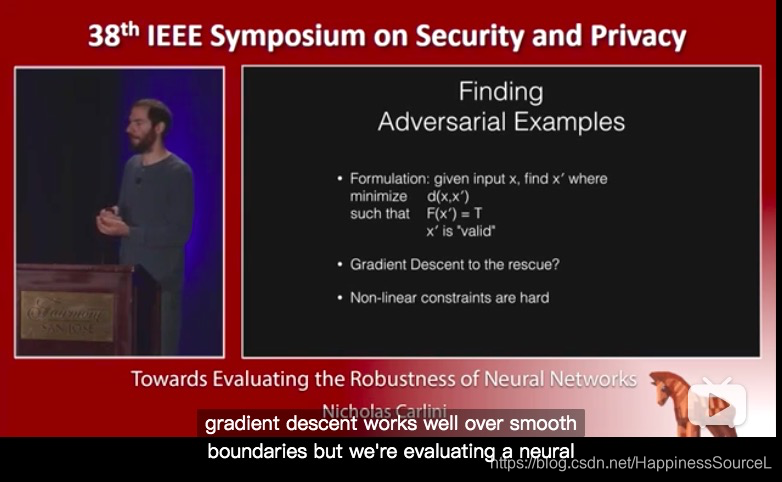

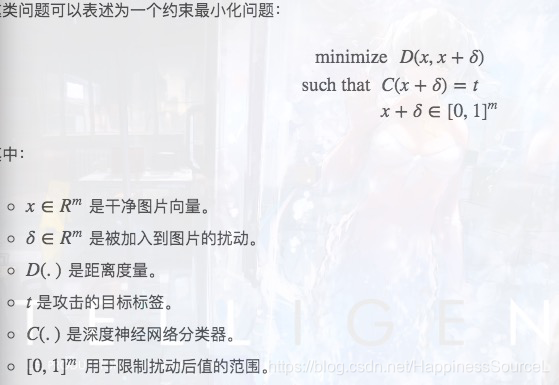

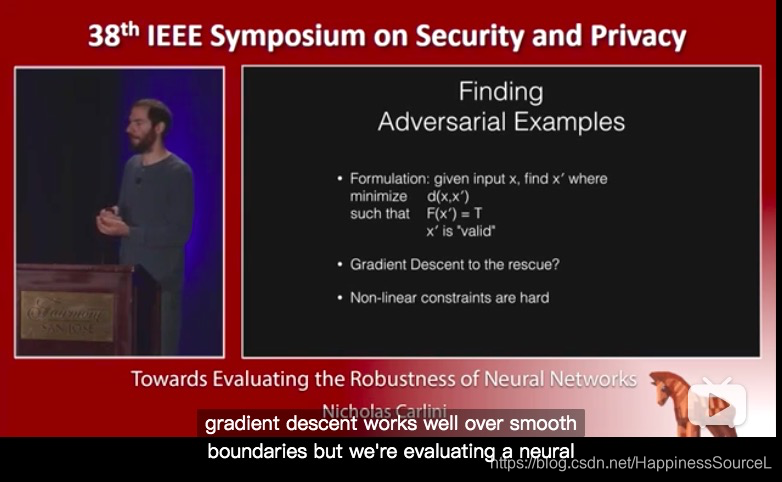

首先是将生成对抗样本的过程formulate为一个凸优化的式子并尝试去解

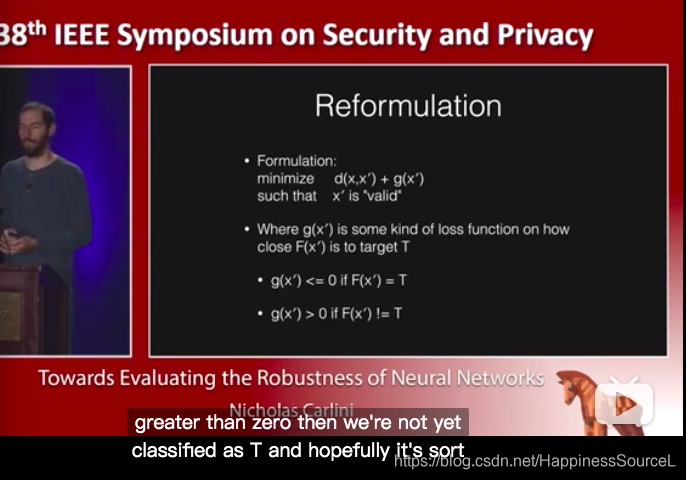

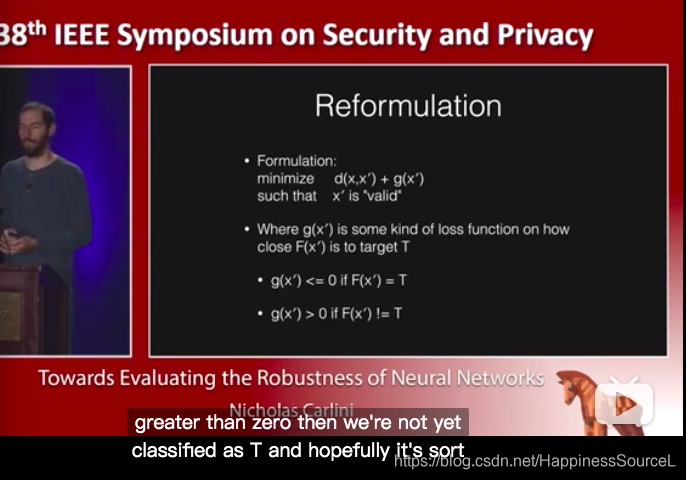

然后将C(x+^) = t 转化为 分类为t的的损失函数最小

</

</

这篇博客是对论文'Towards Evaluating the Robustness of Neural Networks'的解读,作者探讨了如何将对抗样本的生成转化为凸优化问题,以及构建损失函数的多种方式。论文还提出了评估攻击效果的两个标准,并讨论了在黑盒攻击中的应用。此外,Q&A环节解答了关于攻击成本、选择像素修改、模型转移能力等相关问题。

这篇博客是对论文'Towards Evaluating the Robustness of Neural Networks'的解读,作者探讨了如何将对抗样本的生成转化为凸优化问题,以及构建损失函数的多种方式。论文还提出了评估攻击效果的两个标准,并讨论了在黑盒攻击中的应用。此外,Q&A环节解答了关于攻击成本、选择像素修改、模型转移能力等相关问题。

下面这个视频是作者本人的oral presentation ,讲的是论文思路,很不错。

https://www.bilibili.com/video/av884481653/

首先是将生成对抗样本的过程formulate为一个凸优化的式子并尝试去解

然后将C(x+^) = t 转化为 分类为t的的损失函数最小

</

</

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?