文/编辑 | 言有三

正所谓读史使人明智,没有一个经典的网络模型是突然之间冒出来的,都是厚积薄发的结果,我们会在知识星球每天更新一篇网络结构设计的文章,现在先来测试大家一下:

LeNet5,AlexNet,VGG,MobileNet它们的前身都是什么,你知道吗?

卷积神经网络的起源

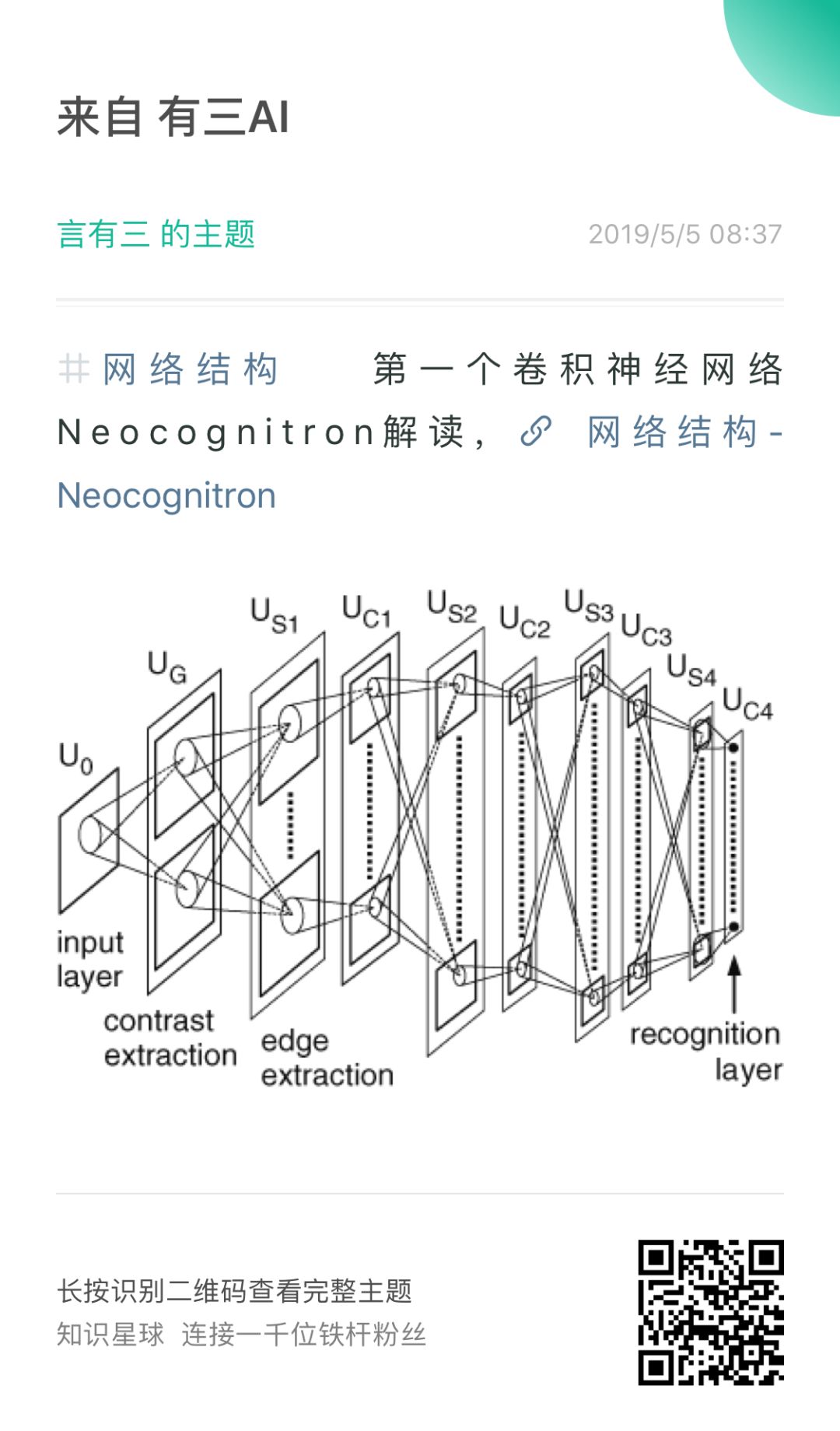

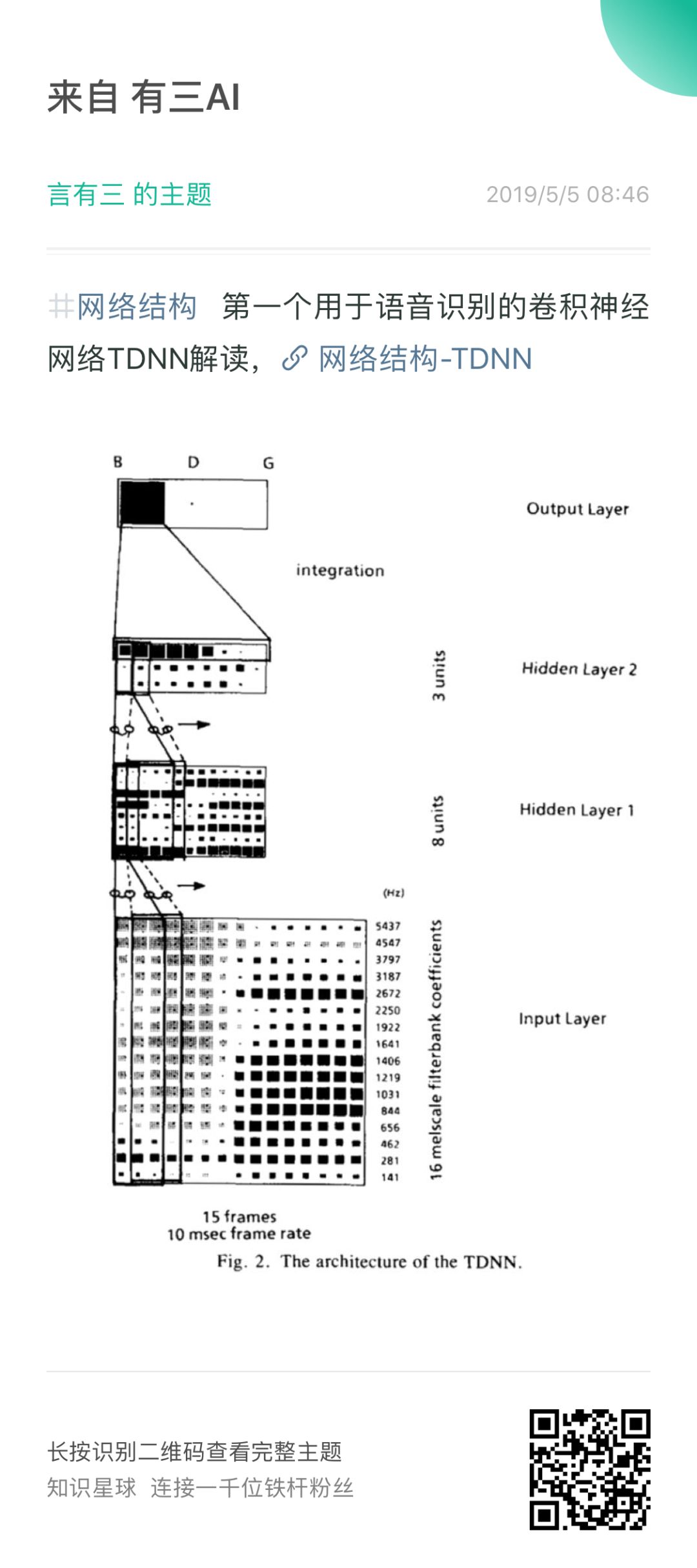

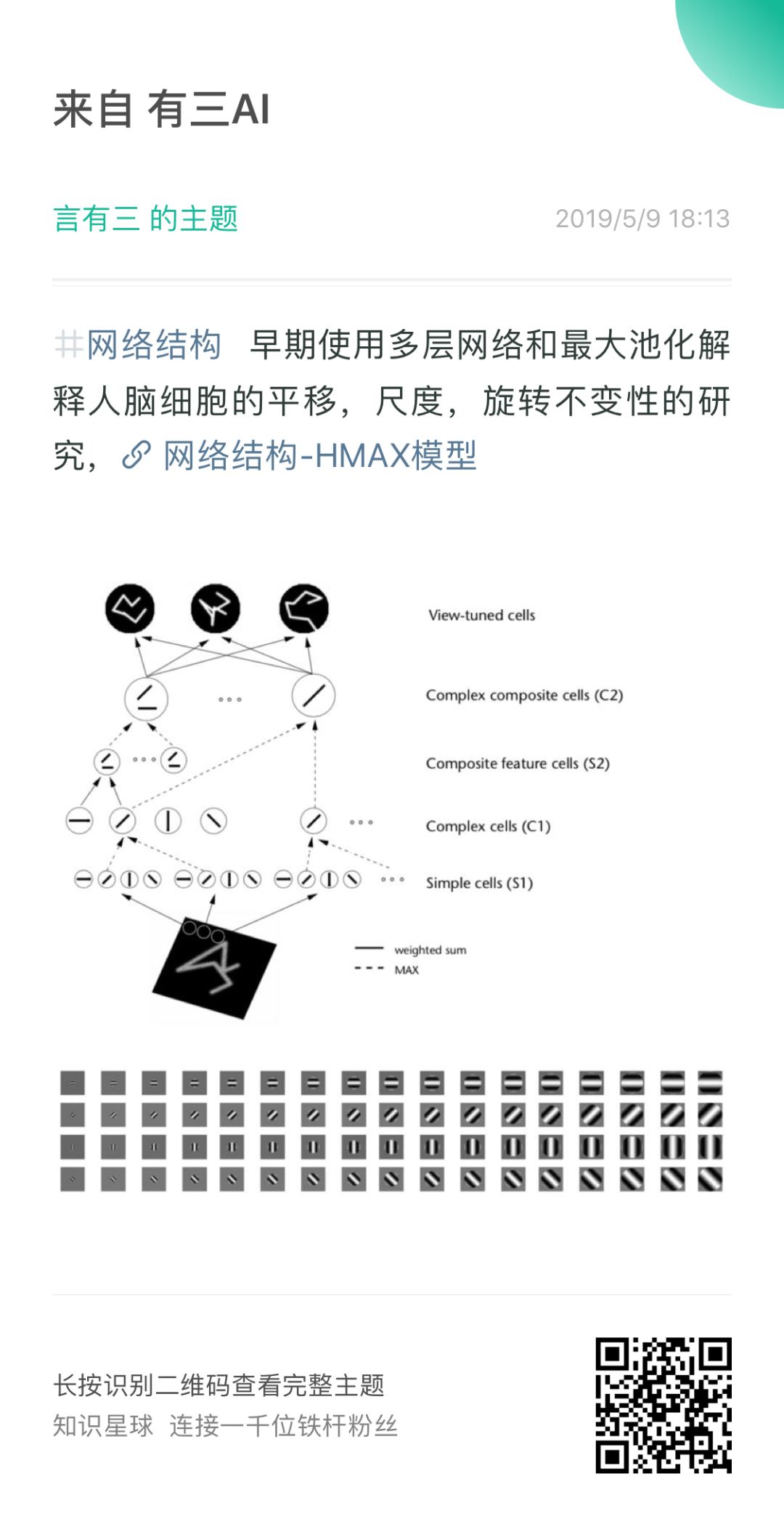

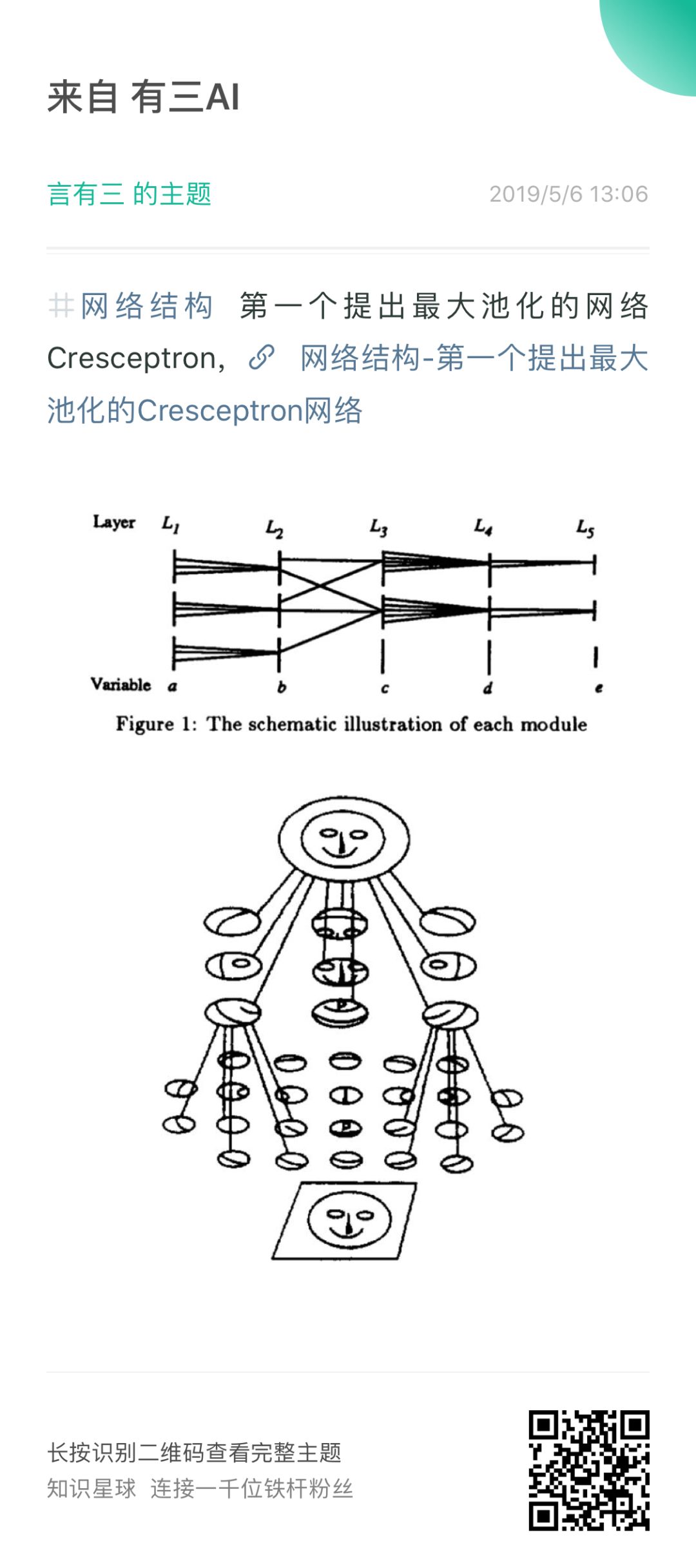

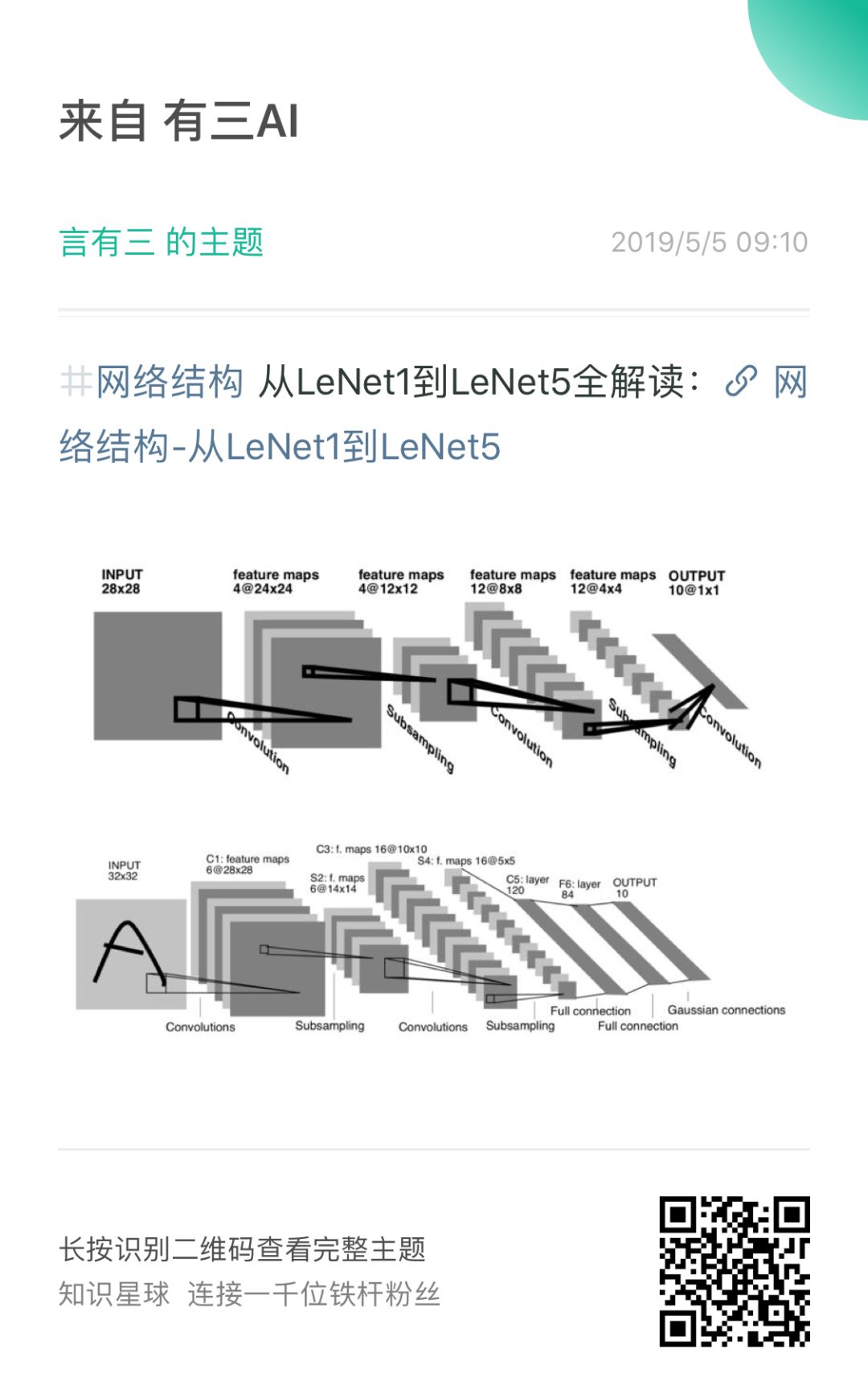

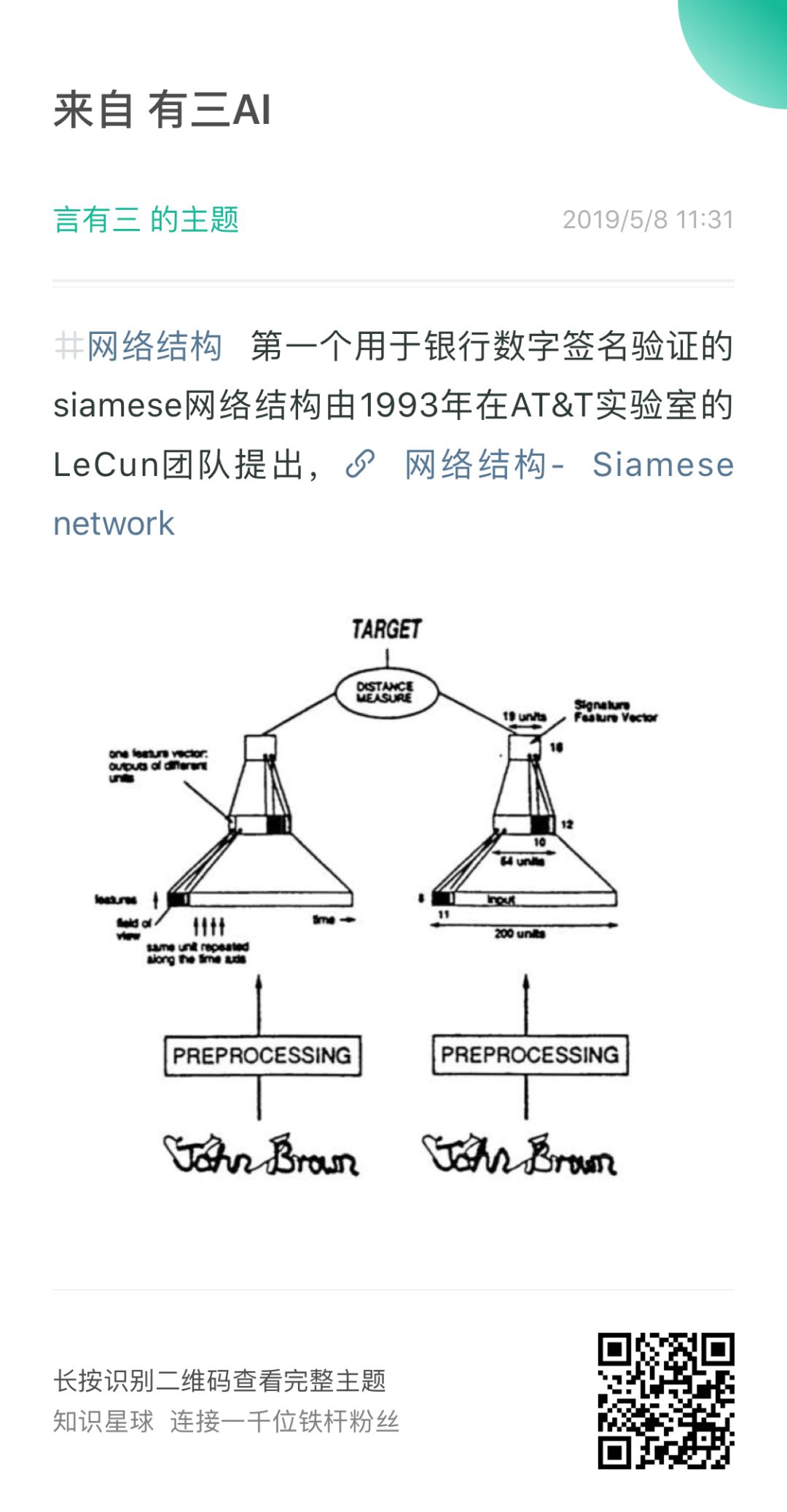

从什么时候开始,才算是卷积神经网络的诞生呢?图像和语音又是如何受益于卷积神经网络,为什么网络要采用分层的设计,是谁开始使用最大池化?LeNet5为什么要加个5呢?难道还有1,2,3,4吗?除了分类数字,上个世纪的CNN还有其他用吗?

Neocognitron,TDNN,HMAX,Cresceptron,Siamese,LeNet系列网络可以了解一下。

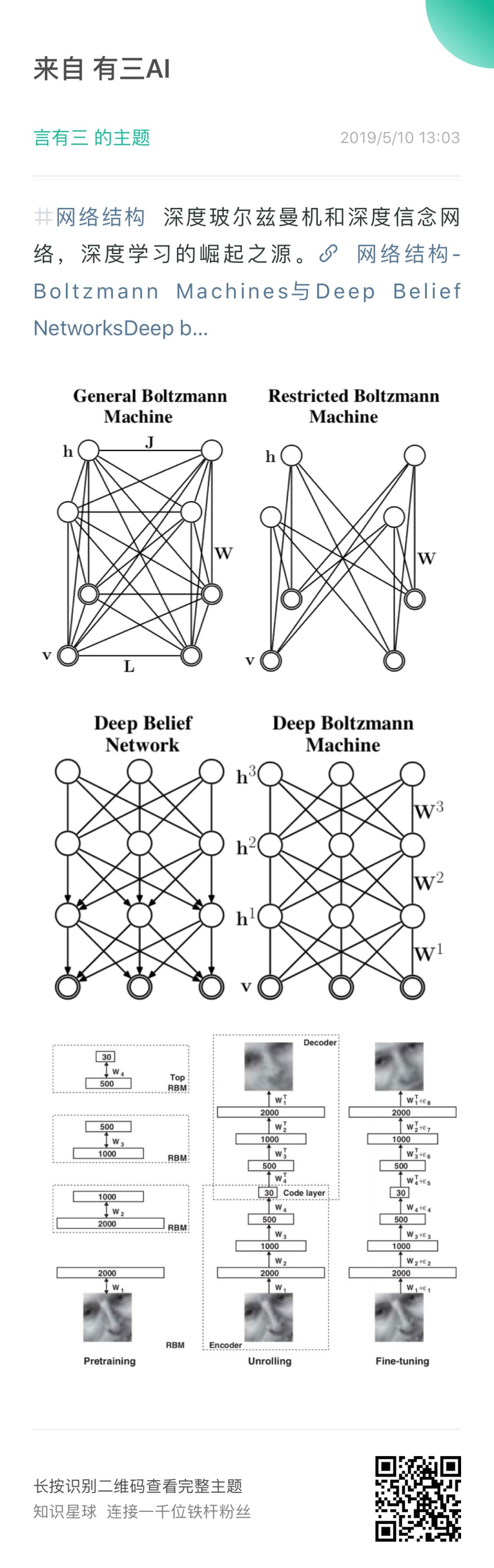

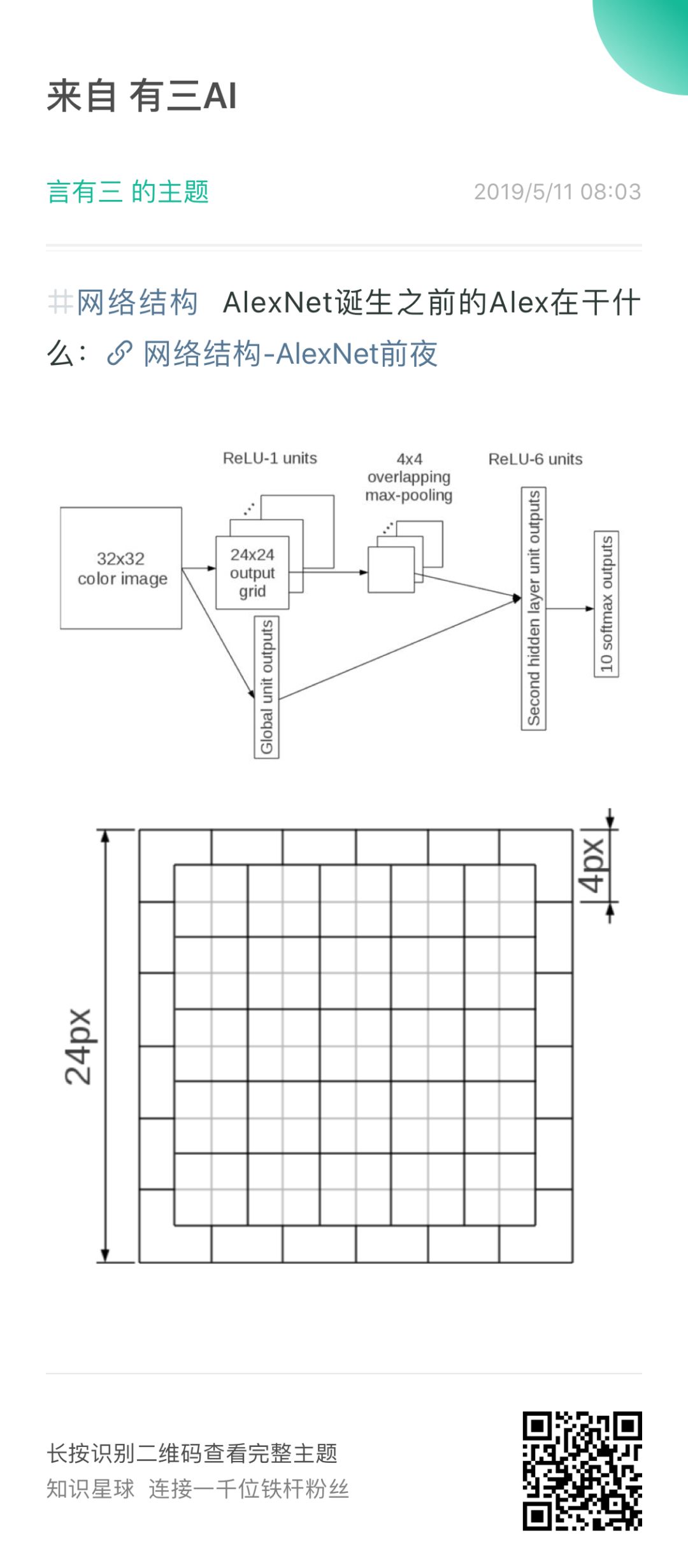

深度学习卷土重来前夕

为什么深度学习崛起从RBM开始?AlexNet诞生之前Alex同学在干什么?VGG怎么就想起来使用小卷积了呢?

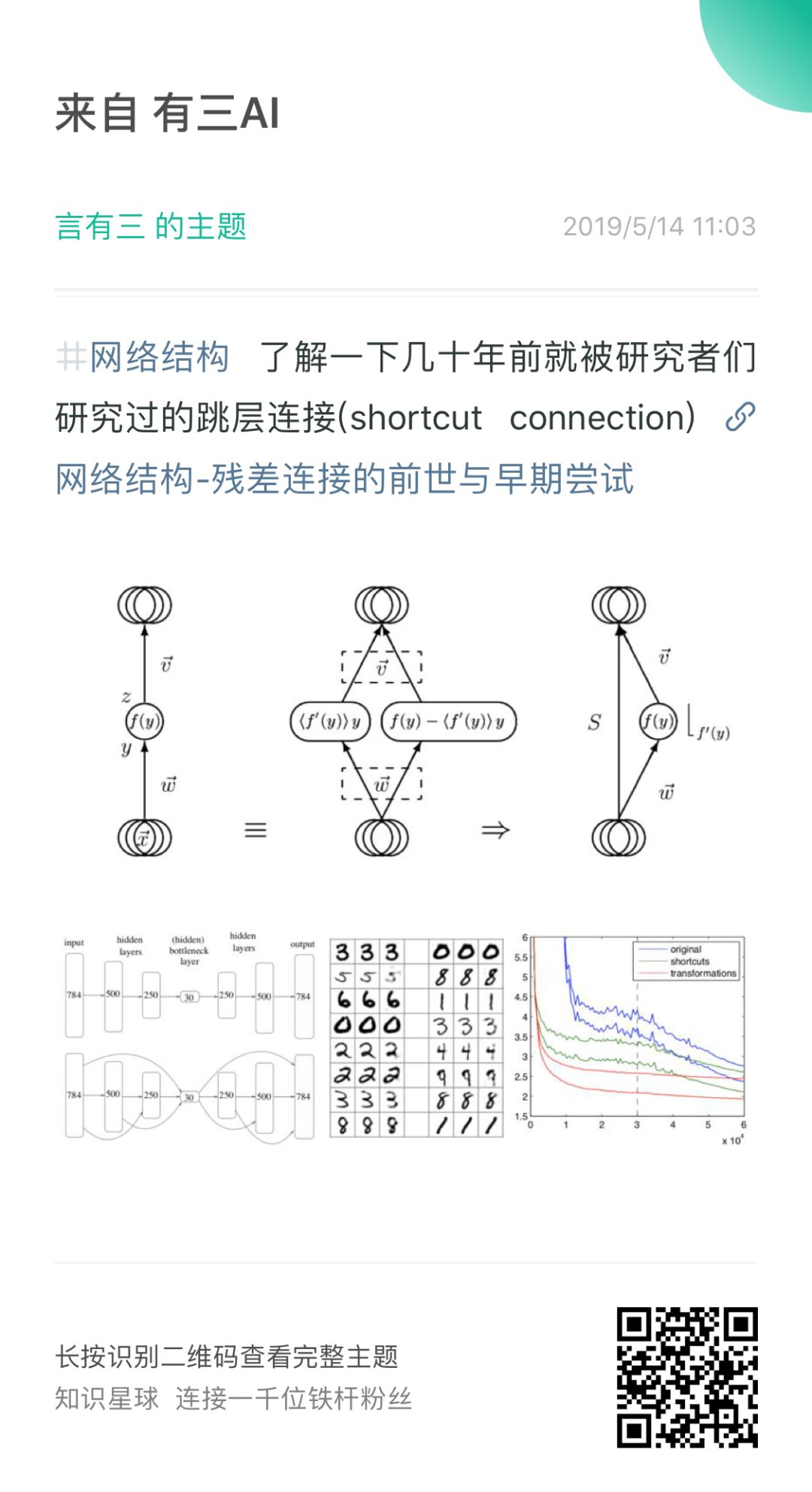

残差连接是原创吗

ResNet文章引用量已经过10000了,但是你知道几十年前的shortcut connection早就已经在网络结构中使用了吗?LeCun大神们早就系统性研究过shortcut connection了吗?早在resnet之前的highway network已经训练过上1000层的深层模型了吗?

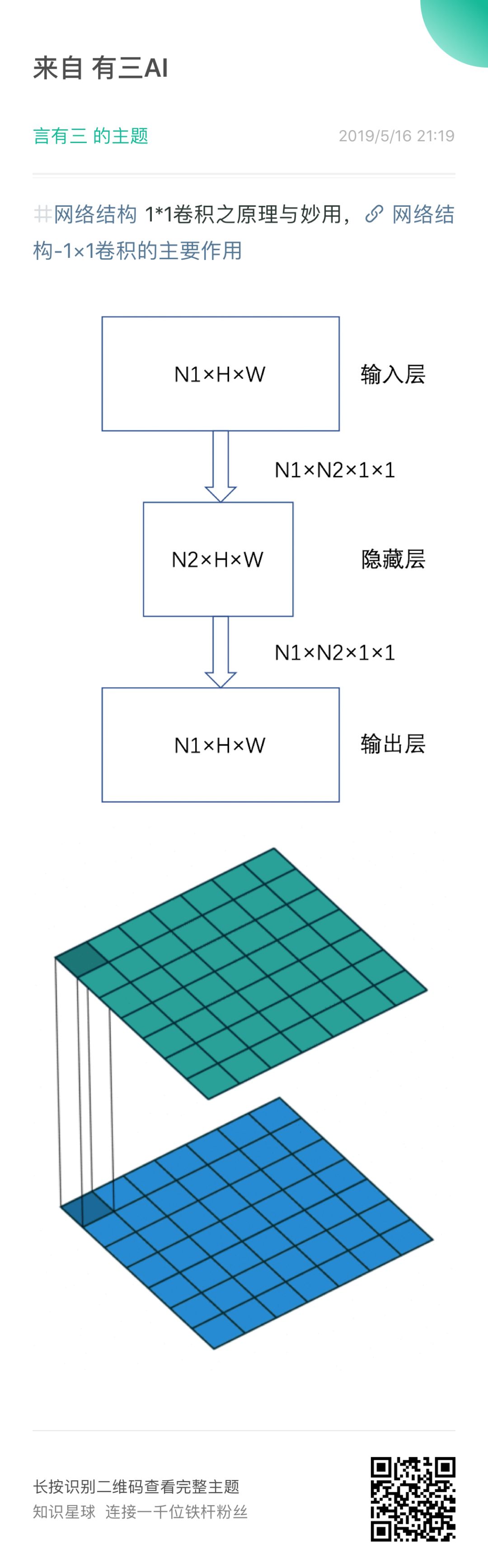

开始研究高效率网络了

随着网络的能力越来越强,大家开始追求性价比了,不仅要强大,而且要高效,那么1*1卷积究竟有何妙用?分组卷积的起源到底是什么?

所有内容知识星球持续更新中,等你来!有三AI纪念版扑克牌已经开始发货了,名额有限,不知道你准备好下单没有。

有三AI纪念版扑克牌

直播预告

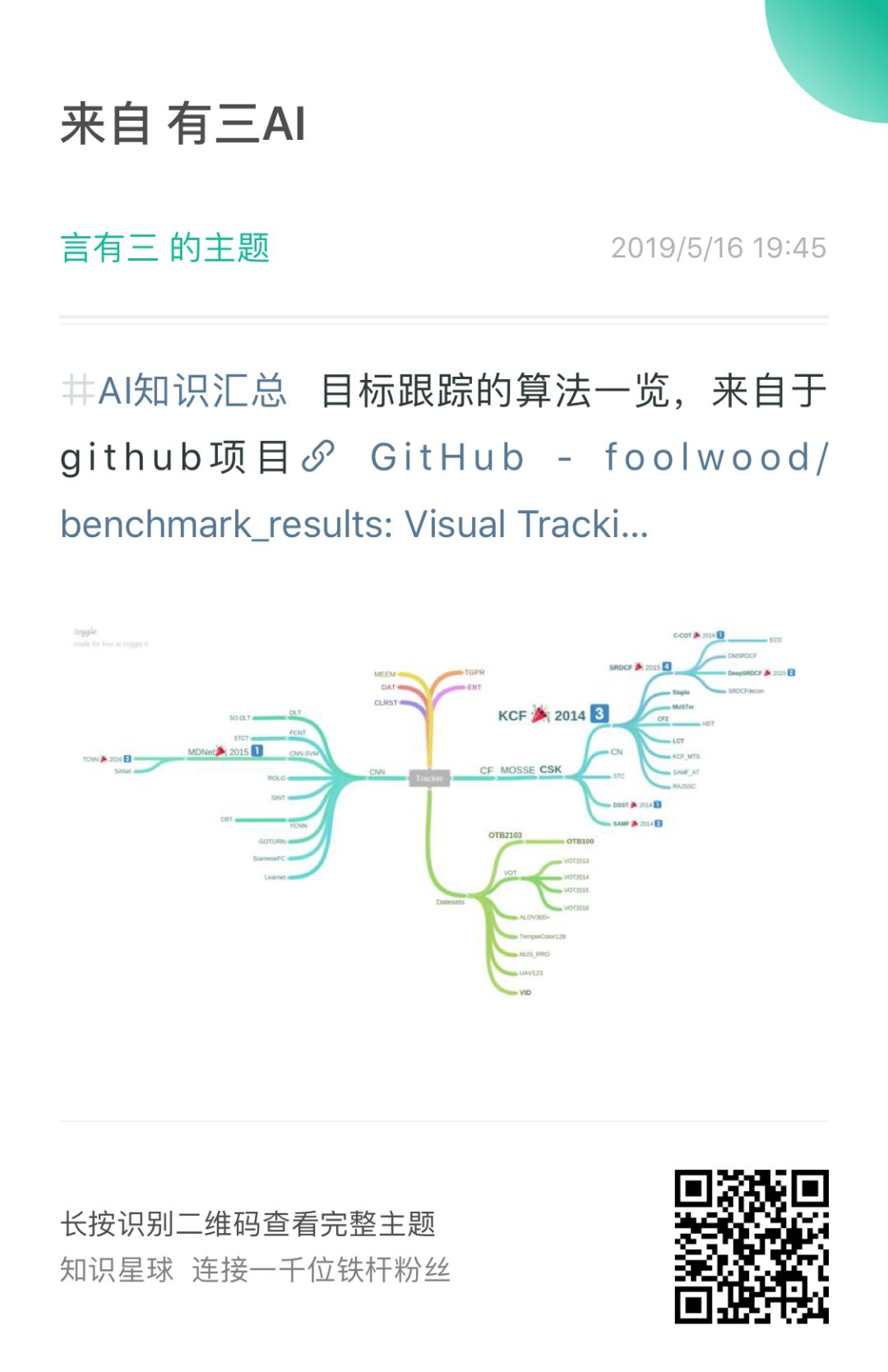

今日看图猜技术

有三AI 知识汇总

有三AI生态

更多更新的内容请移步知乎专栏《有三AI学院》

转载文章请后台联系

侵权必究

文章围绕卷积神经网络展开,探讨其起源,如Neocognitron等早期网络;提及深度学习崛起前的情况,像RBM与AlexNet;还讨论残差连接的历史、高效率网络研究等。此外,介绍了有三AI的相关内容,包括知识星球更新、扑克牌发售等,还罗列了众多AI学习文章。

文章围绕卷积神经网络展开,探讨其起源,如Neocognitron等早期网络;提及深度学习崛起前的情况,像RBM与AlexNet;还讨论残差连接的历史、高效率网络研究等。此外,介绍了有三AI的相关内容,包括知识星球更新、扑克牌发售等,还罗列了众多AI学习文章。

973

973

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?