自动驾驶中的实时三维交通锥检测

摘要

在使用单目相机进行道路场景语义理解方面已取得显著进展。然而,这些研究主要集中在特定类别物体上,如汽车、骑自行车的人和行人。本文研究了交通锥这一对自动驾驶车辆中交通控制至关重要的物体类别。利用单目相机图像进行三维目标检测本质上是一个病态问题。在本研究中,我们利用交通锥的独特结构,提出了一种流水线方法来解决该问题。具体而言,我们首先通过改进的二维物体检测器在图像中检测交通锥;随后借助提出的深度结构回归网络识别交通锥上的关键点,并利用交比具有投影不变性的特点进行网络正则化;最后,通过经典的PnP算法,结合由关键点回归得到的对应关系,恢复交通锥的三维位置。大量实验表明,我们的方法能够实时准确地检测交通锥并估计其在三维世界中的位置。所提出的方 法也部署于一个实时自主系统中,能够在低功耗Jetson TX2平台上高效运行,提供精确的三维位置估计,使赛车能够在由交通锥标示的未知赛道上实现自主建图与驾驶。凭借鲁棒且精确的感知能力,我们的赛车在2018年于意大利和德国举行的大学生方程式竞赛中均获得冠军,在我们的无人驾驶平台“gotthard driverless”上以最高时速54公里/小时平稳行驶。https://youtu.be/HegmIXASKow?t=11694。完整流水线、建图与导航的可视化可在我们的项目页面 http://people.ee.ethz.ch/~tracezuerich/TrafficCone/。

一、引言

自动驾驶已成为计算机视觉、机器人学和机器学习领域共同关注的最具吸引力的问题之一[34],[20],[15],[16]。大量研究推动了自动驾驶领域的发展,促成了关于几年内实现全自动驾驶汽车的雄心勃勃的声明。然而,在人类驾驶员能够被自动驾驶取代之前,仍需克服诸多技术挑战,例如应对恶劣天气和变化的光照条件所需的鲁棒性[30],[6],[35],以及处理路边施工和事故等临时性、突发状况的能力[24]。

交通控制设备,如交通标志、交通信号灯和交通锥,在确保安全驾驶和防止道路上的事故方面起着至关重要的作用。近年来,交通标志[29],[23] 和交通信号灯[17],[8]的检测已取得显著进展。然而,交通锥尚未得到应有的关注。交通圆锥是锥形标记,通常放置在道路或人行道上,可用于安全且临时地引导交通或封锁区域。在路边施工和交通事故情况下,常使用这些圆锥来分流或合并车道。由于交通锥是临时且可移动的,即使高精度(HD)地图也无法解决此类问题,因此必须依靠车载传感器在内部进行处理。

人们可能会倾向于采用端到端方法,直接从图像映射到控制输出(油门和转向指令)[15]。然而,我们相信,将基于部件的方法与可解释的子模块以及数据驱动的端到端方法相结合,是一条更有前景的方向。无论如何,目标检测对于学习自动驾驶系统仍然非常必要。

值得注意的是,尽管这些交通锥本身是静态物体,但它们在城市驾驶场景中经常被更换和移动。汽车可能意外抛锚,新的施工区域也可能比预期更频繁地出现。虽然建筑物和地标可以轻松绘制地图并用于定位,但在自动驾驶中,仍需主动检测并估计这些交通锥的位置以确保安全。

基于距离的传感器(如激光雷达)旨在精确测量三维位置,但由于激光雷达的表示相较于图像更为稀疏,因此检测小物体并预测其物理属性(如颜色和纹理)成为巨大挑战。激光雷达传感器比相机更昂贵,导致使用它们的平台成本处于较高水平。计算机视觉的进步表明,即使单目相机的图像也可用于揭示场景中的内容而且还能确定其在三维世界[12],[33]中的实际位置。使用单目相机的另一个优势是不需要多相机设置,这使得系统更具成本效益且更易于维护。

在本研究中,我们解决从单幅图像中进行交通锥的三维位置估计与检测问题。我们将该任务分解为三个步骤:二维目标检测、关键点回归以及从二维图像空间到三维世界坐标的映射。具体而言,使用针对此场景定制的现成的二维目标检测器在图像中检测交通锥;将检测得到的二维边界框输入到我们提出的卷积神经网络中,以回归交通锥上的七个标志关键点,并利用交比(Cr)具有投影不变性的特性来提高鲁棒性。最后,通过 PnP算法恢复交通锥的三维位置。为了训练和评估我们的算法,我们构建了专用于交通锥的数据集。

通过大量实验,我们证明了所提出的方法能够利用单幅图像准确地检测交通锥。在与真实值对比时,三维交通锥的位置估计在10米距离下偏差仅为0.5米,在16米距离下偏差为1米。我们进一步将该方法部署到一个全尺寸自动驾驶赛车的关键实时系统中,验证了其性能。

本文的主要贡献是:(1)提出了一种利用单幅图像进行实时3D交通锥检测的新方法;(2)构建了一个系统,证明了我们流水线的精度足以支持赛车以最高时速54公里/小时的速度自主在赛道上行驶。展示我们的车辆在两侧布置有交通锥的赛道上行驶的视频可在此处查看:https://youtu.be/HegmIXASKow?t=11694。

二、相关工作

快速目标检测

目标检测一直是计算机视觉领域中最受关注的问题之一。此外,对于需要实时在线性能的应用,尤其是在机器人平台上,速度至关重要。最早的成功的快速目标检测器之一是Viola-Jones人脸检测器[36],该检测器利用弱学习器结合基于Haar的特征来准确检测人脸。接下来一类知名的目标检测器则采用卷积神经网络(CNNs)形式的深度学习方法。一系列 R-CNN[10],[27],[9]方案使用基于卷积神经网络的特征进行区域提议分类。YOLO[25]巧妙地将目标检测表述为一个回归任务,从而实现了非常高效的目标检测系统。单次目标检测也被应用于三维目标检测[18]。尽管在通用目标检测方面已取得进展,但在交通锥等小目标类别的检测性能上仍需进一步提升。

交通设备检测

在交通标志[29],[23] 和交通light[17],[8]。为了推动基准测试工作,已发布了一个包含10万张标注图像的交通标志数据集[38]。李等人[21]提出了一种生成对抗网络(GAN)来提升小目标检测效果,例如远处的交通标志。李等人[19]探索了交通标志检测并输出更精细的掩码,而非粗糙的边界框矩形。该研究简要讨论了利用连续两帧中提取的对象边界进行三角测量的方法,但仅限于仿真环境。我们的工作专注于仅使用单幅图像实现交通锥检测与三维位置估计。

关键点估计

本工作的主要贡献之一是能够仅使用单帧图像准确估计交通锥的3D姿态。利用关于三维几何的先验信息来回归称为关键点的特定特征点。此前,姿态估计和关键点已出现在其他研究中[31],[12]。格拉 斯纳等人[12]使用投票支持向量机集成来估计包含汽车的图像的姿态。图尔萨尼等人[33]利用特征和卷积神经网络来预测不同物体的视角。他们的工作捕捉了物体视角与特定物体关键点之间的相互作用。PoseCNN[37]直接通过深度学习输出六自由度姿态。吉科萨里等人[11]使用k部件可变形部件模型,并提出了一种用于人体检测和关键点提取的统一方法。我们的方法利用交通锥的独特结构,更具体地说,利用交比的射影不变性,实现鲁棒的关键点估计。

III. 单目相机感知流水线

A. 传感器设置和计算平台

实验设置采用基于CMOS传感器的200万像素相机,并配备全局快门,以避免因快速运动导致的图像失真和伪影。本研究所述的中心相机为单目相机,配备12毫米镜头,可实现远距离感知。左右相机则使用5.5毫米焦距的镜头,组成立体相机对,用于近距离圆锥的三角测量。摄像头被封装在定制3D打印的防水外壳内,镜头前方装有偏振滤光片。摄像头通过以太网经由共享交换机传输数据,从而实现整洁的相机外壳设计。摄像头通过螺丝固定在底部的金属板上,并与之直接接触以维持正常工作温度。原始相机数据直接传输至Jetson TX2,该设备作为主控PIP-39(搭载英特尔i7)车载系统“gotthard driverless”的从设备。该流水线足够轻量,可在低功耗计算平台上以10赫兹的频率完全运行。

B. 流水线概述

从单幅图像中进行姿态估计是一个病态问题,但若具备目标物体的先验结构信息,则该问题可解。随着可用性得益于海量数据和GPU等强大硬件的支持,深度学习在那些使用经典的手工方法难以解决的任务上表现优异。数据驱动的机器学习擅长学习复杂的表示,而基于数学和几何得出的结果则提供了稳健可靠的位姿估计。在我们的研究中,我们力求以一种高效的方式将两者优势结合起来,采用兼顾性能与可解释性的流水线方法。

流水线中的子模块使其能够利用单幅图像检测感兴趣的目标并准确估计其三维位置。该流水线的三个子模块分别为:(1)目标检测,(2)关键点回归,以及(3)基于2D-3D对应的位姿估计。流水线的各个子模块通过机器人操作系统(ROS)作为节点运行[4]框架,用于处理流水线不同部分之间以及不同系统之间的通信与数据传输(以消息形式)。详细信息将在第IV节中进一步描述。

四、方法

A. 目标检测

为了从单张图像中估计多个目标实例的三维位置,首先需要能够检测出这些感兴趣的目标。在目标检测任务中,我们的流水线采用了一种现成的目标检测器 YOLOv2[26]。YOLOv2 被训练用于检测不同颜色的圆锥,这些圆锥作为主要地标,用于划分 Formula Student Driverless 比赛中的赛道(我们曾使用自己的平台参与该赛事)。选择阈值和参数时,力求使误报和错误分类最小化。针对这一特定应用场景,YOLOv2 通过减少其检测的类别数量进行了定制,因为它只需区分具有特定语义含义的黄色、蓝色和橙色圆锥。

由于圆锥的边界框高宽比大于一,因此利用这一先验信息,通过重新计算YOLOv2使用的anchor boxes来加以利用(详见[26])。用于ImageNet[7]挑战赛训练的权重用于初始化。我们遵循与原始工作类似的训练方案[26]。在赛季过程中获取并标注更多数据时,检测器会进行微调。有关数据收集与标注的更多详细信息,请参见第V-A.1节。

B. 关键点回归

本节讨论

如何利用单幅二维图像中的目标检测来估计感兴趣物体的三维位置。由于尺度上的歧义性,仅从场景的单个视图中完成此任务具有挑战性。然而,如果已知圆锥的三维形状、尺寸和几何结构的先验信息,则可以恢复仅使用单幅图像检测到的物体的3D姿态。如果有物体(在3D中)与图像(在2D中)之间的一组2D-3D对应关系,并结合相机的内参,就可以估计出物体的3D姿态。为此,我们提出了一种特征提取方案,该方案受传统计算机视觉的启发,但融入了通过机器学习从数据中学习的元素。

1) 关键点表示

目标检测器输出的边界框并不直接对应于圆锥。为了解决这一问题,我们在提议的边界框内提取能够代表圆锥的地标特征。在传统计算机视觉中,存在三类特征:平坦区域、边缘和角点。边缘比平坦区域更具显著性,因为它们在一个方向(垂直于边缘边界)上具有梯度,但存在孔径问题[32]。迄今为止,最具显著性的特征是角点,因其在两个方向上均具有梯度,而非仅一个方向,使其在这三类特征中最为突出。

之前的特征提取工作包括著名的Harris角点检测器[13]、鲁棒的SIFT[22]和SURF[5]特征提取器与描述符。这些方法中的许多都具有对尺度、旋转和光照等变换的不变性,这在大多数应用场景中是非常理想的。它们中的大多数作为通用特征检测器表现良好,可广泛应用于不同领域。

使用此类预先存在的特征提取技术的问题在于,它们是通用的,会检测符合其特征点定义标准的任何类型的特征。例如,Harris角点无法区分特征点是位于圆锥上还是位于道路上的裂缝上。这使得难以建立相关的2D对应关系,并将其正确匹配到对应的3D对应物。另一个问题是,当图像块的分辨率较低时,可能只能检测到少数几个特征,从而无法提供足够的信息来估计物体的3D姿态。

2)关键点回归

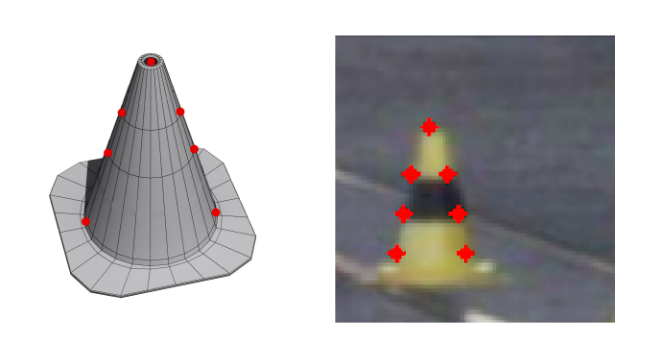

考虑到先前提出的工作存在这些局限性,我们设计了一种卷积神经网络(CNN),该网络能够根据图像块回归出类似“角点”的特征。与通用特征提取技术相比,其主要优势在于借助数据可以学习到对极特定特征点的鲁棒检测能力。尽管在本研究中我们专注于一类特定对象——圆锥;但所提出的关键点回归方案也可以轻松扩展到其他类型的对象。这些特定特征点对应的3D位置(如图3所示)可以从任意世界坐标系中测量得到,Fw。为实现我们的目的,我们将该坐标系置于圆锥底部。

关键点位于此处的原因有两个。首先,关键点网络回归了7个非常特定特征的位置,这些特征在视觉上具有显著区别,且可被视为在视觉上相似于“角”特征。其次,更重要的是,这7个关键点从固定的世界坐标系 Fw 中相对容易地进行三维测量。为方便起见,Fw 被选为三维锥体底部,从而可以在该世界坐标系中测量这7个点的三维位置,Fw。这7个关键点包括:锥体顶点、圆锥底部两侧的两个点(每侧一个),以及中间条纹、背景和上/下条纹相交处的4个点。

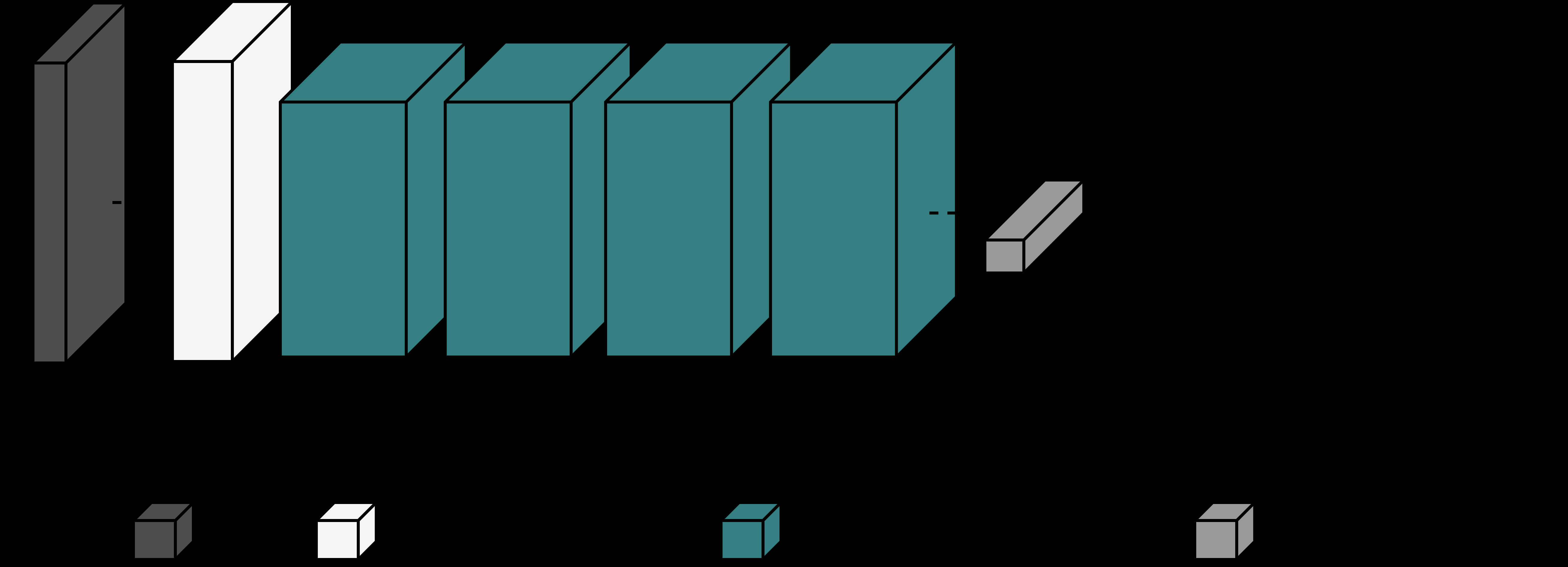

定制卷积神经网络用于检测特定的“角点”特征,其输入为由目标检测器检测到的包含圆锥的子图像块 80 × 80 × 3,并将其映射到 R14。空间维度选择为 80 × 80,所检测到的边界框的平均尺寸。R14的输出向量为关键点的(x, y)坐标。卷积神经网络的架构由受ResNet[14]启发的基本残差块组成,并使用PyTorch[3]框架实现。

如[28],中分析的那样,随着卷积层的增加,张量体积的通道数增多,但另一方面空间维度显著减小,这意味着张量包含的高层信息多于局部信息。我们最终关注的是关键点位置,而关键点具有极强的特异性。采用这种架构可以防止空间信息的损失,因为准确预测位置至关重要。

坐标。该网络在Jetson TX2 上每秒可处理45‐50个锥体图像块。)

坐标。该网络在Jetson TX2 上每秒可处理45‐50个锥体图像块。)

关键点的准确性。网络主干类似于 ResNet。网络中的第一个模块是卷积层,后接批归一化(BN)和作为非线性激活的修正线性单元(ReLU)。接下来的 4 个模块是具有递增通道的基本残差块 C ∈{64, 128, 256, 512}如图 4 所示。最后是一个全连接层,用于回归该图像块中关键点的 (x, y)位置。

3) 损失函数

我们使用物体特定的先验信息来匹配 2D-3D对应关系,即将图像上的关键点(2D)与其在物理锥体上的位置(3D)相对应。此外,关键点网络还通过损失函数中交比的概念,利用有关物体三维几何和外观的先验信息。已知在投影变换下,点间距离及其比值均不保持不变。然而,一种更为复杂的量——交比(即距离之比的比值)具有不变性,在投影下得以保持。我们利用这一性质对关键点的位置进行几何约束,并直接将其整合到模型的损失函数中。

交比(Cr)是一个标量,可以通过4个共线点或5个及以上非共线点[1]计算得到。它在投影以及相机获取图像的过程中具有不变性。

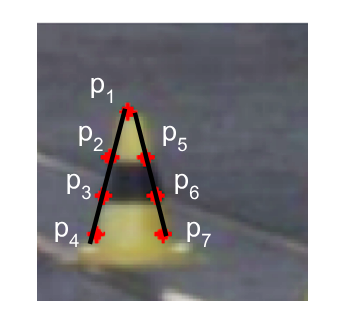

和右臂(p1, p5, p6, p7)。这两部分均用于计算交叉比项,并最小化它们与3D物体上的交比(Cr3D)之间的误差。)

和右臂(p1, p5, p6, p7)。这两部分均用于计算交叉比项,并最小化它们与3D物体上的交比(Cr3D)之间的误差。)

本质上是一种投影变换。交比在场景的二维投影(图像)以及物体所处的三维空间中均保持不变。

在本例中,我们使用4个共线点 p1,p2,p3,p4来计算交比,定义见公式1。根据该值是为3D点(D= 3)还是其投影的二维对应点(D= 2)计算,点 ∆ij与点 pi和 pj之间的距离被定义。

$$

Cr(p1,p2,p3,p4)=(∆13/∆14)/(∆23/∆24) ∈ R

$$

$$

∆ij= √Σ D n=1(X(n) i − X(n) j)2, D ∈{2, 3} (1)

$$

In addition to the cross-ratio to act as a regularizer,损失函数包含每个回归关键点位置(x, y)的平方误差项。该平方误差项迫使回归输出尽可能接近真实值。交比的影响由因子 γ控制,并设置为0.0001。

$$

Σ7 i=1(p^{(x)}

i −p^{(x)}

{i_groundtruth})^2+(p^{(y)}

i −p^{(y)}

{i_groundtruth})^2 +γ ·(Cr(p1,p2,p3,p4)− Cr3D)^2 +γ ·(Cr(p1,p5,p6,p7)− Cr3D)^2 (2)

$$

第二项和第三项最小化在三维中测量的交比(Cr3D)与基于关键点回归器输出在二维中计算的交比之间的误差,间接影响模型预测的位置。公式2中的第二项表示圆锥的左臂,而第三项对应右臂,如图5所示。对于交比,我们选择最小化已知的三维估计值(Cr3D= 1.39408来自真实圆锥)与其二维对应值之间的平方误差项。公式2表示训练关键点回归器时最小化的损失函数。

4) 训练

为了训练模型,使用随机梯度下降(SGD)进行优化,learning rate= 0.0001,momentum= 0.9,批量大小128。学习率在75和100个 epoch后按0.1缩放,并训练250个epoch。

关键点回归器在PyTorch中实现,并通过ROS在“gotthard driverless”上使用。有关数据集的信息,请参见第V-A.2节。

C. 二维到三维对应关系

关键点网络提供目标物体上特定特征的位置,即关键点。我们利用关于目标物体(在本例中为圆锥)的先验信息,例如其形状、大小、外观和三维几何,来进行二维‐三维对应匹配。我们通过透视n点(PnP)算法将相机内参与二维‐三维对应关系结合在一起。

我们将相机坐标系定义为 Fc,世界坐标系定义为 Fw。尽管 Fw可以选择任意位置,但在本例中,我们选择将 Fw置于每个检测到的圆锥的底部,以便于测量关键点的三维位置(相对于 Fw),并方便计算变换以及最终的圆锥位置。

我们使用透视n点法来估计每个检测到的圆锥的姿态。该方法通过估算 cTw与 Fc之间的变换以及 Fw来实现。由于我们仅关注 Fc与 Fw之间的平移,而这正是我们希望估计的圆锥相对于相机坐标系的位置,因此我们舍弃了方向信息。

为了准确估计圆锥的位置,我们使用了OpenCV中实现的非线性PnP方法[2],该方法采用勒文伯格‐马夸尔特算法来获取变换。此外,使用RANSAC PnP来处理噪声对应关系。对每个检测到的圆锥,基于其2D-3D对应关系集合执行RANSAC PnP,即通过关键点回归器提取关键点,并利用预计算的三维对应关系来估计它们的三维位置。通过相机坐标系与自车坐标系之间的变换,可以获得每个圆锥在车辆坐标系中的位置。

V. 数据收集与实验

A. 数据集收集与标注

为了训练和评估所提出的用于目标检测和关键点回归的流水线,收集了数据并进行了人工标注。为了分析使用单幅图像通过所提出方法获得的位置估计的精度,借助激光雷达收集了三维真实值。

1) 交通锥检测

目标检测器在获取的数据集的90%上进行训练,约2700幅人工标注的图像,包含多个圆锥实例,并在10%的数据(约300幅未见过的图像)上评估性能。

2) 锥体图像块上的关键点

从完整图像中提取了900个锥体图像块,并使用自研的标注工具进行手动标注。数据增强。该数据集通过使用20种随机变换对图像进行变换而进一步扩充。

这些包括在[−15◦,+15◦]之间的随机旋转、0.8倍到1.5倍的缩放以及最大为边长50%的平移。在训练过程中,数据还会实时进行对比度、饱和度和亮度方面的增强。最终的增强标注数据集被划分为用于训练的16,000个锥体图像块和用于测试的剩余2,000个锥体图像块。

3) 来自激光雷达的三维真实值

为了测试三维位置估计的精度,将从激光雷达测量得到的相应物体位置作为真实值。该过程针对104个物理锥体在4米至18米的不同距离上进行。估计结果如图7所示,并在第V-D节中进行了总结。

本节分析并讨论了单目感知流水线的结果,特别关注关键点网络的鲁棒性以及利用所提方案从单幅图像中获得的三维位置估计的精度。关键点网络能够在单帧内处理多个锥体图像块,且在Jetson TX2上以15‐16帧每秒的速度运行,在同时运行流水线的其他子模块并处理 1 Gb/s的原始图像数据的情况下,处理时间不超过0.06秒。

B. 锥体检测

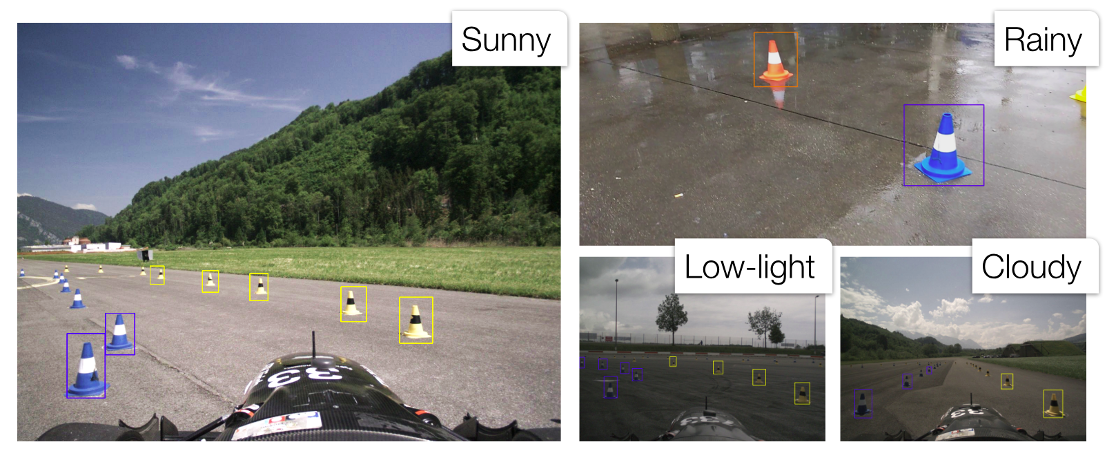

表 II总结了锥体检测子模块的性能评估结果。该系统具有较高的召回率,能够检索到大多数预期的边界框。同时,由于精确率较高,系统能有效避免误检,这对于保持赛车在赛道边界内至关重要。图 2展示了在不同天气和光照条件下锥体检测流程的鲁棒性。彩色的锥体检测结果通过相应颜色的边界框显示。成功驾驶自动驾驶车辆的关键在于设计一个误报极少或没有误报的感知系统。误检可能导致锥体(障碍物)幻觉,迫使车辆偏离路线。锥体检测模块能够检测到大约18‐20米深度范围内的圆锥,但由于远处圆锥尺寸较小,检测结果会更加一致。

| 目标检测 | 精确率 | 召回率 | mAP | MSE |

|---|---|---|---|---|

| 训练 | 0.85 | 0.72 | 0.78 | 3.535 |

| test | 0.84 | 0.71 | 0.76 | 3.783 |

C. 关键点回归

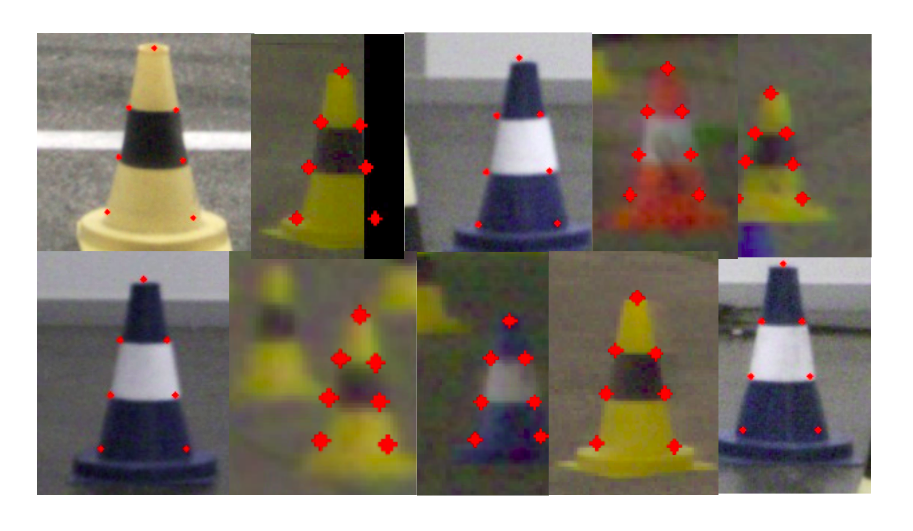

图 6展示了一个由YOLOv2检测后用于关键点回归的10个样本块的组合图。顶行中从左数第二个圆锥位于图像右边缘,仅部分可见,并且用黑色像素填充。即使存在缺失像素且对圆锥的一部分没有信息,我们提出 的回归器仍能预测关键点。它学习了关键点之间的几何结构和相对位置。即使仅部分观察到一个圆锥,它也能近似推断出在完整图像情况下关键点应有的位置。从这些示例可以看出,它能够通过数据理解关键点的空间排列及其几何结构。对于底行中从左数第二个圆锥,背景中有另一个圆锥,但关键点网络仍能回归到更显著的锥体。需要注意的是,随着边界框的尺寸变小,由于子图像的降低的分辨率,精确回归变得更加困难,这一点在此处第一行最后两个圆锥样本中可以明显看出。

我们使用公式2)中的损失来训练模型,该损失除了均方项外还包含交比项。我们使用均方误差来评估关键点回归器的性能。最终关键点回归模型在训练和测试分割上的性能总结见表II。实证性能通过预测值与真实值之间的均方误差来衡量,训练集和测试集之间的性能非常接近,这意味着网络已准确学习如何根据锥体图像块定位关键点,且未发生过拟合。

图 6展示了关键点回归器的鲁棒性和精度,但这仅代表关键点网络子模块的内部性能。在接下来的小节中,我们将分析的输出如何影响整体性能。

D. 三维位置精度

由于其部署在实时自动驾驶汽车上,最关键的方面是估计的3D位置的精度。我们将流水线的精度与激光雷达的三维估计进行比较,后者被视为真实值。

图 7显示了来自两个不同测试赛道的数据。x轴表示物理锥体的深度(单位为米),y轴表示激光雷达与单目相机流程得到的三维位置之间的欧几里得距离。该图表包含104个作为数据点的物理锥体。此外,我们对数据拟合了一条二阶曲线,其主要成分为线性成分。平均而言,在距自车10米的距离处差异约为0.5米,在16米距离处仅约1米。该误差足够小,使得自动驾驶汽车能够在两侧布满锥桶的赛道上以高于50公里/小时的速度行驶。

E. 扩展感知范围

该方法的目标之一是扩展感知范围。在图8中,我们比较了单目相机与立体视觉流程的感知范围差异。我们提出的基于单目相机的方法相比基于立体相机的标准三角测量方案具有更大的感知范围。此外,单目相机的焦距比立体相机更长。如果立体相机对也采用更长的焦距,则视场角会减小,从而引入盲区,导致立体相机无法进行三角测量。

F. 二维边界框对三维估计的影响

如前所述,我们希望了解子模块对最终三维位置估计的影响。在此,我们回溯分析目标检测子模块输出的变异 性(不精确)如何影响结果。

边界框)会影响3D位置。在此实验中,我们根据边界框在相应方向上的高度和宽度,随机扰动边界框的边缘。由于传感器的固有特性,使用摄像头的原始数据估计深度最具挑战性。图9显示了对于单幅图像,以一定量(±1%、±5% 和 ±10%以及 ±20%)扰动边界框如何影响深度估计的方差。如预期所示,扰动越大,深度估计的方差也越大。然而,即使在 ±20%扰动下,在15米处的方差也约为1米²。图9表明,即使边界框不精确且存在变化,圆锥的深度仍然保持一致且方差较低。

有关检测、回归、三维位置估计、建图和最终导航的更多可视化内容,请访问项目页面 http://people.ee.ethz.ch/~tracezuerich/TrafficCone/

VI. 结论

精确的实时3D姿态估计可用于从增强现实到自动驾驶等多个应用领域。我们提出了一种新颖的关键点回归方案,通过利用交比损失项形式的几何结构来提取特定特征点。该方法可扩展至不同物体,以通过单目相机并利用物体结构先验来估计3D姿态。我们展示了该网络学习关键点空间排列的能力,并在具有挑战性的情况下仍能实现鲁棒回归。为验证所提出流水线的有效性和精度,我们在一辆实时自主赛车上部署了该方法。

致谢。我们感谢AMZ无人驾驶团队的支持。本工作还通过TRACE‐苏黎世项目获得了丰田汽车欧洲公司的资助。

17

17

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?