点击上方“芋道源码”,选择“设为星标”

管她前浪,还是后浪?

能浪的浪,才是好浪!

每天 10:33 更新文章,每天掉亿点点头发...

源码精品专栏

来源:telami.cn/2019/mysql-

removes-duplicate -data-

and-keeping-only-one/

在公司加班到八点,此为背景。

加班原因是上线,解决线上数据库存在重复数据的问题,发现了程序的bug,很好解决,有点问题的是,修正线上的重复数据。

线上库有6个表存在重复数据,其中2个表比较大,一个96万+、一个30万+,因为之前处理过相同的问题,就直接拿来了上次的Python去重脚本,脚本很简单,就是连接数据库,查出来重复数据,循环删除。

emmmm,但是这个效率嘛,实在是太低了,1秒一条,重复数据大约2万+,预估时间大约在8个小时左右。。。

盲目依靠前人的东西,而不去自己思考是有问题的!总去想之前怎么可以,现在怎么不行了,这也是有问题的!我发现,最近确实状态不太对,失去了探索和求知的欲望,今天算是一个警醒,颇有迷途知返的感觉。

言归正传,下面详细介绍去重步骤。

CREATE TABLE `animal` (

`id` int(11) NOT NULL AUTO_INCREMENT,

`name` varchar(20) DEFAULT NULL,

`age` int(11) DEFAULT NULL,

PRIMARY KEY (`id`)

) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8 COLLATE=utf8_bin;

INSERT INTO `pilipa_dds`.`student` (`id`, `name`, `age`) VALUES ('1', 'cat', '12');

INSERT INTO `pilipa_dds`.`student` (`id`, `name`, `age`) VALUES ('2', 'dog', '13');

INSERT INTO `pilipa_dds`.`student` (`id`, `name`, `age`) VALUES ('3', 'camel', '25');

INSERT INTO `pilipa_dds`.`student` (`id`, `name`, `age`) VALUES ('4', 'cat', '32');

INSERT INTO `pilipa_dds`.`student` (`id`, `name`, `age`) VALUES ('5', 'dog', '42');目标:我们要去掉name相同的数据。

先看看哪些数据重复了

SELECT name,count( 1 )

FROM

student

GROUP BY

NAME

HAVING

count( 1 ) > 1;输出:

name count(1) cat 2 dog 2

name为cat和dog的数据重复了,每个重复的数据有两条;

Select * From 表 Where 重复字段 In (Select 重复字段 From 表 Group By 重复字段 Having Count(1)>1)删除全部重复数据,一条不留

直接删除会报错

DELETE

FROM

student

WHERE

NAME IN (

SELECT NAME

FROM

student

GROUP BY

NAME

HAVING

count( 1 ) > 1)报错:

1093 - You can't specify target table 'student' for update in FROM clause, Time: 0.016000s

原因是:更新这个表的同时又查询了这个表,查询这个表的同时又去更新了这个表,可以理解为死锁。mysql不支持这种更新查询同一张表的操作

解决办法:把要更新的几列数据查询出来做为一个第三方表,然后筛选更新。

DELETE

FROM

student

WHERE

NAME IN (

SELECT

t.NAME

FROM

( SELECT NAME FROM student GROUP BY NAME HAVING count( 1 ) > 1 ) t)推荐下自己做的 Spring Boot 的实战项目:

https://github.com/YunaiV/ruoyi-vue-pro

删除表中删除重复数据,仅保留一条

在删除之前,我们可以先查一下,我们要删除的重复数据是啥样的

SELECT

*

FROM

student

WHERE

id NOT IN (

SELECT

t.id

FROM

( SELECT MIN( id ) AS id FROM student GROUP BY `name` ) t

)啥意思呢,就是先通过name分组,查出id最小的数据,这些数据就是我们要留下的火种,那么再查询出id不在这里面的,就是我们要删除的重复数据。

推荐下自己做的 Spring Cloud 的实战项目:

https://github.com/YunaiV/onemall

开始删除重复数据,仅留一条

很简单,刚才的select换成delete即可

DELETE

FROM

student

WHERE

id NOT IN (

SELECT

t.id

FROM

( SELECT MIN( id ) AS id FROM student GROUP BY `name` ) t

)90万+的表执行起来超级快。

All done 👏👏👏👏~

- END -欢迎加入我的知识星球,一起探讨架构,交流源码。加入方式,长按下方二维码噢:

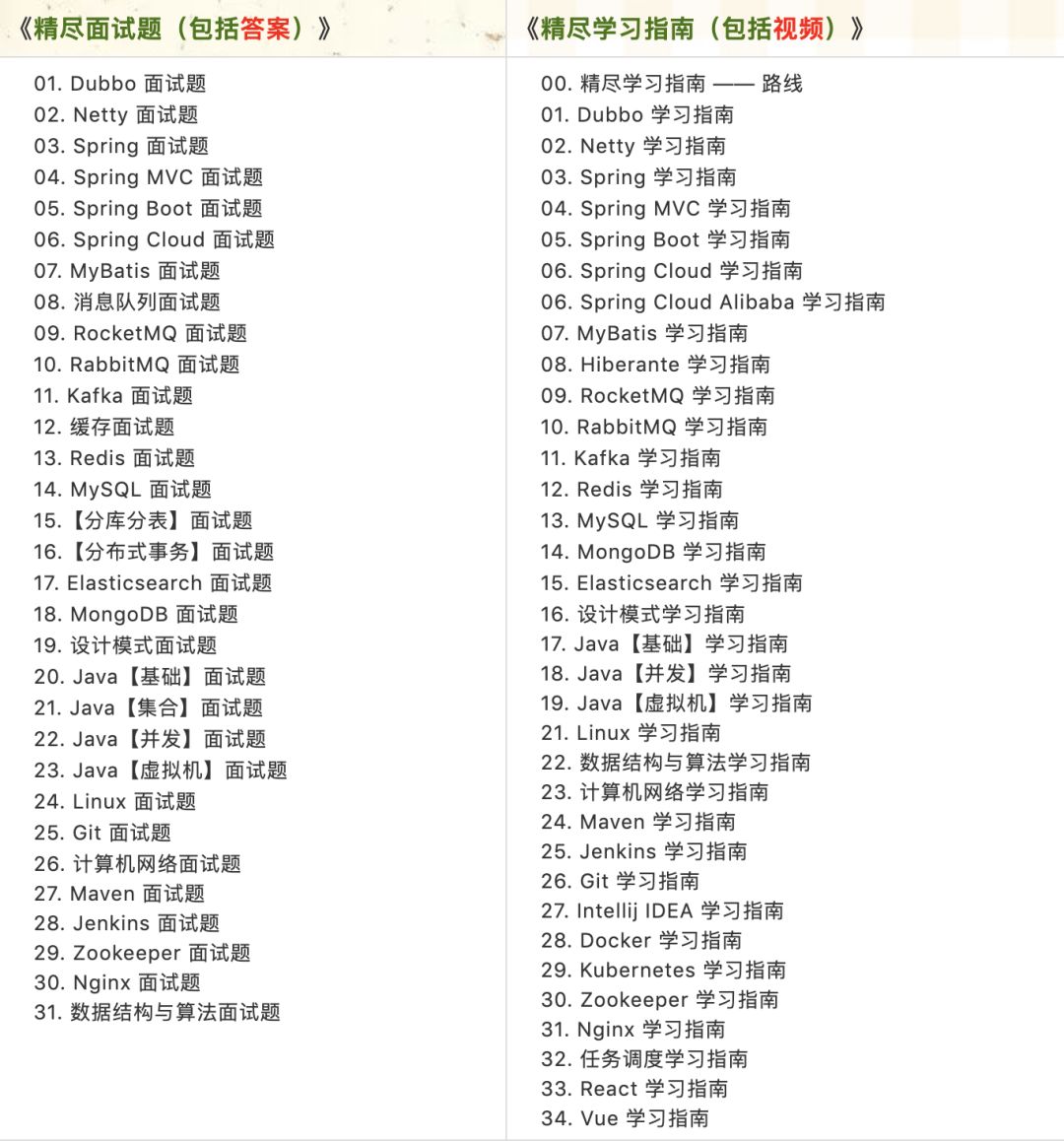

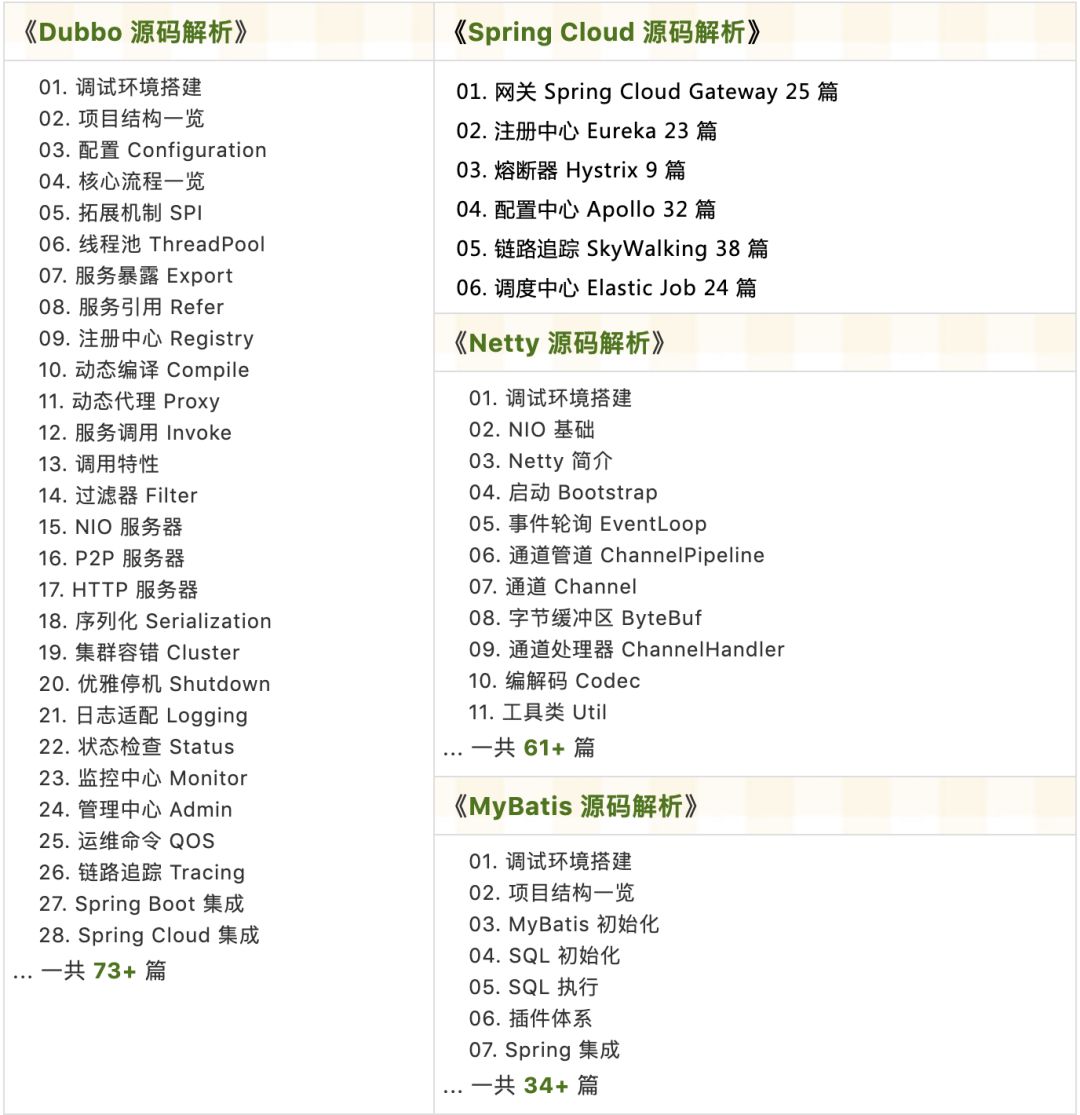

已在知识星球更新源码解析如下:

最近更新《芋道 SpringBoot 2.X 入门》系列,已经 101 余篇,覆盖了 MyBatis、Redis、MongoDB、ES、分库分表、读写分离、SpringMVC、Webflux、权限、WebSocket、Dubbo、RabbitMQ、RocketMQ、Kafka、性能测试等等内容。

提供近 3W 行代码的 SpringBoot 示例,以及超 4W 行代码的电商微服务项目。

获取方式:点“在看”,关注公众号并回复 666 领取,更多内容陆续奉上。

文章有帮助的话,在看,转发吧。

谢谢支持哟 (*^__^*)

本文介绍了如何在MySQL中高效地删除重复数据,通过创建临时表和使用子查询来避免直接更新导致的错误。首先,通过查询找出重复数据,然后删除除最小ID外的重复记录,确保只保留一条。此外,还分享了作者在处理大量数据时的经验和反思。

本文介绍了如何在MySQL中高效地删除重复数据,通过创建临时表和使用子查询来避免直接更新导致的错误。首先,通过查询找出重复数据,然后删除除最小ID外的重复记录,确保只保留一条。此外,还分享了作者在处理大量数据时的经验和反思。

1880

1880

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?