Policy Gradient Theorem Explained

Policy Gradient Thorem Explained

视频很容易懂,但看得我很有睡意可能英语不够好吧,所以总结一下做个笔记-.-!

Intro

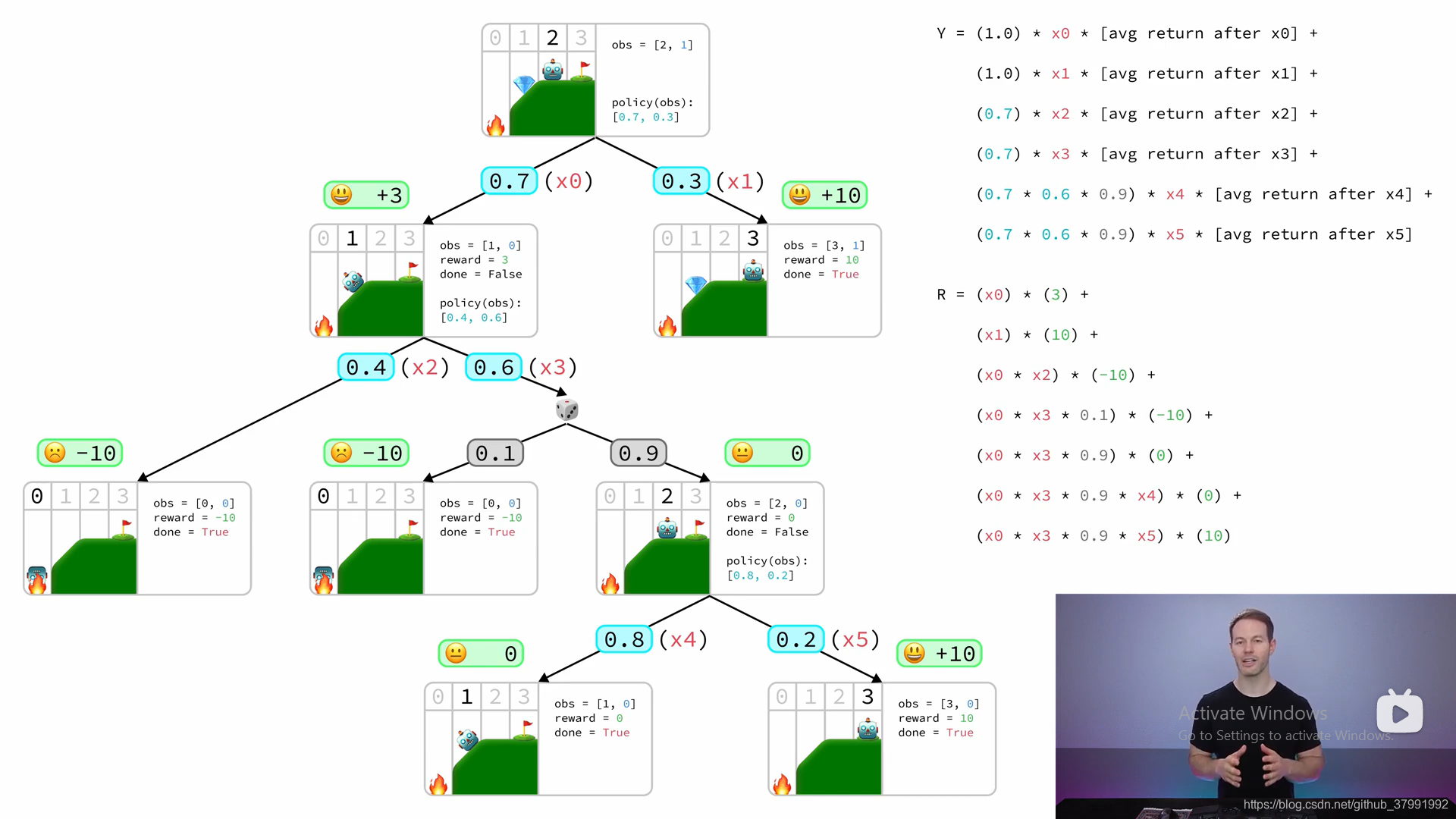

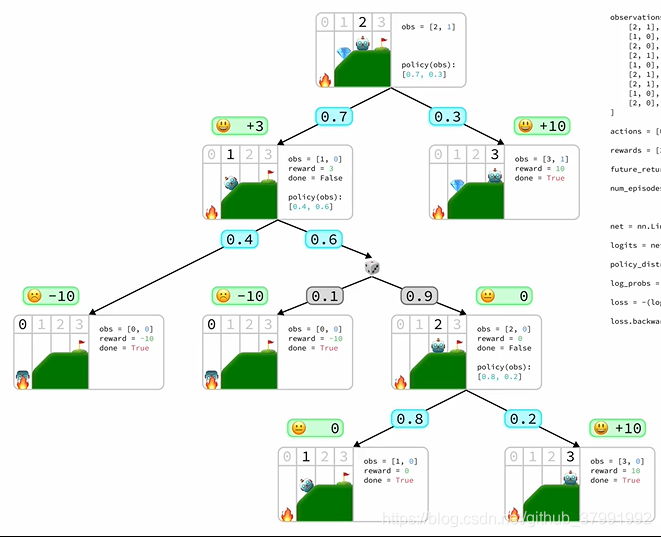

首先定义了这样一种游戏规则

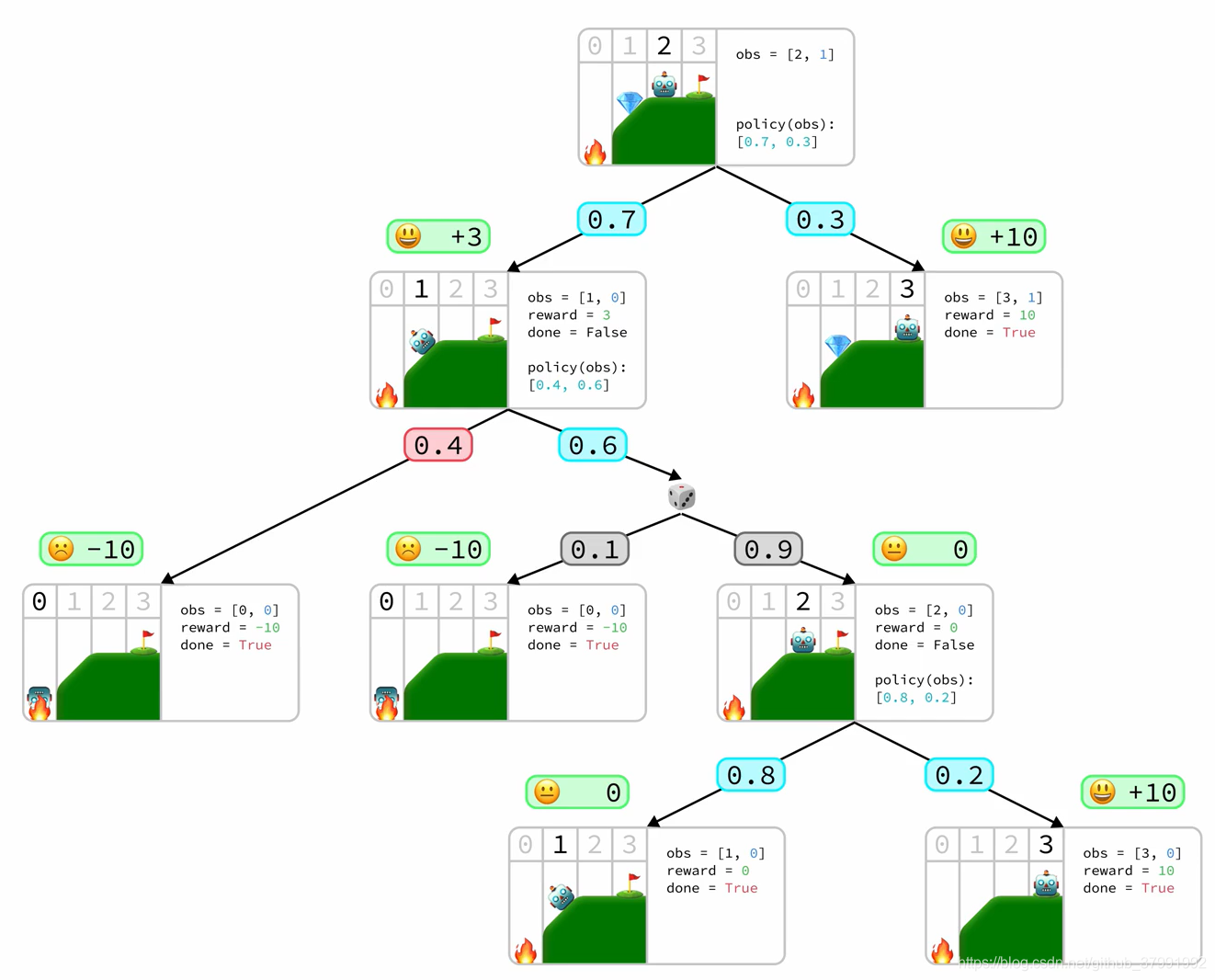

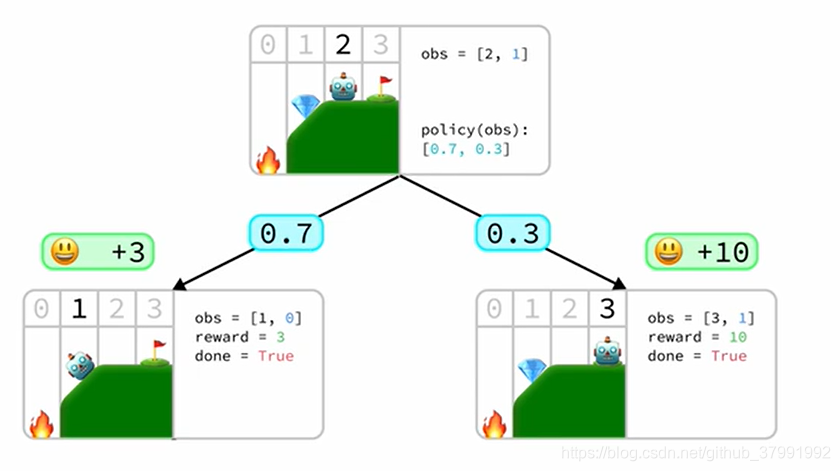

这个游戏有这样几种可能性

数学推导

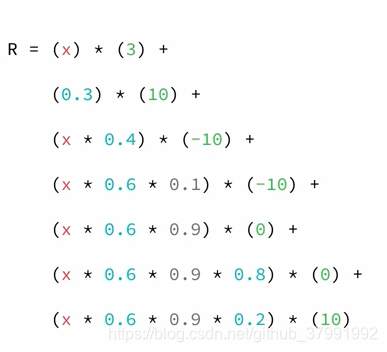

Expected Result: 指得是一路上概率(pro)*奖励(reward)的和

比如上图右下 R = 0.3 x 10

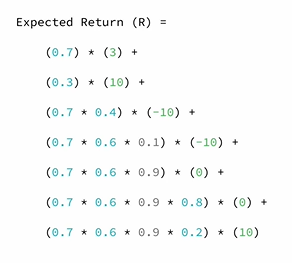

所以全部的Expected Result为:

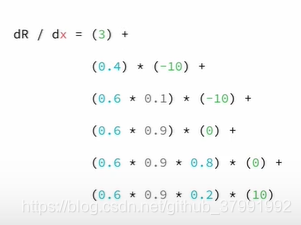

然后做偏导,做backpropogation

以action=1 概率为0.7为例,我们替换所有的0.7为X

则偏导为:

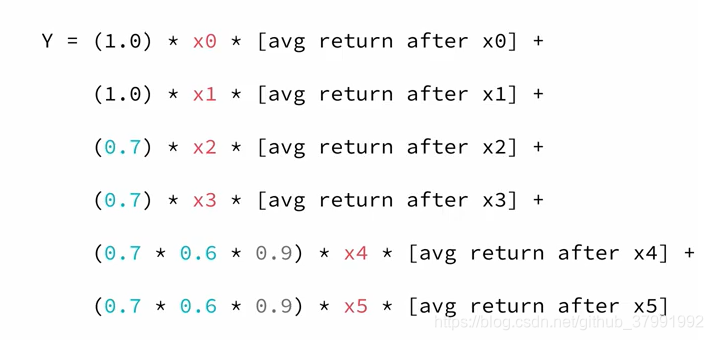

当这些那么把所有的 概率值 改为要学习和调节的 变量:

则整个网络的公式应该为:

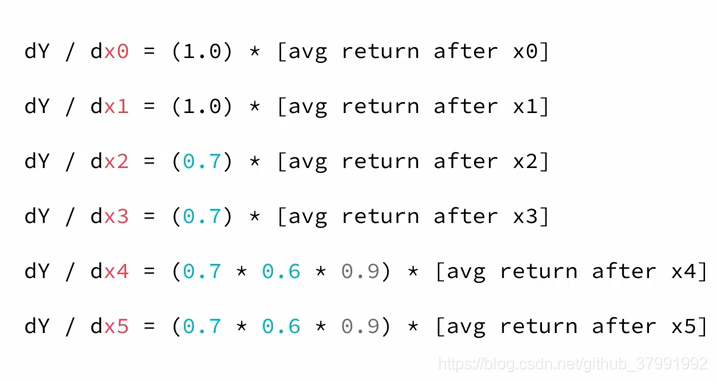

对每个变量做偏导,用来更新 weights 和 bias

如果多次采样:

不太懂为啥要变log(我好菜…)

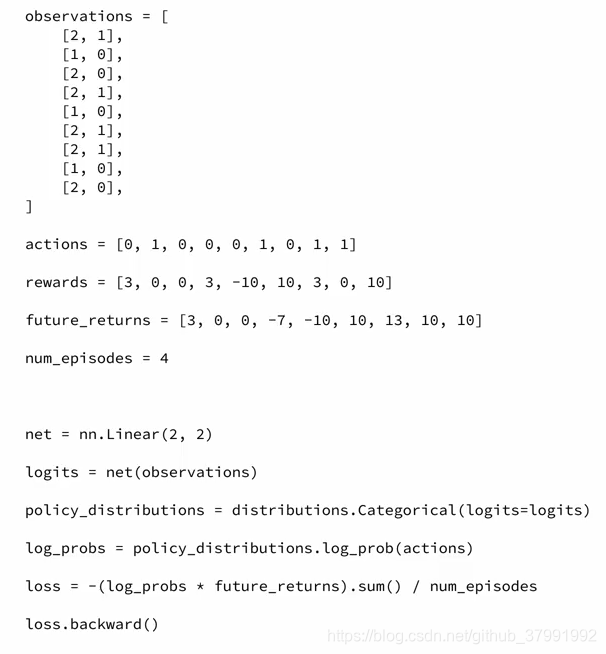

代码实现

本文解释了如何运用Policy Gradient定理来调整游戏策略,通过数学推导和代码示例展示了如何通过概率和奖励计算Expected Result,并用偏导数更新权重和偏差。适合理解基础的英语读者或希望掌握强化学习算法的读者。

本文解释了如何运用Policy Gradient定理来调整游戏策略,通过数学推导和代码示例展示了如何通过概率和奖励计算Expected Result,并用偏导数更新权重和偏差。适合理解基础的英语读者或希望掌握强化学习算法的读者。

910

910

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?