3. 常见问题

3.1 val_loss曲线或val_acc曲线震荡不平滑

原因可能如下:

- 学习率可能太大

- batch size太小

- 样本分布不均匀

- 缺少加入正则化

- 数据规模较小

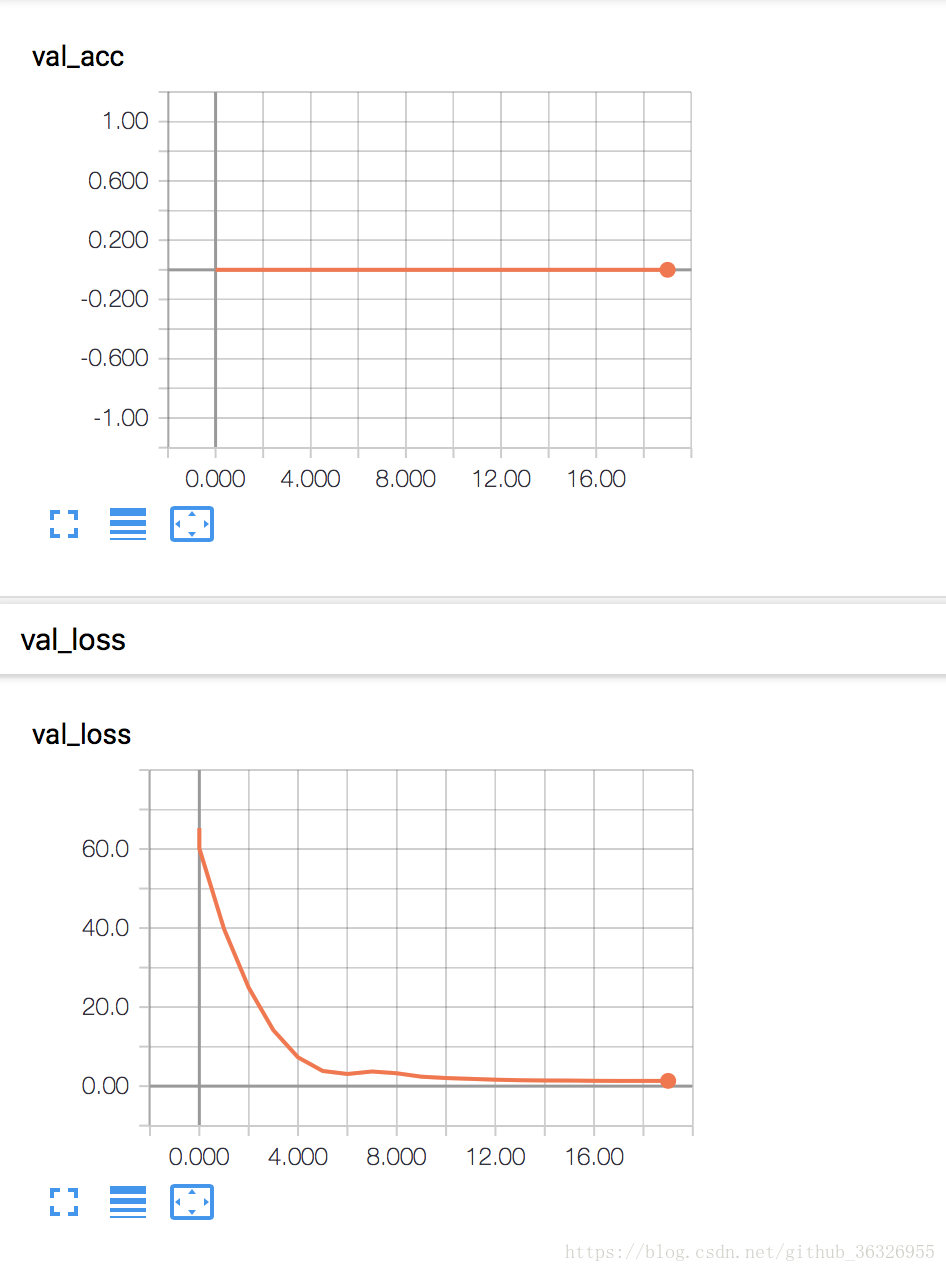

3.2 val_acc几乎为0

一种很重要的原因是数据split的时候没有shuffle

import numpy as np

index = np.arange(data.shape[0])

np.random.seed(1024)

np.random.shuffle(index)

data=data[index]

labels=labels[index]

3.3 训练过程中loss数值为负数?

原因:输入的训练数据没有归一化造成

解决方法:把输入数值通过下面的函数过滤一遍,进行归一化

#数据归一化

def data_in_one(inputdata):

inputdata = (inputdata-inputdata.min())/(inputdata.max()-inputdata.min())

return inputdata 3.4 怎么看loss和acc的变化(loss几回合就不变了怎么办?)

- train loss 不断下降,test loss不断下降,说明网络仍在学习;

- train loss 不断下降,test loss趋于不变,说明网络过拟合;

- train loss 趋于不变,test loss不断下降,说明数据集100%有问题;

- train loss 趋于不变,test loss趋于不变,说明学习遇到瓶颈,需要减小学习率或批量数目;

- train loss 不断上升,test loss不断上升,说明网络结构设计不当,训练超参数设置不当,数据集经过清洗等问题。

3.5 训练中发现loss的值为NAN,这时可能的原因如下:

- 学习率太高

- 如果是自己定义的损失函数,这时候可能是你设计的损失函数有问题

一般来说,较高的acc对应的loss较低,但这不是绝对,毕竟他们是两个不同的东西,所以在实际实现中,我们可以对两者进行一个微调。

3.6 epoch轮数/BN/dropout/

关于epoch设置问题,我们可以设置回调函数,选择验证集最高的acc作为最优模型。

关于BN和dropout,其实这两个是两个完全不同的东西,BN针对数据分布,dropout是从模型结构方面优化,所以他们两个可以一起使用,对于BN来说其不但可以防止过拟合,还可以防止梯度消失等问题,并且可以加快模型的收敛速度,但是加了BN,模型训练往往会变得慢些。

3.7 深度网络的过拟合问题讨论

3.7.1 加入Dropout层

代码示意:

……

from keras.layers import Concatenate,Dropout

……

concatenate = Concatenate(axis=2)([blstm,embedding_layer])

concatenate=Dropout(rate=0.1)(concatenate)3.7.2 检查数据集是否过小(Data Augmentation)

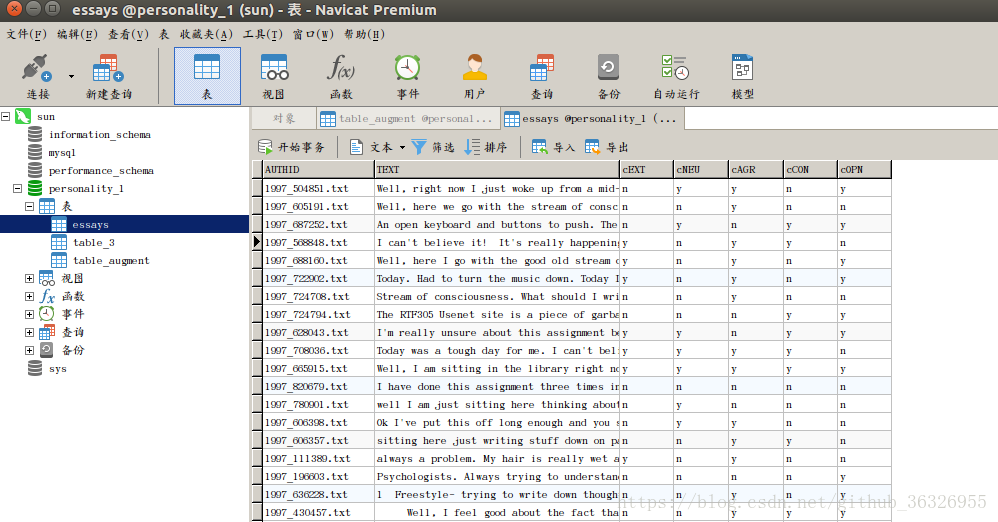

下面这段代码是我对自己实验数据做的augmentation,可以给大家提供一个参考。首先,我的数据集如图所示:

我的数据库中的essays表中有7列,每一行为一个数据样本,其中第一列AUTHID为样本编号,TEXT为文本内容,后面为文本的标记。对于文本的augmentation,一个比较合理的扩增数据集的方法就是将每一个文本的句子循环移位,这样可以最大限度地保证文本整体的稳定。下面的代码读取essays表格中的样本信息,对文本进行循环移位后存入到table_augment表中。

代码示意:

#!/usr/bin/python

# -*- coding:utf8 -*-

from sqlalchemy import create_engine # mysql orm interface,better than mysqldb

import pandas as pd

import spacy # a NLP model like NLTK,but more industrial.

import json

TO_SQL='table_augment'

READ_SQL_TABLE='essays'

def cut_sentences(df):

all_text_name = df["AUTHID"] # type pandas.Series:get all text name(match the "#AUTHID" in essays)

all_text = df["TEXT"] # type pandas.Series:get all text(match the "TEXT" in essays)

all_label_cEXT=df["cEXT"]

all_label_cNEU=df["cNEU"]

all_label_cAGR=df["cAGR"]

all_label_cCON=df["cCON"]

all_label_cOPN=df["cOPN"]

all_number = all_text_name.index[-1] # from 0 to len(all_text_name)-1

for i in xrange(0,all_number+1,1):

print("start to deal with text ", i ," ...")

text = all_text[i] # type str:one of text in all_text

text_name = all_text_name[i] # type str:one of text_name in all_text_name

nlp = spacy.load('en')

test_doc = nlp(text)#.decode('utf8'))

cut_sentence = []

for sent in test_doc.sents: # get each line in the text

cut_sentence.append(sent.text)

"""

type sent is spacy.tokens.span.Span, not a string,

so, we call the member function Span.text to get its unicode form

"""

line_number = len(cut_sentence)

for itertor in range(line_number):

if itertor !=0:

cut_sentence=cut_sentence[1:]+cut_sentence[:1]

cut_sentence_json = json.dumps(cut_sentence)

input_data_dic = {'text_name': str(itertor)+"_"+text_name,

'line_number':line_number,

'line_text': cut_sentence_json,

'cEXT': all_label_cEXT[i],

'cNEU': all_label_cNEU[i],

'cAGR': all_label_cAGR[i],

'cCON': all_label_cCON[i],

'cOPN': all_label_cOPN[i]

}

input_data = pd.DataFrame(input_data_dic,index=[i],columns=['text_name',

'line_number',

'line_text',

'cEXT',

'cNEU',

'cAGR',

'cCON',

'cOPN'])

input_data.to_sql(TO_SQL, engine, if_exists='append', index=False, chunksize=100)

"""

DataFrame.index will be insert to table by default. We don't want it, so we set the

index = False(True default)

"""

print("text ", i ," finished")

if __name__ =='__main__':

engine = create_engine('mysql+pymysql://root:root@localhost:3306/personality_1?charset=utf8', echo=True,convert_unicode=True)

df = pd.read_sql_table(READ_SQL_TABLE, engine,chunksize=5) # read essays

for df_iter in df:

cut_sentences(df_iter)

3.7.3 用一用迁移学习的思想

具体来讲就是model.load人家训练好的weight.hdf5,然后在这个基础上继续训练。具体可以见之后的博文中的断点训练。

3.7.4 调参小tricks.

调小学习速率(Learning Rate)之前已经讲过不在赘述

适当增大batch_size。之前已经讲过不在赘述

试一试别的优化器(optimizer)之前已经讲过不在赘述

Keras的回调函数EarlyStopping() 之前已经讲过,不再赘述

3.7.5 正则化方法

正则化方法是指在进行目标函数或代价函数优化时,在目标函数或代价函数后面加上一个正则项,一般有L1正则与L2正则等。

代码片段示意:

from keras import regularizers

……

out = TimeDistributed(Dense(hidden_dim_2,

activation="relu",

kernel_regularizer=regularizers.l1_l2(0.01,0.01),

activity_regularizer=regularizers.l1_l2(0.01,0.01)

)

)(concatenate)

……

dense=Dense(200,

activation="relu",

kernel_regularizer=regularizers.l1_l2(0.01,0.01),

activity_regularizer=regularizers.l1_l2(0.01,0.01)

)(dense)更多参考信息:

https://blog.youkuaiyun.com/mrgiovanni/article/details/52167016

本文解答了深度学习训练过程中的常见问题,包括val_loss曲线震荡、val_acc接近0、loss值为负数或NAN等问题的原因及解决方案。同时介绍了如何观察loss和acc变化,以及如何处理过拟合问题。

本文解答了深度学习训练过程中的常见问题,包括val_loss曲线震荡、val_acc接近0、loss值为负数或NAN等问题的原因及解决方案。同时介绍了如何观察loss和acc变化,以及如何处理过拟合问题。

9万+

9万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?