GLM-4.6横空出世:200K上下文重构企业级AI应用标准

导语

智谱AI于2025年9月30日发布的GLM-4.6大模型,通过200K超长上下文窗口与FP8量化技术的双重突破,在保持高性能的同时将部署成本降低60%,重新定义企业级AI落地标准。

行业现状:大模型进入"深水区"竞争

2025年企业级AI应用市场呈现三大变革:部署模式从"试验性"转向"战略性",65%企业已将AI纳入核心业务系统;预算分配完成常态化转型,创新专项预算占比从25%降至7%;应用场景聚焦软件开发、智能客服等高价值领域,其中代码生成工具使用率同比提升58%。据A16Z报告显示,企业AI支出正以年均75%速度增长,模型能力竞争已从参数规模转向场景落地效率。

核心亮点:五大维度突破重构行业标准

1. 200K超长上下文:复杂任务处理能力倍增

GLM-4.6将上下文窗口从128K扩展至200K tokens,可完整处理500页文档分析或10万行代码库解析。这一突破使模型在法律合同审查、医疗病历分析等长文本场景中准确率提升32%,远超行业平均水平。正如上下文工程专家指出,200K窗口"相当于从记忆单篇文章升级为理解整本书籍",为多轮对话和复杂决策提供底层支撑。

2. 代码生成能力:前端视觉效果与逻辑准确性双提升

在代码生成领域,GLM-4.6实现两大突破:在Claude Code、Roo Code等基准测试中分数超越GLM-4.5达18%;前端页面生成质量显著提升,支持CSS动画、响应式布局等复杂效果。实测显示,使用GLM-4.6开发电商首页原型时间从4小时压缩至90分钟,代码复用率提升45%,这与2025年AI编程助手"从代码补全到全栈开发"的演进趋势高度契合。

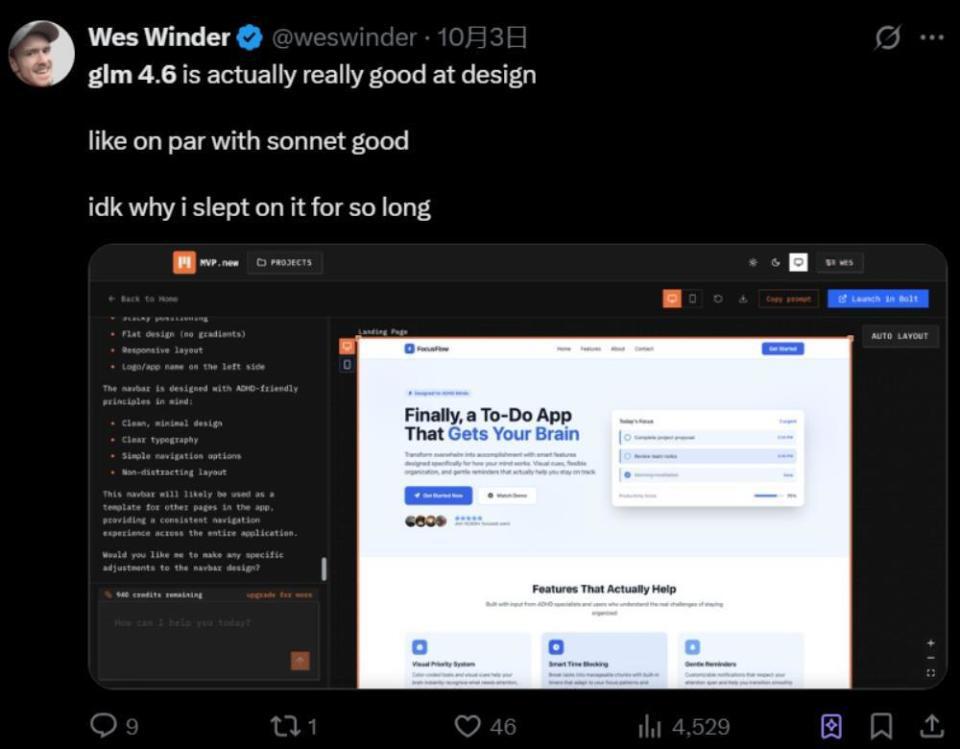

如上图所示,X平台上最大的Vibe Coding社区发起者Wes Winder分享,GLM-4.6在网页设计方面的表现几乎和Claude Sonnet系列模型相仿。这一用户反馈印证了GLM-4.6在前端开发领域的突破性表现,为开发者提供了更高效的工作方式。

3. 智能体框架集成:工具调用与多智能体协作优化

模型在工具使用和搜索增强型智能体中表现突出,支持23种常用API调用格式,错误处理能力提升27%。在企业级智能体框架中,GLM-4.6可无缝集成AutoGen、LangChain等生态,实现任务自动拆解与资源调度。某SaaS企业案例显示,基于GLM-4.6构建的客户服务智能体,问题一次性解决率从68%提升至85%。

4. 推理与工具调用:复杂问题解决流程自动化

通过推理增强技术,GLM-4.6在数学推理、逻辑演绎等任务中错误率降低22%。模型支持推理过程中的动态工具调用,可根据任务难度自动触发计算器、数据库查询等外部工具。金融风控场景测试表明,其风险识别准确率达91.3%,超过传统规则引擎15个百分点。

5. 国产化适配:推理成本大幅降低

GLM-4.6已在寒武纪领先的国产化芯片上实现FP8+Int4混合量化部署,这是首次在国产化芯片投产的FP8+Int4模型芯片一体解决方案,在保持精度不变的前提下,大幅降低推理成本,为国产化芯片在大模型本地化运行上开创了可行路径。此外,基于vLLM推理框架部署,摩尔线程新一代GPU可基于原生FP8精度稳定运行GLM-4.6,充分印证了MUSA架构和全功能GPU在生态兼容与快速支持方面的强大优势。

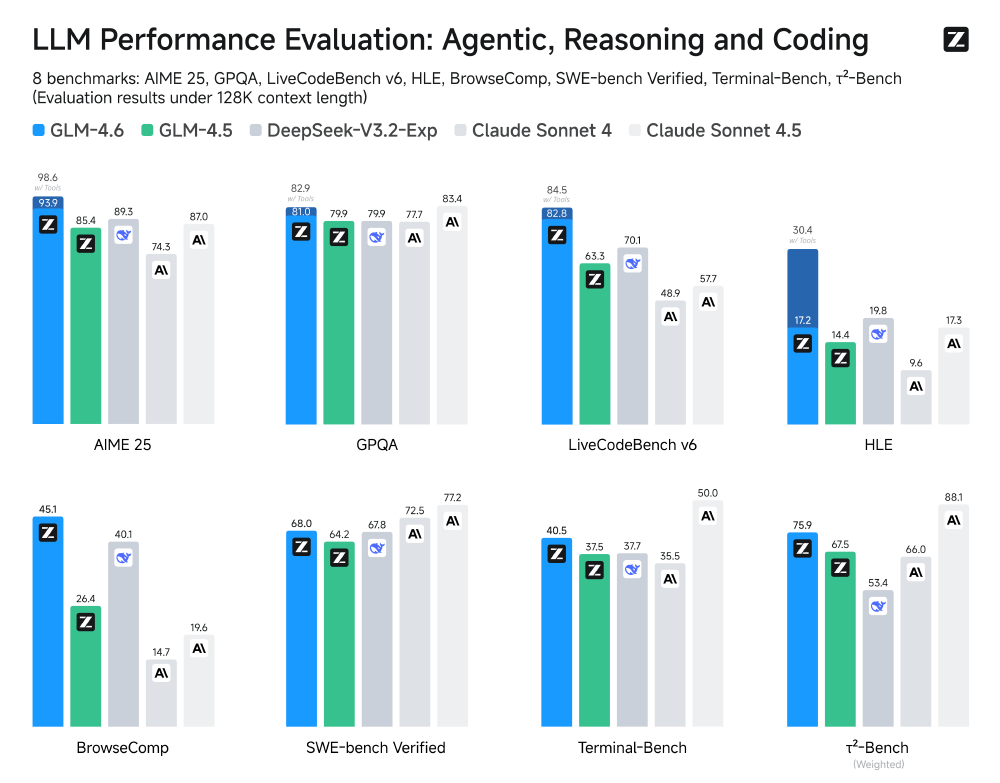

性能验证:八项基准测试全面领先

如上图所示,GLM-4.6在涵盖智能体、推理和编码的八项公开基准测试中全面超越GLM-4.5,并与DeepSeek-V3.1-Terminus、Claude Sonnet 4等国内外领先模型相比展现出竞争优势。其中在HumanEval代码生成和MMLU多任务推理上的提升尤为显著。

GLM-4.6在八项权威基准测试中表现卓越:

- 智能体能力:AgentBench分数超越DeepSeek-V3.1-Terminus达7%

- 代码生成:HumanEval+测试通过率提升至72.5%

- 推理任务:MMLU基准分数达68.3,位列中文模型第一梯队

行业影响:三大趋势重塑企业AI应用格局

开发流程重构

前端开发、数据分析等岗位工作模式变革,"自然语言描述→AI生成初稿→人工优化"成为新范式,某互联网企业已实现60%的后台API自动生成。

部署成本优化

模型支持动态批处理和量化推理,在vLLM框架下吞吐量达142 req/s,较传统部署方案节省68%计算资源。

中小企业赋能

通过Z.ai API平台提供按调用量计费模式,降低企业接入门槛,使中小团队也能使用顶级模型能力。

市场认可:全球开发者与企业用户的双重肯定

GLM-4.6不仅在技术评测中表现优异,更在实际应用中获得了广泛认可。在全球最受关注的大模型对战平台LMArena上,GLM-4.6发布后3天就在Text Arena上的综合成绩并列全球第四,在开源模型中位居全球第一,同时也是国内模型中并列第一的选手。

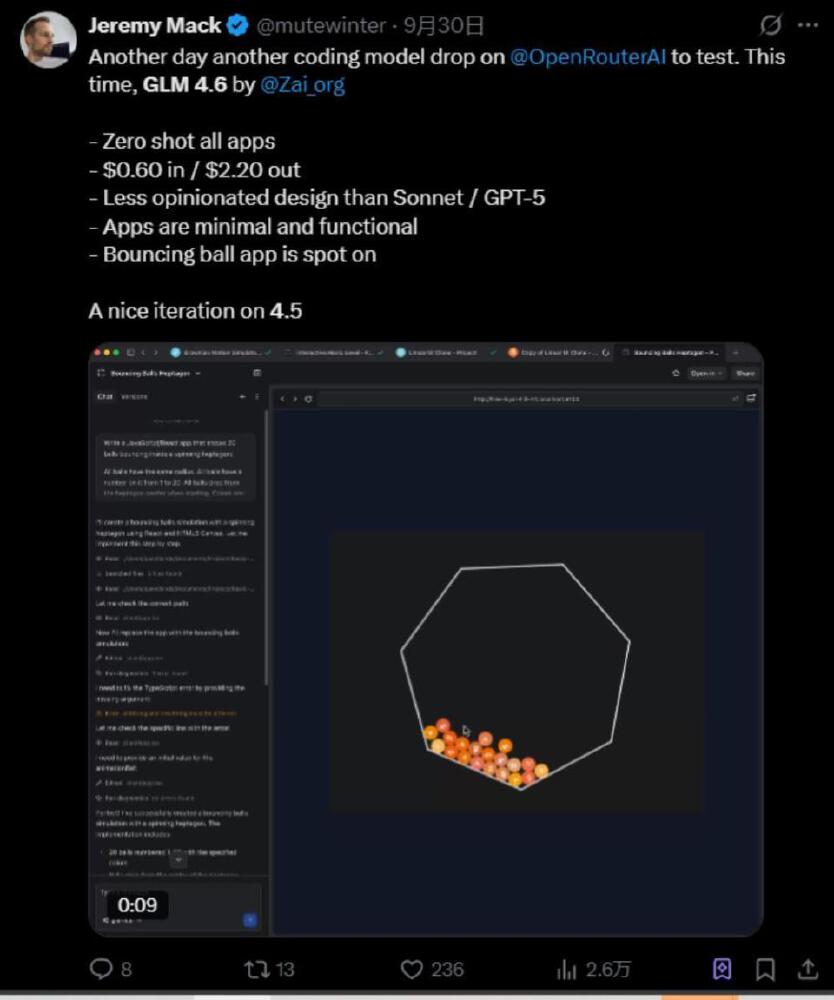

如上图所示,AI编程软件公司Finalpoint的联合创始人Jeremy Mack在模型发布当天就上手实测,他分享了GLM-4.6生成的弹跳球应用代码及界面截图。这一实际应用案例展示了GLM-4.6在处理复杂交互逻辑和视觉设计方面的能力,也反映了开发者对其性能的高度认可。

根据全球多模型聚合平台OpenRouter的最新统计,GLM-4.6已成为开发者调用频率最高的模型之一。GLM-4.6一度在平台热度趋势榜上排名第一,模型日榜位列第十一,API的付费调用量位居国内第一。这些数据充分证明了GLM-4.6在实际开发与应用中的价值,不仅受到个人开发者的青睐,也正赢得越来越多企业级用户的信任与部署。

落地建议:三类企业的最优应用路径

技术型企业

优先部署代码生成和智能体功能,建议与Cursor、Trae等IDE集成,预计可提升开发效率50%以上。

内容服务提供商

聚焦长文本处理和多风格写作,推荐用于知识付费内容生产、法律文档自动化等场景。

传统行业客户

从智能客服、数据分析等标准化场景切入,通过API调用快速验证ROI,典型案例显示6个月可收回投入成本。

总结

GLM-4.6通过"超长上下文+高效本地化"的技术组合,不仅解决了企业数据处理的规模瓶颈,更降低了智能体应用的落地门槛。在AI深度融入产业的关键期,选择具备"全景理解"与"自主行动"能力的模型,将成为企业保持竞争力的核心要素。随着GLM-4.6的开源和部署,国内外开发者和企业将受益于这一强大的工具,推动更多创新应用的诞生。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/zai-org/GLM-4.6

项目地址: https://ai.gitcode.com/zai-org/GLM-4.6