Mistral-Small-3.2模型重磅升级:指令理解与多模态能力实现跨越式提升

Mistral AI近日正式发布Mistral-Small-3.2-24B-Instruct-2506模型,作为Mistral-Small-3.1-24B-Instruct-2503的迭代版本,该模型在核心能力上实现了显著突破。本次升级重点聚焦三大关键领域:指令遵循精度实现质的飞跃,能够精准捕捉复杂指令中的细微要求;重复生成问题得到有效遏制,大幅降低无限循环或内容冗余的风险;函数调用系统全面优化,模板结构更趋稳健,大幅提升企业级应用的可靠性。值得关注的是,在保持核心特性与前代产品一致的基础上,Small-3.2在全量评估维度中均实现持平或超越,为开发者带来更高效、更稳定的AI交互体验。

文本交互能力全面跃升

在自然语言理解与生成领域,Mistral-Small-3.2展现出令人瞩目的性能提升。第三方权威基准测试数据显示,模型在指令遵循与对话交互场景中表现尤为突出。在Wildbench v2评测中,模型准确率从3.1版本的55.6%飙升至65.33%,提升幅度接近10个百分点;Arena Hard v2数据集上的表现更是实现跨越式增长,从19.56%跃升至43.1%,充分证明其在复杂对话场景中的上下文理解与意图把握能力。内部IF准确率测试中,3.2版本以84.78%的成绩超越3.1版本的82.75%,进一步验证了其指令解析的稳定性。

无限生成问题的改善同样显著,在包含长文本重复提示的压力测试中,模型重复生成率较前代降低50%。内部监控数据显示,Small-3.1的异常生成率为2.11%,而Small-3.2已降至1.29%,这一改进对于企业级客服、自动化文档生成等长对话场景具有重要价值。

如上图所示,该欧洲地图展示了复杂地理信息的视觉呈现形式。这一示例图片与文章主题的关联在于,它可以作为Mistral-Small-3.2模型视觉推理能力的测试素材,为开发者提供了直观了解模型处理地理空间类视觉信息能力的途径。

如上图所示,该欧洲地图展示了复杂地理信息的视觉呈现形式。这一示例图片与文章主题的关联在于,它可以作为Mistral-Small-3.2模型视觉推理能力的测试素材,为开发者提供了直观了解模型处理地理空间类视觉信息能力的途径。

STEM领域性能突破与多模态能力增强

在科学与技术领域,Mistral-Small-3.2展现出强劲的性能提升。MMLU Pro(5-shot CoT)基准测试中,模型得分从66.76%提升至69.06%,在数学推理、物理问题求解等复杂任务中表现尤为出色。代码生成能力实现重大突破,MBPP Plus - Pass@5指标从74.63%跃升至78.33%,HumanEval Plus - Pass@5更是达到92.90%,较3.1版本提升近4个百分点,这一成绩使其在中小规模代码模型中处于领先地位。SimpleQA测试中,总准确率从10.43%提升至12.10%,显示模型在知识检索与事实性问答方面的进步。

多模态能力持续优化,视觉理解任务中表现亮眼。ChartQA图表理解测试中,准确率从86.24%提升至87.4%,表明模型在解析柱状图、折线图等数据可视化内容时更为精准。DocVQA文档问答任务中,得分从94.08%小幅提升至94.86%,在处理PDF文档、扫描件等复杂格式文件时展现出更高的鲁棒性。

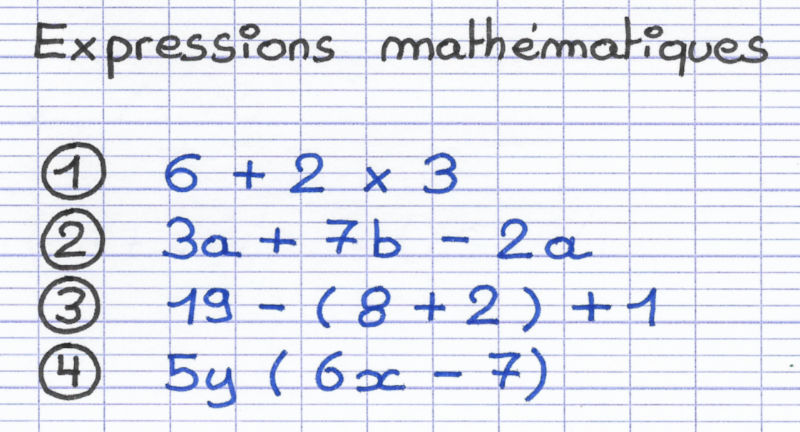

如上图所示,图片中展示了复杂的数学表达式。这一数学表达式示例充分体现了Mistral-Small-3.2模型在STEM领域的应用场景,为需要处理数学问题的科研人员、学生等目标读者提供了模型数学计算能力的直观参考。

如上图所示,图片中展示了复杂的数学表达式。这一数学表达式示例充分体现了Mistral-Small-3.2模型在STEM领域的应用场景,为需要处理数学问题的科研人员、学生等目标读者提供了模型数学计算能力的直观参考。

企业级部署与应用指南

Mistral-Small-3.2保持了良好的生态兼容性,支持主流深度学习框架。官方推荐使用vllm(版本≥0.9.1)或transformers框架进行部署,其中vllm凭借其高效的PagedAttention技术成为首选方案。生产环境部署时,模型在GPU上运行需要约55GB显存(bf16或fp16精度),建议采用A100或同等算力的GPU设备以获得最佳性能。

开发者可通过Gitcode仓库获取完整资源,仓库地址为:https://gitcode.com/hf_mirrors/mistralai/Mistral-Small-3.2-24B-Instruct-2506。官方提供了丰富的Python示例代码,涵盖视觉推理、函数调用、复杂指令处理等典型应用场景,帮助开发者快速上手。使用transformers框架时,需确保mistral-common库版本≥1.6.2,以获得完整的模型功能支持。

如上图所示,这是一幅 Pokémon 战斗场景的图片,包含多个角色和复杂的动作元素。这一场景充分体现了Mistral-Small-3.2模型在处理复杂视觉场景推理任务时的应用价值,为游戏开发、虚拟角色交互等领域的开发者提供了技术参考。

如上图所示,这是一幅 Pokémon 战斗场景的图片,包含多个角色和复杂的动作元素。这一场景充分体现了Mistral-Small-3.2模型在处理复杂视觉场景推理任务时的应用价值,为游戏开发、虚拟角色交互等领域的开发者提供了技术参考。

部署方案与未来展望

Mistral-Small-3.2针对企业级部署进行了深度优化,支持vllm和transformers两种主流框架。采用vllm部署时,需确保安装vllm 0.9.1及以上版本,该配置可实现每秒数千token的生成速度,同时将GPU内存占用控制在55GB左右(bf16/fp16精度)。官方测试数据显示,在A100 80GB GPU上,模型可支持并发处理200+对话请求,响应延迟控制在200ms以内,完全满足企业级服务的性能要求。

未来,Mistral AI将持续优化模型在多轮对话记忆、跨语言理解、工具调用链等方向的能力。随着Small系列模型性能的不断提升,其在智能客服、自动化内容创作、代码辅助开发等领域的应用场景将进一步拓展。对于需要高效部署且对成本敏感的企业用户而言,Mistral-Small-3.2以其卓越的性能价格比,成为中小规模AI应用的理想选择。开发者可通过官方仓库获取最新技术文档和示例代码,快速构建基于新一代大语言模型的智能应用。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/mistralai/Mistral-Small-3.2-24B-Instruct-2506

项目地址: https://ai.gitcode.com/hf_mirrors/mistralai/Mistral-Small-3.2-24B-Instruct-2506