2.6B参数颠覆边缘AI性能天花板:LFM2-2.6B开启终端智能新纪元

【免费下载链接】LFM2-2.6B

导语

Liquid AI推出的LFM2-2.6B轻量级大模型,以26亿参数实现3倍训练速度提升和2倍CPU推理加速,重新定义智能终端本地计算标准,为边缘AI应用开辟新路径。

行业现状:从云端依赖到终端智能的转型浪潮

2025年,全球AI智能终端市场正以爆发式速度增长。根据智研咨询数据,中国AI智能终端市场规模已从2021年的36.66亿元飙升至2024年的2207.85亿元,预计2025年将突破5347.9亿元大关。与此同时,本地AI部署技术在2025年取得显著突破,模型量化技术的成熟使INT4/INT8低精度推理成为主流,专用AI加速芯片(NPU/TPU)的普及降低了硬件门槛。

边缘AI已成为全球数字化变革的核心驱动力。2025年,全球边缘AI市场规模预计突破1800亿美元,中国贡献超35%的份额,年复合增长率维持在28%以上。51CTO在《2025年的五大AI趋势》中指出,"AI驱动的智能手机和笔记本电脑将变得更加强大,减少对持续云访问的需求",这一趋势正推动计算范式从云端集中式向边缘分布式转变。

核心亮点:LFM2-2.6B的四大突破性创新

混合架构设计:卷积与注意力机制的黄金配比

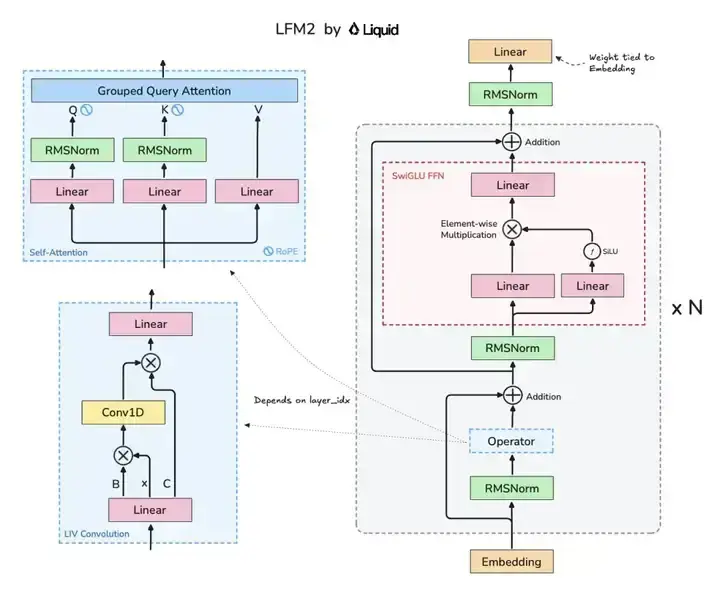

LFM2-2.6B采用创新性的混合Liquid架构,融合了22层卷积块与8层注意力机制,在保持轻量化的同时实现了性能突破。这种架构设计使模型在知识推理、数学计算和多语言能力等关键指标上全面超越同尺寸模型。

如上图所示,该架构图清晰展示了LFM2模型的核心组件布局,包括Grouped Query Attention(GQA)注意力机制与LIV卷积模块的协同设计。这种混合架构是实现小模型高性能的关键,为开发者理解高效模型设计提供了直观参考。

极致性能优化:速度与效率的双重突破

LFM2-2.6B实现了3倍于上一代模型的训练速度,以及2倍于Qwen3的CPU解码速度。在CPU推理吞吐量测试中,LFM2-2.6B在ExecuTorch框架下表现尤为突出。这种性能优势使低端硬件也能流畅运行复杂AI任务,为边缘设备智能化铺平了道路。

LFM2-2.6B在基准测试中展现出超越同规模竞争者的实力:知识与指令跟随方面,MMLU得分64.42,IFEval79.56,Multi-IF22.19;数学能力方面,GSM8K82.41,MGSM74.32;多语言处理方面,MMMLU55.39。整体而言,其输出质量媲美3-4B稠密模型。

多硬件兼容:从手机到汽车的全场景覆盖

LFM2-2.6B针对CPU、GPU和NPU硬件进行了深度优化,可灵活部署于智能手机、笔记本电脑和车载系统等多种设备。模型仅需25.7亿参数即可实现高性能推理,配合INT4量化技术,可在内存受限的嵌入式设备上高效运行。

Liquid AI官方测试数据显示,搭载LFM2-2.6B的中端机型可实现:实时语音翻译(支持8种语言,延迟<300ms)、离线文档理解与摘要生成、设备端健康数据隐私计算分析等功能。

动态混合推理:复杂任务处理的创新方案

LFM2-2.6B是该系列中唯一采用动态混合推理的模型,通过 和标记之间的追踪实现复杂或多语言提示的高效处理。针对边缘场景任务复杂度波动大的特点,模型内置动态混合推理(DHR)机制,通过特殊标记触发多阶段推理流程。在跨语言医疗诊断测试中,该机制使准确率提升17%,同时将单次交互延迟控制在500ms以内。

性能评测:小参数大能力的实证

如上图所示,LFM2-2.6B(橙色线)在2.6B参数点形成明显性能跃升,远超同量级模型并接近4B参数水平。这一现象直观证明了架构优化对边缘AI的关键价值,为开发者提供了参数规模与性能平衡的全新参考。

在与主流竞品的对比中,LFM2-2.6B展现出显著优势:

| Model | MMLU | GPQA | IFEval | IFBench | GSM8K | MGSM | MMMLU |

|---|---|---|---|---|---|---|---|

| LFM2-2.6B | 64.42 | 26.57 | 79.56 | 22.19 | 82.41 | 74.32 | 55.39 |

| Llama-3.2-3B-Instruct | 60.35 | 30.6 | 71.43 | 20.78 | 75.21 | 61.68 | 47.92 |

| SmolLM3-3B | 59.84 | 26.31 | 72.44 | 17.93 | 81.12 | 68.72 | 50.02 |

| gemma-3-4b-it | 58.35 | 29.51 | 76.85 | 23.53 | 89.92 | 87.28 | 50.14 |

行业影响与趋势:开启边缘智能新纪元

LFM2-2.6B的推出恰逢本地AI部署技术爆发期。随着智研咨询预测的AI智能终端市场规模在2025年突破5000亿元,轻量化模型将成为终端智能化的关键引擎。Gartner在《2025年中国人工智能十大趋势》中指出,到2026年中国50%的AI产业生态将基于开放式GenAI模型构建,这为LFM2-2.6B等开源模型提供了广阔舞台。

该图表展示了LFM2系列模型(350M、700M、1.2B、2.6B参数)与其他模型在平均得分上的对比,直观展示LFM2-2.6B在2.6B参数时平均得分显著超过3B参数竞品模型,验证小参数大能力的边缘AI架构优势。

未来,我们将见证三大趋势的融合:模型微型化使AI能力向低端设备渗透,硬件专用化加速AI芯片的普及,部署本地化推动隐私保护与实时响应。这一融合将重塑智能终端产业格局,推动AI从互联网服务向实体设备的全面渗透。

总结与建议:边缘AI时代的战略布局

LFM2-2.6B代表了大模型技术的一个重要方向——在保持性能的同时实现极致压缩。对于企业而言,现在是布局边缘AI的关键时刻:

-

优先考虑本地化部署:利用LFM2-2.6B等轻量化模型,降低对云端服务的依赖,提升数据安全性与系统响应速度。

-

关注硬件-软件协同优化:通过模型量化与专用AI芯片的协同设计,实现性能与效率的平衡。

-

探索垂直领域微调和应用:LFM2-2.6B特别适合在狭窄应用场景下进行微调,企业应重点关注agentic任务、数据提取和RAG等落地场景。

如需开始使用LFM2-2.6B,可通过以下命令从GitCode仓库获取模型: git clone https://gitcode.com/hf_mirrors/LiquidAI/LFM2-2.6B

随着LocalAI等开源生态的成熟,本地化部署门槛将持续降低。LFM2-2.6B的出现,标志着边缘AI从概念走向实用的关键转折点。在这个数据隐私日益重要、终端设备算力持续增强的时代,轻量化、高性能的边缘AI模型将成为智能终端的核心竞争力。

【免费下载链接】LFM2-2.6B

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考