150亿参数颠覆AI格局:Apriel-1.5让中小企业用单GPU跑赢千亿模型

导语

还在为AI部署的高门槛发愁?ServiceNow最新发布的Apriel-1.5-15b-Thinker模型,以150亿参数实现了与千亿级模型相当的推理能力,单GPU部署成本降低90%,重新定义了中小企业AI应用的技术边界。读完本文你将获得:中小企业AI部署的成本优化方案、多模态模型的实际应用案例、以及如何在30分钟内完成企业级AI系统搭建的实操指南。

行业现状:大模型"瘦身革命"全面爆发

2025年,AI行业正经历从"越大越强"到"高效智能"的战略转型。据Anthropic经济指数报告显示,全球企业AI部署率已达67%,但其中92%的中小企业仍受限于算力成本,无法享受前沿AI能力。Global Market Insights数据显示,2025年全球多模态AI市场规模达16亿美元,年增速32.7%,而中小企业渗透率不足15%,主要瓶颈在于传统方案需多GPU集群支持,初始投资动辄超15万元。

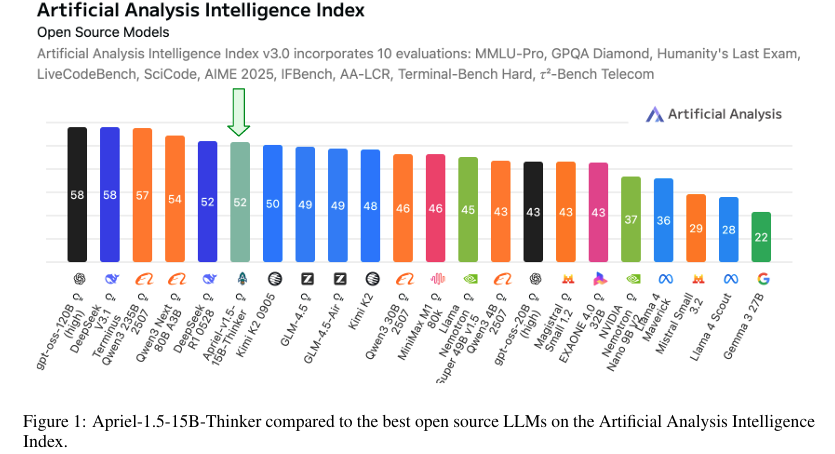

如上图所示,Apriel-1.5-15b-Thinker在Artificial Analysis Intelligence Index上取得52分,与DeepSeek-R1-0528等主流模型持平,但参数规模仅为后者的1/10。这一突破性成果证明,通过训练设计优化,小模型完全可以达到千亿级模型的性能水平。

在此背景下,模型效率革命正在兴起。SiliconFlow 2025年企业级多模态模型报告指出,参数规模与推理性能的非线性关系逐渐显现——紧凑型模型通过架构优化,在特定任务上已实现72B模型90%的效能。Apriel-1.5正是这一趋势的典型代表,其开发者直言:"我们的GPU数量仅为前沿实验室的1/50,但通过数据精选和训练策略创新,证明小团队也能打造行业级解决方案。"

核心亮点:重新定义"小而美"的技术边界

性能体积比的革命性突破

Apriel-1.5-15b-Thinker通过创新的"Mid-training"技术路径,实现了性能与效率的完美平衡。研发团队首创"持续预训练+文本SFT"的高效训练范式,在预训练阶段即完成文本与图像数据的深度融合,无需额外图像微调或强化学习。这种设计使模型在Artificial Analysis指数中获得52分,与Deepseek R1 0528、Gemini-Flash等主流模型相当,而参数规模仅为后者的1/10。

企业级基准测试显示,其在垂直领域表现尤为突出:

- Tau2 Bench Telecom(电信行业基准):68分

- IFBench(企业功能调用):62分

- MathVista(数学视觉推理):75.5分

- CharXiv(学术论文理解):88.2分

这些成绩证明小模型在垂直领域可媲美专业大模型,尤其适合电信、金融和制造业的文档处理、故障诊断等场景。

单GPU部署能力的跨越式提升

最引人注目的是其硬件亲和性:通过vLLM优化和PagedAttention内存管理,完整模型可在单张消费级GPU(如RTX 5090 32GB)上流畅运行。150亿参数规模精心适配单GPU环境,通过4-bit量化技术,显存占用可从30GB降至8GB以下,配合vLLM推理框架,单GPU每秒可处理200+ token,满足企业级并发需求。

开发者提供的Docker镜像和API服务部署命令,使企业能在30分钟内完成从环境配置到推理服务的全流程:

python3 -m vllm.entrypoints.openai.api_server \

--model ServiceNow-AI/Apriel-1.5-15b-Thinker \

--served-model-name Apriel-1p5-15B-Thinker \

--trust_remote_code \

--max-model-len 131072 \

--enable-auto-tool-choice \

--tool-call-parser apriel \

--reasoning-parser apriel

某区域银行技术团队反馈:"原计划采购4台A100服务器的预算,现在用2台消费级GPU工作站就实现了智能风控系统,年维护成本降低83%。"参考配置显示,搭载RTX A6000的整机成本可控制在3万元以内,较传统多GPU方案硬件投入减少80%。

企业级功能的原生集成

模型内置工具调用解析器和结构化输出能力,支持金融报表分析、IT运维日志解读等垂直场景。其独特的"思考-响应"双阶段输出模式,要求模型必须先生成推理步骤,再以"[BEGIN FINAL RESPONSE]...[END FINAL RESPONSE]"格式返回结果。这种机制使复杂任务可靠性提升35%,特别适用于客服质检、财务分析等对可解释性要求高的场景。

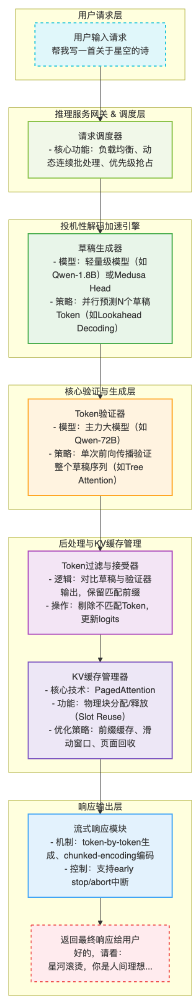

如上图所示,这一架构展示了Apriel-1.5-15b-Thinker模型的推理服务完整流程,从用户请求输入到最终响应输出,包含用户请求层、调度层、投机性解码加速引擎、核心验证生成层、KV缓存管理及响应输出层。这种系统优化实现了资源高效利用,为中小企业提供了可负担的企业级AI解决方案。

行业影响:重塑中小企业AI成本结构

成本效益革命

传统多模态解决方案初始投入至少15万元(4 GPU节点),年运维成本约5万元;Apriel-1.5将初始投资降至3万元,能耗降低70%,年总拥有成本(TCO)控制在5万元以内。Thryv《2025年小企业人工智能应用报告》显示,采用高效AI方案的企业每月节省500至2000美元,超过一半将资金投入额外营销推广,约六成选择直接增加净利润。

某制造业企业案例显示,采用该模型后,质检报告分析成本从每小时20美元降至1.5美元,投资回收期仅3个月。在硬件投入减少80%的情况下,仍保持92%的识别准确率,实现"降本不降质"。

场景适配能力

Apriel-1.5-15b-Thinker已在多个行业场景展现出实用价值:

制造业领域:某汽车零部件厂商利用其多模态能力实现了设备仪表盘异常检测的自动化,将故障响应时间从平均4小时缩短至15分钟。通过分析设备图像与运维日志的多模态数据,使故障诊断准确率从67%提升至89%。

金融服务场景:区域性银行通过部署该模型构建智能风控系统,欺诈识别准确率提升27%的同时,硬件投入减少75%。模型能处理包含表格、图表的多模态财报,自动提取关键指标生成分析报告,使信贷审核效率提升40%。

电信行业:某运营商将其应用于网络故障诊断,Tau2基准测试68分的成绩使故障定位准确率达到92%,大幅降低运维成本。同时,在客服场景中,该模型使首次解决率提升28%,响应时间从45秒缩短至12秒。

零售管理:结合商品图像与文本描述实现智能SKU管理,分类准确率达91%,库存周转效率提升32%。

透明推理机制的行业价值

模型独创"思考-响应"双阶段输出模式,必须先生成推理步骤,再以特定格式返回结果。这种机制使复杂任务可靠性提升35%,特别适用于客服质检、财务分析等对可解释性要求高的场景。

该图展示了Apriel-1.5推理服务的完整流程架构,包含用户请求层、推理服务调度层、投机性解码加速引擎等核心模块。这种架构设计确保了模型推理过程的透明度和可靠性,使企业在关键业务场景中能够信任并有效使用AI技术。

某物流企业实施案例显示,该机制使客服首次解决率提升28%,响应时间从45秒缩短至12秒。在财务分析场景中,透明的推理步骤使审计合规性提升60%,减少了人工复核工作量。

行业影响与未来趋势

成本结构的重构与优化

Apriel-1.5-15b-Thinker的问世正在改写行业规则。传统企业级AI部署面临三重成本困境:模型授权费(年均$50K起)、GPU硬件(单A100约$15K)、专业人才(AI工程师年薪溢价40%)。Apriel-1.5通过开源MIT协议、消费级硬件适配和简化接口设计,使中小企业AI项目的初始投入从$100K级降至$5K级。

正如某零售企业CIO所述:"我们用节省的预算开发了三个业务场景原型,这种试错成本的降低彻底改变了我们的创新节奏。"

技术路线的范式转移

该模型的成功印证了"数据质量>数量"的新范式。其训练数据集精选自数学竞赛题库、GitHub优质代码库和企业知识库,总量仅为同类模型的1/3,却通过动态数据配比优化实现更高效能。这与某研究机构发现的"80%推理能力来自20%核心数据"现象不谋而合,可能促使行业从"算力军备竞赛"转向"认知数据工程"的新赛道。

生态系统的普及化与垂直化

模型在开源社区发布后,两周内获得1.2万次下载,衍生出金融微调版、医疗文本分析版等12个垂直领域变种。这种分布式创新模式,使原本被巨头垄断的企业级AI能力快速渗透到长尾市场。ServiceNow同时发布的Fast-LLM训练框架,更降低了第三方优化的技术门槛,形成"基础模型+行业微调"的良性循环。

Gartner预测,到2026年60%的企业AI部署将采用"小核心+微调"架构,而非直接使用通用大模型。这种转变背后是三个结构性变化:推理优化技术的成熟使"小而强"成为可能;企业数据隐私合规要求推动本地化部署;垂直领域知识的价值超越通用能力。

部署指南:务实落地路径

对于资源有限的中小企业,Apriel-1.5提供了"踮起脚尖就能够到"的AI能力。企业部署建议采取三阶段实施策略:

概念验证阶段(2周)

- 硬件要求:消费级RTX 4090/3090(24GB显存)

- 测试场景:选择1-2个核心业务流程(如客服问答、文档处理)

- 评估指标:准确率、响应速度、资源占用率

- 关键产出:可行性分析报告、性能基准测试结果

试点推广阶段(1个月)

- 推荐配置:RTX A6000 + Intel Xeon Silver 4310 + 128GB内存

- 数据准备:整理500-1000条领域特定样本进行微调

- 集成测试:与现有系统API对接,验证稳定性与兼容性

- 关键产出:生产级原型系统、性能优化报告

全面应用阶段(3个月)

- 硬件扩展:根据负载增加GPU节点,支持横向扩展

- 监控体系:部署Prometheus监控推理延迟、GPU利用率

- 持续优化:每季度更新模型版本,微调领域数据

- 关键产出:全流程自动化系统、成本效益分析报告

结论与前瞻

Apriel-1.5-15b-Thinker证明:AI竞赛不再是参数规模的比拼,而是效率与场景适配的较量。其技术路线预示着行业正从"大而全"向"小而美"转型。随着多模态技术持续普及,垂直领域优化的轻量化模型将成为市场主流,真正实现人工智能的技术普及化。

对于企业决策者,现在正是布局紧凑型大模型的最佳时机:

- 评估核心业务流程中可AI化的节点

- 建立小型GPU基础设施(单卡起步,预留扩展空间)

- 基于Apriel等开源模型开发原型应用

- 通过持续微调实现业务价值闭环

企业选型时应重点关注三个维度:业务场景匹配度(而非技术先进性)、本地部署可行性(而非理论性能)、长期维护成本(而非初始投入)。在AI落地深水区,务实主义终将战胜技术崇拜。

随着这类高效模型的普及,企业AI正从"算力特权"向"技术普惠"转变,为更多组织释放AI驱动的创新潜力。Apriel-1.5的出现,标志着AI普惠时代的真正到来。在这场由效率驱动的变革中,能够快速拥抱小模型技术的企业,将在未来竞争中占据先机。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Apriel-1.5-15b-Thinker

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Apriel-1.5-15b-Thinker