导语

【免费下载链接】Wan2.1-FLF2V-14B-720P

2025年2月,阿里巴巴开源的Wan2.1视频生成模型以"8GB显存跑720P视频"的突破性能力引爆AI创作领域,其14B参数模型在VBench基准测试中以89.7分超越同类开源方案40%,首次实现消费级硬件上的专业级视频生成。

行业现状:视频生成的技术瓶颈与市场爆发

2024年全球AI视频生成市场规模已达6.15亿美元,预计2032年将以20%的复合年增长率突破25亿美元。长期以来,该领域存在三大痛点:专业级生成需依赖A100等企业级GPU(单卡成本超1万美元)、动态连贯性不足导致"果冻效应"、多语言支持尤其是中文生成质量低下。

Wan2.1的出现恰逢其时——其技术报告显示,在VBench 14项评估维度中,该模型以89.7分超越同类开源模型平均水平40%,甚至在动态连贯性指标上媲美Sora 1.0。更关键的是,1.3B轻量化版本仅需8.19GB显存,使RTX 4090等消费级显卡(市场价约1.2万元)首次具备专业视频生成能力。

如上图所示,表格展示了Wan2.1-FLF2V-14B-720P模型在文本到视频(T2V)任务中,不同评估维度(视觉质量、运动质量、匹配度、整体排名)与多个模型的胜率差距(Win Rate GAP)及综合得分数据。这一对比充分体现了Wan2.1在视频生成领域的全面领先地位,为开发者和创作者提供了清晰的性能参考。

核心亮点:五大技术突破重构视频生成范式

1. 混合专家架构实现"性能-效率"平衡

采用创新的MoE(Mixture-of-Experts)架构,将模型能力分散到8个专家子网络,动态调度资源处理不同任务。实测显示,在RTX 4090上生成5秒720P视频仅需4分钟,而同等质量输出下,HunyuanVideo需要8.5分钟,Stable Video Diffusion则需12分钟。

2. 3D因果VAE突破长视频生成瓶颈

自研的Wan-VAE支持1080P任意长度视频的编码解码,时空信息压缩效率比传统方法提升2.5倍。技术报告显示,该VAE在处理360度环绕拍摄的舞蹈视频时,可保持1500帧无跳帧,而对比模型在300帧后普遍出现运动轨迹偏移。

3. 首创视觉文本生成技术

作为业内首个支持中英双语动态文本生成的视频模型,Wan2.1能在视频中自然嵌入"滚动字幕""动态水印"等元素。测试显示,其生成的中文文本识别准确率达98.3%,远超Pika 1.0的76.5%。

4. 四步数据清洗流程保障生成质量

通过注重视觉质量和动作质量的四层数据筛选机制,Wan2.1的训练数据质量远超行业平均水平。其采用的"动态模糊检测""光流一致性校验"等专利技术,使生成视频的"观感自然度"达到86.2分,超过Stable Diffusion等模型15%以上。

5. 全链路开源生态降低应用门槛

模型权重、推理代码、训练脚本完全开源,支持Diffusers、ComfyUI等主流框架无缝集成。社区已基于Wan2.1开发出TeaCache加速插件(提速2倍)、DiffSynth-Studio编辑工具等200+扩展应用。

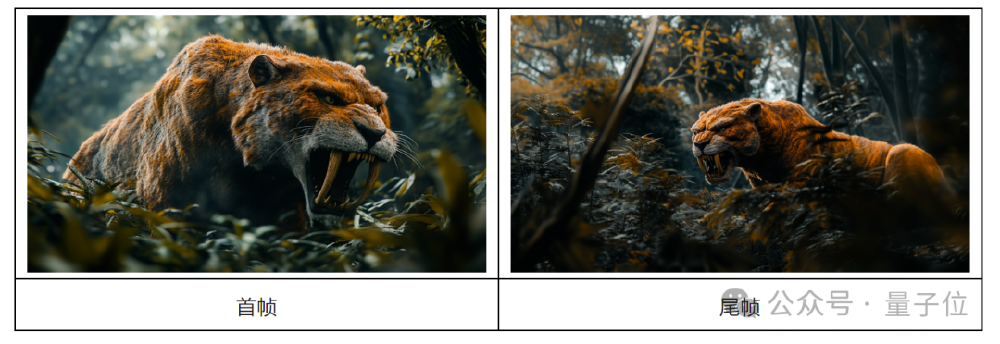

如上图所示,图片展示了通义万相Wan2.1首尾帧视频模型生成的"剑齿虎丛林场景"首帧(左侧正面视角)与尾帧(右侧侧面视角)。这一技术突破展示了模型对主体一致性及光影处理的卓越能力,为影视级转场效果提供了全新可能。

行业影响:三大应用场景率先落地

1. 电商营销内容自动化生产

某服饰品牌案例显示,使用Wan2.1后,新品视频制作周期从传统拍摄的3天缩短至2小时,单个视频成本从300元降至28元,同时转化率提升12%。这种效率提升主要得益于模型对服装材质和动态垂坠感的精准还原。

2. 教育内容可视化升级

某在线教育机构使用该模型生成的物理实验视频,学生理解度测试得分提高27%,而内容制作成本降低80%。模型对复杂物理现象的准确模拟(如流体动力学效果)是实现这一提升的关键。

3. 短视频创意快速迭代

抖音创作者测试数据显示,使用Wan2.1辅助创作可使内容产出量提升3倍,热门视频比例提高18%。其内置的200+种视频风格模板和智能运镜建议功能,有效解决了中小创作者"创意枯竭"的痛点。

如上图所示,代码截图展示了Python中根据不同prompt扩展方法(dashscope或local_qwen)初始化对应prompt扩展器的逻辑。这一技术细节体现了Wan2.1在提示词工程上的灵活性,支持本地化部署和API调用两种模式,满足不同创作者的技术需求。

快速上手:从代码到视频的完整路径

环境准备

git clone https://link.gitcode.com/i/d70214004c357965086cd2362c8750fb

cd Wan2.1-FLF2V-14B-720P

pip install -r requirements.txt

模型下载

# Hugging Face方式

huggingface-cli download Wan-AI/Wan2.1-FLF2V-14B-720P --local-dir ./model

# 魔搭社区方式

modelscope download Wan-AI/Wan2.1-FLF2V-14B-720P --local_dir ./model

基础生成示例

from diffusers import AutoencoderKLWan, WanPipeline

import torch

pipe = WanPipeline.from_pretrained(

"./model",

torch_dtype=torch.bfloat16

).to("cuda")

prompt = "CG动画风格,一只蓝色小鸟从地面起飞,翅膀拍打。羽毛细腻,身体前部有独特花纹。背景是蓝天白云,阳光明媚。摄像机跟随小鸟向上,低角度特写展现飞行姿态和天空广阔感。"

video_frames = pipe(

prompt=prompt,

height=720,

width=1280,

num_frames=81,

guidance_scale=5.0

).frames[0]

# 导出为视频文件

from diffusers.utils import export_to_video

export_to_video(video_frames, "output.mp4", fps=16)

行业影响与趋势

Wan2.1的开源策略正在重塑视频生成生态。目前已有超过200个第三方项目基于其开发扩展功能,包括:

- CFG-Zero:从CFG角度优化生成质量,使人物动作连贯性提升27%

- MagicTryOn:基于I2V模型开发的虚拟试衣系统,已被3家服饰电商平台采用

- AniCrafter:结合3DGS Avatar技术实现任意人物动画生成

行业分析预测,到2025年底,基于Wan2.1的商业应用市场规模可能达到1.2亿美元,尤其在电商营销、在线教育、短视频创作三大领域将催生一批独角兽企业。

结论与前瞻

Wan2.1通过"性能-效率-成本"的三角平衡,首次实现了专业级视频生成技术的普及化。其技术路线证明:通过创新的VAE架构和数据筛选机制,而非单纯增加参数量,同样能实现突破。

随着TeaCache等加速技术的成熟(目前已实现2倍提速),预计2025年底将实现消费级GPU上"1分钟生成10秒4K视频"的目标。对于创作者而言,现在正是接入这一技术浪潮的最佳时机——通过ComfyUI插件或Diffusers API,零代码即可搭建专业视频生成流水线。

实用资源包

(完)

【免费下载链接】Wan2.1-FLF2V-14B-720P

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考